Actos por el 50 aniversario de la Facultad de Ciencia y Tecnología de la UPV/EHU

50 años de ciencia viva

Los actos de conmemoración del 50 aniversario de la Facultad de Ciencia y Tecnología de la UPV/EHU comenzaron el 28 de enero de este año con la plantación de un tilo de hoja pequeña (Tila cordeta Mill.), que representa el Árbol de la Ciencia como símbolo de su unidad fundamental. El acto simbolizó la siembra de la semilla plantada en mayo de 1968, cuando se creó la Facultad de Ciencias de la Universidad de Bilbao, hoy en día Facultad de Ciencia y Tecnología.

Los primeros pasos de la Facultad de Ciencias en el curso 1968/69 se dieron junto al puente de Deusto, en “Botica Vieja, 1”. No fue hasta finales de 1971 cuando se trasladó a su emplazamiento actual en Leioa.

La Facultad de Ciencia y Tecnología ha sido una facultad viva en su oferta de titulaciones. Comenzó ofertando las cinco ramas clásicas de las Ciencias Naturales: Biología, Física, Geología, Matemáticas y Química. Entre los cursos 1994/95 y 2000/01, su oferta se amplía a las licenciaturas de segundo ciclo en Bioquímica, Ingeniería Electrónica, Ingeniería Química y Ciencias Ambientales, pasando a llamarse en el curso 2004/2005 Facultad de Ciencia y Tecnología. Hoy, oferta nueve grados, dos en la rama de Ingeniería (Ingeniería Electrónica e Ingeniería Química), y siete en la de Ciencias (Biología, Bioquímica y Biología Molecular, Biotecnología, Física, Geología, Matemáticas y Química). Se oferta también el doble grado en Física e Ingeniería Electrónica y tres dobles titulaciones internacionales de grado. Esta oferta hace de la Facultad de Ciencia y Tecnología uno de los referentes más importantes del País Vasco en la formación de profesionales capaces de jugar un papel crucial en los retos de nuestra sociedad, desde el desarrollo en nuevas tecnologías, el desarrollo sostenible, la conservación del medio ambiente o la investigación en biociencias.

Los inicios fueron precarios, como se podría esperar ante la difícil situación política de aquellos años. Hoy la facultad es un centro con gran experiencia en docencia, investigación y desarrollo tecnológico, como queda acreditado por las muy buenas posiciones en el ranking de Shanghái de distintas áreas de investigación que se desarrollan en nuestro centro.

La calidad de una facultad no se mide sólo por la excelencia del profesorado, sino también por la calidad de su alumnado: hoy cuenta con estudiantes de primer nivel. Las notas de acceso más elevadas para acceder a las titulaciones universitarias se encuentran en varias de las titulaciones de esta facultad. Un claro ejemplo es la nota de acceso superior a 13, sobre 14, para acceder al doble grado, la más alta de la UPV/EHU.

Tras 50 años de intenso trabajo, 17.500 personas han egresado en licenciatura, ingeniería o grado, y 2.000 se han doctorado. Estas cifras suponen una gran aportación de personal cualificado, profesionales que están trabajando en distintos ámbitos sociales, fundamentalmente en el tejido productivo, pero también en el institucional y el educativo, ocupando muchos de ellos puestos de responsabilidad.

Queremos compartir con la sociedad vasca el trabajo que la Facultad de Ciencia y Tecnología ha desarrollado a lo largo de medio siglo, mediante una investigación de excelencia y una formación rigurosa de profesionales en distintas áreas, mostrando así nuestro orgullo por haber colaborado en el crecimiento económico y social del País Vasco.

Biba Zientzia!, Ciencia Viva.

Todas las actividades programadas las encontrará aquí.

Las actividades programadas en el Bizkaia Aretoa de Bilbao durante los próximos 4 meses son:

Semana de la física

- 20 de marzo

18:30 Conferencia: A. Sanchez-Lavega: “¿Hay mas vida en el universo?

19:00 Mesa redonda: “Ciencia y Tecnología en el siglo XXI”

-Cristina Oyon (Responsable de Iniciativas Estratégicas del Grupo SPRI),

-Jose Maria Pitarke (Director General del CIC-Nanogune),

-Javier García-Abajo (Prof. Investigación CSIC y Research Prof. ICREA)

-Agustin Sanchez Lavega (Catedrático UPV/EHU)

Moderadora: Eva Caballero (Periodista de radio Euskadi)

- 21 de marzo

18:00 Conferencia: Roberto Emparan (Research Prof. ICREA y autor del libro de divulgación reciente “Iluminando el lado oscuro del Universo”): “Stephen Hawking: de los agujeros negros a la Teoría del Todo”

Semana de las matemáticas

- 25 de marzo

18:00 Mesa redonda: “Experiencias Matemáticas en empresa”

Dirigido a: Estudiantes de Bachillerato y de Matemáticas, Orientadores

- 2 de abril

19:00 Evento: Judith Rivas (UPV/EHU); Nagore de las Cuevas y Arkaitz Pascuas; Andoni Aresti Dantza Eskola y Mungiako Udal Dantza Eskola : “Pasos de baile a ritmo de matemáticas”

Dirigido a: Público general

Semana de la geología

- 1 de abril

18:00 Conferencia: Irantzu Guede, doctora de la UPV/EHU en Geología, en Mineralogía Petrología: “Geología en Mitos y Leyendas”.

- 2 de abril

18:00 Conferencia: Humberto Astibia, catedrático de la UPV/EHU: “Los fósiles, documentos de la historia de la Vida archivados en las rocas”.

16:00-20:00 Taller de Geología para familias. Aintzane Goffard (Geologa de la UPV/EHU, ayudante en Estratigrafía-Paleontología) e Irantzu Guede (Doctora de la UPV/EHU en Geología, Mineralogía-Petrología).

- 3 de abril

18:00 Conferencia: Blanca Martínez, doctora de la UPV/EHU en Geología, en Estratigrafía-Paleontología: “Geología y música”.

- 4 de abril

18:00 Conferencia: Ihintza Urain Alberdi, geóloga: “Geologia eta ingurugiroa: Geologoaren papera energia aldaketan eta Lurraren inguruko kultura berri baten aurrean”.

- 8 de abril

18:00 Conferencia: Jose María Tubía, catedrático de Geodinámica de la UPV/EHU: “Riesgo geológico de los tsunamis”.

Acto central

- 11 de abril

18:30 Conferencia: Prado Martín Moruno, 2017 L’Oreal-Unesco awarded Women for Science: “La energía oscura y el destino del Universo”.

Estreno de la obra de baile “GARGANTUA” (basada en el agujero negro GARGANTUA de la película “Interstellar”). Martxel Rodriguez, físico y bailarín profesional. Miembro de “KUKAI dantza taldea”.

Semana de la química

- 29 de abril

18:00 Conferencia: Oskar González. Profesor del Departamento de Química Analítica:“Artelanetan aurkitu diren gauzarik bitxienak”

- 30 de abril

18:00 Conferencia: Pascual Román, profesor emérito. Catedrático de Química Inorgánica: “El sesquicentenario de la tabla periódica de los elementos químicos”

- 2 de mayo

18:00 Conferencia: Jose Luis Vilas, director del Grupo de Química Macromolecular. Departamento de Química Física FCT-EHU: “Hidrogeles: imprimiendo salud”

Semana de la biociencia

- 6 de mayo

18:00 Mesa redonda: “Zientzia, jainkoaren esistentzia, zergatik du gizakiak sinisteko beharra”

Otros actos

- 27 de Junio

19:00 “ZTF/FCTren ekarpena Euskararen Normalizazioan” Conferenciantes: Pedro Miguel Etxenike, Jacinto Iturbe y Jesusmari Txurruka

Acto de clausura. 12 de julio

Bilbao Bizkaia AretoaSe comunicará

Sobre el autor: Fernando Plazaola Muguruza es el decano de la Facultad de Ciencia y Tecnología de la UPV/EHU

El artículo Actos por el 50 aniversario de la Facultad de Ciencia y Tecnología de la UPV/EHU se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Presentación del estudio “Percepción social de la ciencia y la tecnología en el País Vasco”

- Geología, ver más allá de lo que pisamos

- Geología: la clave para saber de dónde venimos y hacia dónde vamos

El cerebro humano tarda en madurar

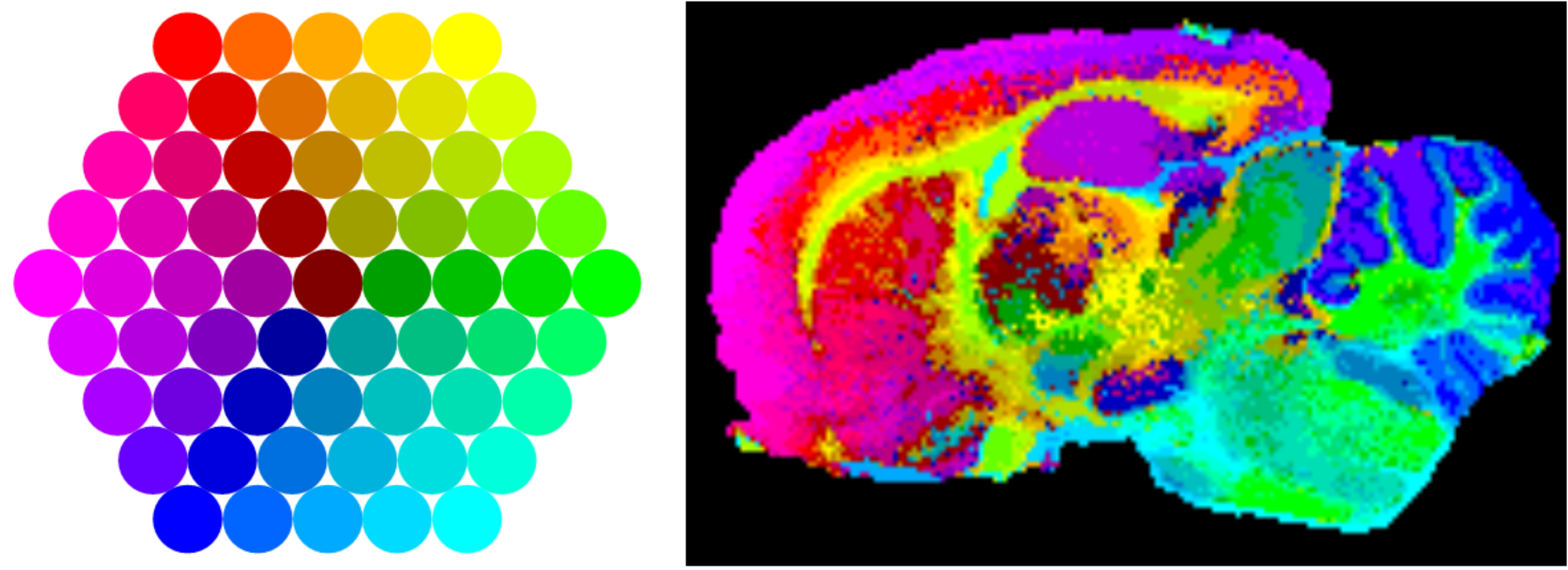

Imagen: Gordon Johnson / Pixabay

Imagen: Gordon Johnson / PixabayUna característica peculiar de los seres humanos es que, aunque nacemos con una cabeza de gran tamaño, tardamos en completar el crecimiento y desarrollo del encéfalo. A los dos años de edad alcanza el 85% de su volumen máximo, por lo que ha de seguir creciendo. Por otro lado, no todas sus áreas se desarrollan y maduran a la vez. La corteza cerebral, que es la parte más exterior, madura en último lugar. Y en ese proceso la proporción entre las denominadas materia gris y materia blanca cambia.

La materia gris corresponde a diferentes elementos: cuerpos neuronales y sus dendritas, que son prolongaciones ramificadas a través de las cuales una neurona recibe señales de otras; células de la glía, que dan soporte y protección a las anteriores; capilares sanguíneos, que proporcionan a neuronas y células gliales el oxígeno y los nutrientes que necesitan; y las conexiones entre neuronas, denominadas sinapsis. La materia gris se distribuye en la corteza del cerebro y del cerebelo, así como en numerosas estructuras de ubicación más profunda en el interior del encéfalo.

La materia blanca corresponde a los axones de las neuronas que se encuentran recubiertos por una sustancia lipídica denominada mielina. Un axón es una proyección de forma tubular que conducen señales nerviosas desde el cuerpo de una neurona hasta otras que pueden encontrarse a cierta distancia o hasta células musculares, principalmente. La vaina de mielina que recubre el axón lo aísla, y ayuda, de esa forma, a que los impulsos nerviosos se transmitan más rápida y eficazmente.

El volumen de materia gris de varias regiones de la corteza cerebral alcanza su máximo desarrollo alrededor de los 10 años de edad. Ese incremento refleja un aumento de las conexiones entre neuronas que se producen como consecuencia de la experiencia, el adiestramiento y el aprendizaje. Durante esos años, la actividad encefálica es tan intensa que llega a gastar un 60% de la energía que consume el organismo en reposo, y casi la mitad de las necesidades diarias totales de energía. Hay quienes atribuyen a ese gran consumo de energía el hecho de que el crecimiento del cuerpo durante la niñez sea lento y se prolongue en el tiempo.

A partir de los once o doce años las cosas cambian. El grosor de la materia gris de la corteza cerebral empieza a reducirse, y lo hace de forma sustancial durante la adolescencia. En algunas zonas esa reducción llega a ser del 17% hacia el final del proceso, unos 15 años después. Lo que ocurre, en parte, es que una cierta proporción de las conexiones sinápticas se “podan”, como se dice en la jerga neurocientífica. Esa poda elimina conexiones que no se usan o se usan poco y se mantienen las que más tráfico registran. A la vez aumenta la proporción de materia blanca. Eso es indicio de que los axones que conducen las señales se hacen más gruesos y que aumenta su grado de cobertura por la capa lipídica de mielina. El engrosamiento de los axones y el mayor grado de mielinización promueven una más rápida y eficaz transmisión de impulsos nerviosos y , por lo tanto, una comunicación más eficiente entre la corteza cerebral y el resto de áreas encefálicas. En definitiva: el cerebro funciona mejor.

La maduración de la corteza cerebral requiere tiempo y hace que la adolescencia sea un periodo difícil. Pero durante ese periodo la mente humana aprende a navegar en el complejo entorno social en que se desenvolverá en la edad adulta. La adolescencia puede entenderse así como el precio que paga por ese aprendizaje.

Nota:

Esta anotación es parte de una colección de tres artículos dedicados a la neuropsicología de la adolescencia. Los artículos son El desajuste adolescente, En busca de la identidad personal y este, El cerebro humano tarda en madurar.

——————-

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo El cerebro humano tarda en madurar se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Sistemas nerviosos: el cerebro de vertebrados

- Daños estructurales por consumo de alcohol en el cerebro humano

- ¿Cuántas células hay en el cuerpo humano?

¿Hemos intentando contactar con extraterrestres?

¿Hemos intentando contactar con extraterrestres? Y si es así, ¿cómo y cuándo se ha hecho? ¿Quién lo ha hecho? Y sobre todo, ¿qué se les ha dicho en los mensajes que se han enviado? Todas las respuestas en minuto y medio.

Los vídeos de ¿Preguntas frecuentes? presentan de forma breve y amena cuestiones que, probablemente, nos hayamos planteado en alguna ocasión. Los vídeos, realizados para la Cátedra de Cultura Científica de la UPV/EHU, se estrenarán en el programa de ciencia Órbita Laika (@orbitalaika_tve), a partir del próximo 18 de marzo todos los lunes a las 22:00 en la 2 de RTVE.

Edición realizada por César Tomé López

El artículo ¿Hemos intentando contactar con extraterrestres? se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Ciencia express: los transgénicos

- Ciencia express: el carbono-14 y los rayos cósmicos

- Ciencia express: Cómo se formó la luna

Los biólogos de la UPV/EHU y la conservación de la naturaleza

La Facultad de Ciencias de Bilbao comenzó su andadura en el curso 1968/69. 50 años después la Facultad de Ciencia y Tecnología de la UPV/EHU celebra dicho acontecimiento dando a conocer el impacto que la Facultad ha tenido en nuestra sociedad. Publicamos en el Cuaderno de Cultura Científica y en Zientzia Kaiera una serie de artículos que narran algunas de las contribuciones más significativas realizadas a lo largo de estas cinco décadas.

Toma de muestras de bivalvos en los manglares nicaragüenses. Foto: Ionan Marigomez / UPV/EHU

Toma de muestras de bivalvos en los manglares nicaragüenses. Foto: Ionan Marigomez / UPV/EHUA menudo se critica a la universidad por falta de conexión con la sociedad. Se afirma que la universidad enseña conocimientos arcanos y que la investigación apenas tiene implicaciones prácticas. Este punto de vista es compartido por bastantes universitarios, por lo que algo habrá detrás del mismo. Sin embargo, un poco de perspectiva histórica muestra que hay numerosas interacciones entre la universidad y la sociedad. A título de ejemplo, vamos a analizar cuál ha sido el impacto de la Sección de Biología en la conservación de la naturaleza.

La Sección de Biología comenzó su andadura muy modestamente en la por entonces denominada Facultad de Ciencias de la Universidad de Bilbao. Esta Sección carecía de catedráticos hasta 1975 y, de los tres profesores agregados de aquel momento, ninguno pertenecía a alguna de las áreas de la biología más naturalistas, es decir, la botánica, la zoología o la ecología. Tampoco llegaban fondos para apoyar proyectos de investigación en estos ámbitos. El bum llegó en la segunda mitad de los años 80, cuando se multiplicó el número de profesores, se potenció la formación de doctores y los grupos de investigación comenzaron a recibir financiación pública para el desarrollo de sus proyectos. Los años 90 vieron la aparición de cursos de postgrado tipo máster, como por ejemplo el de “Evaluación y Recuperación Ambiental”, y el afianzamiento de colaboraciones externas de los equipos de investigación. El siglo XXI ha supuesto la puesta de largo de la investigación en muchos de esos grupos, que participan en proyectos multinacionales de indudable repercusión sobre la conservación y el manejo de los recursos naturales, llegando a alcanzar niveles de excelencia y prestigio internacionales.

En estos años, la Facultad de Ciencia y Tecnología ha formado un gran número de personas en Biología, Ciencias Ambientales y otras disciplinas ligadas con la conservación de la naturaleza. Según las estadísticas oficiales, los egresados de la la FCT incluyen más de 3850 licenciados y más de 450 graduados en Biología, a lo que se suman centenares de estudiantes de master y 475 doctores. De ellos, muchos trabajan en ámbitos relacionados con la conservación de la naturaleza. Algunos lo hacen para la administración como técnicos de medio ambiente municipales, en consorcios y mancomunidades, en las diputaciones forales, departamentos del Gobierno Vasco, parques naturales, etc. Otros muchos trabajan en empresas relacionadas con la conservación de la naturaleza, como consultoras (por ejemplo, Anbiotek o Ekolur) o en centros de I+D+I como Neiker o Azti. Otros muchos se han dedicado a la enseñanza, tanto la reglada en institutos, ikastolas, colegios y universidades, como no reglada en aulas de naturaleza, CEIDAs, etc. Finalmente, muchos egresados colaboran en asociaciones y otras entidades en pro de la conservación de la naturaleza, como grupos ecologistas, asociaciones conservacionistas o entidades de estudio e interpretación del medio ambiente como la Sociedad de Ciencias Aranzadi. Aunque es imposible de cuantificar, podemos afirmar que esta masa de gente con una formación en biología y actitudes conservacionistas ha tenido mucho que ver con la transformación que se ha registrado en la forma de entender la relación de la especie humana con el medio ambiente en el País Vasco.

Miembros de la FCT discutiendo un proyecto de restauración en el Parque Natural de Aiako Harria con técnicos de la Diputación Foral de Gipuzkoa, de Aguas del Añarbe de URA y de la Confederación Hidrográfica del Cantábrico. Fuente: Arturo Elosegi.

Miembros de la FCT discutiendo un proyecto de restauración en el Parque Natural de Aiako Harria con técnicos de la Diputación Foral de Gipuzkoa, de Aguas del Añarbe de URA y de la Confederación Hidrográfica del Cantábrico. Fuente: Arturo Elosegi.Por otro lado, algunos equipos de la FCT han sido muy activos en el inventariado y seguimiento de la biodiversidad de nuestro entorno. Por citar sólo algunos de ellos, el laboratorio de zoología abrió varias líneas de investigación sobre fauna fluvial y marina, sobre artrópodos del suelo o sobre moluscos terrestres. A esas líneas posteriormente se han incorporado otros grupos como el de murciélagos. Por su parte, el laboratorio de botánica abrió líneas de investigación sobre algas, musgos, plantas superiores y hongos, así como otra sobre geobotánica, que caracterizó y cartografió las principales comunidades vegetales de nuestro entorno. La información acumulada durante décadas ha sido esencial para caracterizar los lugares más biodiversos del País Vasco, para identificar sus principales factores de riesgo y, entre otras, para diseñar y optimizar la red Natura 2000.

Además de los inventarios de biodiversidad, algunos grupos han trabajado activamente en evaluar el estado de salud del medio ambiente, colaborando en poner las bases del sistema de información medioambiental del País Vasco. Por ejemplo, en los años 80, los entonces laboratorios de zoología y ecología se embarcaron en el primer gran estudio hidrobiológico de los ríos de Bizkaia, así como en la evaluación del estado medioambiental de la ría de Bilbao. El primer trabajo fue la semilla de la que derivó la red de seguimiento de los ríos del País Vasco, actualmente en manos de URA, la Agencia Vasca del Agua, mientras que el segundo comenzó una serie de estudios sobre la salud de nuestra costa. También hay que citar en este apartado al laboratorio de microbiología, que durante muchos años ha colaborado en la determinación de la calidad de las aguas de baño de la Comunidad Autónoma.

Otros grupos han centrado sus estudios en la detección y evaluación de los impactos que causa la actividad humana en la estructura y el funcionamiento de los ecosistemas. El grupo de ecología fluvial ha estudiado el impacto de las prácticas forestales, de la contaminación agrícola y urbana, de las detracciones de agua o del cambio climático en ríos vascos y de otras regiones. Lo que comenzó siendo el laboratorio de citología, por su parte, ha ido convirtiéndose en un grupo de investigación sobre ecotoxicología, que es hoy la base de la Estación Marina de Plentzia, mientras que el grupo de ecotoxicología animal y biodiversidad utiliza especies como centinelas del estado de salud de las aguas continentales. Otras líneas aplicadas han sido el estudio de suelos contaminados, que se ha abordado desde los laboratorios de zoología y fisiología vegetal, o los trabajos más agronómicos realizados en este último. Toda la información obtenida por estos grupos es utilizada por la Diputaciones Forales, por el Gobierno Vasco y por otras entidades en la planificación y gestión del territorio.

Miembros de la FCT revisando trabajos de restauración ecológica en el río Araxes (Gipuzkoa), junto con técnicos de la Diputación Foral de Gipuzkoa, de las empresas Ekolur y Basoinsa, y un científico del IGB de Berlín. Fuente: Arturo Elosegi.

Miembros de la FCT revisando trabajos de restauración ecológica en el río Araxes (Gipuzkoa), junto con técnicos de la Diputación Foral de Gipuzkoa, de las empresas Ekolur y Basoinsa, y un científico del IGB de Berlín. Fuente: Arturo Elosegi.Más allá de la obtención de información, algunos grupos de la Sección han colaborado estrechamente con la administración en trabajos de gestión de poblaciones, comunidades o ecosistemas. Por ejemplo, el grupo de ecología y evolución del comportamiento ha trabajado en la gestión de mamíferos amenazados, como el visón, el desmán ibérico o los murciélagos, el de ecología y gestión del pastoreo en la gestión de la ganadería en pastos de montaña, el grupo de ecofisiología vegetal en la, entre otras, recuperación de suelos degradados o contaminados, y el de ecología fluvial en proyectos de restauración de ríos. Estos trabajos no se han limitado a evaluar el efecto de prácticas de conservación realizadas por la administración, sino que han implicado a la universidad en el diseño, ejecución y seguimiento de estas prácticas, muchas de las cuales han sido pioneras a nivel estatal.

Finalmente, no podemos olvidar el papel de asesoría realizado por muchos miembros de la Sección, en su participación en los patronatos de parques naturales o de la Reserva de la Biosfera de Urdaibai, o en Naturzaintza, el consejo asesor de conservación de la naturaleza del Gobierno Vasco. Además de estas colaboraciones, es habitual que miembros de la Sección participen en reuniones para definir estrategias y planes de la administración, como la Estrategia Española de Restauración de Ríos o la Estrategia Vasca de Biodiversidad.

La Sección de Biología continúa aportando conocimiento sobre los ecosistemas de nuestro entorno, lo cual facilita la gestión de nuestros recursos naturales. Si bien hasta hace bien poco esta aportación de conocimiento residía básicamente en las áreas más naturalistas referidas arriba, hoy en día las herramientas de la biología molecular son esenciales en el estudio de la biodiversidad, lo que aumenta el número de grupos que trabajan en este campo. Por todo ello, es de esperar que la Sección de Biología de la FCT siga teniendo un papel importante en la conservación de la naturaleza en el País Vasco y en el mundo en general.

Sobre los autores: Arturo Elosegi es profesor de ecología en el Departamento de Biología Vegetal y Ecología de la Facultad de Ciencia Tecnología de la UPV/EHU. Jesús Pozo se retiró recientemente del mismo departamento.

El artículo Los biólogos de la UPV/EHU y la conservación de la naturaleza se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Una fórmula para dominarlos a todos: La conservación de la energía y la ley de la palanca

- De las leyes de conservación (I)

- Naturaleza, ciencia y cultura en el bicentenario de Henry David Thoreau

Aprendiendo de las máquinas

Imagen: Pixabay

Imagen: PixabayLa segunda mitad del siglo XX vio nacer la computación y el sueño de la inteligencia artificial —“la ciencia de conseguir que las máquinas hagan cosas que requerirían inteligencia si las hiciesen humanos”, en palabras de Marvin Minsky—, que hoy en día está despertando un renovado interés gracias a la rama del aprendizaje automático. Se trata de un conjunto de técnicas que se benefician de los avances tecnológicos en materia de computación de las últimas dos décadas, y se caracterizan por su capacidad de engullir enormes cantidades de datos para enfrentarse a problemas de gran complejidad. Las aplicaciones son vastas, y ya forman parte de nuestro día a día: se utilizan para detección de fraude, navegación en vehículos autónomos, sistemas de recomendación (de productos, música…), diagnóstico médico, optimización de procesos, juegos… y un largo etcétera.

En todos estos casos, decimos que la máquina aprende. Y sabemos perfectamente cómo aprende (la lógica matemática y computacional subyacente), pero ¿qué aprende exactamente? Esta pregunta, aparentemente sencilla, nos persigue en todas sus aplicaciones. Por ejemplo, ¿qué lleva a AlphaZero a considerar ventajosos los movimientos que hace y que epatan por igual a aficionados y expertos ajedrecistas? Lo cierto es que no lo sabemos. La importancia de la cuestión puede parecer relativa en decisiones no críticas como la recomendación de una película, pero resulta esencial, e incluso abre derivadas éticas, cuando hablamos de cosas como conceder o no conceder un crédito, o la reacción de un coche autónomo ante un accidente.

En realidad, el tipo de problema al que se enfrentan las técnicas de aprendizaje automático es el mismo al que se viene enfrentando la ciencia, estadística mediante, desde su nacimiento: la inferencia de patrones, de generalizaciones, a partir de datos observacionales con el objetivo de obtener predicciones. En otras palabras, dada una entrada X, ¿qué modelo o función “f” genera la salida Y=f(X)? La gran diferencia se encuentra en que tradicionalmente nos hemos enfrentado a problemas para los cuales hay una teoría matemática previa que establece la estructura de “f”. La estadística clásica es la ciencia que estudia los diferentes tipos de modelos “f” y genera las técnicas para obtener y evaluar el mejor ajuste a partir de las observaciones (x, y). Por otro lado, las técnicas de aprendizaje automático de la nueva ciencia de datos son capaces de aprender la función “f” a partir de los datos sin ningún modelo previo, sin ningún conocimiento a priori del problema. La función “f” inferida se encuentra de alguna forma codificada tras el proceso de aprendizaje, pero nos es completamente desconocida y no hay forma de extraerla: es por eso que suelen llamarse “algoritmos de caja negra”.

Así pues, la estadística clásica define modelos matemáticos en los que las relaciones entre variables son explícitas y, por tanto, son directamente interpretables. Pensemos en una simple relación lineal: cuando crece X, crece Y; por tanto, obtenemos un valor grande de Y porque X es grande. En cambio, estos algoritmos de caja negra son capaces de capturar relaciones arbitrariamente complejas y predecir con gran precisión, pero su desventaja a día de hoy es que nos las ocultan, matemáticamente hablando: no somos capaces de interpretar qué propiedades de X influyen en Y.

Por tanto, uno de los grandes retos que la inteligencia artificial tiene por delante es el de intentar obtener conocimiento a partir de la estructura que las máquinas son capaces de extraer de grandes volúmenes de datos. Quizás se logre mediante una formalización matemática de las técnicas actuales, o quizás se desarrolle una nueva estadística ahora desconocida. Sea como sea, aprender de las máquinas puede ser uno de los principales hitos del presente siglo.

Sobre el autor: Iñaki Úcar es doctor en telemática por la Universidad Carlos III de Madrid e investigador postdoctoral del UC3M-Santander Big Data Institute

El artículo Aprendiendo de las máquinas se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Máquinas inteligentes (y III): Deep blue, HAL 9000 y más allá

- Seminario Famelab: aprendiendo a hacer monólogos

- Máquinas inteligentes (II): Inteligencia artificial y robótica

Paradojas: contando peces, pesando patatas y… detectando agujeros

Tengo un acuario en casa. Contiene doscientos peces, de los cuales el 99% son rojos. Quiero conseguir que sólo el 98% de los peces de mi pecera sean colorados, eliminando sólo algunos de este color, pero sin tener que comprar más de otras tonalidades. ¿Cuántos peces rojos debo sacar del acuario?

Imagen: Pixabay

Imagen: PixabaySeguro que son pocos los que debo extraer de mi pecera. Veamos: los peces rojos representan el 99%. Por lo tanto, el 1% no son colorados, es decir, solo hay dos peces que no son rojos en el acuario. Necesito extraer algunos peces rojos para conseguir que estos dos peces lleguen a ser el 2% de los peces del acuario. Así, si dos peces no colorados deben ser el 2% del total, una sencilla regla de tres dice que deben quedar en el acuario ¡solo 98 peces rojos! Es decir, deben sacarse 100 peces rojos para que el porcentaje de peces colorados pase del 99%al 98%. Sorprendente, ¿no?

¿Y qué hago ahora con los cien peces que me sobran? Decido cambiarlos a un colega por cien kilos de patatas. Es justo, ¿no? Un pez por un kilo de patatas… Y se me plantea un nuevo problema.

Tengo 100 kilos de patatas. El 99% de su peso corresponde al agua que contienen. Quiero deshidratarlas para conseguir que contengan solo un 98% de agua. Tras hacerlo, ¿cuánto pesan las patatas? ¡Si sólo pesan 50 kilos! ¿Por qué?

Imagen: Wikimedia Commons.

Imagen: Wikimedia Commons.Veamos: si de esos 100 kilos, 99 kilos son de agua, 1 kilo corresponde a sólido seco. Vaya, parece que estoy teniendo un “déjà vu”… esto me recuerda mucho al caso de los peces rojos. Pero centrémonos, volvamos a los tubérculos. Si tras deshidratar las patatas la parte sólida pasa a ser del 2% del total –que sigue pesando 1 kilo, porque no se ve afectada por la deshidratación– de nuevo puedo hacer una sencilla regla de tres que me dice que debe de haber solo 49 kilos de agua. Así que, efectivamente, las patatas pasan a pesar 50 kilos. Bueno, así me costará menos transportarlas.

Creo que compraré algo de queso para elaborar alguna receta y acompañar a parte de esas patatas. Me gusta el Emmental porque tiene agujeros, y –como todo el mundo sabe– a las personas que nos dedicamos a la topología nos encanta contar agujeros. Para eso se inventó la teoría de homología, ¿no? Para eso, para contar agujeros de diferentes dimensiones y así distinguir espacios no homeomorfos.

Y me ha dado por pensar en los agujeros del queso, que parece que proceden de la fermentación producida por partículas microscópicas de heno presentes en la leche. A ver:

Cuanto más queso Emmental compre, más agujeros habrá. Pero, cuantos más agujeros haya, tendré menos queso. Es decir, cuanto más queso compre… ¡tendré menos queso!

Imagen: Wikimedia Commons.

Imagen: Wikimedia Commons.¡No me lo puedo creer! Y todo esto por culpa de cien peces rojos…

Referencias

-

Marta Macho Stadler, La paradoja de los peces colorados, ZTFNews, 4 octubre 2013

-

Weisstein, Eric W., Potato Paradox, MathWorld

-

Paradoxe du fromage à trous, Wikipédia (consultado el 10 de marzo de 2019)

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad.

El artículo Paradojas: contando peces, pesando patatas y… detectando agujeros se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Patatas ‘perfectas’ con el método ‘Edge Hotel School’

- La topología modifica la trayectoria de los peces

- Los peces en el río

Reflexión y refracción de la luz

Imagen: V Photography and Art (flickr)

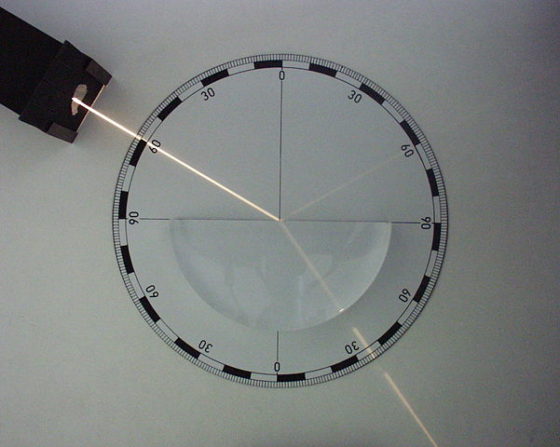

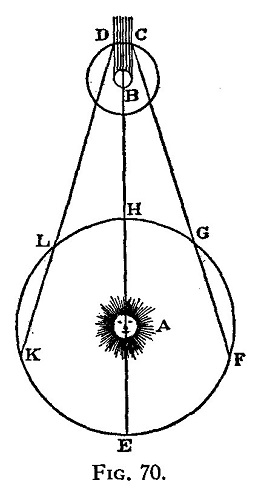

Imagen: V Photography and Art (flickr)¿Qué ocurre cuando la luz que viaja por un medio (por ejemplo, el aire) alcanza el límite de otro medio (por ejemplo, el vidrio)? Las respuestas a esta pregunta dependen de si se utiliza el modelo de partícula o el de onda para la luz. ¿Qué implica cada uno y cuál es mejor? ¿Cómo explican el siguiente hecho experimental (Figura 1):

Figura 1. Un haz de luz llega con un ángulo de 60º al límite entre dos medios; vemos que una parte es reflejada (también con un ángulo de 60º) y otra pasa al medio 2 con un cambio de dirección. Fuente: Wikimedia Commons

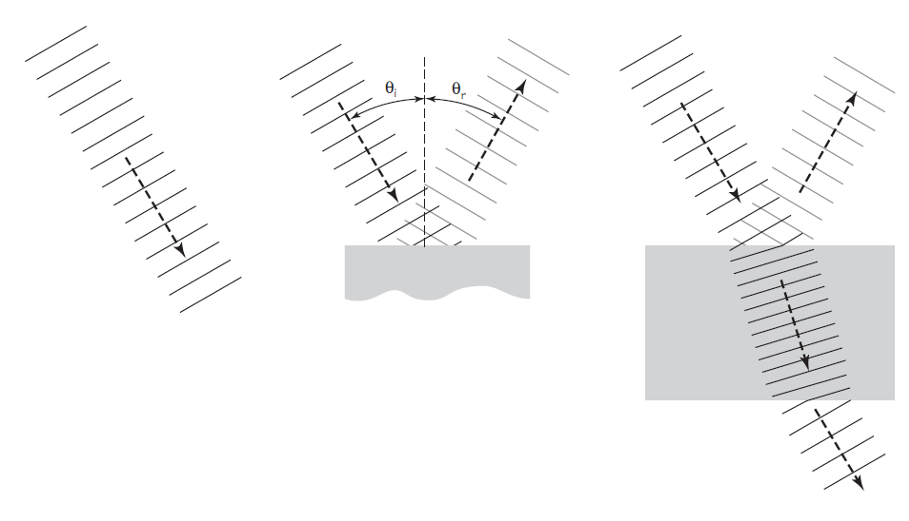

Figura 1. Un haz de luz llega con un ángulo de 60º al límite entre dos medios; vemos que una parte es reflejada (también con un ángulo de 60º) y otra pasa al medio 2 con un cambio de dirección. Fuente: Wikimedia CommonsEl modelo de onda ya lo hemos tratado aquí para la reflexión y aquí para la refracción. Recordemos las conclusiones principales aplicadas a la luz:

1. Un rayo de luz no es otra cosa que una línea perpendicular a las líneas de cresta de una onda. Un rayo representa la dirección en la que viaja un tren de ondas.

2. En la reflexión, el ángulo de incidencia(Θi) es igual al ángulo de reflexión (Θr), esto es, Θi = Θr

3. La refracción implica un cambio de la longitud de onda y velocidad de la onda a medida que pasa a otro medio. Cuando la velocidad disminuye, la longitud de onda disminuye y el rayo gira en una dirección hacia una línea perpendicular al límite entre los medios. Este giro hacia la perpendicular se observa, por ejemplo, cuando un rayo de luz pasa del aire al vidrio.

Figura 2. El modelo de ondas en acción. Fuente: Cassidy Physics Library

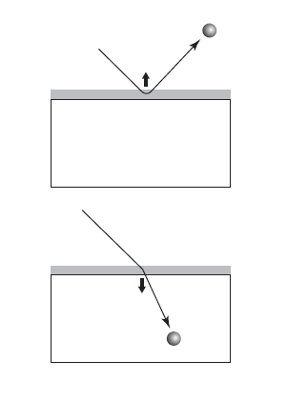

Figura 2. El modelo de ondas en acción. Fuente: Cassidy Physics Library ¿Cómo explicar las mismas observaciones mediante el modelo de partículas? Primero tenemos que considerar la naturaleza de la superficie del vidrio. Aunque aparentemente homogénea, estamos en realidad ante una superficie rugosa: un microscopio lo suficientemente potente mostraría que tiene multitud de colinas y valles. Si las partículas de luz fueran similares a pequeñas bolitas de materia, al golpear una superficie tan rugosa lo que cabría esperar es que se dispersasen en todas direcciones. Por tanto, no serían reflejadas ni refractadas. Por lo tanto, hay que refinar el modelo. Newton argumentó que en realidad debe haber “algún rasgo del cuerpo que esté disperso uniformemente sobre su superficie y por el cual este actúa sobre el rayo sin contacto inmediato (some feature of the body which is evenly diffused over its surface and by which it acts upon the ray without immediate contact).

Vamos a seguir la idea de Newton, a ver a donde nos lleva. De entrada, en el caso de la reflexión, la fuerza actuante tendría que ser una que repela las partículas de luz. Pero claro, por la misma regla de tres, es necesaria una una fuerza que atraiga a las partículas de luz en lugar de repelerlas para explicar la refracción. Esto parece que se complica para el modelo de partículas. O no. Veamos

Cuando una partícula de luz se acerca a un límite con otro medio, primero tendría que superar la fuerza repelente. Si lo consiguiera, entonces encontraría una fuerza atractiva en el medio que la atraería hacia el medio. Dado que la fuerza atractiva sería un vector perpendicular a la superficie del medio, tomando como referencia la dirección del movimiento de la partícula ese vector tendría un componente en la dirección del movimiento original de la partícula, lo que implica que la velocidad de la partícula tendría que aumentar. Otra consecuencia es que, si el rayo de partículas se moviera con un ángulo oblicuo al límite, cambiaría de dirección a medida que entrase en el medio, girando hacia la línea perpendicular al límite.

De acuerdo con el modelo de partículas*, por lo tanto, podríamos afirmar lo siguiente:

1. Un rayo representa la dirección en la que se mueven las partículas.

2. En la reflexión, los ángulos de incidencia y reflexión son iguales. Esta predicción se puede derivar aplicando la ley de conservación del momento a partículas repelidas por una fuerza.

3. La refracción implica un cambio de velocidad de las partículas a medida que entran en otro medio. En concreto, cuando actúa una fuerza atractiva, la velocidad aumenta y el rayo cambia de dirección al entrar en el medio.

Figura 3. El modelo de partículas en acción. Fuente: Cassidy Physics Library

Figura 3. El modelo de partículas en acción. Fuente: Cassidy Physics Library Comparemos estas características del modelo de partículas con las características correspondientes del modelo de onda. La única diferencia está en la velocidad predicha para un rayo refractado. Observamos que un rayo se curva hacia la línea perpendicular cuando la luz pasa del aire al vidrio. El modelo de partículas predice que la luz tiene una velocidad mayor en el segundo medio. El modelo de ondas predice que la luz tiene una velocidad menor.

Podríamos pensar que no hay nada más fácil para averiguar qué modelo es el más correcto: diseñar un experimento para determinar qué predicción es correcta. Todo lo que uno tiene que hacer es medir la velocidad de la luz después de que haya entrado en el vidrio o en el agua y compararla con la velocidad de la luz en el aire. Pero no. A a finales del siglo XVII y principios del siglo XVIII, cuando Huygens argumentaba a favor del modelo de onda y Newton apoyaba el modelo de partículas, ningún experimento de este tipo era posible. La única forma disponible de medir la velocidad de la luz era la astronómica.

No sería hasta mediados del siglo XIX que Armand H.L. Fizeau y Jean B.L. Foucault conseguirían medir la velocidad de la luz en el agua. Los resultados concuerdan con las predicciones del modelo de onda: la velocidad de la luz es menor en el agua que en el aire.

Los experimentos de Foucault-Fizeau de 1850 se consideraron como el último clavo en el ataúd del modelo newtoniano de partículas para la luz, ya que, cuando se realizaron estos experimentos, buena parte de la comunidad científica ya había aceptado el modelo de onda por otras razones. Algunas de estas se derivaron del trabajo del científico inglés Thomas Young, y serán las que veamos a continuación.

Nota:

* Implícitamente en el argumento está la asunción sobre el límite del tamaño de las “partículas” de luz de Newton. Las partículas deben ser al menos tan pequeñas como las irregularidades en la superficie de un vidrio. Si fuesen mayores tendríamos el mismo efecto que una pelota de tenis rebotando en el rugoso suelo de hormigón, solo reflexión.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Reflexión y refracción de la luz se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:Un cartel para el día de pi

María Begoña Medel Bermejo

El alumnado del Grado en Creación y Diseño de la Facultad de Bellas Artes de la UPV/EHU comienza a adentrarse en el mundo del Diseño durante su tercer curso con una asignatura cuyo nombre es Diseño Gráfico.

Existe una discusión recurrente sobre la existencia o no de alguna diferencia entre el Arte y el Diseño. Desde esta asignatura, que imparto desde hace casi 30 años, suelo insistir en el hecho de que una de las características fundamentales, si no la más destacable, es la presencia de un cliente con una necesidad de comunicación. El cliente es el elemento que nos convierte en los profesionales intermediarios que resuelven un problema de comunicación, aplicando los conocimientos sobre el funcionamiento de la percepción humana en la creación de un conjunto único y original de imágenes y textos significantes que transmitirán el mensaje que se necesite.

Suele suceder que en el aula trabajamos con supuestos en los que el rol de cliente lo asume el docente o los propios alumnos, de manera rotativa. Pero, algunas veces tenemos la suerte de enfrentarnos a problemas reales para los que desarrollar soluciones de comunicación gráfica.

Durante este curso 2018-2019, de acuerdo con la Guía Docente de la asignatura Diseño Gráfico, el último proyecto que el alumnado debía desarrollar era un cartel.

Ya habíamos colaborado en otras ocasiones con otras facultades y entidades públicas en temas similares pero, nunca habíamos trabajado con la Facultad de Ciencia y Tecnología.

Tener como cliente a alguien cuyo día a día es tan diferente del nuestro era el mayor atractivo que encontré a esta posibilidad. La innovación, la creación nunca surge si trabajamos dentro de nuestra área de confort. Salir de lo común, de lo reiterativo, supone colocarse en ese lugar que resulta incómodo porque no lo conocemos, y mirar todo aquello que vamos descubriendo con ojos limpios.

Por todo lo dicho hasta ahora me puse en contacto con algunos profesores del área de Matemáticas para preguntarles si tenían algún tema en el que pudiéramos colaborar. La respuesta fue inmediata y muy positiva, necesitaban publicitar la jornada BCAM-Naukas en el día de Pi y era posible colaborar. Participar en un evento organizado por la Cátedra de Cultura Científica de la UPV/EHU, Naukas y BCAM (Basque Center for Applied Mathematics) ha sido un reto para el alumnado y la oportunidad de hacer algo que no quedara entre las paredes de la clase como un proyecto académico más, si no que consiguiera trascender y llegar al público colocando a ambas facultades y a la UPV/EHU en el punto de mira de nuestro cliente específico, el posible futuro alumnado.

Ya teníamos el tema para el proyecto de cartel de este curso.

En clase, cuando planteé el tema, hubo todo tipo de reacciones: desde el entusiasmo al temor ante lo desconocido. Pero, en general, fue bien acogido dado que la posibilidad de hacer algo real suele ser muy valorada por el alumnado.

Participaron 56 alumnas y alumnos de dos grupos, castellano y euskera, de tercer curso del grado en Creación y Diseño. Cada uno de ellos debía llevar a cabo una labor de recopilación de información sobre el tema que les permitiera llegar a concebir al menos tres conceptos totalmente diferentes que sirvieran para comunicar la celebración del día de Pi.

Cuando desarrollamos conceptos de comunicación gráfica trabajamos la creatividad desde diversos lugares para poder encontrar esa imagen que consiga atraer la atención del espectador estableciendo un vínculo emocional al conseguir descifrar el mensaje. Se trata de hacer sonreír a nuestro cerebro.

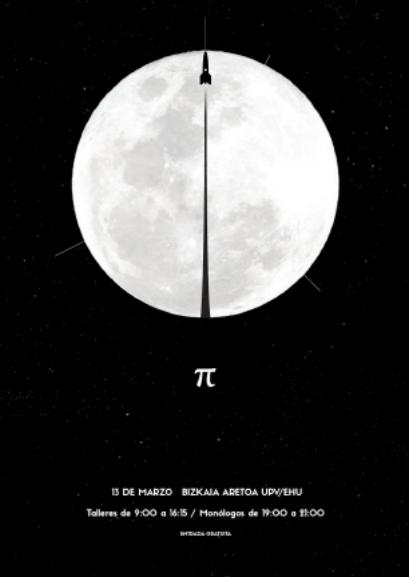

Creo que el resultado obtenido este curso permite constatar que el acercamiento al mundo de las matemáticas permite una multiplicidad de caminos. Como colofón de esta experiencia se han seleccionado dos carteles: el de Paula Castro como cartel de la jornada del 13 de marzo de 2019 y el de Jone Aldalur para comunicar la realización de talleres para escolares. Se trata de las dos primeras imágenes que aparecen a continuación junto con otros 10 carteles que fueron pre-seleccionados:

Obra de Paula Castro. Éste ha sido el cartel seleccionado como imagen general del día de Pi. La relación y conexión entre la ciencia y la profundidad del cosmos se ha realizado mediante la utilización de la imagen icónica de la luna, que representa la circunferencia, y la estela de condensación que genera el cohete en referencia al diámetro.

Obra de Paula Castro. Éste ha sido el cartel seleccionado como imagen general del día de Pi. La relación y conexión entre la ciencia y la profundidad del cosmos se ha realizado mediante la utilización de la imagen icónica de la luna, que representa la circunferencia, y la estela de condensación que genera el cohete en referencia al diámetro. Obra de Jone Aldalur. Se utilizó la imagen para informar sobre los talleres del día de Pi. Las pelotas con números Pi dentro del frasco tienen colores llamativos para atrapar nuestra mirada y a su vez nos remiten a los juegos de azar en los que esos números pueden decidir nuestra suerte.

Obra de Jone Aldalur. Se utilizó la imagen para informar sobre los talleres del día de Pi. Las pelotas con números Pi dentro del frasco tienen colores llamativos para atrapar nuestra mirada y a su vez nos remiten a los juegos de azar en los que esos números pueden decidir nuestra suerte.  Obra de José Manuel García. Un contraluz crea un ambiente narrativo en el que el número Pi aparece sobre una colina desde la que surge un camino de estrellas hacia el cielo.

Obra de José Manuel García. Un contraluz crea un ambiente narrativo en el que el número Pi aparece sobre una colina desde la que surge un camino de estrellas hacia el cielo. Obra de David von Heeren. Gestos positivos realizados con las manos nos sirven para crear una pequeña adivinanza ayudados por los personajes del fondo, que nos proporcionan la pista necesaria para encontrar la clave.

Obra de David von Heeren. Gestos positivos realizados con las manos nos sirven para crear una pequeña adivinanza ayudados por los personajes del fondo, que nos proporcionan la pista necesaria para encontrar la clave. Obra de Jon Flores. A veces se ve más lo que no está que lo que está. Se trabaja con la elipsis repetida del elemento fundamental del cartel. Si no lo leemos en voz alta puede que no seamos capaces de descubrir el juego visual.

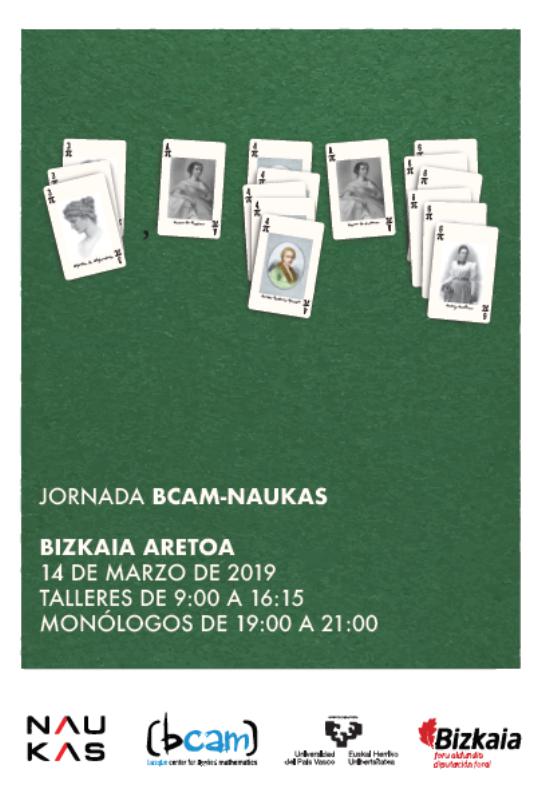

Obra de Jon Flores. A veces se ve más lo que no está que lo que está. Se trabaja con la elipsis repetida del elemento fundamental del cartel. Si no lo leemos en voz alta puede que no seamos capaces de descubrir el juego visual. Obra de Ainhoa Simpler. Como si fuera un juego solitario aparecen las cartas en grupos que remiten a las primeras cifras del número Pi y en cada una de ellas descubrimos la imagen de una matemática famosa.

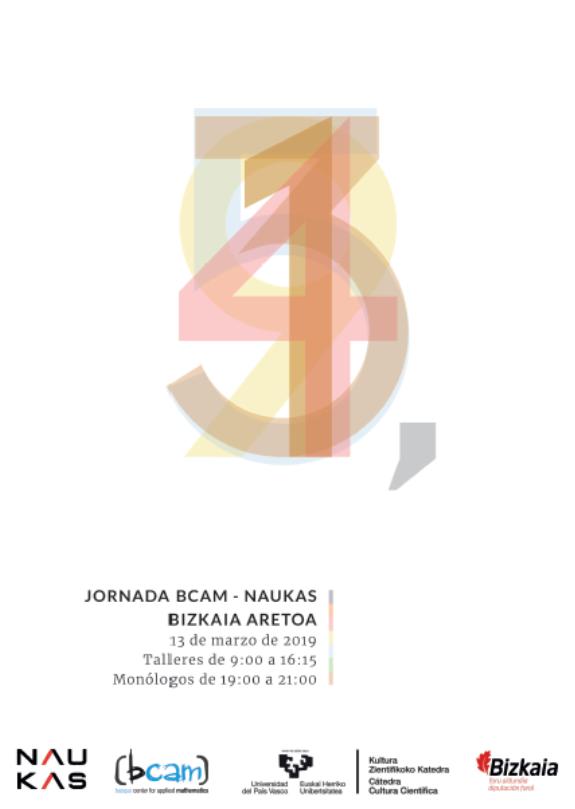

Obra de Ainhoa Simpler. Como si fuera un juego solitario aparecen las cartas en grupos que remiten a las primeras cifras del número Pi y en cada una de ellas descubrimos la imagen de una matemática famosa. Obra de Maialen Sayans. El todo y sus partes. Los primeros números de la sucesión infinita de Pi colocados en visión frontal se convierten en un juego de transparencias que crean otra realidad.

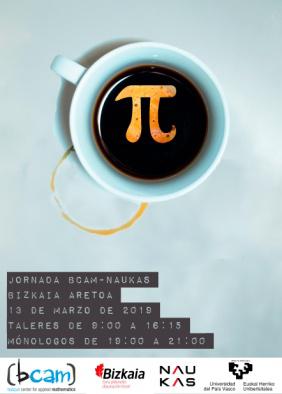

Obra de Maialen Sayans. El todo y sus partes. Los primeros números de la sucesión infinita de Pi colocados en visión frontal se convierten en un juego de transparencias que crean otra realidad. Obra de Eva Muñoz. Hasta ahora muchos matemáticos han perdido el sueño investigando el número Pi y tomando café para mantenerse despiertos. La huella del café sobre la mesa es un guiño a la circunferencia y su diámetro.

Obra de Eva Muñoz. Hasta ahora muchos matemáticos han perdido el sueño investigando el número Pi y tomando café para mantenerse despiertos. La huella del café sobre la mesa es un guiño a la circunferencia y su diámetro. Obra de Mikel Larena. Juego de transparencias con la sucesión del número Pi.

Obra de Mikel Larena. Juego de transparencias con la sucesión del número Pi. Obra de Anne Fernandez. Un papel arrugado con forma esférica repleto de fórmulas matemáticas aparece en primer plano con un fondo realizado con una regla de círculos.

Obra de Anne Fernandez. Un papel arrugado con forma esférica repleto de fórmulas matemáticas aparece en primer plano con un fondo realizado con una regla de círculos. Obra de 11 Laiene Pagazaurtundua. Metáfora visual “el árbol de la ciencia”

Obra de 11 Laiene Pagazaurtundua. Metáfora visual “el árbol de la ciencia” Obra de Lukas Zelaia. Sustitución de un elemento arquitectónico por un Pi gigante que genera en el espectador nuevos puntos de vista y relaciones emocionales con la imagen mediante esta conexión inusual.

Obra de Lukas Zelaia. Sustitución de un elemento arquitectónico por un Pi gigante que genera en el espectador nuevos puntos de vista y relaciones emocionales con la imagen mediante esta conexión inusual.Todas ellas son imágenes muy diferentes que aportan acercamientos originales al concepto de PI desde el mundo del Diseño Gráfico.

Esperamos seguir colaborando en próximas ediciones siempre mejorando la presente y que sea de nuevo una experiencia enriquecedora para ambas facultades.

Sobre la autora: María Begoña Medel Bermejo es Doctora en Bellas Artes y profesora del Grado en Creación y Diseño BBAA/AAEE de la UPV /EHU

El artículo Un cartel para el día de pi se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Una fórmula para dominarlos a todos: La conservación de la energía y la ley de la palanca

- Marcas de agua digitales, qué son y para qué sirven

- El consumo de alcohol para el corazón y las dificultades de divulgar ciencia

El hígado y la vesícula biliar

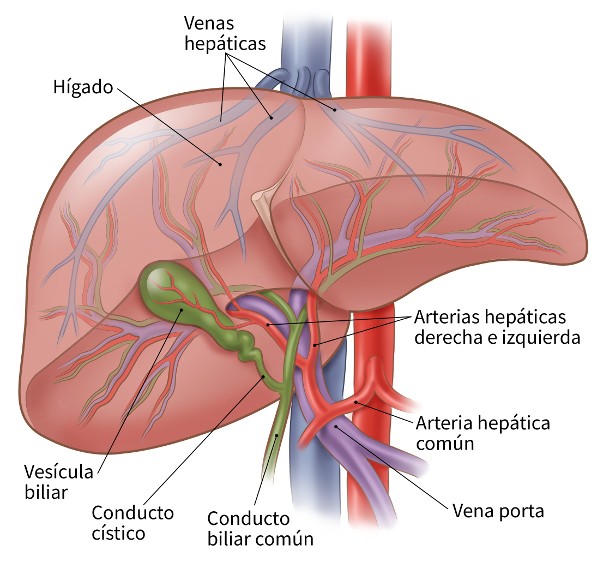

Además de las secreciones pancreáticas, el intestino delgado también recibe secreciones procedentes del sistema biliar, que está formado por el hígado y la vesícula biliar. Nos referimos, en concreto, a la bilis y, en particular, a las sales biliares. Es este el principal asunto que trataremos en esta anotación.

Higado y vesícula biliar humanos. Imagen: cancer.org

Higado y vesícula biliar humanos. Imagen: cancer.orgPero eso será algo más adelante, porque al hígado corresponden funciones adicionales de gran relevancia que queremos consignar aquí para dejar constancia de ellas. Para empezar, es el órgano que gobierna el metabolismo del conjunto del organismo; podría decirse que es el órgano metabólico maestro, su director. Se ocupa del procesamiento metabólico de proteínas, carbohidratos y lípidos, tras su absorción en el intestino, incluyendo también la gluconeogénesis (síntesis metabólica de glucosa a partir de precursores no glucídicos). Y almacena glucógeno y grasas, a la vez que otras sustancias de menor relevancia cuantitativa, como hierro, cobre y varias vitaminas.

El hígado también se ocupa de degradar productos residuales y hormonas, además de eliminar agentes tóxicos y sustancias, procedentes del exterior, sin utilidad biológica o potencialmente peligrosas (fármacos, por ejemplo). También sintetiza proteínas y lipoproteínas plasmáticas, entre las que se encuentran las que participan en la coagulación de la sangre y las que transportan fosfolípidos, colesterol y hormonas esteroideas y tiroideas.

A las tareas anteriores, hay que añadir que activa la vitamina D (tarea compartida con el riñón); elimina, mediante el concurso de sus macrófagos (células de Kupffer), bacterias y glóbulos rojos que ya han finalizado su vida útil; secreta las hormonas trombopoietina (estimula la producción de plaquetas), hepcidina (regula el metabolismo del hierro en mamíferos), IGF 1 o factor de crecimiento insulínico 1 (estimula el crecimiento); excreta el colesterol y la biliverdina y bilirrubina, que son productos derivados de la degradación de la hemoglobina; y en algunas especies de mamíferos (no en primates y conejillos de India) y de aves sintetiza ácido ascórbico (vitamina C).

Es de destacar que con la excepción de las células de Kupffer, todas las funciones aquí consignadas son realizadas por un mismo tipo celular, el hepatocito. Por lo tanto, no hay diferenciación de funciones con arreglo a tipos celulares (puesto que solo hay los dos citados), sino en virtud de los orgánulos en que se desarrolla cada una de ellas. En ellos radica la función y esta se diferencia de unos orgánulos a otros.

El hígado es un órgano muy irrigado, y el flujo sanguíneo en su interior está organizado de tal modo que cada hepatocito está en contacto con sangre venosa proveniente del tubo digestivo y sangre arterial procedente de la aorta. Los capilares procedentes del intestino se van agrupando hasta confluir en la vena porta hepática que penetra en el hígado donde se vuelve a ramificar en múltiples capilares, formando una red de (los denominados) sinusoides hepáticos. Esos sinusoides son los que permiten que la sangre procedente directamente del estómago e intestino delgado difunda a todas las células del hígado para que provean a estos de las sustancias absorbidas. La sangre sale del órgano con los productos elaborados o expulsados para su eliminación (como la urea, por ejemplo) y lo hace a través de la vena hepática, en la que confluyen los capilares que lo drenan. Además de la sangre procedente del digestivo, al hígado también le llega sangre arterial con oxígeno y otras sustancias procedentes del conjunto del organismo para su procesamiento en los hepatocitos.

El hígado se organiza en lóbulos, disposiciones hexagonales de tejido en torno a una vena central. A lo largo de los vértices exteriores de los lóbulos discurren una rama de la vena porta hepática, otra de la arteria hepática y un ducto biliar. De la vena y arteria citadas salen amplios sinusoides que se dirigen hacia la vena central. Las células de Kupffer tapizan los sinusoides, atrapan a cuantas bacterias y eritrocitos fuera de servicio se encuentran, y los eliminan. Los hepatocitos se disponen en placas de dos células cada una, de manera que todas se encuentran en contacto con los vasos sanguíneos, como hemos dicho antes. Las venas centrales de cada lóbulo convergen en la vena hepática que es la que sale del hígado y se une a la vena cava inferior.

El canalículo de la bilis discurre entre las dos células de cada placa, recibiendo secreción biliar de todas ellas. Los canalículos se dirigen hacia el exterior del lóbulo y transportan así la bilis hasta los ductos que se encuentran en los vértices de los hexágonos (lóbulos hepáticos); los ductos de cada lóbulo acaban agrupándose en el ducto hepático común, que es el que lleva la bilis al duodeno.

El hígado produce bilis de forma permanente, pero el acceso de la bilis al duodeno se encuentra controlado por el esfínter de Oddi, que solo permite su paso cuando hay quimo en el duodeno y puede, por lo tanto, ser utilizado. Cuando el esfínter se encuentra cerrado las sales biliares se acumulan en la vesícula biliar, que hace las veces de depósito. Con cada comida la bilis entra en el duodeno debido al vaciado de la vesícula y al aumento en la producción a cargo del hígado. Los seres humanos producimos entre 250 ml y 1 l de bilis cada día. El mensajero que desencadena la contracción de la vesícula y la relajación del esfínter de Oddi es la hormona CCK (la colecistoquinina que vimos en El páncreas) y que se libera por efecto de la presencia de grasa en el duodeno.

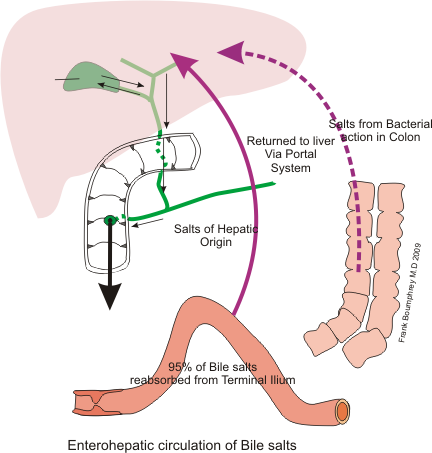

Imagen: Wikimedia Commons

Imagen: Wikimedia CommonsLa bilis contiene colesterol, lecitina, sales biliares, y bilirrubina y biliverdina, y estas sustancias se encuentran en una solución ligeramente básica, similar a la producida por las células de los ductos del páncreas. Las sales biliares son derivados del colesterol y participan en la digestión y absorción de las grasas debido a su acción detergente y a la formación de micelas. Tras su intervención la digestión de lípidos, son reabsorbidas mediante transporte activo en el íleon, la zona terminal del intestino delgado. De allí, a través del sistema porta, vuelven al hígado. Se calcula que en promedio, en cada comida unas mismas sales circulan dos veces por el duodeno e intestino delgado, y que cada día se pierden con las heces un 5% de las sales biliares. Su pérdida es repuesta por los hepatocitos de manera que el total se mantiene constante.

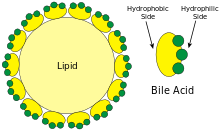

Emulsificación de los lípidos por las sales biliares. Imagen: Wikimedia Commons

Emulsificación de los lípidos por las sales biliares. Imagen: Wikimedia CommonsLas sales biliares intervienen en la digestión de las grasas favoreciendo su emulsificación. Convierten gotas grandes de lípidos en gotas de muy pequeño tamaño suspendidas en el quimo acuoso. De esa forma aumenta muchísimo la relación superficie/volumen y exponiendo una mayor superficie micelar a la acción de la lipasa pancreática, de manera que esta puede atacar las moléculas de triglicéridos. Sin la formación de emulsiones, la mayor parte de esos triglicéridos quedarían en el interior de las gotas grandes lejos del alcance enzimático.

Las sales biliares actúan como los jabones. Ambos son anfipáticos: contienen una porción hidrofóbica (un esteroide derivado del colesterol) y otra hidrofílica con carga negativa (una taurina o glicina) . Las sales se adsorben a la superficie de una gota de grasa, con una orientación acorde a su naturaleza; esto es, la porción liposoluble interactúa con la superficie de la gota lipídica, mientras que la porción cargada queda orientada hacia el exterior y disuelta en agua. Los movimientos intestinales ayudan a fragmentar esas gotas lipídicas y hacer que sean cada vez más pequeñas. En ausencia de sales biliares (detergente), las pequeñas gotas tenderían a caolescer, volviéndose a formar grandes gotas. Pero eso no ocurre porque las cargas negativas solubles en agua lo impiden; forman una especie de capa de cargas negativas que se repelen unas a otras, de manera que no llegan a entrar en contacto. Las gotas lipídicas pequeñas tienen un diámetro que varía entre 200 y 5000 nm.

Para la digestión de las grasas es esencial el concurso de la lipasa procedente del páncreas. La acción de esta enzima es efectiva porque el páncreas secreta la coenzima colipasa, también un péptido alifático, que ocupa el lugar de algunas sales biliares en la superficie de las gotas lipídicas y desde esa posición se une a la lipasa de manera que esta pueda hacer su trabajo. La enzima queda así enganchada a la superficie de las gotas, rodeada de sales biliares, pero de tal forma que puede actuar directamente sobre las moléculas lipídicas.

La absorción de lípidos en el intestino se produce gracias a la formación de micelas. Las micelas son estructuras de entre 3 y 10 nm de diámetro en las que intervienen, además de las sales biliares, el fosfolípido lecitina y el colesterol. La lecitina, como las sales biliares, es anfipática, de manera que se asocia con las sales formando agrupaciones cuya porción hidrofóbica se dispone en el interior, junto al colesterol, y la porción hidrofílica en el exterior. De esa forma, moléculas hidrofóbicas que resultan de la digestión de los lípidos (monoglicéridos, ácidos grasos libres y vitaminas liposolubles) son transportados en emulsión acuosa, gracias a la cubierta hidrofílica, hasta los enclaves del epitelio intestinal donde son absorbidos.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo El hígado y la vesícula biliar se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Avances contra la enfermedad de hígado graso no alcohólica

- Una ecuación para determinar la grasa en el hígado a partir de una resonancia

- Proteínas plasmáticas

La adaptación a los incendios forestales

Para empezar y como ejemplo nos sirve la Comunidad Autónoma del País Vasco. El 27 de diciembre de 2016 aprobó el Consejo del Gobierno Vasco el Plan Especial de Emergencias por Riesgo de Incendios Forestales. En el texto, en la página 9, aparece un cuadro con la superficie quemada en la Comunidad entre 1985 y 2012. El máximo está en el catastrófico 1989, en el mes de diciembre, con más de 27000 hectáreas de superficie arbolada. Fue una sequía en invierno, después de una larga sequía estival, y con fuertes vientos que dificultaban la extinción de los incendios.

El siguiente año en superficie quemada fue 1985, con casi 2600 hectáreas, seguido de 2002 con 700 hectáreas y 1995 con 600 hectáreas. En 2011 fueron 140 hectáreas y en 2012, último año con datos en este Plan, fueron 175 hectáreas. En España, y según datos del Ministerio de Medio Ambiente, los años recientes con más de 400000 hectáreas quemadas fueron 1985, 1989 y 1994.

Estos son los datos para la Comunidad y para España y no hay que olvidar que a nivel del planeta, más o menos el 3% de su superficie se quema cada año. Los incendios forestales aparecen cuando las plantas colonizan la tierra, en bosques de entre 350 y 400 millones de años de antigüedad. Hay restos de carbón de incendios tan antiguos como del Silúrico, hace unos 400 millones de años.

Cada fuego es una combinación particular de frecuencia, intensidad, tamaño, estación, tipo de propagación y extensión. Pero, también es evidente que los incendios influyen, además de todo lo que significan como suceso público, en nuestra percepción del entorno, en concreto, del paisaje. Francisco Lloret y sus colegas, de la Universitat Autònoma de Barcelona, han estudiado los cambios en el paisaje en el municipio de Tivissa, en Tarragona, entre 1956 y 1993.

Tivissa. Imagen: Wikimedia Commons

Tivissa. Imagen: Wikimedia CommonsEs un municipio agrícola con zonas difíciles y poco productivas que se han abandonado en los últimos años, y se han cubierto de matorrales que han homogeneizado el paisaje. Además, ha disminuido la superficie de bosques. Los autores encuentran que los incendios son más probables en áreas homogéneas con árboles, y provocan que el paisaje posterior también sea homogéneo.

Concluyen que, en las zonas con actividad humana el paisaje es más heterogéneo, por ejemplo, con distintas actividades agrícolas y modelos de explotación de la tierra, y los incendios se controlan mejor quizá por ser heterogéneas, con diferentes plantaciones que, a su vez, tienen diferente capacidad de incendiarse. Y, además, los que se aprovechan de las actividades agrícolas procuran defenderlas del fuego y no provocar incendios.

En las zonas sin actividad agrícola, muy iguales, con árboles y arbustos, los incendios se extienden con más facilidad y provocan, después y en primer término, mayor diversidad.

Es evidente que, sea a más o a menos diversidad, los incendios influyen en el paisaje y en nuestra precepción del mismo.

El incendio acercándose al complejo de Old Faithful en el Parque Nacional de Yellowstone (Estados Unidos) en 1988. Imagen: Wikimedia Commons

El incendio acercándose al complejo de Old Faithful en el Parque Nacional de Yellowstone (Estados Unidos) en 1988. Imagen: Wikimedia CommonsSin embargo, un paisaje quemado se puede recuperar, quizá no exactamente igual al que existía antes del fuego, y puede convertirse en un área ecológicamente saludable. Fue el año 1988, en una gran sequía que, al año siguiente, en 1989, provocaría los incendios en el País Vasco, cuando ocurrió el gran incendio en Estados Unidos, en el Parque Nacional de Yellowstone, en el que ardieron más de 600000 hectáreas, algo así como Gipuzkoa, Bizkaia y gran parte de Álava. Fue uno de los mayores incendios forestales en una zona templada que aparece en la historia escrita. Daniel Donato y su grupo, del Departamento de Recursos Naturales del Estado de Washington en Olympia, nos cuentan cómo está el parque 24 años después.

Las zonas centrales del bosque, más tupidas y con más árboles, se han regenerado con fuerza y no ha influido la severidad del incendio. Las zonas más secas, con menos árboles, se han recuperado peor, en más tiempo, y, sobre todo, lo hacían con más eficacia si cerca habían quedado parcelas pequeñas sin quemar que pueden funcionar como reserva de semillas.

Una de las zonas de pino de Yellowstone que ardieron en 1988 tal y como se encontraba en 2006. El pino que sobrevivió (a la izquierda) es un Picea engelmannii, los jóvenes, Pinus contorta. Imagen: Wikimedia Commons

Una de las zonas de pino de Yellowstone que ardieron en 1988 tal y como se encontraba en 2006. El pino que sobrevivió (a la izquierda) es un Picea engelmannii, los jóvenes, Pinus contorta. Imagen: Wikimedia CommonsLa regeneración culminó, en general, a los 15 años del incendio aunque, en las mejores zonas, el crecimiento ha continuado. A los 24 años, en esas zonas de bosque más maduro, el reemplazamiento de los árboles anteriores al incendio está completo. En las áreas más secas y con menos bosque, ha quedado, en muchos lugares, una estepa herbácea que necesitará varias décadas o, incluso, teniendo en cuenta el calentamiento global, nunca volverá a ser bosque.

Los resultados sobre incendios en la Península Ibérica son parecidos, tanto en Galicia, según el grupo de Otilia Reyes, de la Universidad de Santiago de Compostela, como en Cataluña, según Santiago Martín y Lluis Coll, del Centro de Ciencias Forestales de Solsona.

Son dos paisajes diferentes en dos climas distintos, en el oeste y este de la Península. En ambos casos, los incendios fueron en bosques de pinos, con el pino marítimo (Pinus pinaster), en Serres, en la costa de A Coruña y en 2014, un año antes del estudio, y pino laricio (Pinus nigra) en el centro de Cataluña y en 1998, siete años anterior al estudio.

Los resultados son parecidos y, como en Yellowstone, cuanto más potente es el bosque original, mejor se recupera. Y, también, ayuda la presencia de pequeñas parcelas no quemadas como origen de semillas para repoblar. Solo en las zonas más secas aparecen áreas con arbustos o praderas. Para la recuperación de las zonas con buen bosque original no se necesita ninguna intervención.

Como nos cuentan William Bond y John Keeley, de las universidades de El Cabo, en Sudáfrica, y de California en Los Angeles, grandes áreas del mundo arden de manera regular y, por tanto, los ecosistemas se han incendiado durante cientos de millones de años. Hay evidencias de incendios de hace 420 millones de años, desde la aparición de las plantas terrestres. Así se ha construido el paisaje que conocemos y se mantienen la estructura y la función de esos ecosistemas, muy adaptados a los incendios periódicos. Por tanto, los incendios son una fuerza evolutiva de selección natural lo que implica que los bosques que ahora conocemos se han seleccionado y aguantan y se recuperan de los incendios porque así se han formado. Y el fuego estimula la regeneración con, por ejemplo, semillas que germinan estimuladas por el calor o por sustancias químicas emitidas por la madera quemada o, también, la floración acelerada por el fuego.

Después de revisar incendios y diversidad de plantas en todo el planeta, excepto la Antártida, y desde finales del siglo XX hasta inicios de XXI, Juli Pausas y Eloi Ribeiro, del CIDE-CSIC de Montcada, en Valencia, y del ISRIC de Wageningen, en Holanda, han recopilado casi 200 millones de citas. Sus resultados demuestran que la mayor diversidad de plantas se da con la mayor productividad y, también, con la actividad de incendios. Así, el fuego explica una proporción significativa de la diversidad de las plantas. En conclusión, el fuego aumenta la heterogeneidad del paisaje y crea nuevos nichos con oportunidades para una gran variedad de especies.

Paisaje un año después de un incendio en un bosque de pinos. Imagen: Wikimedia Commons

Paisaje un año después de un incendio en un bosque de pinos. Imagen: Wikimedia CommonsLas plantas adaptadas al fuego han seleccionado determinadas características que les benefician en caso de incendio. En las áreas con clima mediterráneo, como la propia cuenca del Mediterráneo, California, región de El Cabo en Sudáfrica y Chile, el grupo de Philip Rundel, de la Universidad de California en Los Angeles, han revisado el número de especies vegetales adaptadas al fuego. En el Mediterráneo abundan las plantas que rebrotan después del incendio; tienen germinación estimulada por el fuego, sea por el calor, o por el humo; y florecen estimuladas por el fuego. Para estas especies, el fuego ha sido un estímulo importante para la diversificación y aparición de nuevas especies.

Como resumen final sirve la publicación de Juli Pausas y Jon Keeley, del Centro de Investigación sobre Desertificación del CSIC en Valencia y del Servicio Geológico de Estados Unidos respectivamente, cuando escriben que no solo el clima y el suelo explican la distribución de las especies animales y vegetales en el planeta, también interviene el fuego. Desde hace mucho tiempo, unos 400 millones de años, impulsando la aparición de especies nuevas adaptadas a los incendios periódicos. Sin embargo, nuestra especie ha cambiado la relación entre el fuego y los seres vivos. Primero, Homo utilizó el fuego para adaptar el entorno a sus necesidades. Pero, y en segundo lugar, lo hace con tal intensidad y extensión que cambió muchos ecosistemas y pone en peligro la sostenibilidad.

Referencias:

Archibald, S. et al. 2018. Biological and geophysical feedbacks with fire in the Earth system. Environmental Research Letters 13: 033003.

Bond, W.J. & Keeley, J.E. 2005. Fire as a global “herbivore”: the ecology and evolution of flammable ecosystems. Trends in Ecology and Evolution 20: 387-394.

Bowman, D.M.J.S. et al. 2009. Fire in the Earth system. Science 324: 481-484.

Donato, D.C. et al. 2016. Regeneration of montane forests 24 years after the 1988 Yellowstone fires: A fire-catalyzed shift in lower treelines? Ecosphere 7: e01410

Pausas, J.G. & Keeley, J.E. 2009. A burning story: The role of fire in the history of life. BioScience 59: 593-601.

Pausas, J.G. & Ribeiro. E. 2017. Fire and plant diversity at the global scale. Global Ecology and Biogeography DOI: 10.1111/geb.12596

Rundel, P.W. et al. 2018. Fire and plant diversification in Mediterranean-climate regions. Frontiers in Plant Science 9: 851.

Sobre el autor: Eduardo Angulo es doctor en biología, profesor de biología celular de la UPV/EHU retirado y divulgador científico. Ha publicado varios libros y es autor de La biología estupenda.

El artículo La adaptación a los incendios forestales se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Incendios, los grafos de visibilidad y la conjetura de Collatz

- “El bien común como adaptación” por Antonio Lafuente

- Las aves de Prometeo

¿Existe el geoturismo?

Si cerrásemos los ojos para visualizar la imagen de un geólogo, probablemente imaginaríamos a una persona descubriendo fósiles y recopilando y coleccionando minerales. No obstante, esta disciplina académica cuenta con muchísimas más aplicaciones desconocidas para gran parte de la sociedad.

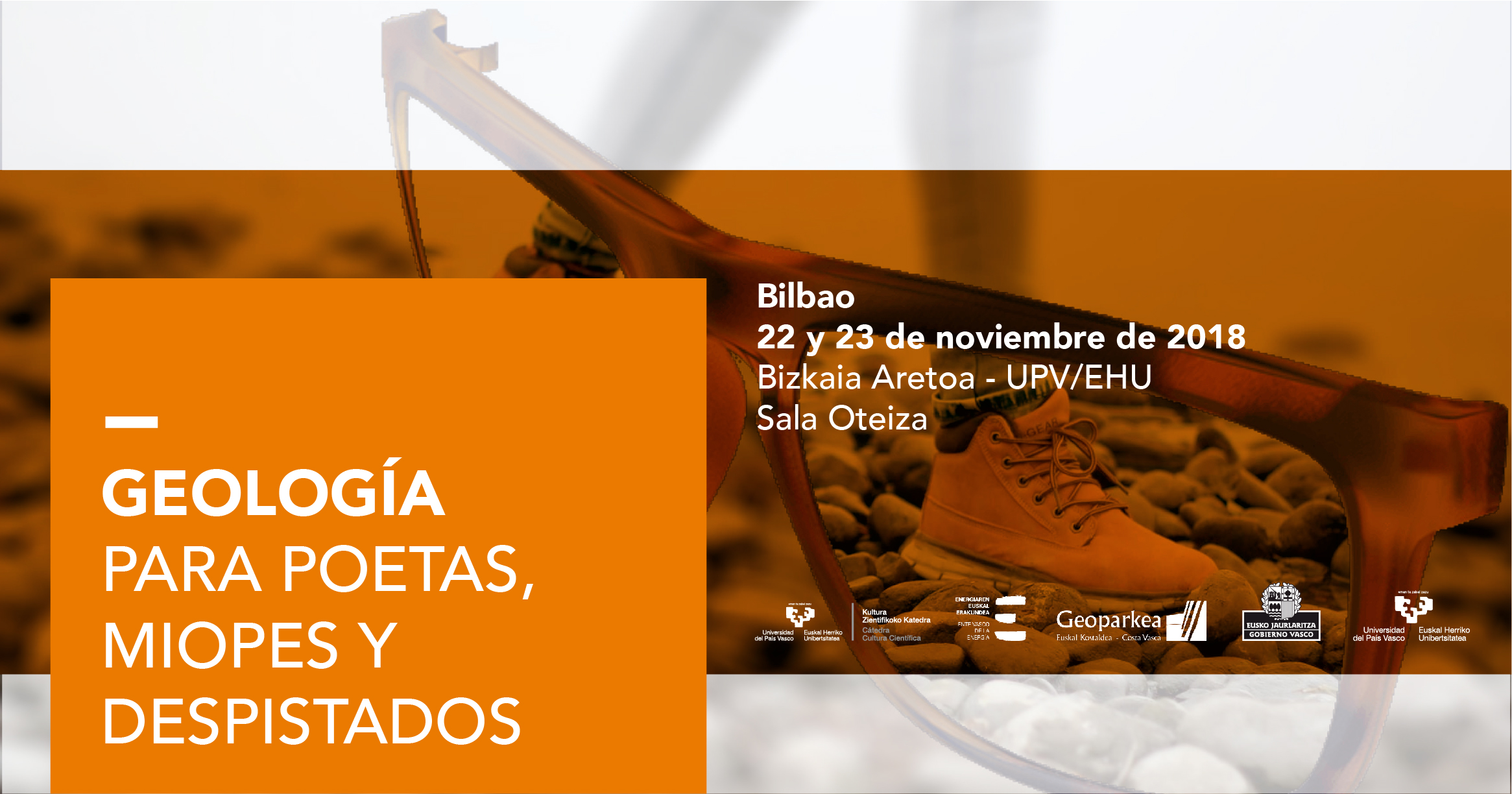

Con el objetivo de dar visibilidad a esos otros aspectos que también forman parte de este campo científico nacieron las jornadas divulgativas “Abre los ojos y mira lo que pisas: Geología para miopes, poetas y despistados”, que se celebraron los días 22 y 23 de noviembre de 2018 en el Bizkaia Aretoa de la UPV/EHU en Bilbao.

La iniciativa estuvo organizada por miembros de la Sección de Geología de la Facultad de Ciencia y Tecnología de la UPV/EHU, en colaboración con el Vicerrectorado del Campus de Bizkaia, el Ente Vasco de la Energía (EVE-EEE), el Departamento de Medio Ambiente, Planificación Territorial y Vivienda del Gobierno Vasco, el Geoparque mundial UNESCO de la Costa Vasca y la Cátedra de Cultura Científica de la UPV/EHU.

Los invitados, expertos en campos como la arquitectura, el turismo o el cambio climático, se encargaron de mostrar el lado más práctico y aplicado de la geología, así como de visibilizar la importancia de esta ciencia en otros ámbitos de especialización.

Asier Hilario, director científico del Geoparque de la Costa Vasca, se encarga de ahondar en la geología como recurso. Algunos de los principales destinos turísticos del mundo son pura geología, tienen millones de visitantes y aunque muchos no lo sepan, hay algo de esa geología que les interesa. Desde su experiencia, expone las principales claves y oportunidades del geoturismo para crear destinos de turismo innovadores y sostenibles que fomenten el disfrute y conocimiento de las ciencias de la Tierra.

Edición realizada por César Tomé López

El artículo ¿Existe el geoturismo? se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Geología, ver más allá de lo que pisamos

- Patrimonio geológico: la otra mitad del ambiente

- Geología: la clave para saber de dónde venimos y hacia dónde vamos

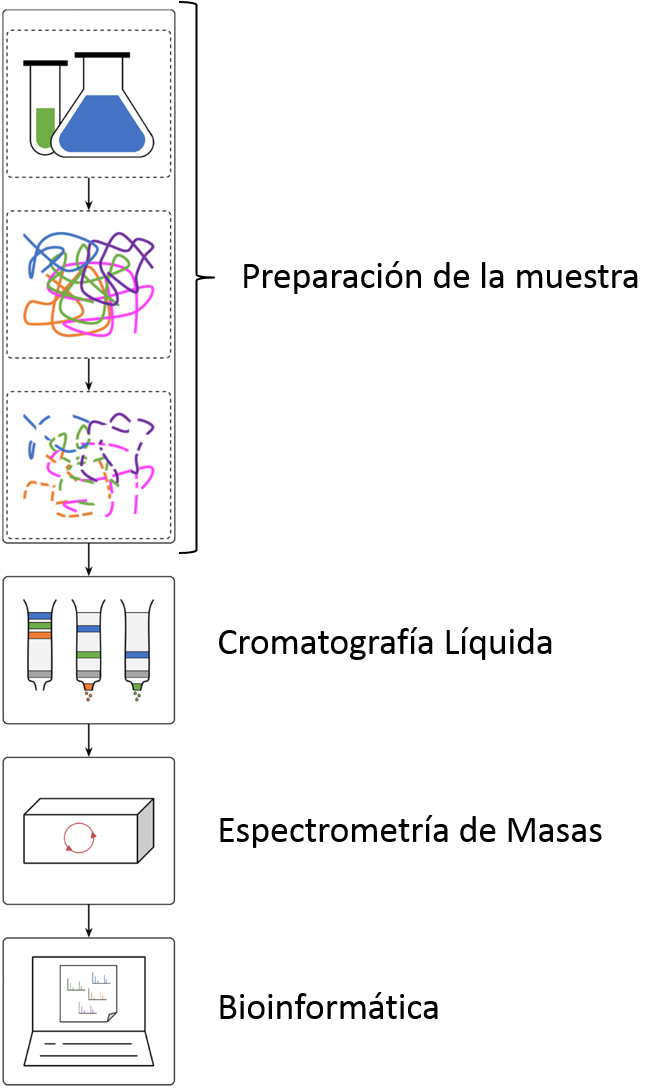

Proteómica: cuando las proteínas y la espectrometría de masas van de la mano

La Facultad de Ciencias de Bilbao comenzó su andadura en el curso 1968/69. 50 años después la Facultad de Ciencia y Tecnología de la UPV/EHU celebrará dicho acontecimiento dando a conocer el impacto que la Facultad ha tenido en nuestra sociedad. Durante las próximas semanas en el Cuaderno de Cultura Científica y en Zientzia Kaiera se publicarán regularmente artículos que narren algunas de las contribuciones más significativas realizadas a lo largo de estas cinco décadas. Comenzamos con la serie “Espectrometría de masas”, técnica analítica que supone el ejemplo perfecto del incesante avance de la Ciencia y la Tecnología.

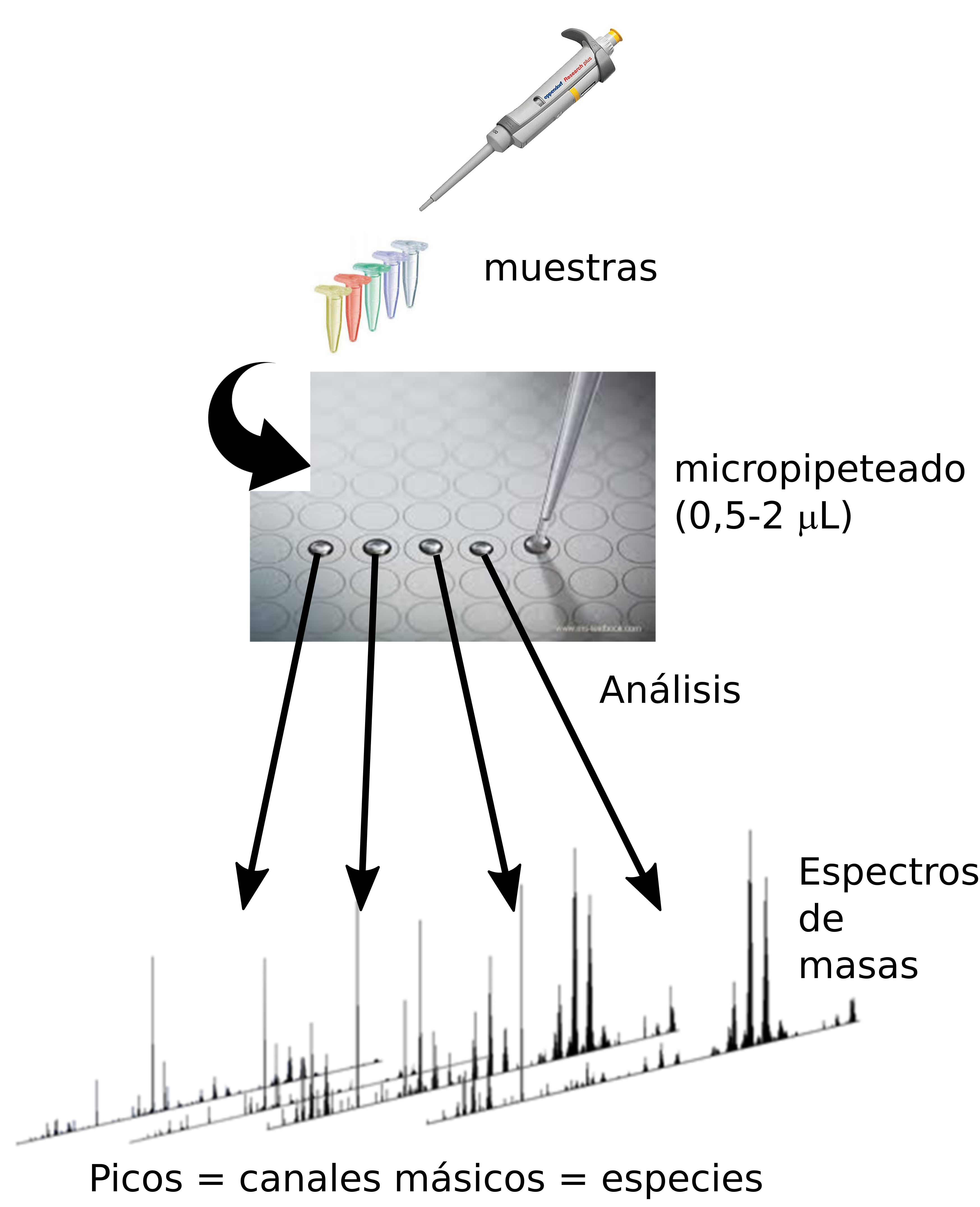

La espectrometría de masas (MS) es una técnica habitual entre los químicos desde hace ya 100 años, pero no fue hasta hace 3 décadas que se empezó a utilizar como técnica de análisis de proteínas. Para analizar un analito mediante espectrometría de masas (MS) es necesario ionizar dicho analito y pasarlo a fase gaseosa. Durante mucho tiempo, la posibilidad de ionizar macromoléculas como las proteínas o fragmentos de proteínas, es decir péptidos, y pasarlos a fase gaseosa se consideraba una tarea tan posible como hacer volar a un elefante. Sin embargo, el desarrollo y comercialización de dos métodos de ionización a los que se denominó ionización “suave”, demostraron que era posible analizar macromoléculas del tamaño de las proteínas, tanto en disolución como en estado seco cristalino; éstos métodos de ionización se conocen hoy día como ionización electrospray (ESI) y ionización por desorción láser asistida por matriz, (matrix assisted laser desorption ionization) (MALDI). En ESI, se aplica un alto voltaje a la solución que contiene el analito a su paso por una fina aguja perforada. A medida que se va evaporando la solución con las moléculas cargadas, se va reduciendo el tamaño de las gotas, hasta conseguir que pasen a estado gaseoso. Por su parte, en MALDI se dispara con láser a una placa de acero en la que se ha secado el analito junto con una matriz. La matriz absorbe la energía del láser que a su vez se transfiere a la muestra, haciendo que cambie a estado gaseoso.

Pero, ¿por qué las proteínas? ¿a qué viene ese interés por analizarlas? La razón es que las proteínas son las moléculas fundamentales de todos los seres vivos. Las proteínas son las encargadas de realizar diversas tareas en nuestras células; entre otras, catalizan reacciones químicas, transportan moléculas, mantienen la estructura celular y nos protegen frente a los patógenos. Nuestro cuerpo está formado por trillones de células, y cada una de ellas cuenta con miles de proteínas diferentes. De hecho, dependiendo del catálogo o conjunto de proteínas que contenga un tipo de célula, llevará a cabo unas u otras funciones y tendrá unas u otras características. Todas las células de un ser vivo contienen la misma información genética, es decir, el genoma de todas sus células es idéntico. La información necesaria para producir cada proteína está escrita en los genes. Dicho de otro modo, los genes son las recetas que se siguen para crear las proteínas, y dependiendo de las recetas que se utilicen en cada momento, se producirán unas proteínas u otras. Se denomina proteoma a la colección de proteínas de las que dispone una célula en un momento concreto. A diferencia del genoma, el proteoma celular varía continuamente; en respuesta a cualquier estímulo que llegue a las células, o cuando deben hacer frente a cualquier ataque, es decir, con el fin de adaptarse al entorno, las células producirán diferentes proteínas que trabajarán conjuntamente. Esto explica cómo, contando ambas con el mismo genoma, una oruga se convierta en mariposa (Imagen 1).

Imagen 1. Papilio machaon oruga (a) y mariposa (b). Fuente: Wikimedia Commons.

Imagen 1. Papilio machaon oruga (a) y mariposa (b). Fuente: Wikimedia Commons.Las proteínas, al igual que nosotros, tienen sus propias «redes sociales». Cumplen sus funciones interaccionando entre ellas más que individualmente. A pesar de ello, estas interacciones suelen ser, en la mayoría de los casos, temporales. Se crean y se destruyen según las necesidades celulares. Habiendo millones de proteínas en la células, la red de interacciones intracelulares es tan compleja como la que puede haber entre todas las personas del planeta. El funcionamiento de esa red de proteínas condicionará la salud de la célula y, en consecuencia, la de todo el organismo. Por eso es tan importante estudiar las proteínas y sus interacciones, es decir, los proteomas, e intentar interpretarlos en su conjunto. En consecuencia, uno de los retos fundamentales de la biología actual es describir los proteomas cualitativamente y cuantitativamente. Dicho objetivo parece alcanzable y pocos dudan del liderazgo que ha tomado la proteómica en este camino.

La proteómica estudia los proteomas. Fue en 1975 cuando por primera vez se separaron miles de proteínas de la bacteria Escherichia coli mediante electroforesis bidimensional en gel (2DE). Sin embargo, la identificación de dichas proteínas, concretar cuáles eran exactamente, constituía otro reto diferente. Para abordarlo, fue necesario, tanto desarrollar técnicas de secuenciación parcial, léase degradación de Edman, como ajustar la propia técnica de espectrometría de masas (MS) al análisis de proteínas. La MS es, a día de hoy, el método que se utiliza habitualmente para identificar proteínas. Para poder interpretar los proteomas en su conjunto, además de identificar las proteínas, hay que cuantificarlas. Los primeros pasos para la cuantificación de proteínas se dieron mediante el análisis de imágenes de los geles de 2DE. Si bien sigue siendo una técnica adecuada para el análisis proteómico, hoy en día ocupa un segundo lugar, muy por detrás de la proteómica basada en la espectrometría de masas (MS-based proteomics). De hecho, actualmente, la MS es el método habitual para identificar y cuantificar las proteínas en muestras proteicas complejas. Se ha convertido pues en una técnica fundamental para interpretar la información codificada en el genoma.

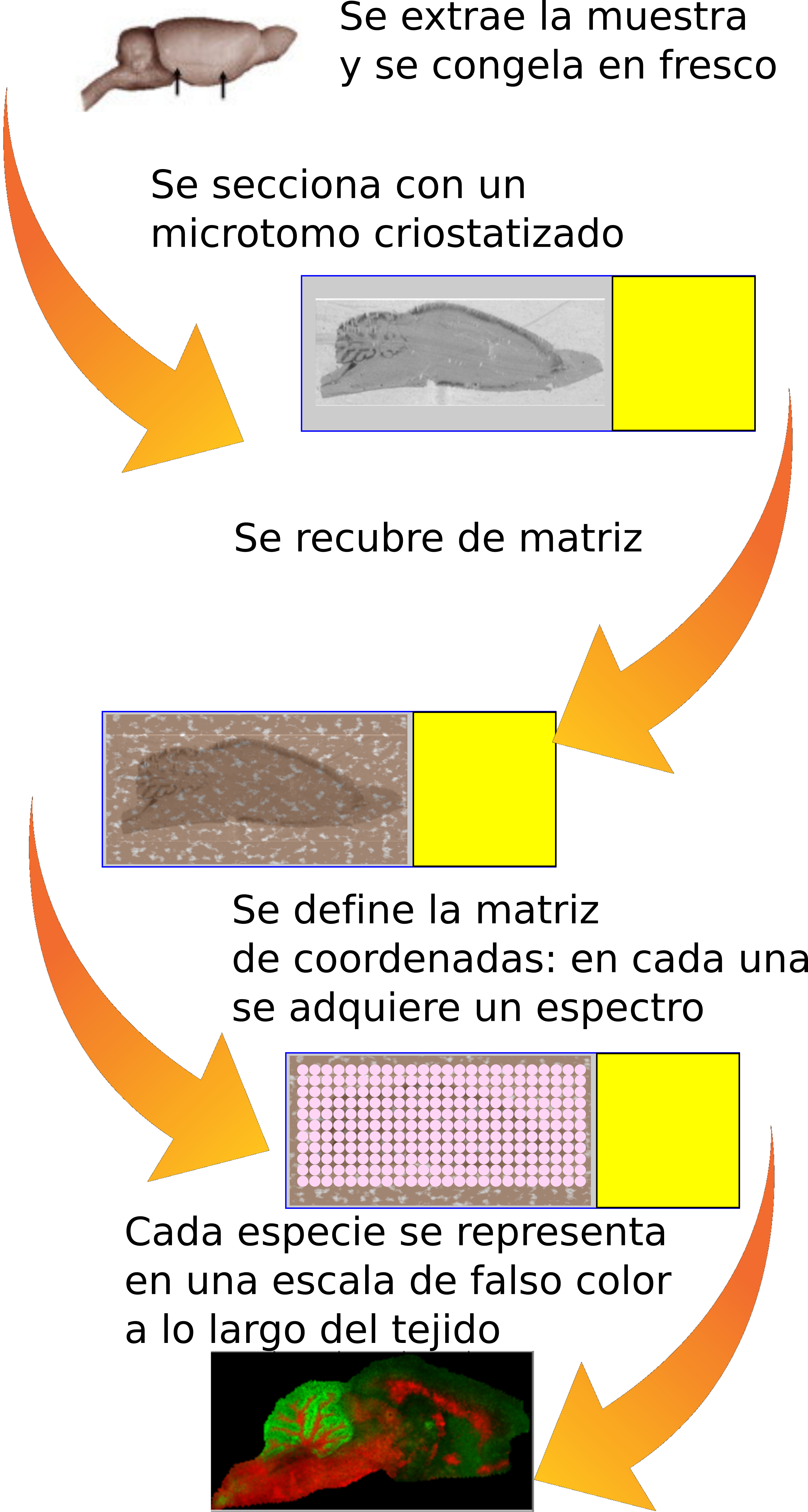

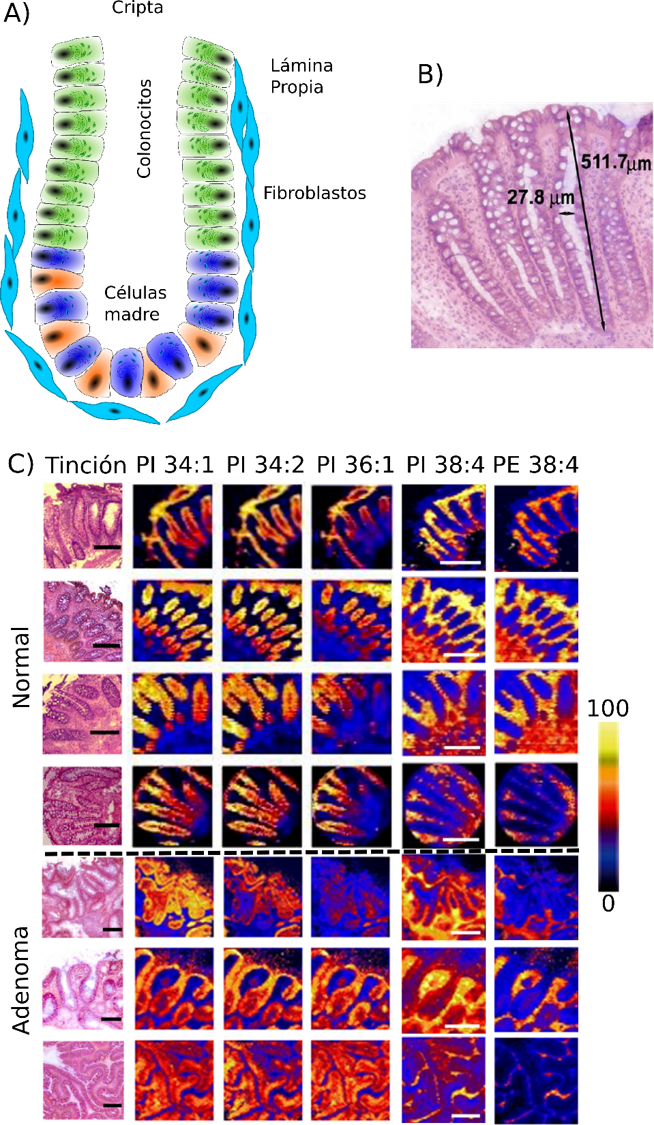

Tal y como se ha mencionado anteriormente, las técnicas habituales utilizadas para ionizar y evaporar proteínas y péptidos son ESI y MALDI. La técnica MALDI-MS se utiliza para analizar mezclas de péptidos relativamente simples. En cambio, los sistemas ESI-MS acoplados a la cromatografía líquida (LC-MS), son los más adecuados para el análisis de muestras complejas. Siendo los proteomas, por definición, complejos, las técnicas de LC-MS han prevalecido en la proteómica. La precisión, sensibilidad y resolución de masas, junto con su velocidad, son las claves del éxito de las técnicas de LC-MS. Durante los últimos años, se ha podido identificar, cuantificar y caracterizar un enorme número de proteomas mediante diferentes procedimientos de LC-MS. Entre los logros conseguidos a nivel de proteómica, cabe destacar dos borradores del proteoma humano publicados en 2014, y el actual Proyecto Proteoma Humano (HPP) dirigido por la Organización Mundial del Proteoma Humano (HUPO)