Einstein y la pizarra del Observatorio del Monte Wilson

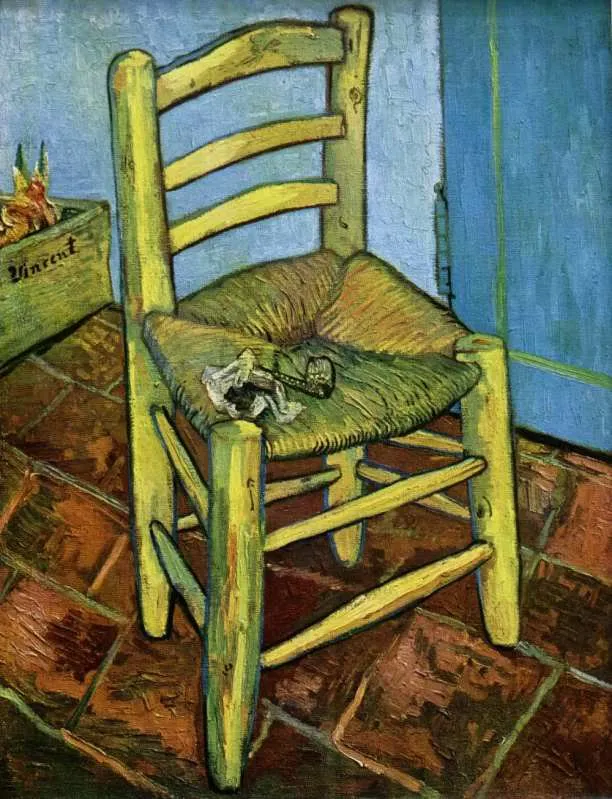

La foto que abre esta entrada es bastante popular. Más que por la foto en sí, por una aplicación que permite escribir en la pizarra lo que cada cual quiera. Y, sin embargo, esta foto tiene una historia cuando menos curiosa que nos va a permitir explorar someramente la idea de curvatura y cómo expresarla usando una herramienta matemática tremendamente útil en física, los tensores, a la par que rememorar un momento muy interesante en la historia de la cosmología.

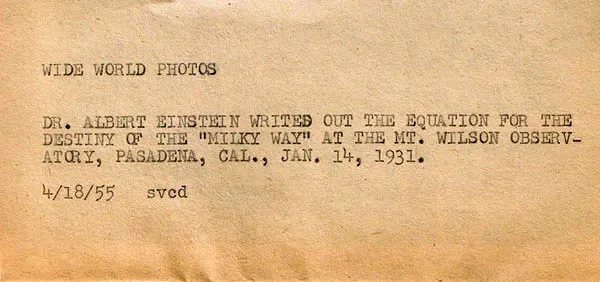

En una época anterior a internet, las fotos de las noticias eran enviadas por las agencias de prensa por correo ordinario urgente a los distintos periódicos. Cada fotografía llevaba anexa su historia escrita por la agencia de noticias adherida a la parte posterior, de esa forma el periódico no tenía que complicarse a la hora elaborar el pie de foto.

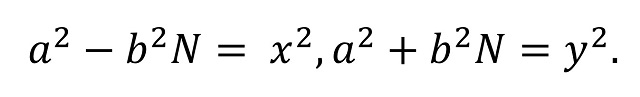

La foto de Einstein fue tomada el 14 de enero de 1931 durante su visita al complejo del Observatorio del Monte Wilson en California (Estados Unidos). Sin embargo, se hizo pública 24 años después, con motivo de la muerte de Einstein el 18 de abril de 1955. El pie de foto con el que apareció en prensa decía: “Dr. Albert Einstein writes an equation for the density of the Milky Way on the blackboard at the Carnegie Institute, Mt. Wilson Observatory headquarters in Pasadena, Calif., in this Jan. 14, 1931.” En español se tradujo tal cual, por ejemplo: “Einstein escribe una ecuación sobre la densidad de la Vía Láctea en un pizarrón del Observatorio Monte Wilson, en Pasadena, California, en 1931”. Pero, ¿desde cuándo una densidad se expresa con subíndices y con la letra R? ¿La densidad de la Vía Láctea es cero? No parece tener sentido.

La historia anexa a la foto que mandó la agencia de noticias podría ayudarnos a desvelar esta posible contradicción. El original es el siguiente:

Vemos que “density” era originalmente “destiny”. ¿Podría haber ocurrido que el avezado reportero de la agencia de noticias se limitase a reflejar la frase que entendió y le llamó la atención y que, en algún paso intermedio, alguien decidiese que el “destino” no puede expresarse en una ecuación y que lo que quería decir es “densidad”? Podría ser. Parecería incluso más probable que Einstein lo que hacía era escribir sobre la curvatura del espaciotiempo. Pero, en realidad, lo que estaba haciendo es considerar el problema de la existencia de la constante cosmológica. Vamos a verlo, que es muy fácil de entender intuitivamente.

Si cortas una naranja por la mitad, quitas la pulpa del interior, e intentas aplanar el hemisferio de piel resultante, terminas rajándolo. Si tratas de aplanar algo con la forma de una silla de montar, como una patata frita (de las de bolsa) revenida, te encuentras con el problema contrario: hay “demasiada” superficie y se te forman pliegues. Si tomas, sin embargo, un rollo de papel de cocina y deseas aplanarlo, no hay nada más fácil, con desenrollarlo, listo. Las superficies como las esferas se dice que están curvadas positivamente, las que tienen la forma de una silla de montar que lo están negativamente, y las que son como el papel de cocina son, simplemente, planas (démonos cuenta de que son planas en este sentido aunque no estén en un plano). Esto es así porque la curvatura se define en términos de “geometría intrínseca” de una superficie, en la que la distancia se mide en función de los caminos que están dentro de la superficie.

Hay varias maneras de hacer precisa esta noción de curvatura y hacerla cuantitativa, de tal manera que a cada punto de la superficie se pueda asociar un número que diga “cómo de curvada” está en ese punto. Para poder hacer esto es necesario que se cumplan determinadas condiciones matemáticas que permitan determinar las longitudes de los caminos, es lo que se llama una métrica riemanniana. La noción de curvatura puede ser generalizada a un mayor número de dimensiones, de tal forma que se habla de la curvatura en un punto en una variedad riemanniana de d dimensiones. Sin embargo, cuando la dimensión es mayor de dos, es decir, no es un plano lo que se curva sino un espacio, las posibilidades de curvatura en un punto se hacen tan complicadas que ya no pueden ser expresadas por un número sino por algo llamado el tensor de Ricci.

Un tensor no es más que la extensión del concepto de vector a dimensiones adicionales. Un escalar, un número, aparece en un gráfico como un punto, un objeto de cero dimensiones. Un vector, que tiene magnitud y dirección, aparecería en un gráfico como una línea, es decir, como un objeto de una dimensión. El tensor extiende esta idea a las dimensiones adicionales. Esto podemos interpretarlo como un conjunto de vectores relacionados, moviéndose en múltiples direcciones en un plano.

Lo veremos mejor de otra manera. En vez de pensar en un vector como un conjunto de coordenadas, lo podemos considerar una operación, es decir, un vector lo que haría es asociar una dirección a un número. Lo importante desde el punto de vista matemático es que la operación es lineal y homogénea. Gracias a esto, un vector queda completamente determinado por sus proyecciones en d direcciones, donde d es el número de dimensiones del espacio en el que se define. Por tanto, un vector se puede expresar como un conjunto de números que son en realidad sus proyecciones en un sistema de ejes coordenados.

Un vector es realmente un tensor de rango 1, asocia 1 dirección a un número. Un escalar, es un tensor de rango 0, asocia 0 direcciones a un número. Por tanto un tensor de rango 2 (un tensor ya por derecho propio), asocia dos direcciones arbitrarias a un número. Si quisiéramos expresarlo en términos de las d coordenadas, como se hace con los vectores, necesitaríamos d x d números. Para un tensor de rango q, por tanto, necesitaríamos nq números.

Veamos ahora desde el punto de vista formal las ecuaciones de campo de la relatividad general. Si has llegado leyendo hasta aquí no te asustará demasiado, después de todo no es más que una igualdad tensorial en la que se relacionan un conjunto de tensores 4 x 4 (simétricos, pero en esto no vamos a entrar ahora), para un espaciotiempo de 4 dimensiones. Así:

![]()

Donde Rμν es el tensor de curvatura de Ricci del que hablábamos más arriba, R es la curvatura escalar (simplificando, la curvatura entendida en el sentido que hablábamos más arriba, un número asociado a un punto del espacio), gμν es el tensor métrico (una generalización del campo gravitatorio y principal objeto de interés), Λ es la constante cosmológica, G es la constante gravitacional de Newton, c la velocidad de la luz en el vacío y Tμν el tensor de energía-impulso.

Los índices en los tensores son etiquetas, es una forma de llamarlos. En este caso empleamos la notación abstracta de Penrose. Se puede usar cualquier símbolo conveniente para los índices de los tensores. Tradicionalmente, las letras latinas se usan para indicar que se están usando coordenadas espaciales (x, y, z), mientras que las griegas se emplean para indicar coordenadas espaciotemporales (x, y, z, t). En la época de la foto esta convención no se había establecido.

Una simple observación de la ecuación de campo nos dice que podría haber algo similar con lo que escribe Einstein en la pizarra: el tensor de Ricci. Efectivamente, existe un caso especial de la ecuación de campo en el que se postula que Tμν = 0, es decir, que la energía y el momento se conservan localmente. En este caso, y por las propiedades de los tensores, solo existe una posibilidad para que Rμν= 0 o, usando la notación de Einstein, Rik = 0, y es que Λ = 0. En definitiva, que el pie de foto podría ser “El Dr. Einstein discutiendo [por lo de la interrogación] la posibilidad de que la constante cosmológica sea cero”.

Para saber más:

Las ecuaciones de campo de la relatividad general

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

Una versión anterior de este artículo se publicó en Experientia Docet el 17 de diciembre de 2010.

El artículo Einstein y la pizarra del Observatorio del Monte Wilson se ha escrito en Cuaderno de Cultura Científica.

Por qué la obesidad es un imán para otras enfermedades

Francisco José Esteban Ruiz

Foto: TheOtherKev / Pixabay

Foto: TheOtherKev / PixabaySin entrar en el debate de si la obesidad debe o no considerarse una enfermedad, y siendo conscientes de que sus causas pueden ser múltiples, nos enfrentamos a un verdadero problema de salud pública que aumenta tanto la morbilidad (enfermar) como la mortalidad (morir debido a ello).

Independientemente de lo que nos lleve a pasarnos del peso que se considera dentro de lo normal, esos kilos de más nos afectan de un modo u otro. Existen pruebas irrefutables de que la obesidad es un importante factor de riesgo para padecer otras enfermedades como hipertensión, dislipemia (alteración de la cantidad de lípidos en sangre, como el colesterol), diabetes, enfermedades cardiacas e infartos cerebrales, piedras en la vesícula, artrosis, ovario poliquístico, síndrome de apnea del sueño y algunos tipos de cáncer. Y nos hemos quedado cortos, pues se considera que la obesidad y el sobrepeso incrementan el riesgo y favorecen el desarrollo de más de 200 enfermedades crónicas.

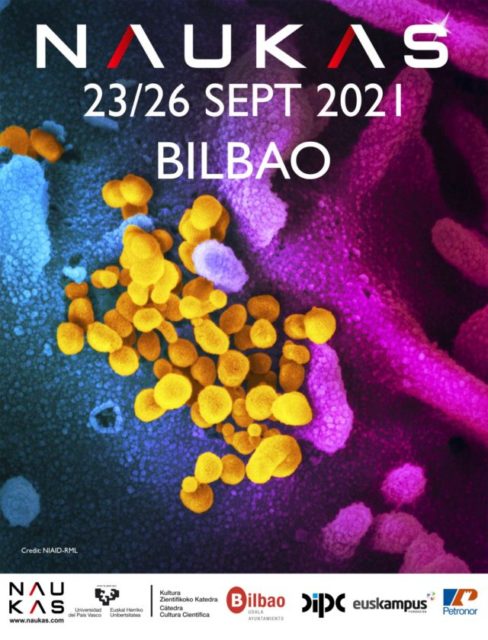

Además, y desafortunadamente, desde el inicio de la pandemia debida al coronavirus se hizo patente el hecho de que la obesidad empeoraba la situación. Sí, desde hace años se conoce que las personas obesas son más vulnerables a las infecciones y a las complicaciones derivadas de las mismas. En el caso concreto de la covid-19, y según un estudio de la Sociedad Española de Obesidad, el 80% de las personas con manifestaciones severas por coronavirus en España eran obesas.

La acumulación de grasa enferma al tejido

¿A qué se debe que el ser obeso aumente el riesgo de contraer otras enfermedades? La investigación en biología celular, bioquímica y genética nos ayuda a responder.

La principales células responsables del almacenamiento de grasa en nuestro cuerpo son los adipocitos, que forman parte del llamado tejido adiposo. En este tejido también hay otros tipos celulares, como los linfocitos y los macrófagos del sistema inmune, y el buen estado de salud del tejido depende de que exista un equilibrio funcional entre todos los tipos de células.

Pues bien, en la base de la obesidad se encuentra la adiposopatía, que podemos decir que es una alteración que se produce debido a que, por diferentes causas, ingerimos más calorías de las que gastamos. Esto da lugar a una alteración anatómica (deposición anormal de grasa) y funcional (inmune y hormonal) del tejido adiposo que puede causar o empeorar una enfermedad metabólica.

¿Y qué es una enfermedad metabólica? Sencillamente un daño debido a la alteración de nuestras vías metabólicas, como la del colesterol, la insulina y las hormonales, que a su vez dan lugar a enfermedades como arterioesclerosis, la hipertensión, la diabetes y un aumento de hormonas masculinas en mujeres y su disminución en hombres.

La grasa se acumula donde no debe

Cuando los adipocitos comienzan a acumular más grasa de lo normal también se produce deposición de grasa más allá de donde debería, por ejemplo, en el hígado y en el músculo. Junto a la adiposopatía, este hecho provoca una alteración en la secreción de hormonas, como la leptina, y de toda una serie de proteínas proinflamatorias, como las citoquinas.

Además, la obesidad da lugar a una deposición anormal de grasa alrededor del corazón. Un estudio reciente realizado sobre casi 7 000 participantes ha puesto de manifiesto que el aumento de la grasa pericárdica se asocia con el riesgo de fallo cardiaco.

El aumento en la secreción de citoquinas debido a la obesidad no sólo reduce la capacidad de responder a la infección respiratoria causada por el coronavirus, sino que provoca que todo empeore. Más aún, la asociación de la obesidad con una disminución de la función inmune hace que estos pacientes sean más susceptibles a todo tipo de infecciones.

En cuanto al tratamiento, en los obesos disminuye la respuesta a los antivirales y son menos eficaces las vacunas.

El novelista Charles Dickens dijo que “cuanto más engorda uno, más prudente se vuelve. Prudencia y barriga son dos cosas que crecen simultáneamente”. Visto lo visto, más vale que seamos prudentes y no hagamos crecer la barriga.![]()

Sobre el autor: Francisco José Esteban Ruiz es profesor titular de biología celular en la Universidad de Jaén

Este artículo fue publicado originalmente en The Conversation. Artículo original.

El artículo Por qué la obesidad es un imán para otras enfermedades se ha escrito en Cuaderno de Cultura Científica.

Ignorantes que creen saberlo todo

Foto: Brett Jordan / Unsplash

Foto: Brett Jordan / UnsplashLa búsqueda de información en Google ofusca la percepción acerca del origen de lo que sabemos o creemos saber. Al demandar a Google datos, historias, piezas de conocimiento del tipo que sea, tendemos a considerar como propio el origen de la información que nos da el buscador. Esto es, tendemos a pensar que ya disponíamos de ella, y así sobrevaloramos nuestros recursos y capacidades cognitivas. Esta es la principal conclusión de un estudio publicado hace unas semanas en la revista PNAS.

El hecho en sí, el recabar conocimiento ajeno, no es inhabitual en absoluto. Nadie lo sabe todo. Dependemos del conocimiento de familiares, amistades, colegas. Configuramos con esas personas sistemas cognitivos compartidos que nos permiten atender, procesar y recordar información de forma colectiva. No necesitamos saberlo todo; lo que necesitamos es saber quién sabe qué cosas. La ciencia, por ejemplo, funciona así, sobre la base de un conocimiento y comprensión de los fenómenos de la naturaleza compartidos de forma parcial por centenares de miles de personas, muchas de las cuales ni siquiera viven en la actualidad. La cognición humana no es individual; el pensar, recordar y conocer son, muy a menudo, colaborativos, el producto de la interacción entre recursos cognitivos propios y ajenos.

En las últimas décadas, a los mecanismos clásicos de cooperación cognitiva se ha sumado la internet y sus sistemas de búsqueda rápida. La red permite expandir la mente dotándonos de una memoria externa que se puede consultar cada vez que se necesita. Lo sabe casi todo y está siempre a nuestra disposición; nos proporciona la información que deseamos en el instante en que la solicitamos, sin esfuerzo por nuestra parte, con mayor facilidad, incluso, que si la obtuviésemos de nuestra misma mente. No tenemos que acudir a la biblioteca o consultar con un colega por teléfono. Es esa particularidad, esa facilidad para acceder a ella, la ausencia de otros actos intermedios, lo que, al parecer, hace que se difuminen las fronteras entre el conocimiento interno y el externo. Tendemos a pensar que el conocimiento de internet es nuestro conocimiento.

Como se difumina la frontera entre conocimiento externo e interno, quienes recurren con mayor frecuencia a internet para buscar información tienen más confianza en su memoria. A menudo olvidan, incluso, que habían recurrido a Google para saber algo. Creen que las respuestas obtenidas de internet procedían de su propia memoria.

Sabíamos del denominado “efecto Google”: cuando obtenemos información fácilmente en internet, tendemos a no almacenarla en nuestra memoria o, incluso, a olvidarla con facilidad. Pues bien, el estudio citado antes ha revelado la existencia de un segundo efecto Google, uno que no se refiere a lo que la gente sabe, sino a lo que cree saber. Como consecuencia, en un mundo en el que la búsqueda en internet es con frecuencia más rápida y fácil que bucear en la memoria propia, la gente puede llegar a saber menos, aunque crea saber más.

Las implicaciones de este fenómeno pueden ser variadas e importantes. Al aumentar la confianza de las personas en su conocimiento y comprensión, puede distorsionar su juicio acerca del aprendizaje y la motivación para aprender. Puede también otorgar mayor (e injustificada) confianza en el criterio propio a la hora de tomar ciertas decisiones. Y puesto que somos poco dados a cuestionar lo que consideramos conocimiento propio, al borrarse la frontera con el que obtenemos de la red, es más difícil detectar informaciones erróneas, con las consecuencias que se pueden derivar de ello.

¿Se imagina un mundo lleno de ignorantes que creen saberlo casi todo? Sé que exagero, pero quizás no demasiado. Piénselo.

Fuente: Ward, A. F. (2021): People mistake the internet’s knowledge for their own. Proceedings of the National Academy of Sciences, 118 (43) e2105061118.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Ignorantes que creen saberlo todo se ha escrito en Cuaderno de Cultura Científica.

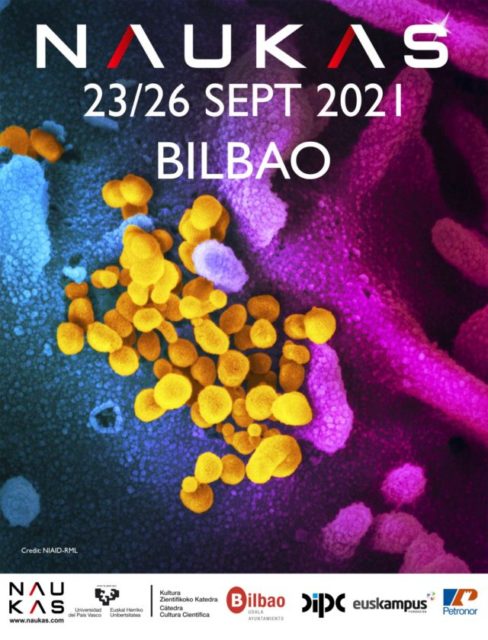

Naukas Bilbao 2021: Esther Samper – Eran otros tiempos

El gran evento de divulgación Naukas regresó a Bilbao para celebrar su décima edición en el magnífico Palacio Euskalduna durante los pasados 23, 24, 25 y 26 de septiembre.

Ningún tiempo pasado fue mejor que hoy en términos sanitarios. Sin embargo, la pandemia ha puesto de manifiesto la existencia de una parte de la sociedad que es presa fácil de los enemigos de la medicina de base científica; que es, por cierto, la única medicina (las alternativas, por definición, no tienen base científica). Esther Samper, que es doctora en medicina regenerativa y comunicadora, lidia con estos enemigos a diario.

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Naukas Bilbao 2021: Esther Samper – Eran otros tiempos se ha escrito en Cuaderno de Cultura Científica.

Una nueva especie extremófila en el Valle Salado de Añana

Fuente: Fundación Valle Salado de Añana

Fuente: Fundación Valle Salado de AñanaEl Valle Salado de Añana es una zona muy biodiversa, en la que las especies acuáticas son especialmente llamativas. Los análisis realizados por el grupo de investigación MikroIker, de la Universidad del País Vasco/Euskal Herriko Unibertsitatea, han aportado información sobre la existencia de una nueva especie microbiana. La nueva especie bacteriana aislada en el agua del manantial de Santa Engracia ha sido bautizada como Altererythrobacter muriae, y, por el momento, solo ha sido identificada en ese lugar.

“Los estudios poblacionales microbianos realizados durante los últimos años en el Valle Salado de Añana nos están permitiendo conocer la evolución y la relación entre las especies detectadas en ese ambiente. Hemos observado cómo existe la posibilidad de estar ante algunas nuevas especies bacterianas no descritas anteriormente que sean únicas de ese ecosistema, lo que cerciora la biodiversidad exclusiva del lugar aumentando su valor ecológico”.

Ilargi Martinez-Ballesteros.

Los ambientes hipersalinos se consideran ambientes metabólicamente extremos y son habitados por un grupo diverso de microorganismos con capacidad para sobrevivir en concentraciones variables (2-30 %) de cloruro sódico (sal), denominados halófilos. El Valle Salado de Añana se emplaza sobre una gran burbuja de sal que procede de la desecación de un antiguo mar de hace 200 millones de años. El agua dulce de lluvia atraviesa las capas más profundas de halita o sal gema disolviéndola y aflora en forma de manantiales hipersalinos, ofreciendo así hábitat a una gran diversidad de microorganismos halófilos y halotolerantes.

Existe una amplia variedad de halófilos (pertenecientes a los tres dominios principales de la vida, Archaea, Bacteria y Eukarya), que transforman una amplia gama de sustratos en los hábitats hipersalinos. Además, los distintos mecanismos de haloadaptación desarrollados por los microorganismos en esas condiciones extremas han derivado en la producción de compuestos útiles para la supervivencia microbiana que, a su vez, han resultado ser de gran interés en los ámbitos de la biomedicina, la biorremediación o la industria alimentaria.

“Los microorganismos son indispensables en el mantenimiento de la biosfera, ya que regulan los ciclos biogeoquímicos de los principales elementos, participan en los procesos de descomposición de materia orgánica, favorecen el ciclaje de nutrientes, y degradan compuestos contaminantes, procesos indispensables en el mantenimiento de los ecosistemas”.

Ilargi Martinez-Ballesteros.

A la hora de comprender la diversidad microbiana en ambientes extremos, como es el Valle Salado de Añana, es importante estudiar la composición de las comunidades procariotas (bacterias y arqueas) tanto en los manantiales salinos de los que se extrae sal en distintos puntos del valle, como de afluentes salobres que afloran en otros puntos del valle. “Esto permitirá generar conocimiento básico sobre las poblaciones microbianas allí presentes, sus patrones de distribución y su potencial uso biotecnológico en beneficio de la salud tanto humana como medioambiental. Los métodos de análisis microbiológicos convencionales y quimiotaxonómicos o la genómica comparativa han permitido ya el reconocimiento de tipos interesantes y numéricamente importantes de halófilos y halotolerantes”, concluye Ilargi Martinez-Ballesteros.

Referencia:

Maia Azpiazu-Muniozguren, Ilargi Martinez-Ballesteros, Javier Gamboa, Sergio Seoane, Rodrigo Alonso, Lorena Laorden, Javier Garaizar, Joseba Bikandi Altererythrobacter muriae sp. nov., isolated from hypersaline Añana Salt Valley spring water, a continental thalassohaline-type solar saltern (2021) International Journal of Systematic and Evolutionary Microbiology doi: 10.1099/ijsem.0.004734

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Una nueva especie extremófila en el Valle Salado de Añana se ha escrito en Cuaderno de Cultura Científica.

Una extinción de novela policiaca

Reconstrucción de un sinápsido, grupo precursor de los mamíferos, de finales del Pérmico. Autor: U. Kikutani

Reconstrucción de un sinápsido, grupo precursor de los mamíferos, de finales del Pérmico. Autor: U. KikutaniHace unos 252 millones de años se produjo la mayor extinción masiva de los últimos 500 millones de años de historia de nuestro planeta, la extinción del límite Pérmico-Triásico. En poco menos de 1 millón de años, desaparecieron aproximadamente el 95% de las especies que había en la Tierra. Se vio el final de todas las especies de trilobites que habitaban los mares y océanos, se extinguieron muchas especies de los helechos y coníferas gigantes que formaban enormes bosques pantanosos y desaparecieron más del 70% de las especies de reptiles y sinápsidos, grupo precursor de los actuales mamíferos, que dominaban la tierra firme. Por eso a esta extinción se la suele denominar “La Gran Mortandad” y se toma como un punto de inflexión tan importante en la historia evolutiva del planeta, que da fin a la Era Paleozoica y comienzo a una nueva etapa, la Era Mesozoica. Poniéndonos poéticos, prácticamente la podríamos denominar como un apocalipsis biótico en el que el contador evolutivo casi se puso a 0. Por suerte, la vida siempre se abre camino y, si superó la extinción del Pérmico-Triásico, puede soportar casi cualquier cosa que se le ponga por delante.

Meseta de Putorana, incluida dentro de los Trap Siberianos, formada por la acumulación de rocas volcánicas. Foto: jxandreani / Wikimedia Commons

Meseta de Putorana, incluida dentro de los Trap Siberianos, formada por la acumulación de rocas volcánicas. Foto: jxandreani / Wikimedia CommonsSon varias las causas a las que se aluden para intentar explicar los motivos que provocaron esta extinción biótica. Por un lado, en la actual Siberia, se encuentran unos enormes depósitos volcánicos, denominados los Trap Siberianos, que se formaron por sucesivas erupciones acontecidas a finales del Pérmico. Estas gigantescas erupciones debieron liberar toneladas de gases de efecto invernadero a la atmósfera, que rápidamente cubrieron todo el globo y dieron lugar a un intenso calentamiento global que, literalmente, achicharró la Tierra. Por otro lado, en los mares y océanos se registró un descenso generalizado de los niveles de oxígeno disuelto en el agua, lo que produjo condiciones anaerobias en el fondo que dieron lugar a la expulsión de enormes cantidades de sulfuro de hidrógeno a la atmósfera, gas nocivo para la biota y que, además, es capaz de afectar a la capa de ozono. Y también se descongelaron los depósitos de hidratos de metano que se encontraban enterrados en el sedimento de los fondos oceánicos, liberando toneladas de este gas de efecto invernadero a la atmósfera. Por último, recientemente se especula con un posible impacto de un cuerpo extraterrestre a finales del Pérmico tras el descubrimiento de un cráter meteorítico en la Antártida, aunque aún se está investigando esta hipótesis ante la necesidad de realizar una datación temporal más precisa de este hallazgo.

Pero ahora es cuando todo se pone más interesante. Y aviso de que voy a hacer algunos spoilers. En 1934, la escritora británica Agatha Christie publicó una de sus obras más famosas, Asesinato en el Orient Express. En esta novela, el detective belga más admirado a nivel mundial, Hércules Poirot, se enfrenta al asesinato de un conocido hombre de negocios norteamericano sucedido durante uno de los viajes de este famoso tren y tiene que descubrir al asesino mientras esperan a que los rescaten tras acabar varados debido en un alud de nieve. Ahora es cuando debéis dejar de leer este artículo si no conocéis la novela, puesto que voy a destriparos el final. Y es que lo que descubre Poirot es que todos los pasajeros son los asesinos, ya que tenían una relación entre ellos y un motivo para acabar con la víctima, así que entre todos terminaron con su vida apuñalándole de uno en uno.

Y algo similar es lo que parece que sucedió a finales del Pérmico en nuestro planeta. Las causas que os he descrito previamente, cada una por sí sola, no serían capaces de acabar con cerca del 95% de las especies de nuestro planeta. Pero todas juntas y de manera combinada, sí. Las erupciones volcánicas provocarían un efecto invernadero generalizado en todo el planeta que daría lugar a un aumento de la temperatura del agua marina, que a su vez provocaría las condiciones anóxicas del fondo, con la generación de sulfuro de hidrógeno y la descongelación de los hidratos de metano. Estos dos gases, una vez liberados a la atmósfera, aumentarían el efecto invernadero, retroalimentando las condiciones de calentamiento global. Incluso la hipótesis del impacto extraterrestre tendría cabida en este juego, ya que sería factible que las ondas de choque provocadas por el mismo fueran las desencadenantes del vulcanismo siberiano. A esta hipótesis que une las posibles casusas de la extinción del Pérmico-Triásico como auto desencadenantes una de la otra, se la ha denominado “Efecto Asesinato en el Orient Express”, en honor a la gran novela de Agatha Christie.

Como podéis comprobar, en geología siempre nos encanta hacer homenajes a la cultura popular poniendo nombres de este tipo a las cosas que descubrimos. Y aunque esta hipótesis aún está en estudio, el nombre es más que apropiado, ya que por sí mismo explica lo que pudo suceder en nuestro planeta hace unos 252 Millones de años durante la mayor crisis biótica de nuestra historia.

Sobre la autora: Blanca María Martínez es doctora en geología, investigadora de la Sociedad de Ciencias Aranzadi y colaboradora externa del departamento de Geología de la Facultad de Ciencia y Tecnología de la UPV/EHU

El artículo Una extinción de novela policiaca se ha escrito en Cuaderno de Cultura Científica.

Vera Pless, de especialista en álgebra abstracta a experta en teoría de códigos

Vera Stepen nació en Chicago (Estados Unidos) el 5 de marzo de 1931. Sus padres eran judíos rusos que habían emigrado a Estados Unidos: su madre, Helen Blinder, era dentista, y su padre, Lyman Stepen, joyero. Deseaban que su única hija disfrutara de los beneficios en educación que se ofrecían en este país, y la incentivaron a estudiar.

Vera Pless. Fuente: Wikimedia Commons.

Vera Pless. Fuente: Wikimedia Commons.

Cuando Vera tenía unos 12 años, un amigo de la familia, estudiante de posgrado en la Universidad de Chicago, le enseñó cálculo. Observó que poseía un verdadero talento matemático, pero Vera no estaba demasiado interesada en las matemáticas en ese momento. Tocaba el violonchelo en la orquesta de su escuela, y soñaba con llegar a ser una instrumentista destacada. Pero su padre tenía otros planes para ella, y la obligó a abandonar la escuela secundaria dos años antes.

Vera ingresó en la Universidad de Chicago donde obtuvo una licenciatura en solo tres años. Seguía sin tener un interés especial por convertirse en matemática, a pesar de tener cerca varias personas que la inspiraron.

No tenía la ambición de convertirme en matemática; las chicas en ese momento aspiraban a ser esposas (de hombres exitosos) y madres. Tal vez algunas chicas «desafortunadas» no se casaron e hicieron una carrera; pero, en lo que respecta a las mujeres matemáticas, nunca vi una durante mi época de estudiante. Sin embargo, conocía el trabajo de Emmy Noether y tal vez influyó en mi elección de área, álgebra; aunque creo que la enseñanza de Irving Kaplansky fue lo que realmente me inspiró.

Vera Pless, AMS Notices

Efectivamente, Emmy Noether (1882-1935) e Irving Kaplansky (1917-2006) eran especialistas en álgebra abstracta, en teoría de anillos y, sin duda alguna, dos personas realmente inspiradoras. Así, Vera continuó sus estudios en la Universidad de Chicago preparando su maestría. En esa época conoció a su futuro esposo, un estudiante de física, en la universidad y se casaron en 1952, dos semanas antes de su examen de maestría. Vera Stepen pasó a llamarse Vera Pless.

Vera comenzó a trabajar con un grupo de física en la Universidad de Chicago mientras su esposo preparaba su doctorado en física experimental de altas energías. Poco después consiguió una beca para estudiar en la Universidad Northwestern y comenzó a trabajar en su tesis doctoral bajo la supervisión de Alex Rosenberg (1926-2007), un antiguo alumno de Kaplanski.

Cuando su marido terminó su doctorado, le ofrecieron un puesto en el Instituto de Tecnología de Massachusetts y Vera se mudó con él a Cambridge. Rosenberg se mostró dispuesto a que Pless terminara su tesis doctoral a distancia; Vera regresó en junio de 1957 a la Universidad Northwestern para defender su trabajo doctoral Quotient Rings of Continuous Transformation Rings. Dos semanas más tarde nació prematuramente su primera hija, y Vera se quedó en casa cuidando de la pequeña; era lo que se esperaba de ella.

En 1959 llegó su segundo hijo, un niño. Cuando el pequeño tuvo la edad suficiente para asistir a la guardería, en 1962, Pless comenzó a impartir cursos en la Universidad de Boston.

Todavía sentía que mi primera responsabilidad eran mis hijos pequeños. Incluso con mi docencia, encontré esta vida agobiante. Teníamos poco dinero, por lo que no podíamos contratar niñeras ni ayuda doméstica. Mi esposo era muy ambicioso, trabajaba muchas horas, y no sentía que debía ayudar de todos modos, algo que era común en esa época.

Vera Pless, AMS Notices

Cuando el menor de sus hijos tuvo la edad suficiente para comenzar la escuela primaria, Vera Pless comenzó a buscar puestos de tiempo completo. Pero no tuvo éxito: aunque tenía experiencia docente, había interrumpido su investigación. Era consciente de que la discriminaban; de hecho, en algunas instituciones le decían abiertamente que la universidad no era el lugar adecuado para una mujer.

En ese momento, en 1963, el Laboratorio de Investigación de Cambridge de la Fuerza Aérea Estadounidense buscaba matemáticos para trabajar en el área emergente de códigos correctores de errores. Aunque Vera desconocía a que se dedicaba este campo, su experiencia algebraica se consideró suficiente para incorporarse en el equipo. Trabajó allí hasta 1972, con un breve permiso maternal cuando nació su tercer hijo. Se convirtió en una de las principales expertas mundiales en teoría de códigos.

Publicó varios artículos sobre códigos correctores de errores, y otros que continuaban con la investigación que había realizado para su doctorado.

En 1973, la llamada enmienda Mansfield limitó las asignaciones para investigación en defensa solo a proyectos que tuvieran una aplicación militar directa. Vera Pless dejó su puesto para trabajar, durante tres años, como investigadora asociada en el Instituto de Tecnología de Massachusetts en el proyecto MAC sobre matemáticas y computación. En 1975 fue nombrada profesora titular en la Universidad de Illinois en Chicago. Su esposo y su hijo menor se quedaron a vivir en la zona de Boston; el matrimonio se divorció en 1980.

Portada de Introduction to the theory of error-correcting codes.

Portada de Introduction to the theory of error-correcting codes.

En 1982 publicó un libro sobre la teoría de la codificación, Introduction to the theory of error-correcting codes, diseñado como un curso de un semestre para estudiantes universitarios. Trataba sobre teoría de codificación algebraica, y fue especialmente apreciado por incluir demostraciones claras y sencillas. Sus publicaciones de investigación suman más de un centenar.

Se jubiló en 2006 y falleció el 2 de marzo de 2020 a la edad de 88 años.

Mirando atrás, creo que tuve mucha suerte. Trabajé en codificación desde sus inicios, y se ha convertido en un tema matemático fascinante. He apreciado la oportunidad de trabajar con muchos matemáticos maravillosos, en particular Richard Brualdi, John Conway y Neil Sloane. Era capaz de cuidar a mis hijos en sus años más jóvenes en un entorno de baja presión. […] Nuestra disciplina no es la única que exige mucho. Mi hija, médica residente con una hija pequeña, tiene mucho que decir sobre las largas horas demandadas a los residentes. Lamentablemente, nuestra sociedad está perdiendo probablemente valiosas contribuciones de las mujeres por estas razones. Y muchas mujeres están pagando un gran precio emocional, ya sea renunciando a carreras o no dedicando tanto tiempo a sus familias como creen que deberían.

Vera Pless, AMS Notices

Referencias

- Su página web, Universidad de Illinois en Chicago

- Vera Pless (1991). In Her Own Words, AMS Notices 38 (7) 705-706

- O’Connor, John J.; Robertson, Edmund F., Vera Pless, MacTutor History of Mathematics archive, University of St Andrews

- Vera Pless, Biographies of Women Mathematicians, Agnes Scott College

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad

El artículo Vera Pless, de especialista en álgebra abstracta a experta en teoría de códigos se ha escrito en Cuaderno de Cultura Científica.

Sócrates y el efecto Dunning-Kruger en redes sociales

Foto: Bermix Studio / Unsplash

Foto: Bermix Studio / Unsplash“Solo sé que no sé nada”. ¿Cuántas veces habremos oído esta frase atribuida a Sócrates como justificación de la ignorancia? Sin embargo, esta sentencia no aparece en ninguno de los escritos en los que se cita al que era más sabio que ningún otro humano, parafraseando a la Pitia. De hecho, la comprobación de lo que en realidad quería decir nos desvelará que Sócrates estaba en realidad probablemente sujeto a un prejuicio cognitivo, el efecto Dunning-Kruger.

El dicho se suele atribuir al Sócrates de Platón. Sócrates no dejó nada escrito, de ahí que lo que conocemos de él es lo que escribieron sus contemporáneos, especialmente Platón. En ninguna de las referencias de Platón a Sócrates aparece la expresión “Solo sé que no sé nada”.

Sin embargo, en la Apología, la versión idealizada de la defensa que hizo Platón de Sócrates en el juicio a este, encontramos: “Este hombre, por una parte, cree que sabe algo a pesar de no saber nada. Por otra, yo, igualmente ignorante, no creo saber algo”. Esta es la frase a partir de la cual se produce el salto, lógicamente falaz, del “no creo saber algo” al “no sé nada”. El autor no dice que no sepa algo sino que no puede, que nadie puede, saber con absoluta certeza, pero que puede tener confianza acerca del conocimiento de ciertas cosas (por ejemplo, de que el otro no sabe nada). Como es obvio, esta conclusión no la extraemos de esta frase aislada sino sobre el análisis del conjunto de la obra sobre Sócrates que han realizado varios autores.

Vemos pues que la ignorancia o, mejor, su admisión, no es una resultante sino un punto de partida para el conocimiento. Es la base del método socrático que se ilustra mejor en los primeros diálogos de Platón. El método consiste en simular ignorancia, la llamada ironía socrática, o admitirla como base sobre la que construir el conocimiento y establecer un diálogo con un supuesto experto, cuya confiada afirmación de conocer terminará siendo destruida. A partir de aquí ya se pueden desarrollar ideas más adecuadas.

Así, en Menón, un diálogo de Platón, aparece Sócrates diciendo: “Por eso ahora no sé lo que es la virtud; quizás tu lo supieses antes de que me contactases, pero ahora eres ciertamente como uno que no sabe”. En este punto el objetivo de Sócrates está claro, cambiar la posición de Menón, que era un firme creyente en su propia opinión y cuya afirmación de conocimiento Sócrates acaba de probar que es infundada.

Estamos ante el origen de la filosofía occidental que terminará resultando en lo que hoy conocemos como ciencia: Sócrates comienza toda sabiduría con el autocuestionamiento, con la propia admisión de ignorancia.

Pero veamos la misma cuestión desde un punto de vista diferente. En los diálogos socráticos de Platón el sabio es el que duda, el que se cuestiona, mientras que el verdadero ignorante es el que tiene muy clara cuál es la verdad, a la que ha llegado en muchos casos por sí mismo sin preocuparse demasiado de donde surge el conocimiento. Por otra parte, estos “sabios” no siempre reconocen su error, están pagados de sí mismos y se creen superiores a los demás. Estamos ante una ilustración del efecto Dunning-Kruger.

El efecto Dunning-Kruger se puede expresar de la siguiente manera: los peores trabajadores/estudiantes/participantes son los que menos conscientes son de su propia incompetencia. Toma su nombre de un estudio de 2003 que realizaron Dunning, Kruger y otros con estudiantes universitarios con respecto a los resultados de sus exámenes. Después los resultados han sido reproducidos en varias ocasiones, por ejemplo con estudiantes de medicina a la hora de evaluar su capacidad para hacer entrevistas de diagnóstico, con administrativos evaluando su rendimiento o con técnicos de laboratorios médicos calibrando su nivel de dominio del trabajo.

La razón de fondo parece estar en que los que peor lo hacen son incapaces de aprender de sus errores.

Una solución aparentemente simple es decirle directamente al incompetente que lo es y por qué. Pero no funcionará. Desafortunadamente, el incompetente habrá estado recibiendo ese tipo de respuesta durante años y no habrá sido capaz de enterarse. A pesar de los exámenes suspensos, los trabajos mal hechos, las risas, burlas y sesudas contraargumentaciones a sus comentarios en redes sociales y la irritación que provocan sistemáticamente en los demás, el incompetente sigue sin creerse que lo sea.

Como Sócrates, las personas con verdadero talento tienden a subestimar lo buenos que son. Es la parte simétrica de este prejuicio: las personas inteligentes tienden a asumir que para los demás las cosas son tan fáciles y evidentes como para ellos, cuando lo que están haciendo es proyectar su propia luz y creer que ven un reflejo de la misma en los demás.

Estas ideas se conocen desde mucho antes que Dunning-Kruger y los demás investigadores las cuantificasen. Se pueden encontrar muchas citas al respecto, como esta de Bertrand Russell en la que se refiere a su tiempo, pero que como sabemos que es otro prejuicio cognitivo, podemos extrapolar a cualquiera:

“Una de las cosas dolorosas de nuestra época es que aquellos que se sienten ciertos son estúpidos, y aquellos con algo de imaginación y comprensión están llenos de dudas e indecisión”.

En el mundo de Internet lo anterior tiene una consecuencia práctica inmediata: No alimentes al comentarista manifiestamente incompetente, es solo una versión de trol que busca llamar la atención. Su problema es que no sabe, ni puede llegar a saber, que lo es.

Para saber más:

Lo que los sabelotodos no saben, o la ilusión de competencia

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

Una versión anterior de este artículo se publicó en Experientia Docet el 13 de junio de 2012.

El artículo Sócrates y el efecto Dunning-Kruger en redes sociales se ha escrito en Cuaderno de Cultura Científica.

Pezuñas calientes, cabeza fría

Ilustración: María Lezana

Ilustración: María LezanaLa gacela de Thomson (Eudorcas thomsonii) es un antílope de pequeño tamaño (pesa entre 20 y 30 kg) que habita en los pastizales de las sabanas de Tanzania y Kenia, donde es una de las presas preferidas de leones, guepardos, leopardos y cocodrilos.

Puede alcanzar velocidades de hasta 80 km/h, normalmente cuando huye de alguno de sus depredadores habituales, aunque difícilmente supera los 40 km/h en carrera sostenida durante varios minutos.

Tras huir de un depredador -quizás del más rápido de ellos, el guepardo-, durante un tiempo de unos 5 min, y suponiendo que no haya sido atrapada, ha generado una gran cantidad de calor debido al esfuerzo realizado. Ese calor no se disipa inmediatamente, de manera que provoca un aumento de la temperatura corporal bien por encima de la habitual. La sangre arterial puede elevarse de los 38 °C o 39 °C normales hasta los 44 °C. La gacela de Thomson, a pesar de ser un animal homeotermo, pierde así de manera transitoria la capacidad para mantener constante su temperatura corporal como consecuencia del esfuerzo.

Al huir despavorida a toda velocidad, el gasto metabólico de la gacela se multiplica por cuarenta. Además del efecto del esfuerzo, la temperatura ambiental es alta, muy alta, tanto quizás como la corporal. Así pues, a la gacela le resulta muy difícil disipar el calor que produce, por lo que la temperatura sanguínea sube rápidamente. Además, es posible que esa temperatura corporal tan alta sirva a la gacela para que sus músculos se contraigan más rápidamente y pueda así huir con mayor facilidad del depredador.

La elevación de la temperatura corporal no se debe a que fallen los sistemas de disipación de calor. De hecho, la gacela jadea a muy alta frecuencia, tanto para tomar más oxígeno como para refrigerar la sangre facilitando la evaporación del líquido que cubre las superficies respiratorias. El problema es que bajo las condiciones en que se encuentra no es posible mantener la temperatura en los valores normales, incluso aunque los sistemas de termorregulación mantengan plena integridad funcional. La carga de calor es demasiado alta y la gacela no puede disipar todo el que genera.

Pero ocurre que la elevación de la temperatura no se produce por igual en todo el organismo, ya que gracias precisamente al jadeo, la gacela de Thomson puede mantener su encéfalo más fresco que el resto de órganos. De hecho, mientras el cuerpo alcanza los 44 °C, el encéfalo no pasa de 41 °C, temperatura por encima de la cual las neuronas sufrirían graves daños.

El mecanismo de refrigeración se basa en una rete mirabile (red maravillosa). En su camino hacia el encéfalo, la sangre que circula por la arteria carótida se distribuye entre centenares de arteriolas o capilares, para volver a agruparse justo antes de alcanzarlo. Esas arteriolas constituyen una rete mirabile, un dispositivo especialmente apto para intercambiar calor. El intercambio se produce porque los vasos arteriales atraviesan un seno que se encuentra lleno de sangre venosa, que procede, precisamente, de la zona nasal de la gacela, donde ha tenido lugar la evaporación del líquido superficial y, como consecuencia, el enfriamiento de la que circula por allí. De esa forma se enfría la sangre que circula por las arteriolas, cediendo calor a la venosa que procede de la nariz. Al atravesar el seno, la sangre arterial reduce su temperatura en unos 2 o 3 °C.

En la anotación anterior de la sección Animalia, sobre la irrigación de la musculatura de algunos peces (atunes y lenguados), vimos cómo funcionaba una rete mirabile como esta, con la diferencia de que aquella red servía para calentar la sangre que irrigaba los músculos que impulsan al atún y ésta para enfriar la sangre que irriga el encéfalo. En ambos casos se producen intercambios de calor mediante un dispositivo en contracorriente, aunque con objetivos opuestos.

En inglés denominan “selective brain cooling” al mecanismo, basado en el jadeo, de que hace uso la gacela de Thomson. Aunque no es el único animal que lo utiliza, pues bastantes ungulados domésticos también recurren a él cuando lo necesitan. De todos ellos cabría decir aquello de que mantienen la cabeza fría y, en este caso, las pezuñas calientes.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Pezuñas calientes, cabeza fría se ha escrito en Cuaderno de Cultura Científica.

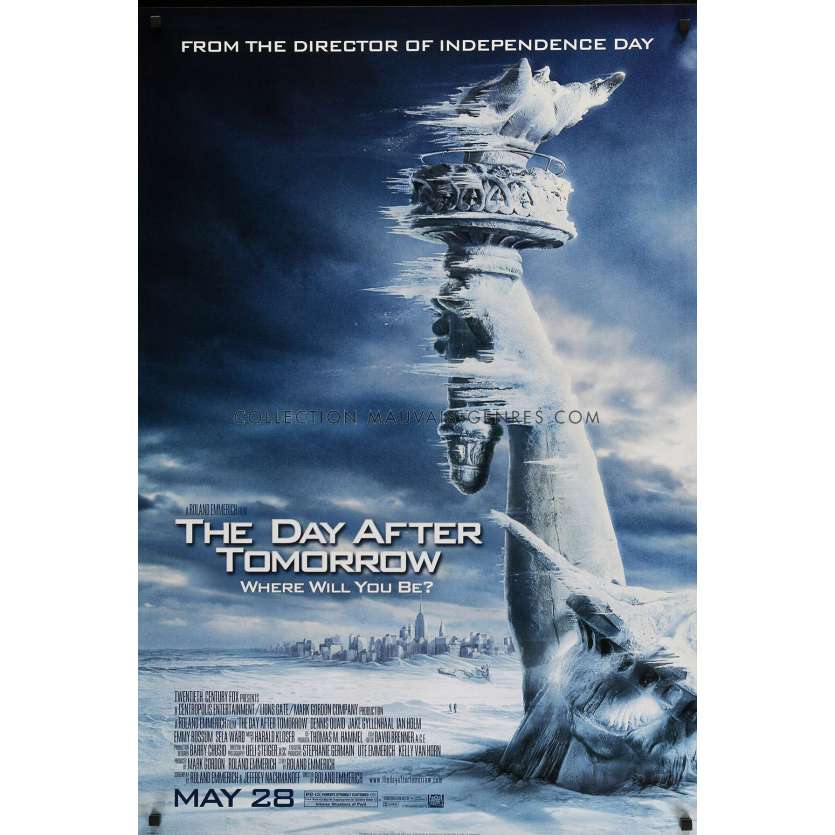

ZientZinema 2: El día de mañana

Dirección: Roland Emmerich. USA. 2004. 124 min. Intérpretes: Dennis Quaid (Profesor Jack Hall), Jake Gyllenhaal (Sam Hall), Ian Holm (Terry Rapson), Emmy Rossum (Laura), Sela Ward (Dra. Lucy Hall), Dash Mihok (Jason Evans), Jay O. Sanders (Frank Harris), Austin Nichols (J.D.), Arjay Smith (Brian Parks), Tamlyn Tomita (Janet Tokada). Guion: Roland Emmerich y Jeffrey Nachmanoff; basado en un argumento de Roland Emmerich. Producción: Mark Gordon y Roland Emmerich. Música: Harald Kloser. Fotografía: Ueli Steiger. Montaje: David Brenner. Diseño de producción: Barry Chusid. Dirección artística: Martin Gendron, Michele Laliberte, Claude Paré, Réal Proulx, Tom Reta y Gerald Sullivan.

¿Y si estuviéramos al borde de una nueva era glacial? Éste es el asunto que obsesiona al climatólogo Jack Hall (Dennis Quaid). Las investigaciones llevadas a cabo por Hall indican que el calentamiento global del planeta podría desencadenar un repentino y catastrófico cambio climático de la Tierra. Las perforaciones realizadas en la Antártida muestran que es algo que ya ha ocurrido con anterioridad, hace diez mil años. Y ahora está alertando a los dirigentes de que podría ocurrir de nuevo si no se adoptan medidas de forma inmediata. Pero sus advertencias llegan demasiado tarde. Todo empieza cuando Hall presencia cómo un bloque de hielo del tamaño de Rhode Island se desgaja completamente de la masa de hielo de la Antártida. Posteriormente, una serie de fenómenos climatológicos cada vez más drásticos empiezan a ocurrir en distintas partes del globo: granizos del tamaño de una ciruela destrozan Tokio, vientos huracanados que rompen todos los récords machacan Hawai; la nieve cae en Nueva Delhi; una serie de devastadores tornados azotan la ciudad de Los Ángeles. Una llamada de teléfono de un colega suyo de Escocia, el profesor Terry Rapson, confirma los peores temores de Jack: estos intensos fenómenos meteorológicos son síntomas de un cambio climatológico masivo y, además, se ha detectado una bajada súbita de la temperatura en las aguas del Atlántico Norte. El derretimiento de la capa de hielo polar ha vertido recientemente demasiada agua dulce a los océanos y ha afectado a las corrientes que dan estabilidad a nuestro sistema climático. La disminución de la salinidad en el mar provoca que la corriente se detenga, la temperatura global cae y lleva al planeta a una nueva edad glacial. El cambio climático ha puesto el planeta al borde del precipicio y, en la película, todo ocurrirá durante una supertormenta de extensión planetaria.

La premisa central del guion se basa en una hipótesis científica legítima pero adornada con episodios de obvias inexactitudes científicas: tornados que destruyen Los Angeles; inundación de Nueva York con olas gigantes; y, sobre todo, el enfriamiento del planeta se completa en una semana.

La película de Emmerich combina con acierto melodrama y cine de catástrofes en un intento de comprometer a los espectadores cognitiva y emocionalmente con una historia espectacular sobre un abrupto cambio climático, escribía en 2012 Alexa Weik von Mossner, de la Universidad de Klagenfurt, en Austria.

La recaudación que obtuvo el film después de su estreno muestra que tuvo gran aceptación, no solo de críticos y periodistas, sino también de climatólogos, sociólogos, ecologistas y miembros del gobierno y la administración. Fue una película alabada, criticada e, incluso, despreciada. Pero, además, fue la primera película popular que promocionó el interés público por el cambio climático. Para la autora, el interés de la película está en que apela al pensamiento racional y, también, a las emociones cuando relata el rápido y catastrófico cambio climático.

El guion se basa en propuestas de la década de los noventa sobre la emisión de dióxido de carbono, su disolución en el agua del mar y su influencia sobre las corrientes marinas tal como aparece en el artículo de 1997 de Thomas Stocker y Andreas Schmitter en Nature. El estudio de los cambios en las corrientes se inició con la del Golfo y se amplió a todos los movimientos de agua en los océanos. Anuncian cambios en 100 años si la emisiones de dióxido de carbono aumentan con rapidez y provocarían la detención permanente de las corrientes. Si la emisión de dióxido de carbono disminuye, las corrientes no se detendrán pero serán más lentas.

La conocida Corriente del Golfo es parte de un sistema de corrientes del Atlántico que, en conjunto, se conocen como AMOC (en inglés, Atlantic Meridional Overturning Circulation, o Circulación Meridional de Retorno del Atlántico). Está compuesta por corrientes superficiales y profundas, como explica Montserrat Alonso, de la Universidad de Salamanca, en El País.

Las aguas superficiales del hemisferio sur pasan por el trópico donde se calientan, llegan al Caribe, se dirigen al norte por la costa este de Norteamérica, cruzan el Atlántico por el sur de Groenlandia y llegan a Europa frente a Noruega. Parte de este sistema es la Corriente del Golfo que sale del Caribe, se mueve hacia el norte paralela a la costa de Norteamérica y se convierte en la corriente Noratlántica.

Todo este sistema de movimientos de agua llega al Atlántico subpolar, se enfría, y como las aguas son muy salinas y con menos temperatura, se hunden y retornan hacia el sur como corrientes profundas. Por eso se le llama circulación de retorno: las aguas del sur, calientes, llegan a la zona polar, se enfrían y vuelven al sur.

Además de agua, AMOC mueve energía en forma de cambios de temperatura del agua. Según estudios recientes, todo el sistema se ha ralentizado en un 15% desde la mitad del siglo pasado. Sin embargo, en 2006 faltaban evidencias de que la circulación fuese más lenta, como escribía Richard Kerr en Science. En una reunión de expertos se constató que más del 95% de los asistentes consideraba que no había cambios significativos en las corrientes atlánticas. Añadían que no había pruebas de un riesgo inmediato y piden más datos, durante quizá décadas, para demostrar la circulación lenta por el cambio climático.

En aquellos años hay más expertos que consideran que una nueva edad glaciar en Europa no es un escenario probable a corto o medio plazo. Carl Wunsch, del MIT, plantea que la corriente del Golfo se produce por el sistema de vientos a gran escala del Atlántico y por el movimiento de rotación del planeta. Por tanto concluye que o se detiene el sistema de vientos o la rotación de la Tierra, o ambos a la vez, para llegar a una nueva edad glaciar dentro de millones de años.

La táctica del director se basa en los efectos especiales de un guion que relata la historia de un científico cuyos avisos de lo que puede ocurrir son ignorados. La ciencia avisa, es una profecía, y cuando se cumple es la visión del desastre lo que vemos en la pantalla. Algunos modelos predicen que si Groenlandia se deshiela, la corriente podría detenerse lo que haría caer la temperatura en el sur de Europa. En la película, en enfriamiento ocurre en cuestión de horas. Es poco probable pero puede comenzar una época más fría, una nueva edad de hielo.

El mismo año del estreno comenzó el debate la película. Bogi Hansen y su grupo, del Laboratorio de Pesquerías de las Islas Feroe, escriben, en 2004, que el debilitamiento de la AMOC durante este siglo puede tener efectos sobre el clima, quizá con el enfriamiento del norte de Europa como aparece en la película. El grupo de Hansen tiene datos de temperaturas más bajas en el mar, con la salinidad en aumento desde mediados de los 70 y menos flujo de agua, hasta un 20% desde 1950. Sin embargo, como muchos otros expertos concluyen que faltan datos a más largo plazo.

Para 2018 comienza a aceptarse, con datos y modelos, que AMOC se ha debilitado. Levke Caesar y su grupo, del Instituto Postdam de Investigación sobre el Impacto del Clima, en Alemania, plantean que la reducción es del 15% desde mediados del siglo XX. Añaden, para el futuro, que si continua el calentamiento global, seguirá debilitándose la AMOC, con cambios en los flujos de agua, pérdidas en la cubierta de hielo de Groenlandia y caída de las temperaturas en el Atlántico Norte.

La propuesta del grupo de Caesar se confirma con los datos de David Thornalley y su equipo, del Colegio Universitario de Londres, con participación de Pablo Ortega del Centro de Biocomputación de Barcelona. Es un estudio sobre el Mar del Labrador, entre Groenlandia y Norteamérica y, para los autores, las evidencias apuntan a los últimos 150 años, desde 1850, al final de la Pequeña Edad del Hielo, con una reducción de la corriente en 15%-20%. Sugieren más datos para delimitar el papel de la variabilidad natural del clima y de la actividad humana con el resultado actual del debilitamiento de la AMOC. Aunque también encuentran que los cambios en la AMOC no coinciden siempre con las variaciones en la temperatura. Parece que la AMOC responde a los cambios en el clima pero que no los dirige.

De nuevo Levke Caesar y su grupo, ahora desde la Universidad de Maynooth, en Irlanda, confirmaron que AMOC había perdido fuerza según la revisión de 11 series de datos desde el año 400 a la actualidad. Al principio, AMOC permanecía estable hasta comienzos del siglo XIX. Después, se acelera el proceso desde mediados del siglo XX hasta la actualidad.

Para resumir, en 2021, Niklas Boers, después de analizar ocho índices de la AMOC sobre la temperatura en la superficie del mar y la salinidad en el Atlántico, concluye que hay evidencias empíricas consistentes de que, en el pasado siglo, AMOC ha pasado de condiciones estables a un punto crítico de transición a una circulación más lenta que puede provocar un impacto severo en el sistema climático del planeta.

Una revisión final, publicada en 2021, sobre los indicadores del cambio climático en los océanos la firma Carlos García-Soto, del Instituto Español de Oceanografía en Santander, con otros once expertos y, entre ellos, Ainhoa Caballero, de AZTI en Pasaia.Según esta:

– La temperatura del agua en la superficie del mar ha crecido, de media, 0.062ºC al año en los últimos 120 años. En la última década, de 2010 a 2019, el aumento se ha acelerado a los 0.280ºC al año.

– El contenido de calor del océano en los 2000 metros superiores, de media y a nivel mundial, ha sido de 0.35 watios por metro cuadrado en los últimos 65 años. Durante la última década, de 2010 a 2019, la tasa es el doble con 0.70.

– El pH global de la superficie del océano ha disminuido, de media, 0.1 unidades desde 1770 con la revolución industrial. El nivel medio global del mar ha aumentado de 1993 a 2019 una tasa de 3.17 milímetros por año. Entre 1900 y 2015, en 115 años, ha aumentado en 19 centímetros.

– Los niveles de oxígeno disuelto han bajado el 2% en los últimos 50 años. La extensión de hielo marino en el Ártico ha disminuido un 13.1% por década en verano y un 2.6% por década en invierno.

– Y la AMOC está en su punto más débil de varios cientos de años y se ha ralentizado más en el último siglo.

Después del estreno en Gran Bretaña, el grupo de Thomas Lowe, de la Universidad de East Anglia en Norwich, organizó un estudio para conocer si los espectadores, después de la película, diferenciaban en ella la ciencia y la ficción. Los autores preguntan a los espectadores sobre su concepto del calentamiento global antes y después del film, así como su percepción sobre si la ciencia que aparece se basa en hechos. Entrevistan a 301 espectadores, de 12 a 60 años o más, y son mujeres el 55%.

La audiencia no consigue determinar la precisión de la ciencia que aparece en la película. Según los autores, los espectaculares efectos especiales y su gran calidad hacen difícil distinguir dónde termina la ciencia y comienza la ficción. Para el 30%, los efectos especiales les ayudan a entender los hechos y, por ello, aumentó su compromiso con lo que significa el cambio climático. Casi el 44% está dispuesto a hacer algo para reducir el cambio climático.

Otro estudio sobre el efecto de la película en el público y su percepción del cambio climático lo firma Anthony Leiserowitz, de la Universidad de Yale, e incluye entrevistas a 529 espectadores. Encuentra cambios en su percepción del riesgo, los modelos conceptuales del cambio climático, las intenciones de su conducta, las prioridades políticas e, incluso, en su intención de voto en futuras elecciones. En conclusión, la representación en una película popular de riesgos ambientales puede influir en la actitud y la conducta de los ciudadanos.

Uno de los cambios en que está implicada la temperatura del agua y la AMOC es la distribución de las especies pesqueras. Ocurre, por ejemplo, con las migraciones de anguilas y angulas desde Europa y Norteamérica al Mar de los Sargazos para la reproducción. La deriva hacia el norte de la isoterma de 22.5ºC, que marca el límite norte de la reproducción de las anguilas, más la disminución del viento y la mezcla de temperaturas en profundidad afectan a la distribución de las larvas. Según Kevin Friedland y sus colegas, del Servicio Nacional de Pesquerías Marinas de Estados Unidos, la relación entre estos datos y los cambios en la AMOC sugiere que la caída en el número de angulas y anguilas que llegan a nuestros ríos en Europa y, quizá, en Norteamérica, está causada, por lo menos en parte, por el cambio climático.

En conclusión, esta película busca provocar en los espectadores una reacción ante el desastre global que puede suponer el cambio climático y, en parte, lo consigue.

Referencias:

Alonso García, M. 2021. ¿Han cambiado la temperatura y la dirección de la corriente del Golfo? El País 3 marzo.

Boers, N. 2021. Observation-based early-warning signals for a collapse of the Atlantic Meridional Overturning Circulation. Nature Climate Change 11: 680-688.

Caesar, L. et al. 2018. Observed fingerprint of a weakening Atlantic Ocean Overturning Circulation. Nature 556: 191-198.

Caesar, L. et al. 2021. Current Atlantic Meridional Overturning Circulation weakest in last millenium. Nature Geoscience 14: 118-120.

Criado, M.A. 2018. El sistema circulatorio del planeta se debilita. El País 12 abril.

Cubitt, S. 2005. Eco Media. Rodopi. Amsterdam-New York. 168 pp.

Friedland, K.D. et al. 2007. Oceanic changes in the Sargasso Sea and declines in recruitment of the European eel. ICES Journal of Marine Science 64: 519-530.

García-Soto, C. et al. 2021. An overview of ocean climate change indicators: sea surface temperature, ocean heat content, ocean pH, dissolved oxygen concentration, Arctic Sea ice extent, thickness and volume, sea level and strength of the AMOC (Atlantic Meridional Overturning Circulation). Frontiers in Marine Science doi: 10.3389/fmars.2021.642372.

Hansen, B. et al. 2004. Already the Day After Tomorrow? Science 305: 953-954.

Kerr, R.A. 2006. Fake alarm: Atlantic conveyor belt hasn’t slowed down after all. Science 314: 1064.

Kirby, D.A. 2011. Lab coats in Hollywood. Science, scientists, and cinema. MIT Press. Cambridge & London. 265 pp.

Leiserowitz, A.A. 2004. Before and after The Day After Tomorrow: a U.S. study of climate risk perception. Environment 46: 23-37.

Lomborg, B. 2008. En frío. La guía del ecologista escéptico para el cambio climático. Ed. Espasa-Calpe. Pozuelo de Alarcón. 284 pp.

Lowe, T. et al. 2006. Does tomorrow ever come? Disaster narrative and public perceptions of climate change. Public Understanding of Science 15: 435-457.

Mulet, J.M. 2021. Ecologismo real. Ed. Destino. Barcelona. 3,83 pp.

Stocker, T.F. & A. Schmittner. 1997. Influence of CO2 emission rates on the stability of the thermohaline circulation. Nature 388: 862-865.

Thornalley, D.J.R. et al. 2018. Anomalously weak Labrador Sea convection and Atlantic overturning during the past 150 years. Nature 556: 227-232.

Weik von Mossner, A. 2012. Facing The Day After Tomorrow: Filmed disaster, emotional engagement, and climate risk perception. En “American environments: Climate-Cultures-Catastrophe”, p. 97-115. Ed. por C. Mauch & S. Mayer. Universitätverlag Winter. Heidelberg.

Wunsch, C. 2004. Gulf Stream safe if wind blows and Earth turns. Nature 428: 601.

Sobre el autor: Eduardo Angulo es doctor en biología, profesor de biología celular de la UPV/EHU retirado y divulgador científico. Ha publicado varios libros y es autor de La biología estupenda.

El artículo ZientZinema 2: El día de mañana se ha escrito en Cuaderno de Cultura Científica.

Naukas Bilbao 2021: Amanda Sierra – Elogio de la incertidumbre

El gran evento de divulgación Naukas regresó a Bilbao para celebrar su décima edición en el magnífico Palacio Euskalduna durante los pasados 23, 24, 25 y 26 de septiembre.

Amanda Sierra es neurocientífica y lidera el laboratorio de biología de las células glía del Achucarro Basque Center for Neuroscience. Pero en esta charla no habla de neurociencia, sino que aporta tres mensajes muy sencillos para ayudarnos a diferenciar entre ciencia y pseudociencia, entre datos contrastados y bulos.

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Naukas Bilbao 2021: Amanda Sierra – Elogio de la incertidumbre se ha escrito en Cuaderno de Cultura Científica.

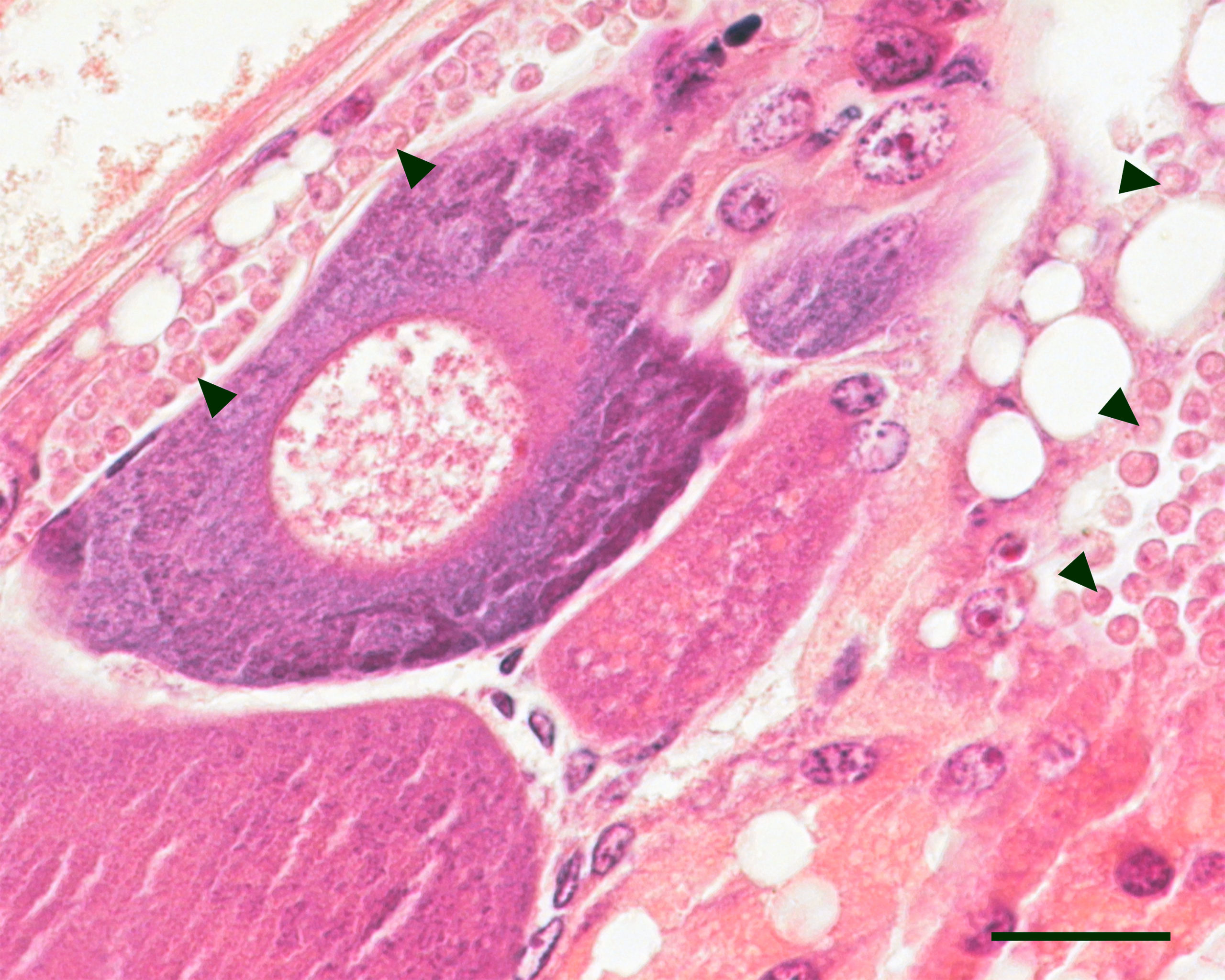

Un parásito que contribuirá a explicar el origen de la multicelularidad animal

Bautizado como Txikispora philomaios, pertenece a un linaje cercano al punto evolutivo en el que organismos unicelulares se diferenciaron para formar animales y hongos.

Imagen microscópica de Txikispora philomaios parasitando hemocitos, tejidos conectivos y gónadas femeninas de un anfípodo. Imagen: Ander Urrutia / UPV/EHU

Imagen microscópica de Txikispora philomaios parasitando hemocitos, tejidos conectivos y gónadas femeninas de un anfípodo. Imagen: Ander Urrutia / UPV/EHUEl investigador Ander Urrutia del grupo de investigación Biología Celular en Toxicología Ambiental de la UPV/EHU y de Patología Animal en CEFAS/OIE, (Centre for Environment, Fisheries, and Aquaculture Science, Reino Unido) se dedica a estudiar la gran diversidad aun desconocida de organismos parasíticos unicelulares que existe en la zona intermareal en los ecosistemas costeros de climas templados. Una herramienta muy útil para ello es el ADN ambiental: se trata de una técnica que consiste en “extraer el ADN contenido bien en una matriz orgánica o ambiental, como, por ejemplo, en un organismo o en muestras de agua marina previamente filtradas”. Urrutia la usa para ver qué organismos parasitan a los invertebrados: “Existen muchísimos parásitos sin identificar; encontramos nuevas secuencias de ADN e inferimos su comportamiento en base a su similitud genética con otros parásitos, pero realmente no sabemos lo que son”, comenta el investigador.

En la tarea de clasificar los parásitos unicelulares encontrados en las muestras, Urrutia encontró un parásito a priori poco común, que en base a sus características no casaba en ningún grupo existente hasta el momento. “Tuvimos que hacer unos análisis moleculares, que nos confirmaron que era un organismo distinto. Una vez realizados varios árboles filogenéticos, es decir, una vez comparado el ADN de este organismo con sus posibles parientes más cercanos, pudimos ver que se trata de un organismo perteneciente a un linaje primitivo, que se sitúa cerca del punto en el que se diferenciaron los animales y los hongos. Está cerca del momento evolutivo en el que un organismo unicelular se diferenció para dar a todos los animales que existen, poco después de que otro organismo celular parecido se diferenciara para terminar evolucionando en todos los hongos que existen”, explica Urrutia.

El parásito, bautizado como Txikispora philomaios, es un protista (organismo eucariota unicelular) que evolucionó poco después de la división del ancestro común de animales y hongos antes de desarrollar su multicelularidad. “Todos los animales y los hongos del mundo vienen de un mismo organismo celular que presumiblemente estaba en el océano hace cientos de millones de años. En algún momento este comenzó a agregarse y duplicarse, mientras sus células se especializaban formando tejidos, y eventualmente un cuerpo, desde una microscópica medusa hasta una enorme ballena azul”, explica el investigador.

Puesto que a menudo la reordenación genética sufrida por los parásitos difiere de sus parientes de vida libre, el estudio de este parásito y su genoma contribuirá a entender cómo se desarrolló la multicelularidad animal; “es decir, en qué momento y cómo las células empezaron a comunicarse, juntarse, o especializarse entre ellas, formando organismos cada vez más complejos. El desarrollo de la multicelularidad animal es muy importante desde el punto de vista de biología básica”, añade Urrutia, que ha realizado la investigación a caballo entre CEFAS en el Reino Unido, la Estación Marina de Plentzia (PIE) y el Instituto de Biología Evolutiva (IBE/CSIC).

Según explica Urrutia, “Txikispora no solo es una especie nueva, sino que da nombre a un género nuevo, una familia nueva, y un orden nuevo. Es decir, ahora tenemos a la nueva familia Txikisporidae, una familia con bastantes secuencias crípticas, es decir, trozos de ADN desconocidos que se parecen mucho a Txikispora, que también podrían pertenecer a parásitos, pero que ni sabemos dónde están ni qué animales podrían parasitar. Muchas de ellas están en ecosistemas acuáticos de Europa, pero no sabemos nada más acerca de ellos. Esa es otra línea de investigación que me gustaría seguir”.

Los investigadores de la UPV/EHU han sido los encargados de poner nombre a dicho parásito. El nombre de Txikispora es debido a que se trata de una pequeña (txiki) espora, y philomaios es debido a que el parásito solo aparecía unos pocos días durante mayo: ‘amante de mayo’. A la dificultad de ubicarlo filogenéticamente en su correspondiente grupo se ha sumado la dificultad de encontrarlo en aguas marinas: “Estuvimos dando palos de ciego hasta darnos cuenta de que solo se encuentra en la comunidad de anfípodos unos pocos días durante este mes; es como si el resto del año el parásito desapareciera”, explica Urrutia.

Referencia:

Ander Urrutia, Konstantina Mitsi, Rachel Foster, Stuart Ross, Martin Carr, Georgia M. Ward, Ronny van Aerle, Ionan Marigomez, Michelle M. Leger, Iñaki Ruiz-Trillo, Stephen W. Feist, David Bass (2021) Txikispora philomaios n. sp., n. g., a micro-eukaryotic pathogen of amphipods, reveals parasitism and hidden diversity in Class Filasterea Journal of Eukaryotic Microbiology doi: 10.1111/jeu.12875

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Un parásito que contribuirá a explicar el origen de la multicelularidad animal se ha escrito en Cuaderno de Cultura Científica.

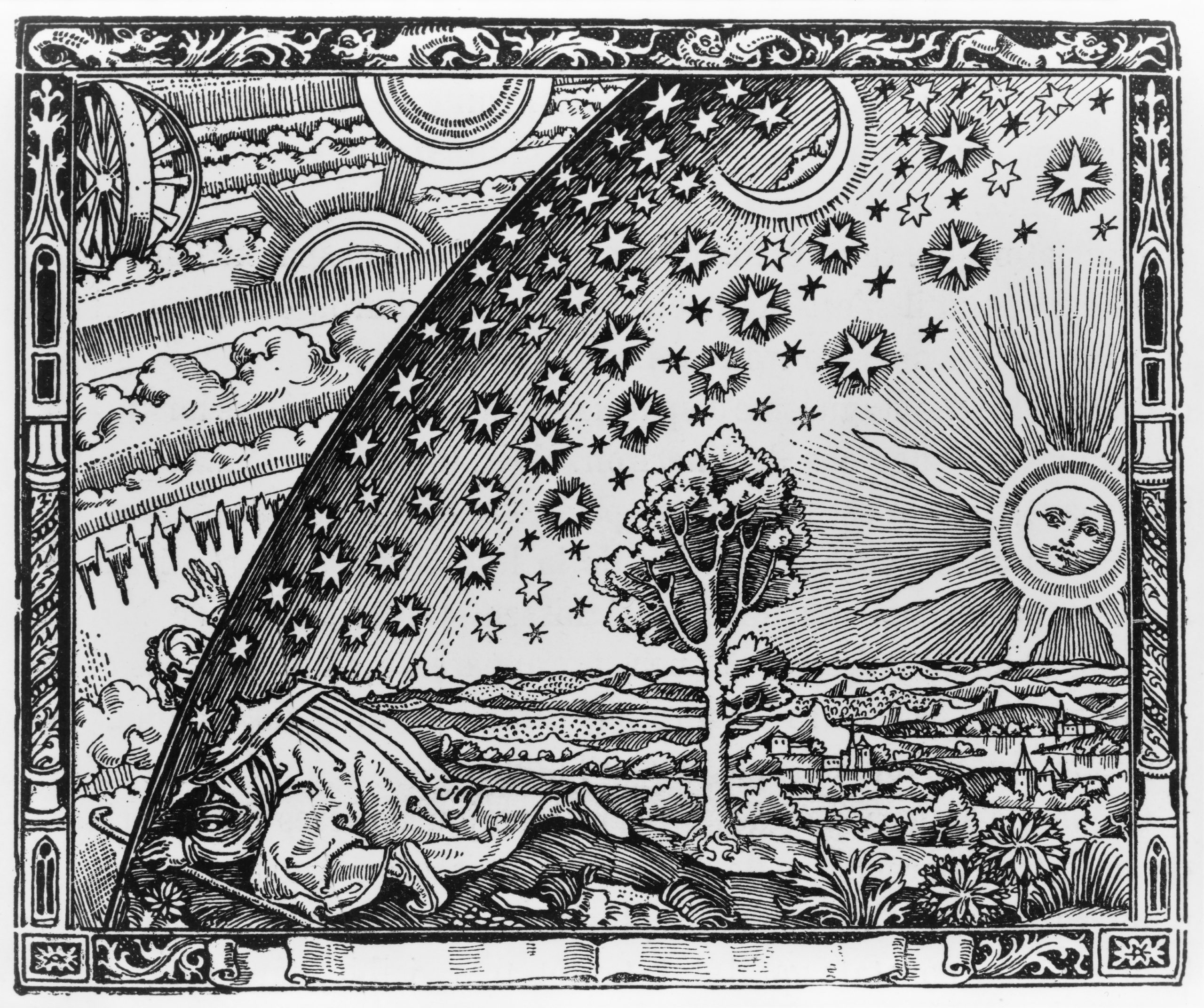

La distancia a las estrellas (III)

Fuente: Wikimedia Commons

Fuente: Wikimedia Commons“Un misionero de la Edad Media dice haber encontrado el punto en el que el cielo se encuentra con la tierra”. Esta es la leyenda que acompaña a una de las imágenes más icónicas de la historia de la astronomía. El conocido como grabado Flammarion ilustra un pasaje de L’Atmosphere: Météorologie Populaire, un libro publicado por el astrónomo Camille Flammarion en 1888. En él, el autor describe las concepciones antiguas del mundo, con el cielo apoyado como una tienda de campaña sobre la tierra.

Durante siglos, nuestra visión del cielo nocturno fue muy parecida a esta. Las primeras representaciones del cosmos pintan el firmamento como una bóveda salpicada de luces. Todas las estrellas se sitúan a la misma distancia del observador, las constelaciones son dibujos planos sobre una pared.

Como el protagonista del grabado de Flammarion, con el paso de los siglos los astrónomos fueron asomándose más allá de esa aparente bóveda y empezaron a hacerse preguntas que les permitieron entender la lógica que daba sentido a todos esos dibujos de luz en la noche. Descubrieron que, lejos de formar una bóvida, cada estrella se sitúa a distinta profundidad y desarrollaron métodos para medir distancias cada vez más inimaginables.

Uno de los más antiguos es el método de paralaje. Se trata de un efecto visual que se produce cuando un observador se mueve. Al hacerlo, los objetos más cercanos parecen cambiar de posición en relación con los más distantes. Es un fenómeno especialmente fácil de reproducir, gracias a los dos ojos (dos puntos de observación) de nuestra cara. Basta con que extiendas tu brazo, con el pulgar alzado, y guiñes alternativamente uno de los dos ojos. El desplazamiento aparente del dedo respecto a los objetos del fondo depende de la distancia que lo separe de tus ojos y se puede usar para calcularla de manera precisa. De hecho, esto es lo que hace tu propio cerebro para que tú percibas el espacio en tres dimensiones. La diferencia entre las imágenes obtenidas desde tus dos puntos de observación (los dos ojos) es suficiente para estimar la distancia a la que se sitúan los objetos de manera intuitiva. Otros animales, con los ojos en lados opuestos de la cabeza y dos campos de visión que no se superponen, por tanto, deben utilizar el movimiento de la propia cabeza o el cuerpo para obtener este efecto del paralaje y poder ver en 3D.

Los astrónomos no tienen los ojos lo suficientemente separados como para percibir la profundidad del cielo nocturno. En cambio, aprovechan el movimiento de la propia Tierra para invocar este mismo principio y determinar la distancia a estrellas relativamente cercanas. Al igual que la punta del dedo, las estrellas que están más cerca de la Tierra cambian de posición en relación con las más distantes, que parecen fijas. Es posible medir de manera precisa el ángulo de desplazamiento de estas estrellas a lo largo del año, y así, conociendo cuánto se ha movido la Tierra (el tamaño de su órbita), calcular la distancia de la estrella usando geometría.

En términos astronómicos, el paralaje solo nos permite calcular distancias relativamente cortas. Pero gracias a él, los astrónomos pueden estimar la profundidad de otros objetos más lejanos y calibrar distintas escalas de medición. Este es el caso de las llamadas “candelas estándar”. Se trata de objetos luminosos cuya magnitud absoluta es conocida, como las cefeidas que mencionamos en el capítulo anterior de esta serie. Comparando su verdadero brillo con su magnitud aparente, es posible conocer a qué distancia se sitúan. No obstante, para calibrar esta escala, primero es necesario calcular la distancia a una cefeida cercana y determinar la relación entre su magnitud absoluta y su periodo de pulsación.

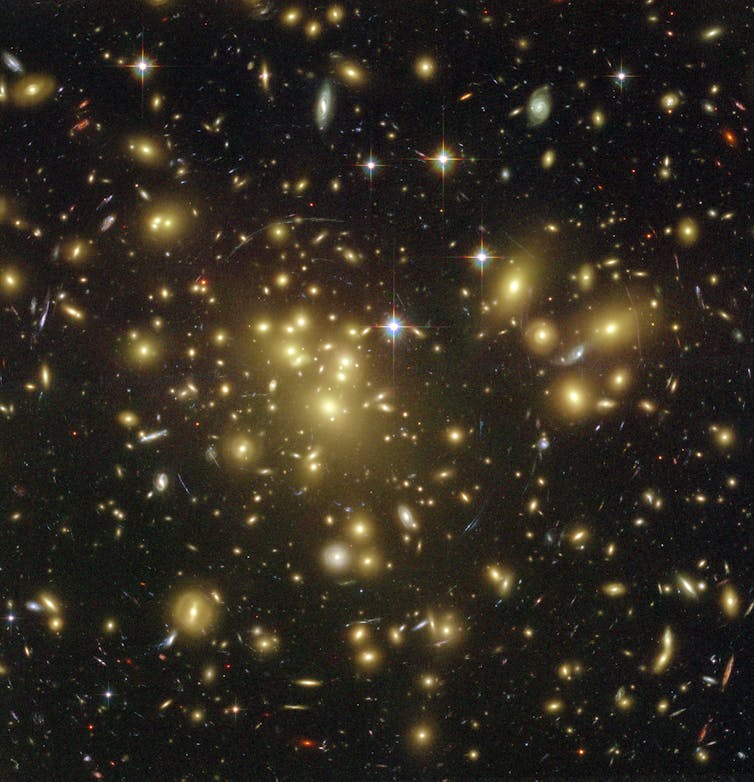

Las cefeidas son estrellas especialmente brillantes, por lo que son visibles en galaxias que se encuentran a decenas de millones de años luz de distancia. Para galaxias aún más distantes, los astrónomos confían en otro tipo de estrellas en explosión conocidas como supernovas de tipo A. Al igual que sucede con las cefeidas, la velocidad a la que se iluminan y se desvanecen estas supernovas está relacionada con su magnitud absoluta, que se puede utilizar para calcular su distancia. Pero esta técnica también requiere una buena calibración utilizando paralaje y cefeidas. Sin conocer la distancia precisa a algunas supernovas, no hay forma de determinar su brillo absoluto.

Otro tipo de método útil para calcular distancias tiene que ver con las variaciones en la propia luz de las estrellas que se alejan de nosotros: el desgaste de la botella debido al viaje del que hablábamos en el capítulo anterior. Hoy sabemos que el universo está en expansión y que las galaxias más lejanas se alejan de nosotros a mayor velocidad que las más cercanas. Esta velocidad provoca un fenómeno conocido como “desplazamiento hacia el rojo” (red shift), debido al efecto Doppler. Las longitudes de onda de la radiación electromagnética tienden a alargarse debido a que su fuente se aleja de nosotros. Si conocemos la frecuencia percibida y la frecuencia original, podemos calcular a qué velocidad se aleja su fuente1.

Para objetos celestes del espacio profundo (a partir de 10 megaparsecs, o 32 millones de años luz, que se dice pronto), la ley de Hubble2 afirma que el corrimiento al rojo de la radiación es proporcional a la distancia que nos separa de su fuente. Esta ley se considera la primera base observacional del paradigma de un universo en expansión, una de las evidencias de la teoría del Big Bang. Se diría que los astrónomos se han asomado tanto a través de la cúpula celeste, que han conseguido ver sus orígenes, quizás no su base, pero sí el punto que vio nacer nuestro cielo nocturno.

Referencias:

1P. A. Tipler, G. Mosca. Física para la ciencia y la tecnología. 6ª Edición. 2012.

2 E. Hubble. A Relation between Distance and Radial Velocity among Extra-Galactic Nebulae. 1929.

Para saber más: De la paralaje

Sobre la autora: Almudena M. Castro es pianista, licenciada en bellas artes, graduada en física y divulgadora científica

El artículo La distancia a las estrellas (III) se ha escrito en Cuaderno de Cultura Científica.

El teorema de Pitágoras y los números congruentes

Los números capicúas, aquellos números tales que sus cifras leídas de izquierda a derecha y de derecha a izquierda son las mismas, llaman profundamente nuestra atención, hasta el punto que solemos buscarlos, e incluso coleccionarlos, en las matrículas de los coches, los décimos de lotería, los billetes de medios de transporte, los billetes de la moneda de cualquier país o cualquier otro lugar en el que aparezcan números de cuatro, o más dígitos. De la misma forma, cuando una fecha lleva asociada una expresión numérica capicúa nos parece una fecha curiosa y solemos prestarle atención, comentarlo e incluso darle cierta relevancia a la misma. Por este motivo, no he podido evitar empezar esta entrada del Cuaderno de Cultura Científica mencionando que ayer fue 22 de febrero de 2022, es decir, 22/02/2022, luego una fecha capicúa puesto que el número asociado a la misma, 22.022.022, es un número capicúa. Además, en esta fecha el número 22 tiene especial relevancia, ya que aparece tres veces el número 22, separado cada uno de los otros por un 0 (sobre el número 22 véase la entrada El misterioso número 22).

¿Qué pasa con el día de hoy, el 23/02/2022? Obviamente no es un número capicúa. Sin embargo, podemos obtener fácilmente un número capicúa a partir del mismo, con el simple proceso de sumarle el número simétrico, 23.022.022 + 22.022.032 = 45.044.054. Este es el algoritmo “invierte el orden y suma” del que hemos hablado en la entrada El secreto de los números que no querían ser simétricos (véase también el libro La gran familia de los números, Libros de la Catarata, 2021).

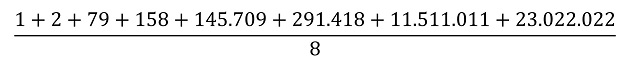

Pero, sigamos con el número asociado al día de hoy, 23.022.022 y pensemos qué propiedades numéricas tiene. Para empezar, este número se puede escribir como producto de tres números primos distintos, 23.022.022 = 2 x 79 x 145.709, es lo que se conoce en matemáticas con el nombre de “número esfénico”. Por lo tanto, tiene 8 divisores (incluyendo el 1 y él mismo: 1, 2, 79, 158, 145.709, 291.418, 11.511.011 y 23.022.022) y la suma de sus divisores propios es 11.948.378, que es una cantidad menor que nuestro número 23.022.022, luego este es un número deficiente (véase la entrada Los números enamorados o el libro La gran familia de los números). Además, es un “número aritmético” ya que, si se realiza la media aritmética de los divisores del número 23.022.022 el resultado es un número natural, en concreto, la media de los divisores de este número

es 4.371.300.

Trivialmente, no es un número primo, ya que es par, pero tampoco es un número “potencialmente primo”, ya que no se puede obtener un número primo sin más que cambiar uno de sus dígitos (por ejemplo, el número 144 es “potencialmente primo” ya que si cambiamos su último dígito obtenemos un número primo, 149).

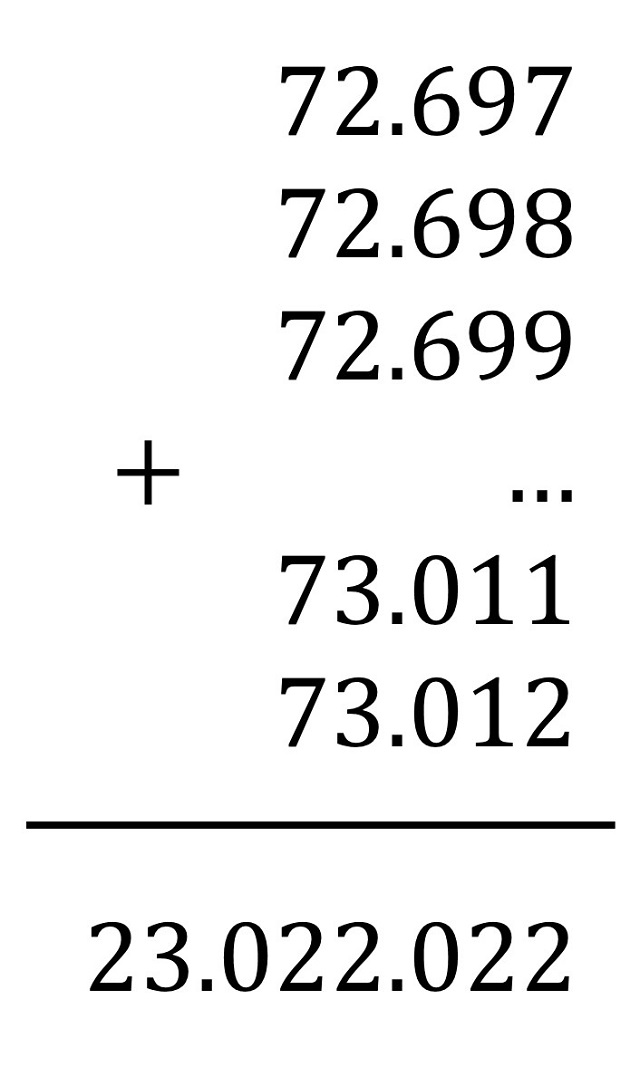

Más aún, 23.022.022 es un número trapezoidal, ya que puede expresarse como suma de dos, o más, números consecutivos, mayores que 1. Así, nuestro número puede expresarse como suma de los números consecutivos desde 72.697 hasta 73.012. Y se dice que 2 elevado a 23.022.022 es un número apocalíptico ya que incluye el número de la bestia, 666, entre sus dígitos.

Finalmente, el número que se corresponde con el día de hoy, 23.022.022, es un “número congruente”. Y este es el concepto que analizaremos brevemente en esta entrada.

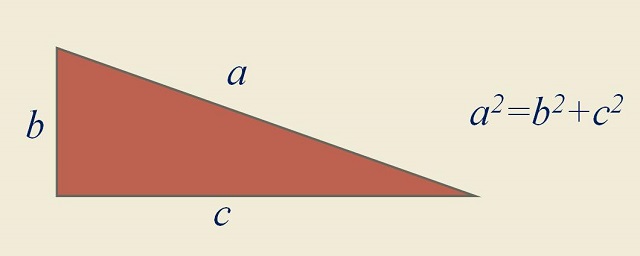

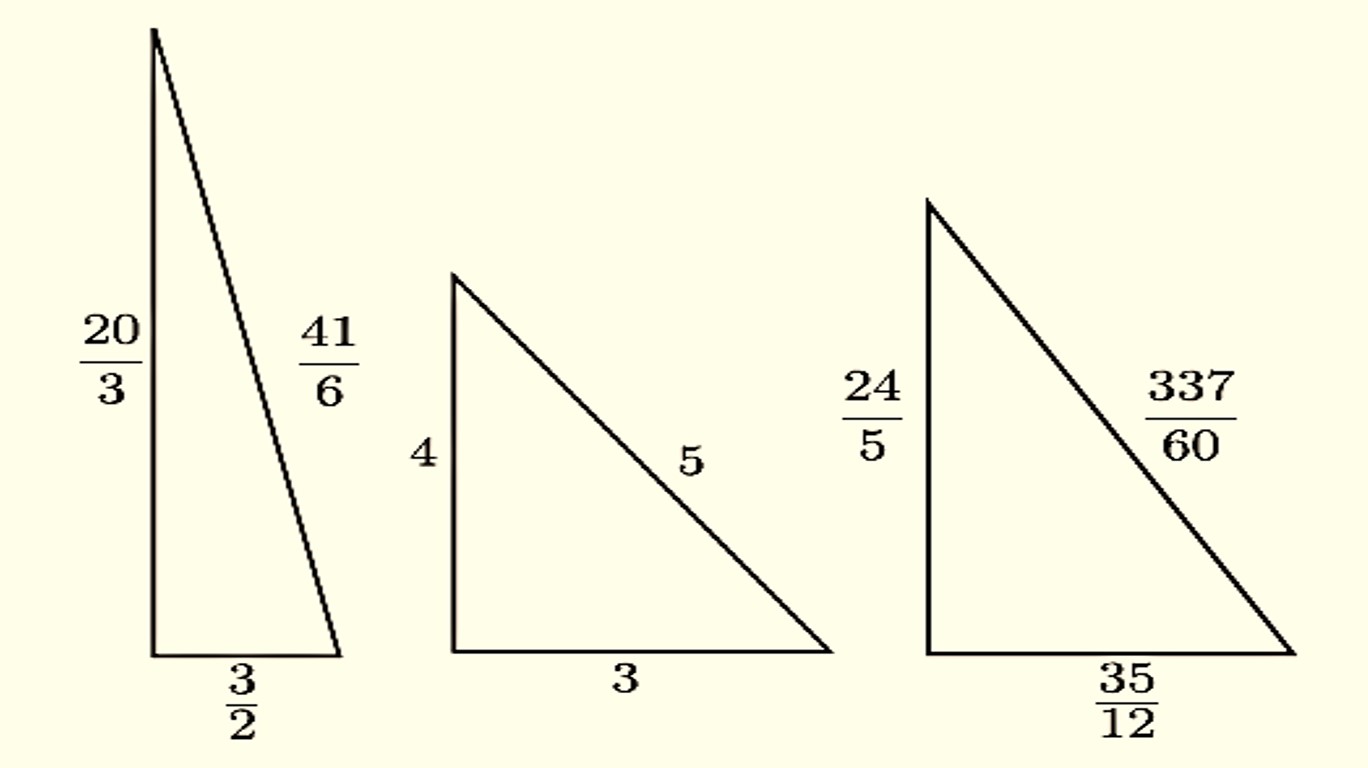

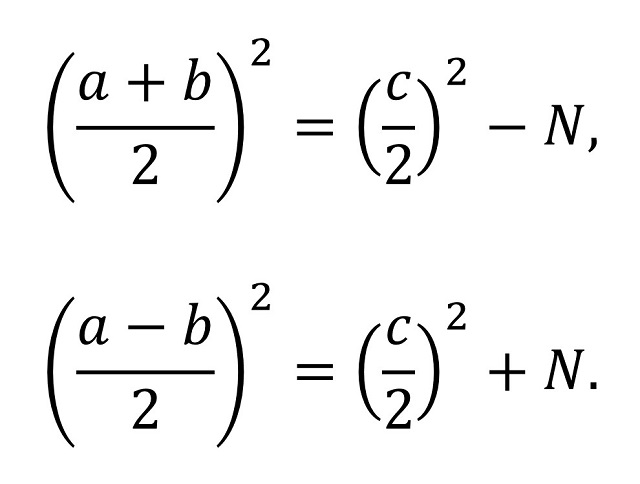

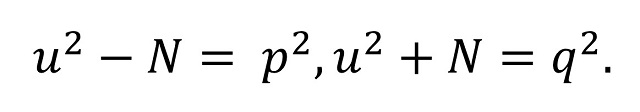

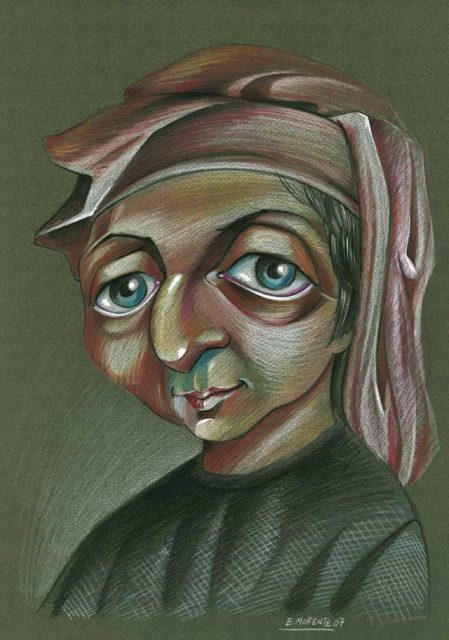

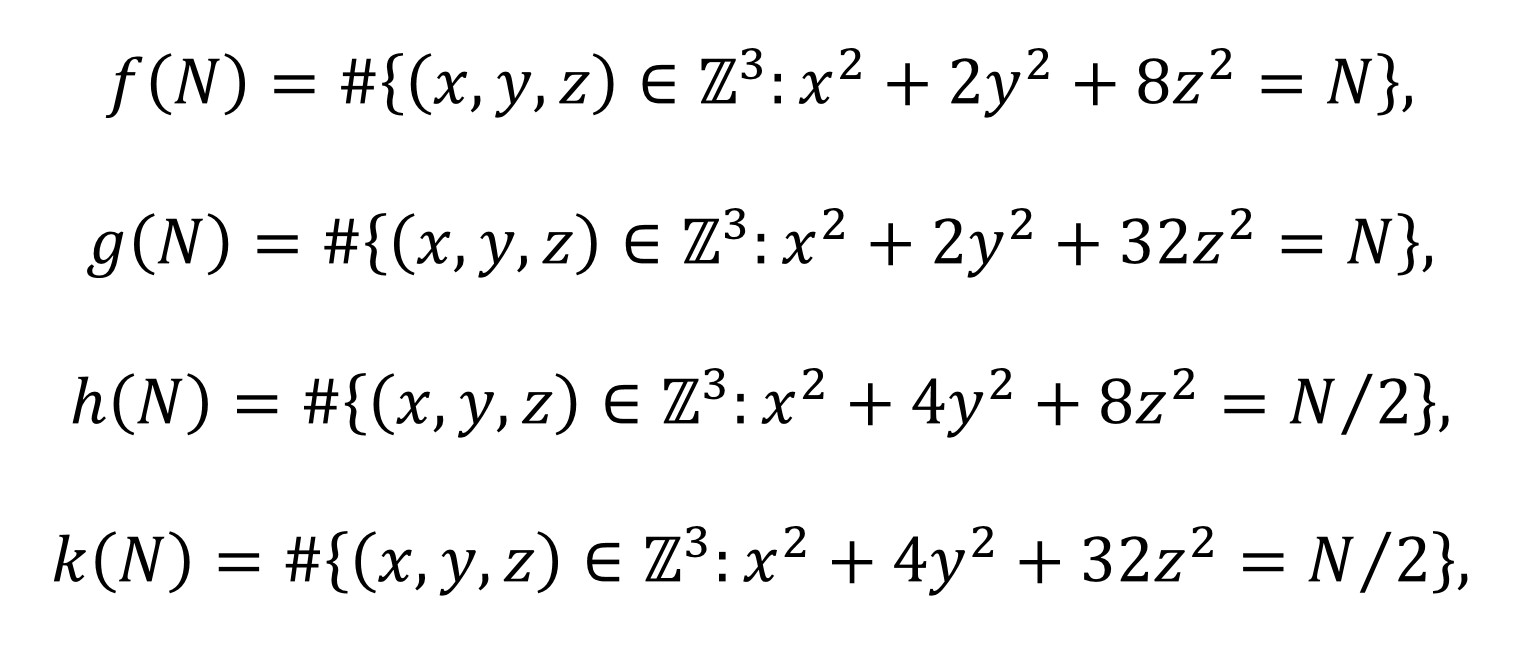

El concepto de número congruente está relacionado con el teorema de Pitágoras. Por lo tanto, como es nuestra costumbre, empecemos recordando este resultado geométrico: “dado un triángulo rectángulo, entonces el cuadrado de la hipotenusa es igual a la suma de los cuadrados de los catetos” (la famosa expresión a2 + b2 = c2, si a y b son los catetos y c la hipotenusa). De hecho, el teorema dice algo más, también es cierto el recíproco, es decir, que “dado un triángulo para el cual el cuadrado de uno de sus lados es igual a la suma de los cuadrados de los otros dos, entonces el triángulo es rectángulo”.