Einstein y David Hilbert

David Hilbert es uno de los grandes matemáticos de todos los tiempos. Su trabajo influyó en numerosos campos, desde el álgebra abstracta a la teoría de números pasando por la mecánica cuántica y la teoría general de la relatividad (TGR). Durante décadas, se asoció a Hilbert con Einstein porque aparentemente los dos llegaron a las ecuaciones de la TGR con días de diferencia. La casi simultaneidad del trabajo de los dos investigadores ha sido la base de, en el mejor de los casos, leyendas sobre la carrera para encontrar las ecuaciones de la TGR y, en el peor, sospechas sobre si Einstein vio una versión preliminar del artículo de Hilbert y basó el suyo en éste. La investigación moderna ha exonerado a Einstein completamente, y ha vuelto las tornas de tal manera que ahora es Hilbert el sospechoso de un presunto plagio.

David Hilbert en 1912. Fuente: Wikimedia Commons

David Hilbert en 1912. Fuente: Wikimedia CommonsHilbert y Einstein se encontraron por primera vez en el verano de 1915 cuando Einstein dio una serie de seis conferencias en Gotinga, donde Hilbert era profesor. Einstein se quedó con la familia Hilbert, y los dos hombres discutieron las dificultades de Einstein con la teoría de la gravedad. Einstein había publicado varios artículos desde 1911 en un intento de ampliar su teoría especial de la relatividad para incorporar la gravedad (precisamente en 1911 publicó el artículo en el que afirmaba que un rayo de luz vería modificada su trayectoria por la presencia de una masa), y aunque no había presentado una teoría completa todavía, estos artículos fueron los precursores de lo que sería la TGR. Después de varios días en la compañía de Einstein, Hilbert estaba ansioso por poner su capacidad matemática al servicio de las nuevas ideas sobre la gravitación. En esa época, la comunidad de físicos de Gotinga estaba muy orientada a la creación de modelos matemáticos como enfoque de la física moderna, y Einstein después comentaría que hicieron más por el desarrollo de las matemáticas de la TGR que sus propios colegas de la Universidad de Berlín.

Durante los meses siguientes Einstein entró en una fase de trabajo febril. Se dio cuenta de que había estado siguiendo el camino equivocado y ahora había encontrado la forma correcta de formular la TGR. Durante este tiempo dejó de escribirse con todo el mundo, excepto con Hilbert. Está claro a la vista de esta correspondencia que los dos hombres intercambiaban información sobre su trabajo. Así, Einstein comunicó que se había dado cuenta de que sus pruebas anteriores estaban equivocadas y Hilbert que estaba trabajando en la forma de conectar la gravedad con la teoría de la luz.

Pero en algún momento de este intercambio, Einstein comenzó a preocuparle el que Hilbert estuviese tan implicado. En noviembre, Hilbert le ofreció a Einstein su último conjunto de ecuaciones y Einstein, que acababa de descubrir las ecuaciones finales de la TGR, escribió la respuesta inmediatamente, claramente intentando establecer su prioridad: “El sistema que envías está de acuerdo, hasta donde puedo ver, exactamente con lo que he encontrado en las últimas semanas y que he presentado a la Academia”. Unos días después escribió otra tarjeta postal a Hilbert afirmando de nuevo que el había desarrollado sus ecuaciones independientemente: “Hoy presento a la Academia un artículo en el que derivo cuantitativamente a partir de la relatividad general, sin ninguna otra hipótesis, el movimiento [precesión] del perihelio de Mercurio descubierto por LeVerrier. Ninguna teoría de la gravitación había conseguido esto hasta ahora”. Einstein no sólo estaba aquí afirmando su prioridad, sino también señalando el increíble logro que reclamaba claramente como suyo. No mencionó, sin embargo, que había trabajado en el problema del perihelio durante varios años y que, por lo tanto, el descubrimiento no era algo que había escrito corriendo en unos pocos días. Hilbert no pudo hacer otra cosa que mandar una nota de felicitación.

Hilbert como preocupaciónA pesar de ello está claro que a Einstein le seguía preocupando Hilbert. Tan pronto como Einstein publicó su artículo el 25 de noviembre, escribió a su amigo Arnold Sommerfeld: “La teoría es bella más allá de toda comparación. Sin embargo, solo un colega la ha comprendido realmente, y está buscando ‘ser partícipe’ en ella… astutamente. En mi experiencia personal no he llegado a conocer la desdicha de la condición humana mejor que a resultas de esta teoría y todo lo conectado con ella”.

Aunque la preocupación de Einstein con el asunto de la prioridad da indicios suficientes para pensar que Einstein sí desarrolló las ecuaciones de la TGR él mismo, de igual manera implica que Hilbert, también, las encontró él mismo. Consecuentemente, la historia habitual del descubrimiento de la TGR siempre ha tenido esta vuelta de tuerca extra: Einstein tendría el mérito de la TGR por unos días, ya que Hilbert la podía haber publicado también. Algunos historiadores de la ciencia han llevado la cuestión más allá. El artículo de Einstein sobre la TGR se publicó el 25 de noviembre de 1915, mientras que el de Hilbert, impreso en marzo del año siguiente, mostraba una fecha de envío del 20 de noviembre. Se ha sugerido que Einstein vio la prueba de Hilbert antes de publicar su propio trabajo, y pudo haber hecho uso fácilmente de la información de Hilbert en su artículo.

Este debate concluyó en 1997. John Stachel, Jürgen Renn y Leo Corry publicaron un artículo en Science en el que analizaban la correspondencia de los archivos tanto de Einstein como de Hilbert. Por una parte, la fecha de envío del artículo de Hilbert es incorrecta, no se envió hasta el 6 de diciembre de 1915, dos semanas después de que se publicase el artículo de Einstein. Lo que es más importante, ni el envío original de Hilbert ni las pruebas que había enviado antes a Einstein, provocándole tanta preocupación, incluyen las ecuaciones correctas de la TGR. Einstein parece que reaccionó histéricamente al trabajo de Hilbert, pudiendo incluso malinterpretar las ecuaciones, viéndolas a la luz de sus propios hallazgos. Está claro que Einstein no pudo tomar nada de Hilbert para su artículo sobre la TGR.

Al contrario, parece que Hilbert habría alterado su artículo para acomodarlo a las ecuaciones recientemente publicadas por Einstein. También es cierto que el trabajo de Hilbert no pretendía hacer lo que Einstein había hecho, es decir, desarrollar una nueva teoría de la gravitación. En vez de eso Hilbert estaba intentando unir la gravedad con investigaciones previas sobre el espectro electromagnético. Su artículo llevaba el ambicioso título de “Los cimientos de la física”, por lo que tenía sentido editarlo para incluir los últimos avances en gravitación; parece que editó su envío original, incorporando el nuevo trabajo de Einstein sobre la gravitación en la versión publicada del artículo. Esto es comprensible, lo que no lo es tanto es el fechar antes el envío, lo que hizo que muchos pensasen que Hilbert había desarrollado esas ecuaciones por sí mismo. Si esta modificación de fecha fue un error o un acto consciente probablemente no se sabrá nunca. Lo que si está claro es que Hilbert fue un matemático brillante, más allá de toda duda.

A pesar de la breve disputa entre Einstein y Hilbert, este episodio no llevó a una animosidad a largo plazo. El 20 de diciembre de 1915, Einstein escribió una carta a Hilbert diciendo, “Ha habido algo de malos sentimientos entre nosotros, la causa de los cuales no quiero analizar. He luchado contra el sentimiento de amargura asociado con ellos, y esto con un éxito completo. Pienso en usted con amabilidad sincera y le pido que intente hacer lo mismo para conmigo. Objetivamente es una lástima que dos colegas que se las han arreglado para sacar algo de este mezquino mundo no se lleven bien el uno con el otro”. Aunque se desconoce si Hilbert respondió, los dos hombres mantuvieron desde entonces una relación cordial.

Referencia:

Corry, L. (1997). Belated Decision in the Hilbert-Einstein Priority Dispute Science, 278 (5341), 1270-1273 DOI: 10.1126/science.278.5341.1270

Para saber más:

Las ecuaciones de campo de la relatividad general

A.J. Durán (2019) Einstein y Hilbert (1 y 2) Blog del Instituto de Matemáticas de la Universidad de Sevilla

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

Una versión anterior de este artículo se publicó en Experientia Docet el 26 de julio de 2009.

El artículo Einstein y David Hilbert se ha escrito en Cuaderno de Cultura Científica.

La anomalía de Ceres

Nuestro Sistema Solar es una caja de sorpresas, y es que a veces encontramos cosas en lugares verdaderamente inesperados. Si no, que se lo digan a Giuseppe Piazzi, que en 1801 descubrió el planeta enano Ceres. Y es aquí donde empieza nuestra historia, porque la de Ceres es, sin lugar a dudas, una historia de dar verdaderos tumbos.

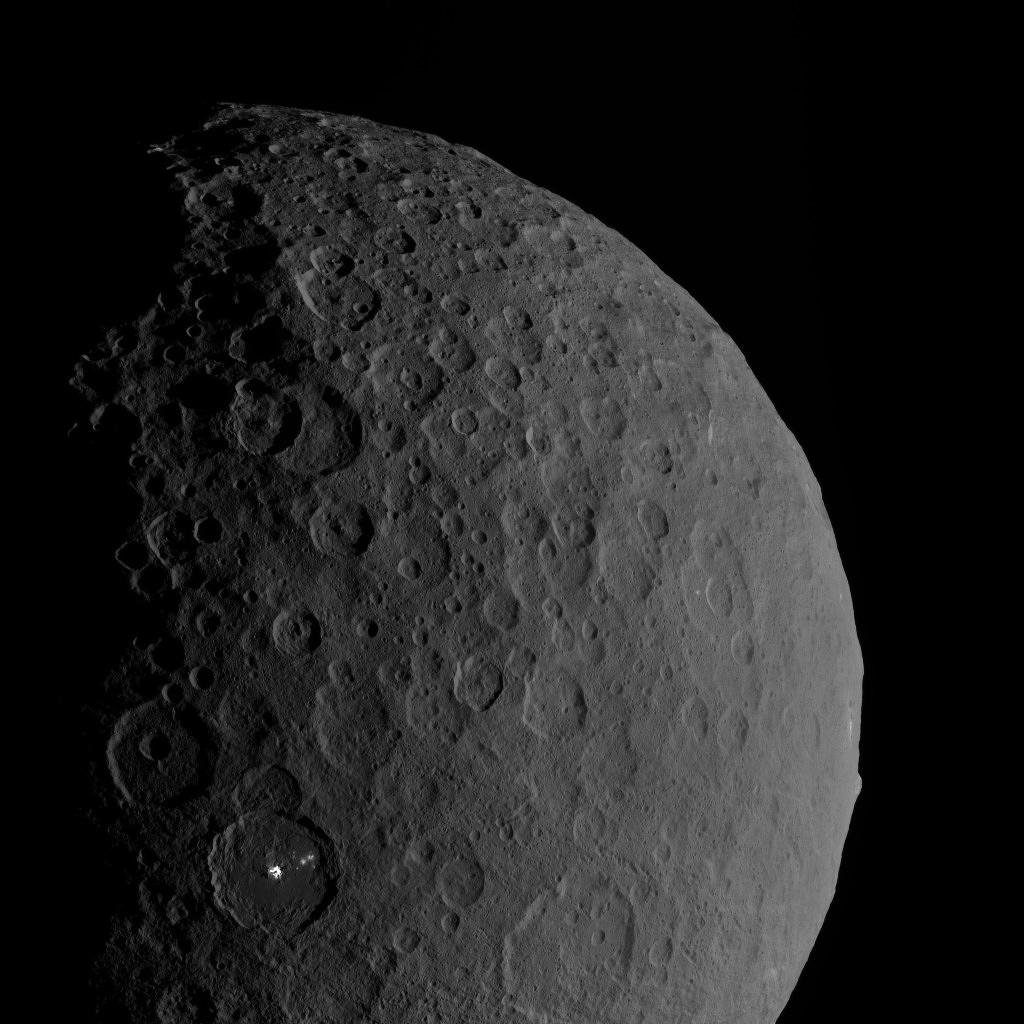

La superficie de Ceres, un lugar lleno de sorpresas. Imagen cortesía de: NASA/JPL-Caltech/UCLA/MPS/DLR/IDA

La superficie de Ceres, un lugar lleno de sorpresas. Imagen cortesía de: NASA/JPL-Caltech/UCLA/MPS/DLR/IDA

De hecho, sin tener en cuenta otros asuntos, y solo fijándonos en la nomenclatura, Ceres tuvo una historia bastante turbulenta: Cuando se descubrió, primero se lo denominó planeta, ya que los astrónomos sospechaban que entre las órbitas de Marte y de Júpiter tendría que haber un planeta y no el aparente hueco que se observaba.

Pero llegó la segunda mitad del siglo XIX y Ceres entró en otra categoría, la de los asteroides, porque empezaron a aparecer otros cuerpos en órbitas similares a la de Ceres y se necesitó en aquel entonces crear una nueva para dar cabida a todos estos cuerpos recién descubiertos y cuyo número comenzaba a crecer.

Y por último, en 2006, volvió a cambiar de categoría para pasar a ser un planeta enano. ¿Por qué? Porque cumple dos de las tres condiciones de la definición de planeta. La primera, que gira alrededor del Sol, y la segunda, que tiene una forma esférica debido a su gran masa, lo que le permite alcanzar el equilibrio hidrostático y le confiere esa apariencia. Pero no cumplía el tercer requisito, que es el haber limpiado su órbita de otros cuerpos y establecido un dominio claro.

Pero la historia de Ceres podría ser mucho más sorprendente de lo que podría parecer a simple vista. El cinturón de asteroides, el lugar donde se encuentra Ceres, está formado por millones de objetos rocosos que “sobraron” de la formación de los planetas del Sistema Solar, como una inmensa reserva de fósiles que contiene una parte de la historia de esos primeros momentos de nuestro sistema planetario.

Al medir sus propiedades, los científicos se dieron cuenta de que algo no cuadraba: su densidad no cuadraba con la de un objeto rocoso, estando alrededor de los 2.15 g/cm3, mientras que la Tierra, por ejemplo, tiene 5.5 g/cm3 o Marte 3.9 g/cm3.

Si Ceres es un cuerpo sólido y rocoso porque se encontraba en el cinturón de asteroides, ¿a qué podría deberse esta diferencia de densidades? ¿Podría ser un objeto de ese tamaño tan poroso que su densidad bajase mucho? No lo parecía, ya que la mayoría de los poros deberían de estar cerrados por efecto de su propia masa y la gravedad.

Resulta que al menos una cuarta parte de su masa en realidad está formada por hielo, un porcentaje muy alto si lo comparamos con los demás cuerpos que lo rodean, y de ahí su baja densidad. No solo eso, en los últimos años se ha descubierto que parte de ese hielo se sublima -pasando del estado sólido al gaseoso sin pasar por el líquido- debido a la energía que recibe del Sol.

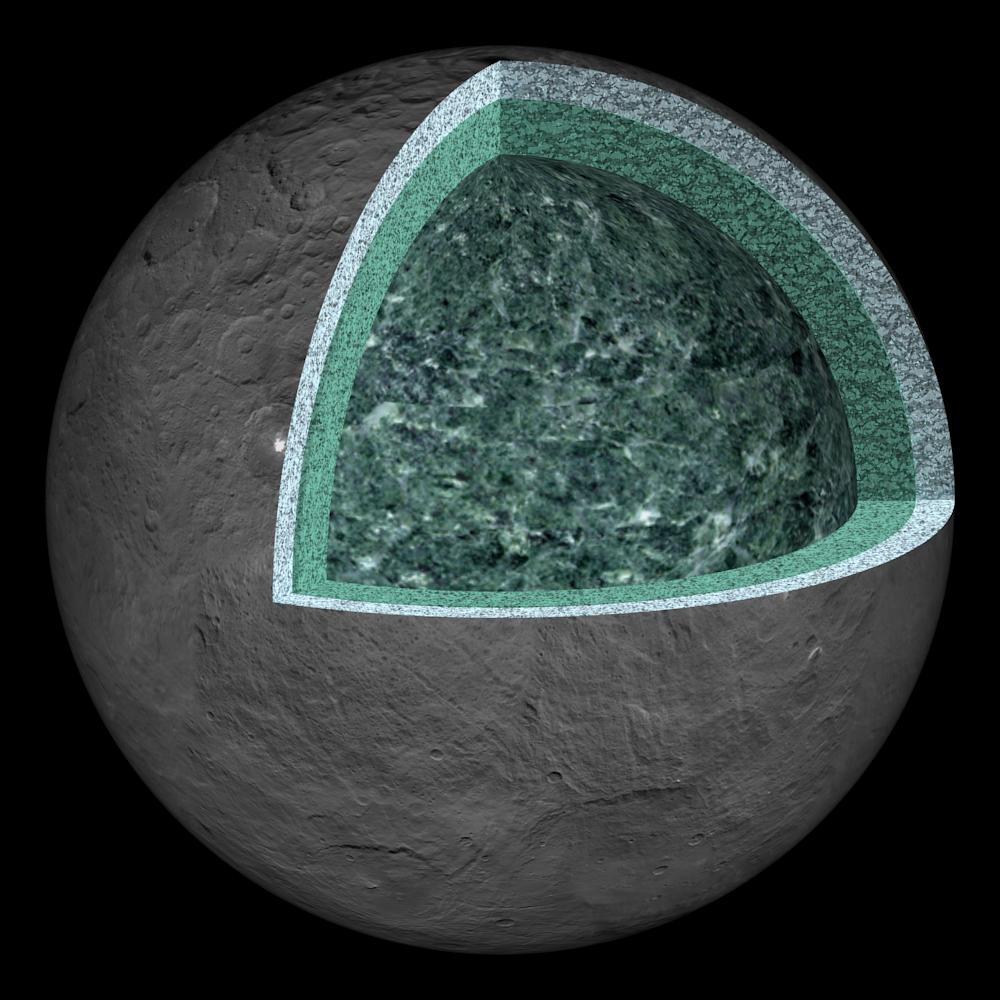

Así podría ser la estructura interna de Ceres: En primer lugar, una corteza de unos 40 kilómetros de potencia formada por hielos, sales y minerales hidratados. De los 40 hasta los 100 kilómetros es posible que exista una capa formada por salmueras en estado líquido. Y a partir de los 100, un manto rocoso. Imagen cortesía de: NASA/JPL-Caltech/UCLA/MPS/DLR/IDA.

Así podría ser la estructura interna de Ceres: En primer lugar, una corteza de unos 40 kilómetros de potencia formada por hielos, sales y minerales hidratados. De los 40 hasta los 100 kilómetros es posible que exista una capa formada por salmueras en estado líquido. Y a partir de los 100, un manto rocoso. Imagen cortesía de: NASA/JPL-Caltech/UCLA/MPS/DLR/IDA.

Este hecho de algún modo nos recuerda a los cometas, cuerpos formados por hielo de distintos volátiles (amoniaco, vapor de agua, dióxido de carbono…) que cuando se van acercando al Sol, debido a la sublimación de estos, desarrollan una cola muy característica y que, conforme se vuelven a alejar, la pierden.

Ante estos hechos, cabe la pregunta, ¿y si Ceres no se formó en el cinturón de asteroides? Un nuevo artículo publicado por Ribeiro de Sousa et al. (2022) sugiere que Ceres no es originario del cinturón de asteroides, sino que en realidad se formó mucho más lejos, migrando posteriormente hacia el interior del Sistema Solar.

Tanto sería así que, según los autores, Ceres podría haberse formado mucho más allá de la órbita de Saturno, donde volátiles como el amoniaco eran muy abundantes y donde las temperaturas eran lo suficientemente bajas como para que volátiles como el monóxido de carbono, dióxido de carbono y el amoniaco empezaran a condensarse y fusionarse junto con el vapor de agua para formar cuerpos cada vez más grandes. Un proceso similar al que se estaba dando en el Sistema Solar interior, pero en vez de con materiales rocosos o metálicos, con granos de distintos hielos.

Para llegar a esta conclusión, los investigadores esta vez han usado simulaciones informáticas para poder calcular la posibilidad de que Ceres provenga de tan lejos. Para ello, empezaron con la formación de los gigantes gaseosos, sembrando en distintas posiciones cuerpos similares a Ceres para estudiar cuál sería su comportamiento orbital a lo largo del tiempo, y mientras estos gigantes seguían creciendo y moviéndose por el Sistema Solar.

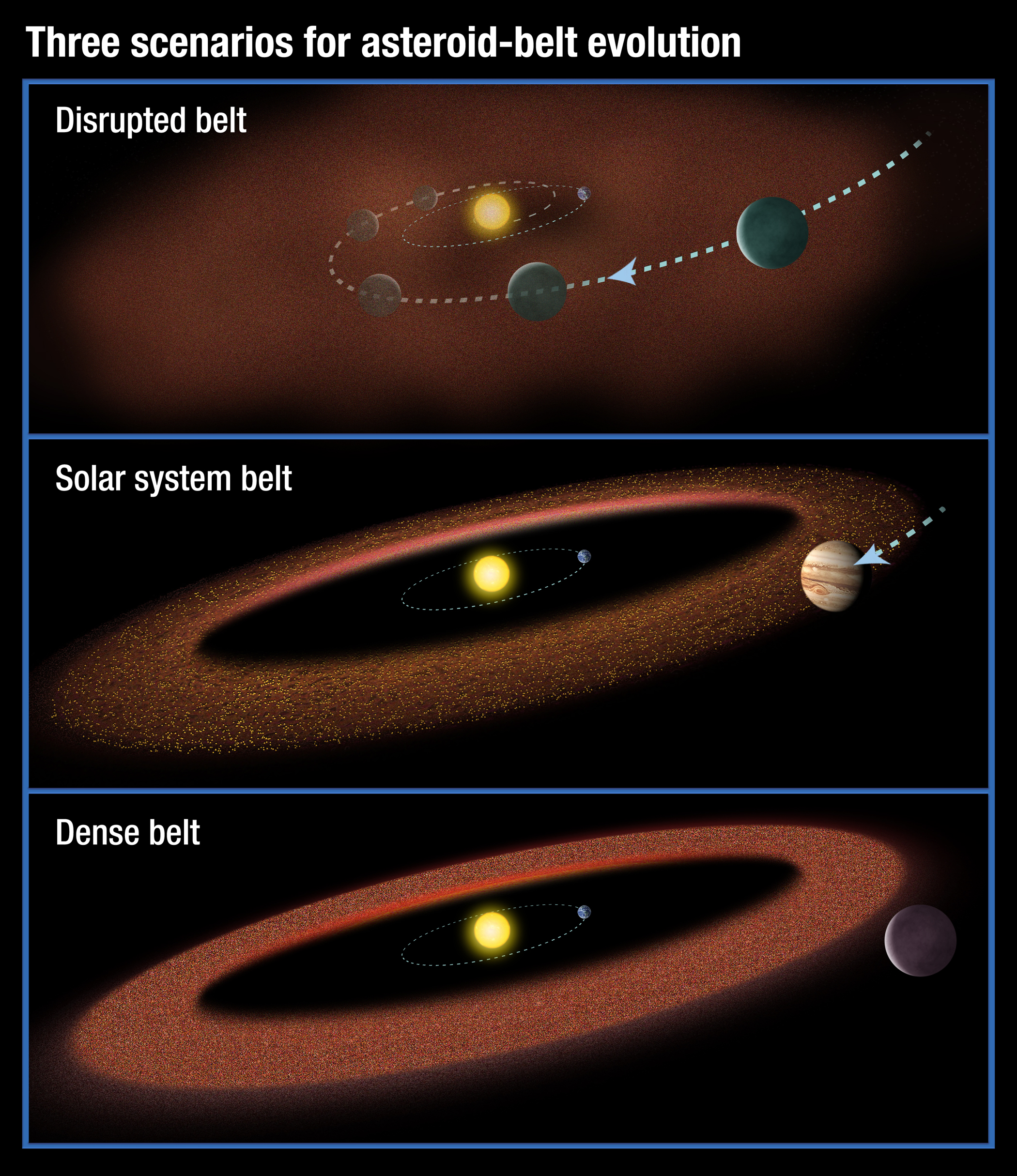

La migración de los gigantes gaseosos hacia el interior de los sistemas planetarios puede tener grandes consecuencias sobre la dinámica orbital del cinturón de asteroides. Imagen cortesía de: NASA/ESA/A. Feild, STScI.

La migración de los gigantes gaseosos hacia el interior de los sistemas planetarios puede tener grandes consecuencias sobre la dinámica orbital del cinturón de asteroides. Imagen cortesía de: NASA/ESA/A. Feild, STScI.

A la vista de los resultados de las simulaciones, han llegado sugerido que distintos mecanismos, como las perturbaciones orbitales provocadas al pasar cerca de otros cuerpos como los gigantes gaseosos, con otros planetas en formación o incluso por el rozamiento con las partículas que todavía estaban alrededor del Sol en estas etapas era suficiente como para importar un objeto formado más allá de Saturno en el interior del Sistema Solar.

Pero no se quedan aquí, este equipo afirma que podría haber habido muchos más cuerpos similares a Ceres, incluso quizás superando en número los diez mil, y que varios de ellos podrían haber formado parte del cinturón de asteroides, pero la interacción gravitatoria con los planetas gigantes podría haberlos expulsado también de esta zona.

Aunque este tipo de estudios puedan resultarnos una mera curiosidad, lo cierto es que nos ayudan mucho a reconstruir la compleja dinámica de la formación planetaria y de la que todavía nos queda mucho por aprender y que, sin duda, nos permitirá comprender las diferencias entre los distintos planetas del Sistema Solar.

Referencia:

Ribeiro de Sousa, R., Morbidelli, A., Gomes, R., Neto, E., Izidoro, A. and Alves, A. (2022) Dynamical origin of the Dwarf Planet Ceres. Icarus, doi: 10.1016/j.icarus.2022.114933

Para saber más:

15 años con el planeta enano Plutón

Sobre el autor: Nahúm Méndez Chazarra es geólogo planetario y divulgador científico.

El artículo La anomalía de Ceres se ha escrito en Cuaderno de Cultura Científica.

La transición al Neolítico en Europa

Migraciones yamnaya. Fuente: Wikimedia Commons

Migraciones yamnaya. Fuente: Wikimedia CommonsLa denominada “revolución neolítica” empezó hace ciento veinte siglos en el llamado “Creciente fértil”, una zona que se extiende desde Mesopotamia (actual Iraq y oeste de Irán), en el este, hasta el norte del valle del Nilo, en el oeste, describiendo una curva en forma de media luna por los actuales Kurdistán, Siria, Líbano, Jordania, Israel y Palestina. Esa transición ocurrió más tarde en otros lugares del planeta. Se empezaron cultivando cereales y, más tarde, leguminosas. Los primeros animales domesticados fueron muflones, de los que proceden las ovejas, y cabras; más adelante se criaron uros (ganado vacuno) y otras especies. Los caballos se domesticaron después y en Asia central, aunque no se sabe con precisión dónde.

Los primeros agricultores y ganaderos llegaron a Europa procedentes de Anatolia, la actual Turquía. Esos pueblos eran el resultado de la mezcla repetida entre grupos de cazadores recolectores europeos y del Medio Oriente que se movían de unos lugares a otros. Hace algo más de ocho mil años, esos primeros granjeros empezaron a desplazarse hacia el oeste, hacia Europa, donde se fueron cruzando con cazadores recolectores locales. Llegaron en diferentes momentos a prácticamente todos los enclaves de Europa Occidental, en un proceso que se prolongó durante varios milenios.

Una investigación a gran escala, basada, sobre todo, en datos de genoma antiguo, indicadores de dieta (ratios entre isótopos de carbono y nitrógeno), de movilidad (ratios entre isótopos de estroncio) y de cubierta vegetal (polen) ha permitido caracterizar la transición al Neolítico en Europa y amplias zonas del oeste de Siberia. La investigación ha revelado que, ya antes de producirse la llegada a Eurasia de los primeros agricultores, había una gran diversidad genética en los pueblos de cazadores recolectores. También ha permitido identificar un linaje procedente de la cuenca media del río Don que tuvo una aportación genética significativa a los yamnaya, los pastores nómadas de las estepas al norte del Cáucaso y de los mares Negro y Caspio.

Al este de una franja de terreno que se extiende en dirección norte sur desde el Mar Báltico al mar Negro, la neolitización no conllevó la sustitución de los linajes genéticos preexistentes. Sin embargo, la transición tuvo una influencia genética muy importante al oeste de esa franja, de tal manera que en algunas zonas, como la actual Dinamarca, se produjo una sustitución total de los linajes de cazadores recolectores por los de agricultores y ganaderos que procedían de Anatolia.

La segunda mayor transformación genética empezó hace unos cinco mil años y se prolongó durante diez siglos aproximadamente, que es el tiempo que tardaron los yamnaya en expandirse desde las estepas al norte del Cáucaso hasta la mayor parte de las regiones europeas. Los pobladores neolíticos que ya habitaban el este, sur y oeste del subcontinente europeo se mezclaron con los pastores yamnaya, mientras que en Escandinavia, más que mezcla, se produjo la sustitución casi total de los antiguos linajes por los recién llegados. Algo similar ocurrió en el oeste de Siberia. Recordemos que los yamnaya se desplazaban a caballo y en carros que utilizaban, además, como vivienda.

Ya antes de la transición neolítica Europa era genéticamente muy diversa. La neolitización, con sus movimientos de pueblos de procedencias diferentes, aportó mayor diversidad. Y la adaptación a las condiciones ambientales propias de cada región, incluidas las relacionadas con la comida, generó variación adicional. Aunque los movimientos de población y las adaptaciones se han seguido produciendo tras completarse la revolución neolítica, todavía hoy se detectan patrones de variación que hunden sus raíces en lo que ocurrió en nuestro continente hace más de ochenta siglos.

Fuente: Allentoft, M. E., et al., Population Genomics of Stone Age Eurasia, 2022. bioRxiv 2022.05.04.490594 (preprint).

Para saber más:

Biomarcadores para determinar los hábitos del pastoreo neolítico

Una estructura de parentesco neolítico

La lateralidad del tallista neolítico

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo La transición al Neolítico en Europa se ha escrito en Cuaderno de Cultura Científica.

IV Jornada Nacional de Evolución y Neurociencias: José Miguel Martínez – ¿Por qué siguen existiendo los psicópatas?

¿Estamos realmente diseñados para conectar con los demás? Si es así, ¿por qué siguen existiendo los psicópatas? ¿Se pueden tratar trastornos delirantes como la paranoia desde el punto de vista de la evolución? O ¿cómo ha cambiado la atracción sexual desde la época de nuestros ‘abuelos’ homínidos hasta ahora?

A estas y otras cuestiones relativas a la evolución del comportamiento humano se trató de dar respuesta durante la IV Jornada Nacional de Evolución y Neurociencias, evento organizado por la Cátedra de Cultura Científica de la UPV/EHU y la Red de Salud Mental de Bizkaia, que tuvo lugar los días 28 y 29 de abril en el Bizkaia Aretoa – UPV/EHU de Bilbao.

Desde que en 2017 un grupo de psiquiatras de la Red de Salud Mental de Bizkaia organizara la primera edición de esta jornada, la cita se ha convertido en un punto de encuentro para profesionales de distintos ámbitos científicos como la psiquiatría, la psicología, la biología o la filosofía con un interés común: la conducta humana desde una perspectiva evolucionista y su divulgación científica en un formato accesible y ameno para todos los públicos, a la par que riguroso y actualizado.

La evolución no nos ha hecho perfectos del todo. Los psicópatas siguen existiendo (no hay informativo de televisión en el que no salga alguno y no todos los que salen son asesinos, que se sepa). José Miguel Martínez Gázquez, psicólogo especialista en neuropsicología clínica, y que además ha estudiado el comportamiento de otros primates además del humano, nos explica este hecho aparentemente sorprendente.

Para saber más:

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo IV Jornada Nacional de Evolución y Neurociencias: José Miguel Martínez – ¿Por qué siguen existiendo los psicópatas? se ha escrito en Cuaderno de Cultura Científica.

Polvaredas y sonidos en Jezero (Marte)

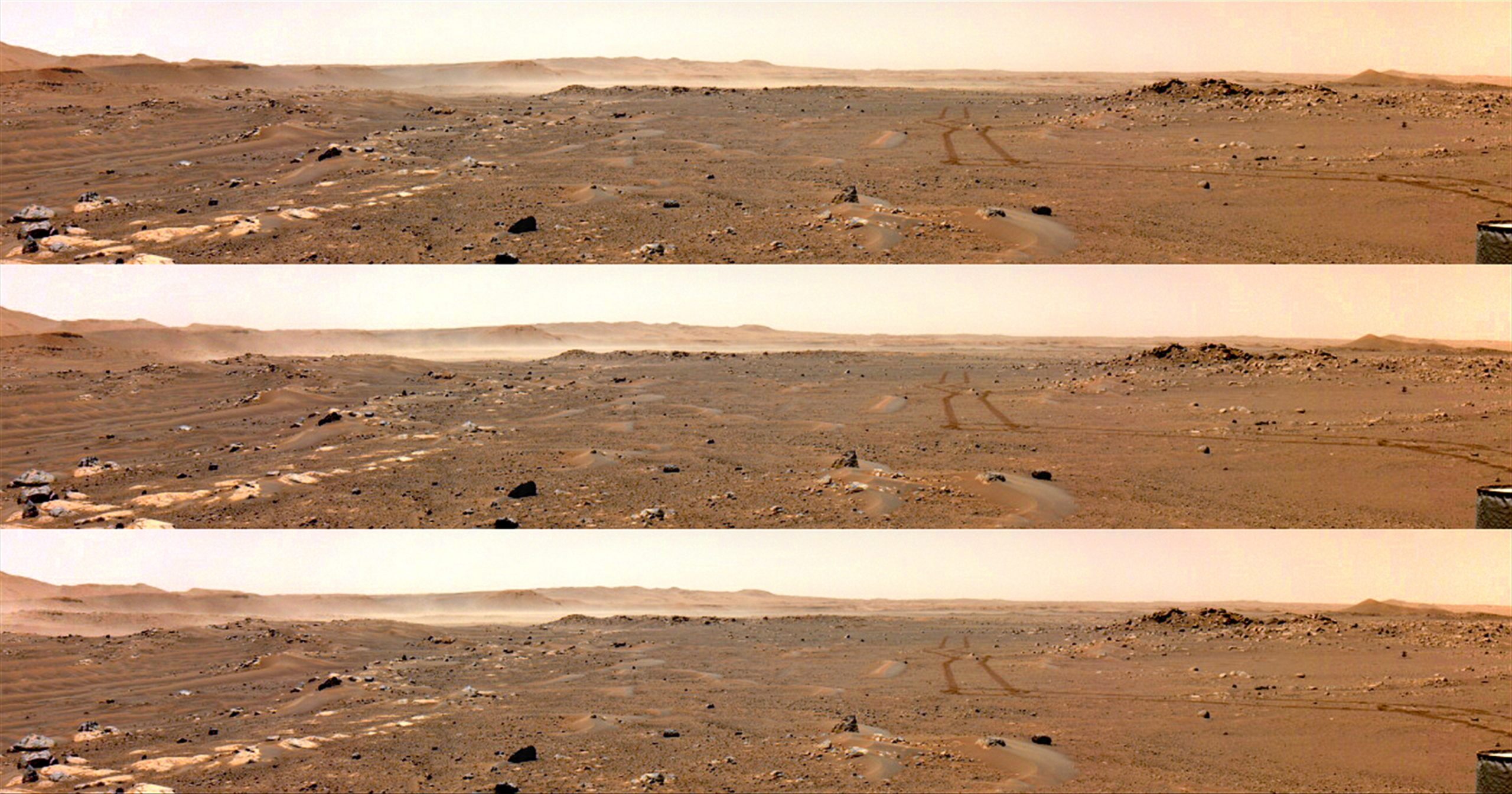

Secuencia de levantamiento de polvo causado por una fuerte ráfaga de viento a mediodía. El área que se ve en las imágenes ocupa una superficie de unos 4 km2. Autor: NASA/Caltech-JPL/ASU/MSSS/SSI

Secuencia de levantamiento de polvo causado por una fuerte ráfaga de viento a mediodía. El área que se ve en las imágenes ocupa una superficie de unos 4 km2. Autor: NASA/Caltech-JPL/ASU/MSSS/SSIEl 18 de febrero de 2021 llegó a Marte la misión Mars 2020 de la NASA y sobre la superficie del cráter Jezero comenzó a operar el rover Perseverance, un auténtico laboratorio móvil. Uno de sus instrumentos es la estación meteorológica MEDA, desarrollada en el Centro de Astrobiología-INTA en Madrid y en la que colaborado el Grupo de Ciencias Planetarias de la Universidad del País Vasco, que dirige el catedrático Agustín Sánchez Lavega. El análisis de los datos que va proporcionando MEDA está permitiendo profundizar en uno de los aspectos clave de la atmósfera del planeta rojo: como se levanta el polvo de la superficie.

“Podemos decir que ahora empezamos a comprender las condiciones necesarias para levantar el polvo de la superficie de Marte. Y este es un elemento clave, porque el ciclo de polvo del planeta rojo nos ayudará a entender mejor la meteorología global de Marte”, explica Ricardo Hueso, segundo autor del artículo publicado en Science Advances por el grupo.

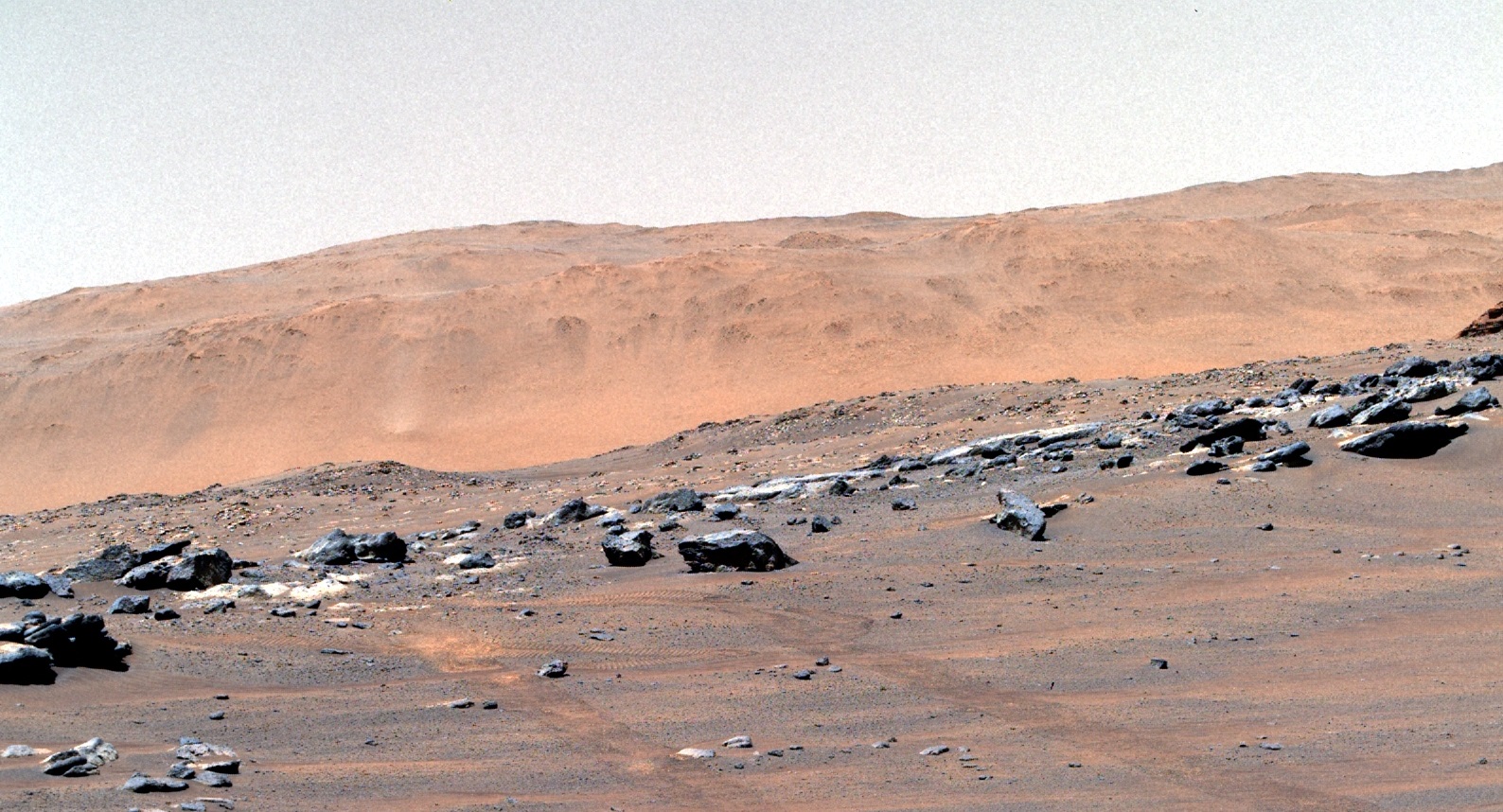

Remolino de polvo o dust devil observado por las camaras Mastcam-Z. Autor: NASA/Caltech-JPL/ASU/MSSS/SSI

Remolino de polvo o dust devil observado por las camaras Mastcam-Z. Autor: NASA/Caltech-JPL/ASU/MSSS/SSIAl ser la atmósfera marciana unas 150 veces menos densa que la terrestre, el polvo en suspensión determina muchas de sus propiedades térmicas y cómo se calienta y se enfría. Este nuevo trabajo estudia los fenómenos que levantan el polvo en la superficie de Marte, incluyendo los remolinos de polvo llamados ‘dust devils’ y los vientos racheados capaces de producir grandes polvaredas. De hecho, gracias a los datos recopilados sobre el viento, polvo, temperatura y otras variables atmosféricas, el equipo internacional que colabora en la investigación ha concluido que el cráter Jezero, elegido como lugar de estudio de la misión Mars 2020 porque, aunque hoy es un desierto, hace miles de millones de años estaba totalmente inundado, es uno de los lugares más activos y favorables para levantar grandes cantidades de polvo de su superficie.

Serie de imágenes capturadas por las cámaras Navcam que muestran varios «dust devils» en movimiento en Jezero. Autor: NASA/Caltech-JPL/ASU/MSSS/SSI

Serie de imágenes capturadas por las cámaras Navcam que muestran varios «dust devils» en movimiento en Jezero. Autor: NASA/Caltech-JPL/ASU/MSSS/SSILos vientos diurnos son ascendentes y, en general, intensos, mientras que de noche los vientos detectados son descendentes y más débiles. “Es la interacción de estas corrientes de viento con la superficie la que produce estos fenómenos de levantamiento de polvo masivo”, indica Hueso. El polvo de la atmósfera de Marte, al depositarse sobre la superficie, puede cubrir paneles solares e imposibilitar el funcionamiento de algunas misiones espaciales de superficie. Sin embargo, este no es un aspecto preocupante para el rover Perseverance, que utiliza energía nuclear para sus operaciones.

“Conocer la atmosfera de Marte hoy no solo es fundamental para entender su pasado cuando Marte era un planeta potencialmente habitable, sino también para preparar la exploración humana de Marte que esperamos pueda desarrollarse en las próximas décadas”

Ricardo Hueso.

Primeras grabaciones de sonidosPor otra parte, Nature publica esta semana ‘In situ recording of Mars soundscape’, que recoge las primeras grabaciones de sonido en la fina atmósfera de Marte. En el artículo ha participado el grupo IBeA de la UPV/EHU, que dirige el catedrático Juan Manuel Madariaga, así como uno de los firmantes del artículo anterior, el estudiante de doctorado Asier Muguira.

Como desvelan las grabaciones, en la tenue atmósfera de Marte se producen fenómenos acústicos diferentes a los terrestres, como, por ejemplo, la dispersión del sonido en diferentes frecuencias del espectro audible humano, o una mayor atenuación del sonido con la distancia debido de nuevo a la baja densidad atmosférica.

El artículo está basado en los datos del micrófono del instrumento SuperCam, en cuyo desarrollo ha participado el grupo IBeA, y recoge sonidos naturales producidos por el viento en el cráter Jezero. Así mismo, se pueden escuchar sonidos artificiales producidos por las aspas del helicóptero Ingenuity, el compresor del instrumento MOXIE y los del rover y sus ruedas al desplazarse por Marte, así como los sonidos producidos por la ablación que genera el láser del instrumento LIBS (parte de SuperCam), de cuyo análisis se pueden inferir propiedades de los materiales examinados en Marte.

Referencias:Newman, Hueso, Lemmon, Munguira et al. (2022) The dynamic atmospheric and aeolian environment, of Jezero crater, Mars Science Advances doi: 10.1126/sciadv.abn3783

Maurice, S., Chide, B., Murdoch, N. et al. (2022) In situ recording of Mars soundscape Nature doi: 10.1038/s41586-022-04679-0

Para saber más:Sería buena noticia que no hubiera vida en Marte ni la hubiese habido nunca

Marte y el enigma de la vida: el gran desembarco robótico de 2021

Los glaciares olvidados de Marte

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Polvaredas y sonidos en Jezero (Marte) se ha escrito en Cuaderno de Cultura Científica.

Y, sin embargo, se mueven

Hace 110 años, el físico y meteorólogo alemán Alfred Wegener propuso una curiosa idea que presentó a la comunidad científica, unos años después, con la publicación de su obra “El Origen de los Continentes y Océanos”. En ella, Wegener planteaba una concepción movilista de nuestro planeta, argumentando que hace millones de años todos los continentes estuvieron unidos en una gran masa de tierra a la que denominó Pangea (del griego “todas las tierras”), que a su vez estaba rodeada por un único y enorme océano al que llamó Panthalassa (también del griego “todos los mares”). Pero, en algún momento, este gran supercontinente se fracturó y entonces los continentes se desplazaron sobre el océano hasta alcanzar la posición actual.

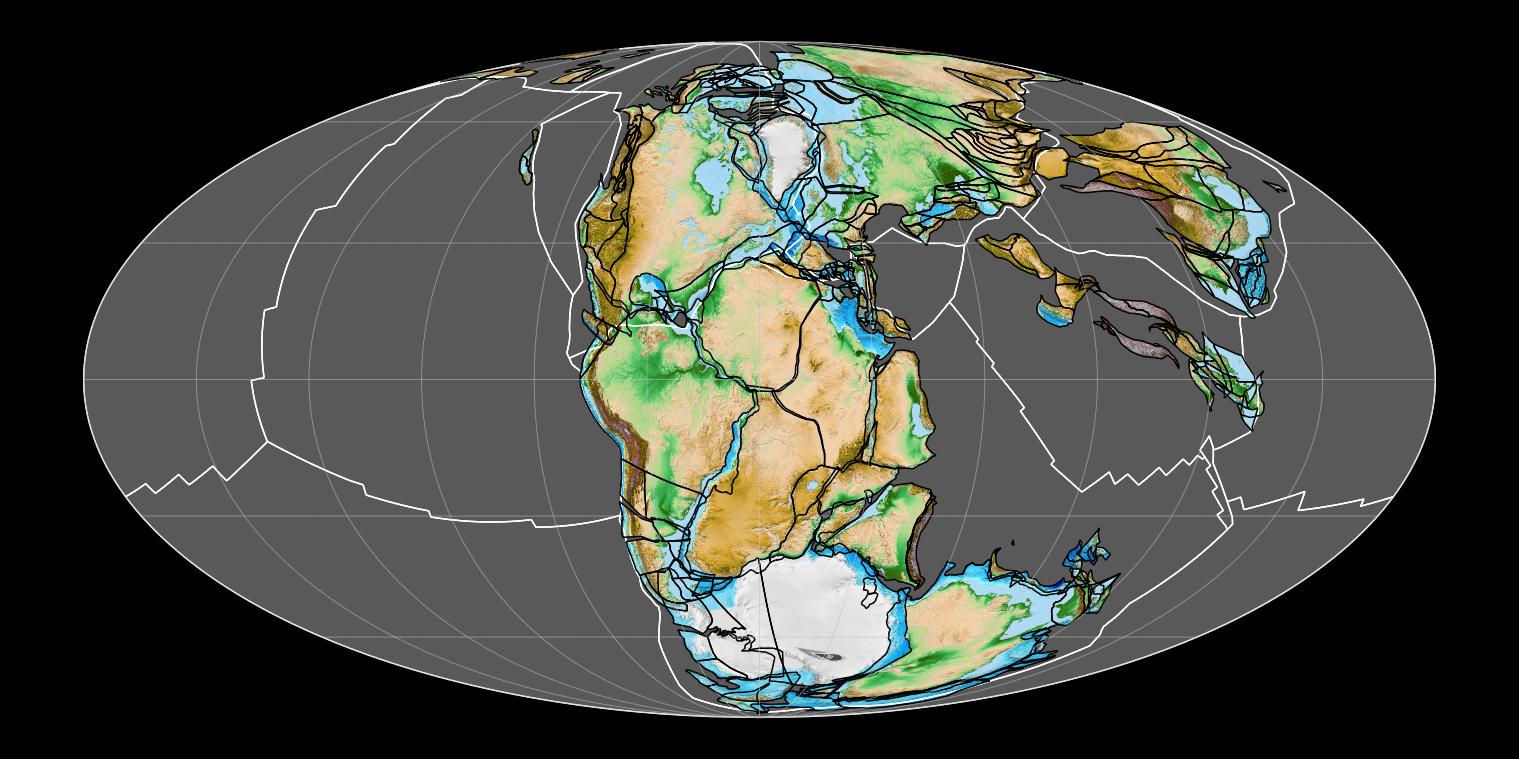

Pnagea hace 200 millones de años. Fuente: Wikimedia Commons

Pnagea hace 200 millones de años. Fuente: Wikimedia CommonsPara sustentar su hipótesis, Wegener se basó en ciertas evidencias geológicas. Observó que los perfiles continentales de Europa, África y América encajaban casi a la perfección, como si fuesen las piezas de un puzle, y encontró que algunos materiales geológicos, rocas, fósiles y cordilleras se continuaban a un lado y otro del Atlántico, aseverando que, en algún momento del tiempo geológico, esas zonas estuvieron unidas y posteriormente se separaron. Sin embargo, no fue capaz de explicar cómo se produjo ese movimiento de las masas continentales. Hasta que, en los años 60, gracias a los avances en la investigación geofísica de los fondos oceánicos, se descubrió el motor que realmente mueve nuestro planeta, la tectónica de placas. Ahora sabemos que los continentes no se desplazan sobre los océanos, son los fragmentos en los que está dividida la litosfera o capa más externa de nuestro planeta, a los que llamamos placas tectónicas, los que se mueven sobre la astenosfera, que es la capa que tienen justo por debajo.

Pero no voy a entrar ahora en detalles sobre cómo o por qué se mueven las placas tectónicas. Lo que vamos a ver es desde cuándo lo hacen. Es decir, responder a una pregunta que igual no os habéis hecho nunca: ¿Ha habido una sola Pangea en la historia de la Tierra?

Pues vamos a viajar al pasado más remoto de nuestro planeta y veamos lo que nos dice la evidencia científica. La Tierra tiene casi 4600 millones de años y hace al menos 3800 millones de años que se formó una litosfera estable, con las primeras placas tectónicas y las primeras masas continentales. Fue entonces cuando se le dio al botón de encendido de los movimientos tectónicos y, por suerte, tenemos registros geológicos del devenir de las placas desde entonces. Y parece que tienen un comportamiento muy cíclico: en primer lugar, las placas tectónicas formadas por masas continentales acaban convergiendo entre sí dando lugar a un supercontinente. Pasados millones de años, los movimientos tectónicos provocan la fragmentación de esa gran masa terrestre en continentes menores y su separación progresiva. Finalmente, las placas tectónicas vuelven a converger, dando lugar a un nuevo supercontinente. Y así sucesivamente. Es lo que se conoce como Ciclo Supercontinental de Wilson.

No hubo un único supercontinenteAhora que sabemos que no ha habido una sola Pangea en el pasado geológico, se nos plantean dos nuevas preguntas: ¿Cuántos supercontinentes han existido?, y ¿cuándo se formaron y se disgregaron esos supercontinentes? Para responder a ambas cuestiones, vamos a hacer un pequeño listado lleno de nombres curiosos.

El supercontinente más antiguo del que tenemos evidencias se formó hace entre 3600 y 2750 millones de años y se le conoce como Supercontinente Vaalbará. Le sigue el Supercontinente Kenorland, que comenzó a constituirse hace unos 2750 millones de años y se fracturó hace 2500 millones de años. El tercer supercontinente del que nos quedan evidencias se conformó hace entre 2500 y 2100 millones de años y se le conoce como Supercontinente Arctica. Hace entre 2100 y 1800 millones de años nos encontramos con el Supercontinente Atlantica. El quinto fue el Supercontinente Columbia, que se generó hace unos 1800 millones de años y se desmembró hace unos 1300 millones de años. A continuación, hace entre 1250 y 650 millones de años, tenemos el Supercontinente Rodinia. Y terminamos este repaso con el Supercontinente Pannotia, formado hace unos 600 millones de años y fracturado hace 540 millones de años. Por tanto, el Supercontinente Pangea (hace entre 335 y 175 millones de años) es, como mínimo, el octavo supercontinente de la historia geológica de nuestro planeta.

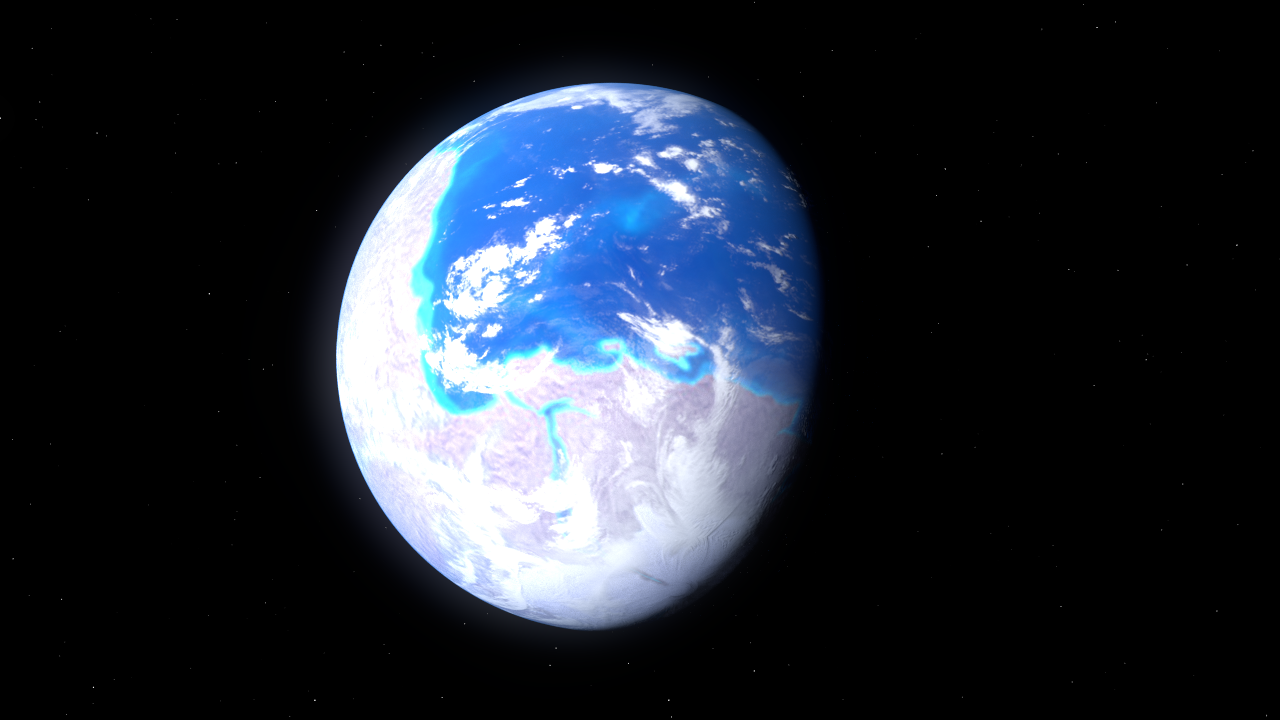

Ilustración del aspecto que ofrecería la Tierra vista desde el espacio hace 600 millones de años, con el supercontinente Pannotia

Ilustración del aspecto que ofrecería la Tierra vista desde el espacio hace 600 millones de años, con el supercontinente PannotiaVamos, que la Tierra no ha estado quieta prácticamente desde que se formó. La tectónica de placas evidencia una serie de movimientos cíclicos de colisión y separación de grandes continentes que seguirá produciéndose mientras exista dinámica litosférica en nuestro planeta. ¿Significa esto que en el futuro volverá a formarse un nuevo supercontinente? La respuesta es sí. Se estima que, dentro de algo más de 200 millones de años, las actuales masas continentales confluirán de nuevo entre sí. Aunque se han propuesto hasta cuatro hipótesis sobre el aspecto de dicho supercontinente, ya que no es tan sencillo estimar el verdadero movimiento futuro de las placas tectónicas basándonos en las actuales orientaciones y velocidades de desplazamiento de las mismas. Al menos los nombres propuestos para esos posibles futuros supercontinentes siguen siendo muy evocadores: Pangea Ultima, Novapangea, Aurica y Amasia.

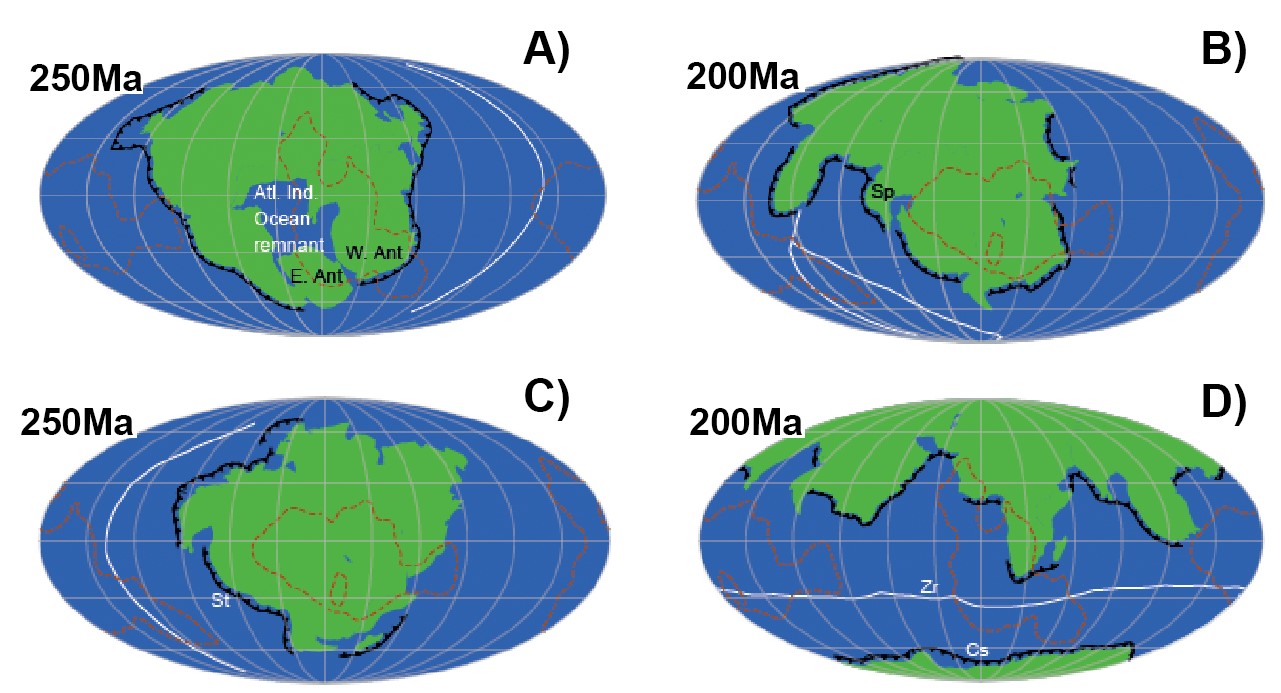

Aspectos hipotéticos del futuro supercontinente global dentro de 200-250 millones de años (Ma). A) Pangea Ultima, B) Novapangea, C) Aurica y D) Amasia. Imágenes modificadas de Davies, H.S., Green, M. y Duarte, J.C. (2018). Back to the future: Testing different scenarios for the next supercontinent gathering. Global and Planetary Change doi: 10.1016/j.gloplacha.2018.07.015Para saber más:

Aspectos hipotéticos del futuro supercontinente global dentro de 200-250 millones de años (Ma). A) Pangea Ultima, B) Novapangea, C) Aurica y D) Amasia. Imágenes modificadas de Davies, H.S., Green, M. y Duarte, J.C. (2018). Back to the future: Testing different scenarios for the next supercontinent gathering. Global and Planetary Change doi: 10.1016/j.gloplacha.2018.07.015Para saber más:

Historia de la tectónica de placas [vídeo breve]

De la tectónica de placas

Sobre la autora: Blanca María Martínez es doctora en geología, investigadora de la Sociedad de Ciencias Aranzadi y colaboradora externa del departamento de Geología de la Facultad de Ciencia y Tecnología de la UPV/EHU

El artículo Y, sin embargo, se mueven se ha escrito en Cuaderno de Cultura Científica.

Dos más dos son cinco

La libertad es poder decir libremente que dos y dos son cuatro. Si se concede esto, todo lo demás vendrá por sus pasos contados.

George Orwell, 1984 (capítulo VII)

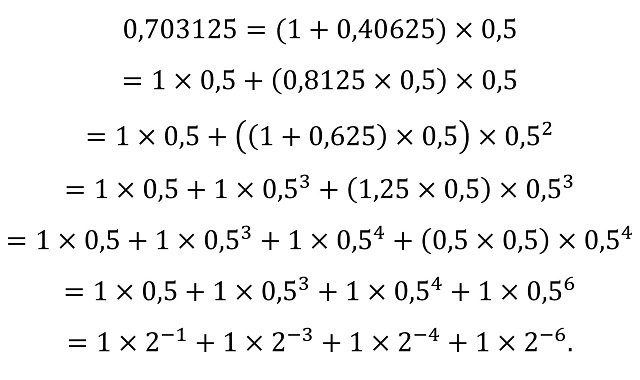

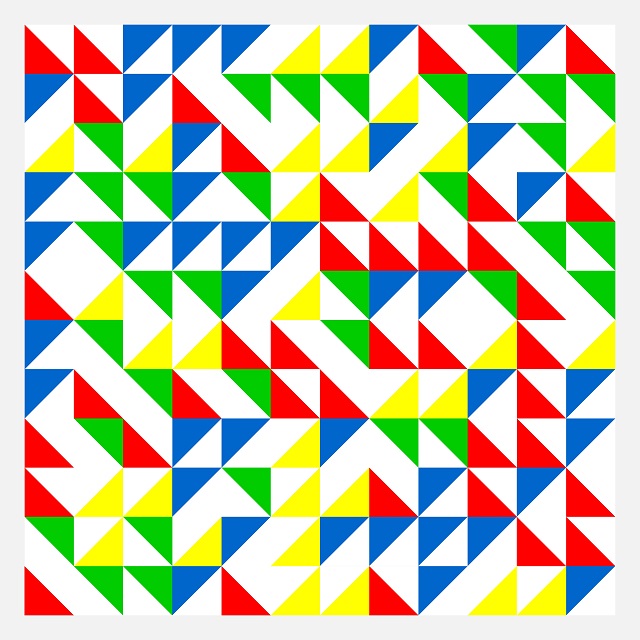

Imagen generada con Powerpoint. Fuente: Marta Macho

Imagen generada con Powerpoint. Fuente: Marta Macho

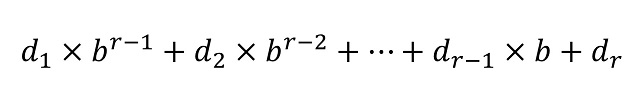

¿Pero dos más dos no han sido siempre cuatro? No necesariamente; ya vimos en la anotación Algunas observaciones someras relativas a las propiedades aerodinámicas de la suma que el resultado de esa suma puede depender de la velocidad del viento…

Bromas aparte, el lógico y filósofo Bertrand Russell (1872-1970) utilizó este enunciado matemático para explicar que es posible llegar a demostrar cualquier propiedad si se comienza con una proposición falsa. Como parte de esta anécdota, se comenta que, con escepticismo, alguien increpó a Russell de este modo:

¿Quiere usted decir que si 2 + 2 = 5, entonces es usted el Papa?

Russell asintió y pasó a demostrar que, efectivamente él era el obispo de Roma:

Supongamos que 2 + 2 = 5. Restemos 3 de cada uno de los miembros de la identidad; obtenemos 1 = 2. Por simple simetría, 1 = 2 implica que 2 = 1. Ahora, dado que el Papa y yo somos dos personas distintas, y dado que 2 = 1, el Papa y yo somos uno. Como resultado de ello, yo soy el Papa.

George Orwell y Radiohead

La banda británica de rock Radiohead lanzó en 2003 el tema «2 + 2 = 5 (The Lukewarm)», aludiendo a la novela 1984 del escritor británico George Orwell (1903-1950):

Cogió el libro de texto infantil y miró el retrato del Gran Hermano que llenaba la portada. Los ojos hipnóticos se clavaron en los suyos. Era como si una inmensa fuerza empezara a aplastarle a uno, algo que iba penetrando en el cráneo, golpeaba el cerebro por dentro, le aterrorizaba a uno y llegaba casi a persuadirle que era de noche cuando era de día. Al final, el Partido anunciaría que dos y dos son cinco y habría que creerlo. Era inevitable que llegara algún día al dos y dos son cinco. La lógica de su posición lo exigía. Su filosofía negaba no sólo la validez de la experiencia, sino que existiera la realidad externa. La mayor de las herejías era el sentido común. Y lo más terrible no era que le mataran a uno por pensar de otro modo, sino que pudieran tener razón. Porque, después de todo, ¿cómo sabemos que dos y dos son efectivamente cuatro? O que la fuerza de la gravedad existe. O que, el pasado no puede ser alterado. ¿Y si el pasado y el mundo exterior sólo existen en nuestra mente y, siendo la mente controlable, también puede controlarse el pasado y lo que llamamos la realidad? […] La libertad es poder decir libremente que dos y dos son cuatro. Si se concede esto, todo lo demás vendrá por sus pasos contados.

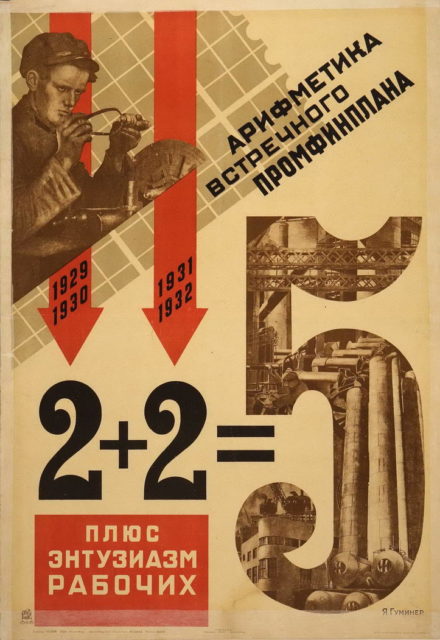

«2 + 2 = 5» es parte de un eslogan comunista que se popularizó en la Unión Soviética y que buscaba “convencer” de que, a través del esfuerzo de las personas asalariadas, el trabajo realizado en dos años (1929 y 1930) y otros dos años más (1931 y 1932) podía llegar a equivaler al trabajo realizado en 5 años.

Cartel de Yakov Guminer (1931) en el que se puede leer «La aritmética de un plan alternativo industrial-financiero: 2 + 2 más el entusiasmo de los trabajadores = 5». Fuente: Wikimedia Commons.

Cartel de Yakov Guminer (1931) en el que se puede leer «La aritmética de un plan alternativo industrial-financiero: 2 + 2 más el entusiasmo de los trabajadores = 5». Fuente: Wikimedia Commons.

George Orwell alteró el significado del eslogan comunista para transformarlo en dogma y aludir a la manipulación del Gran Hermano, el fundador del Partido que todo lo controla de la novela 1984, de tal forma que lo promulgado estuviera por encima de lo verdadero.

La canción «2 + 2 = 5 (The Lukewarm)» comienza con estos versos:

¿Eres tan soñador

como para enderezar al mundo?

Me quedaré para siempre en casa,

donde dos y dos siempre suman cinco.

Antes que George Orwell, en 1895, el periodista y humorista francés Alphonse Allais (1854-1905) ya había utilizado esta expresión. Deux et deux font cinq fue el título que eligió para una colección crónicas absurdas.

Portada de Deux et deux Font cinq de Alphonse Allais. Fuente: Wikimedia Commons.

Portada de Deux et deux Font cinq de Alphonse Allais. Fuente: Wikimedia Commons.

Prueba (o no) de que 2 + 2 = 5

Vamos a demostrar (o no) que 2 + 2 = 5 de una manera sencilla. Sean a = b = 1. Entonces, a = b. Multiplicando ambos miembros de la anterior igualdad por a, se obtiene que a2 = ab. Si restamos b2 en ambos lados, a2 – b2 = ab – b2; de otra manera (a – b)(a + b) = (a – b)b. Dividiendo por (a – b) ambos miembros de la ecuación, se deduce que a + b = b. Y como hemos supuesto que a = b = 1, se deduce que 2 = 1. Sumando 3, queda que 5 = 4 o, de otra manera, 5 = 2 + 2.

Quizás sería conveniente repasar la prueba antes de creérsela. Aunque para aquellas personas que deseen realmente que 2 + 2 sean 5, podríamos limitarnos a “valores grandes de 2”…

Referencias

- 2 + 2 = 5, Wikipedia (consultado el 19 de mayo de 2022)

- 2 + 2 = 5 (canción), Wikipedia (consultado el 19 de mayo de 2022)

- Sobre 2+2=5 en Radiohead, Blog de la Biblioteca de Matemáticas, UCM, 18 enero 2010

- George Orwell, 1984, versión online UCM

- Alphonse Allais, Deux et deux Font cinq, Gallica

- What is meant by «Two plus two equals five”?, Quora, 2019

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad

El artículo Dos más dos son cinco se ha escrito en Cuaderno de Cultura Científica.

Einstein y Erwin Schrödinger

Erwin Schrödinger fue un físico austriaco que ayudó a crear los fundamentos de la mecánica cuántica. Al igual que Einstein, Schrödinger no estuvo de acuerdo con los extremos a los que otros llevaron la nueva ciencia. Fue uno de los pocos científicos que se alinearon con Einstein en contra de los “giros estrafalarios” que estaba adoptando la mecánica cuántica, intentando buscar una teoría unificada que mejorase las teorías que todos los demás apoyaban. Hasta que ocurrió un terrible malentendido.

Schrödinger. Fuente: Wikimedia Commons

Schrödinger. Fuente: Wikimedia CommonsEinstein y Schrödinger trabajaron juntos en los primeros años 30 como profesores del Instituto Kaiser Wilhelm en Berlín. Ambos destacaron en esta institución extremadamente rígida y formal como profesores que trataban a sus alumnos como iguales. Los dos disfrutaban de paseos juntos, a pie y en velero, y llegaron a ser amigos íntimos.

Como muchos de sus contemporáneos, Einstein y Schrödinger comenzaron a escribirse acerca de su trabajo mucho antes de conocerse en persona. En los años veinte toda la comunidad de físicos se concentró en una nueva clase de ciencia que había dado en llamarse mecánica cuántica, ya que estaba basada en la idea de que la luz y la energía no eran flujos continuos, sino que estaba formada por paquetes discretos llamados cuantos. Einstein fue el primero en sugerir que la luz estaba hecha de cuantos, por lo que participó en el desarrollo de la mecánica cuántica desde el principio. Pero este campo estaba empezando a adquirir lo que Einstein y Schrödinger estaban de acuerdo en llamar un giro estrafalario.

Cuanto más y más se aprendía, más parecía que la mecánica cuántica eliminaba las leyes de la causalidad, insistiendo en que los procesos atómicos eran tan aleatorios que no se podía predecir exactamente lo que ocurriría a continuación. En 1925 Werner Heisenberg propuso una nueva clase de matemáticas matriciales que podían usarse para hacer predicciones probabilísticas acerca de cómo un átomo podría comportarse en una situación dada. Este trabajo fue saludado, y con razón, como una gran ayuda para la incipiente teoría, pero también implicaba la idea de que solamente se podían hacer “conjeturas” acerca del comportamiento del átomo.

Al año siguiente, Schrödinger publicó lo que esperaba que fuese una alternativa mejor. Ideó otro conjunto de herramientas matemáticas para que sirvieran de ayuda con la mecánica cuántica, la llamada mecánica ondulatoria. Einstein se alegró mucho con la noticia. Las matemáticas de Schrödinger, haciendo referencia a las cualidades físicas de las ondas como hacían, parecían dar esperanza a la idea de que había una razón física tras las rarezas del comportamiento atómico. Einstein, que estaba muy a disgusto con las probabilidades de Heisenberg, escribió a su amigo Michele Besso en mayo de 1926: “Schrödinger ha aparecido con un par de artículos fantásticos sobre las reglas cuánticas”.

Pero la euforia de Einstein no duraría mucho. Casi inmediatamente, se demostró que las matemáticas de Schrödinger, tan diferentes de las de Heisenberg a primera vista, eran de hecho equivalentes. Schrödinger había venido a confirmar esencialmente la inherente aleatoriedad que otros científicos estaban pidiendo ávidamente. El austriaco estaba tan contrariado por el giro de los acontecimientos como el propio Einstein, llegando a decir que si hubiera sabido lo que sus artículos iban a desencadenar no los habría publicado.

Con todo, la cuestión de si era mejor usar la mecánica matricial de Heisenberg o la ondulatoria de Schrödinger se convirtió en un debate acalorado. Aunque no le gustase la forma en la que otros interpretaban sus matemáticas, Schrödinger entró en la refriega defendiendo su propio trabajo, lo que fastidió a Heisenberg, que escribió a su amigo Wolfgang Pauli diciendo: “Cuanto más pienso en la parte física de la teoría de Schrödinger, más repulsiva la encuentro […] Lo que Schrödinger escribe acerca de la visualizabilidad de su teoría ‘es probablemente no demasiado correcto’, en otras palabras, son chorradas”. [*]

A pesar de su importante contribución a su desarrollo, Schrödinger tuvo reservas sobre la mecánica cuántica toda su vida. En su famoso experimento mental conocido como el gato de Schrödinger, trataba de burlarse de una ciencia que insistía en que nada en el mundo atómico puede conocerse a no ser (y hasta) que se mida. Lo absurdo que le resultaba a Schrödinger pensar que el gato pudiese estar a la vez vivo y muerto le convencía de que la teoría de la mecánica cuántica no era todavía comprendida del todo, la misma posición que mantenía Einstein.

Independientemente de la frustración con la que veían cómo otros científicos se entregaban a los absurdos de la mecánica cuántica, tanto Einstein como Schrödinger sabían que la teoría hacía un fantástico trabajo a la hora de predecir las probabilidades de los acontecimientos atómicos. El trabajo de Schrödinger con la mecánica ondulatoria era una parte crucial de ese éxito, y Einstein fue uno de los que nominaron a Schrödinger al premio Nobel varias veces. Schrödinger ganó el premio de física en 1933.

¿El campo unificado de Schrödinger?Dado que Schrödinger, como Einstein, no creía que la física cuántica estuviese completa, se unió a Einstein en la búsqueda de una nueva teoría. Einstein se refería a ella como la teoría del campo unificado, ya que sería la teoría omnicomprensiva que uniría toda la física. Consecuentemente, en los años 40, cuando Einstein vivía en Princeton y Schrödinger había dejado el odio de Alemania para vivir en Irlanda, Schrödinger era una de las pocas personas con las que Einstein compartía sus ideas. “No envío esto a nadie más”, escribió Einstein en 1946, “ya que tú eres la única persona que conozco que no lleva anteojeras en lo que respecta a las cuestiones fundamentales de nuestra ciencia”.

Pero la colaboración tomó un rumbo inesperado cuando Schrödinger anunció que él había resuelto el problema completamente. Estaba convencido de que había encontrado la teoría del campo unificado gracias al uso de la geometría afín. Anunció sus hallazgos el 27 de enero de 1947, no en una revista científica, sino a bombo y platillo en una rueda de prensa a la que asistió el primer ministro de Irlanda, Éamon de Valera.

Einstein se quedó estupefacto: el trabajo era idéntico a lo que él le había enviado. Si bien Schrödinger se las había ingeniado para hallar una nueva forma de derivarlas, las ecuaciones que había anunciado eran las mismas que Einstein había encontrado y que, a esas alturas, ya había descartado por incompletas. Einstein hizo unas feroces declaraciones al New York Times en las que venía a afirmar que una publicidad exagerada como la de Schrödinger hacían un flaco favor a la ciencia, ya que “el lector tiene la impresión de que cada cinco minutos hay una revolución en la ciencia, algo así como un golpe de estado en alguna de esas pequeñas repúblicas inestables”.

Schrödinger mandó una disculpa a Einstein, intentando explicar como podía haber cometido ese error colosal, pero Einstein no cambió de opinión. Einstein escribió a Schrödinger para decirle que deberían tomarse un descanso en su carteo y concentrarse en sus trabajos. Pasarían tres años (hasta poco antes del fallecimiento de Einstein) antes de que reanudasen su correspondencia.

Nota:[*] Hoy día el más usado es el enfoque de Schrödinger. Tanto es así que un estudiante de química, por ejemplo, puede terminar su grado, e incluso su máster, sin saber siquiera que existe algo que no sea la ecuación de Schrödinger para el tratamiento de los sistemas cuánticos.

Para saber más:Serie de artículos de introducción a los conceptos básicos de la mecánica cuántica, asumiendo conocimientos previos muy elementales: Cuantos

Serie de artículos de introducción a los problemas interpretativos de la mecánica cuántica: Incompletitud y medida en física cuántica

El artículo Einstein y Erwin Schrödinger se ha escrito en Cuaderno de Cultura Científica.

Ingredientes para la receta: El tomate

En tiempo de tomate, no hay mala cocinera.

Dicho popular a orillas del Bidasoa.

Cómo no os queda nada? Ay un puchero,

con chorizo, con baca, y con carnero,

con tozino, que alegra los gaznates,

con su salsa picante de tomates,

ya picadas sus verengenitas,

con sus garbanzos, y sus verduritas,

y para que acabéis unos buñuelos.

Agustín Moreto (1676) en el «Entremés de la Mariquita», tomado de Blanca y Cañizares, 2021.

Foto: Avin CP / Unsplash

Foto: Avin CP / UnsplashHablamos de la planta llamada tomatera y de su fruto el tomate, con nombre científico Solanum lycopersicum. El término de la especie, lycopersicum, se podría traducir por melocotón de lobo. Según leyendas germánicas, brujas y magos utilizaban los frutos de la belladona para convertirse en hombres lobo. La belladona pertenece a la familia Solanacea, como el tomate. Cuando llegó a Europa el tomate, sus frutos recordaban a los de la belladona y, además, sin llegar a madurar eran tóxicos por su contenido en el alcaloide tomatina. Por ello, se conocían como melocotón de lobo. El fruto lleva minerales como potasio, fósforo y magnesio, vitaminas B y C, carotenoides como licopeno y beta-caroteno, y polifenoles, todos ellos componentes ideales para las dietas actuales.

Es el segundo cultivo hortícola más importante después de la patata. En Asia es donde más se siembra, seguido de África, Europa, América y Oceanía.

La flor de la tomatera de la especie original tiene un estilo largo que supera la altura del cono de estambres lo que favorece la fecundación cruzada, con el polen de otra flor, por insectos o el viento. Con el tiempo aparecieron variedades con el estilo corto y autofecundación obligada.

El nombre del tomate deriva de tomatl, en nahuatl, idioma de los antiguos mexicanos. Formaba parte importante de la dieta antes de la llegada de Colón. Y no solo de los mexicanos sino de muchas tribus de América como los sioux, los apaches o de los indígenas peruanos y bolivianos. La referencia más antigua que conocemos sobre el tomate se fecha entre 1335 y 1347 en los Códices de Xocimilco, durante el gobierno de la reina Tlazocilhuapilli, interesada en el ambiente y en la dieta de sus gobernados. Inventó, entre otros platos, el tonalchilli o chile güero en tomate, que lleva chile amarillo, tomate y clavo.

Llegó a Europa con Colón en 1523 y la primera mención se atribuye a Pier Andrea Mattioli, médico y botánico italiano, en 1544, o a Mathiolus en el mismo año (sospecho que son el mismo con el apellido traducido a otro idioma, quizá al latín). Mattioli describía lo que consideraba una nueva berenjena. Recomendaba cocinarlo con sal, pimienta y aceite. En Francia se conocía en 1660 como planta ornamental y hacia 1778 también como hortaliza formando parte de la dieta.

El tomate más antiguo conocido conservado en un herbario es de 1551 y está en Bolonia, Italia, y fue preparado por Ulisse Aldrovandi. Hay otros 17 ejemplares de tomate del siglo XVI en herbarios que se encuentran en Italia, Alemania, Francia, Suiza y Países Bajos. Ocho de los ejemplares tienen frutos.

Ya en 1580, en el Libro Quinto de Plantas Medicinales de Francisco Hernández se menciona el tomate en un texto que publica Pilar Iglesias y que nos ayudará a conocer el tomate, sus variedades y los usos medicinales. Dice así

Aparte de las demás especies de solano de las cuales hablamos al tratar de las plantas de nuestro Viejo Mundo, hay en este otras cuyos frutos, llamados tomatl porque son redondos, están encerrados en una membrana, son de naturaleza seca y fría en primer grado y participan de alguna acidez. Los más grandes de ellos se llaman xitomatl, es decir, tomatl, con forma de calabaza y rugosos; los más chicos, miltomatl, es decir, de siembra, porque se acostumbra sembrarlos al mismo tiempo que el tlaolli o grano indio. Algunos de los primeros son de hermoso aspecto, un poco mayores que nueces, de color verde al principio y después amarillo pálido, y se llaman coatomatl, o sea, de culebra. Otros son de la misma forma y tamaño, pero se vuelven al fin rojos; otros se vuelven de verdes a amarillos y tienen casi el tamaño de la llamada naranja, con uno y otro lado ligeramente comprimidos e irregularmente rugosos desde la parte en que se adhieren al pedúnculo hasta su mitad; otros son rojos cuando han madurado por completo, pasando antes también por el verde, el amarillo pálido y el rojizo, y son casi del mismo tamaño y figura que los anteriores, pero, además de ser rugosos, tienen ciertas protuberancias irregulares que no solo semejan las partes femeninas, sino también hemorroides y cuanto de horrible y obsceno pueda verse en las mujeres. Entre los menores, algunos son del tamaño de nueces y de color verde; otros, llamados izhoatomatl, son mayores que avellanas, aunque menores que las nueces, están encerrados en una membrana a modo de vejiga, de donde les viene el nombre, y pasan del verde al amarillo pálido o al púrpura; los llamados miltomatl son del tamaño de avellanas y del mismo color que los precedentes, así como el coztomatl y el tomatl, que llamamos xalatlacense por el lugar en que se hace, los cuales están llenos de unas semillas como pajitas, y se cuentan principalmente entre los medicamentos dotados de calor. Hay otras especies, de las que hablaremos separadamente, pues tienen nombre propios y especiales naturalezas. Por lo que ve a las antes citadas, todas parecen ser semejantes al solano y aun especies suyas; pero las que dan fruto más grande son también mayores y con hojas aserradas, en tanto que las de fruto menor son más pequeñas. Los farmacéuticos europeos que han conocido algunos de estos frutos los han llamado frutos de amor. En suma, la figura de la planta, las propiedades del fruto, sus membranas y a veces su forma de tal modo corresponden a las especies de solano, que sería necio no convenir con los que clasifican todos los tomates entre las variedades del mismo. Se hace de ellos, molidos y mezclados con chili, una salsa muy agradable que mejora el sabor de casi todas las viandas y alimentos y estimula el apetito. Su naturaleza es fría, seca y algo picante. Tanto las hojas como los frutos son muy eficaces, untados, contra los fuegos de San Antón: curan aplicados las fístulas lagrimales y los dolores de cabeza, alivian los ardores de estómago, y untados con sal resuelven las paperas. Su jugo es bueno contra las inflamaciones de la garganta, y cura las úlceras reptantes mezclado con albayalde, aceite rosado y litargirio. Para las fístulas lagrimales se mezcla con pan; para la irritación de los niños que llaman soriasis, con aceite rosado; se agrega en vez de agua a los colirios, se unta en vez de huevo contra los flujos agudos, y alivia instilado el dolor de oídos. Aplicado en una venda detiene los flujos menstruales excesivos, y mezclado con estiércol de gallina y aplicado en una mecha es un remedio excelente para las fístulas lagrimales. Nacen en cualesquiera regiones, pero principalmente en las cálidas, ya espontáneamente, ya cultivados.

Las primeras recetas con tomates impresas en Europa se publicaron en Nápoles en 1692. El autor era Antonio Latini y una de la recetas era un estofado con codorniz, ternera, pollo y tomate. La segunda receta era una salsa de tomate que llamó al estilo español. Rudolf Grewe la tradujo al inglés y decía así

Toma media docena de tomates que estén maduros, y ponlos a asar en las brasas, y cuando estén chamuscados quítales la piel con diligencia y pícalos finamente con un cuchillo- Agrega tomillo y cebollas, picadas finamente, a discreción y agrega pimientos picantes también picados finamente. Después de mezclar todo junto, ajustarle un poco de sal, aceite y vinagre, es una salsa muy rica, tanto para platos hervidos, como para cualquier otra cosa.

El ancestro silvestre del tomate son pequeñas bayas con semillas que son dispersadas por las aves. Resisten el paso por el tubo digestivo que, además, influye en la capacidad de germinación. Si ayuda el clima y el entorno, se pueden encontrar plantas de tomate en lugares donde no se ha sembrado como cerca de desagües, junto a muros y cercas o en cunetas.

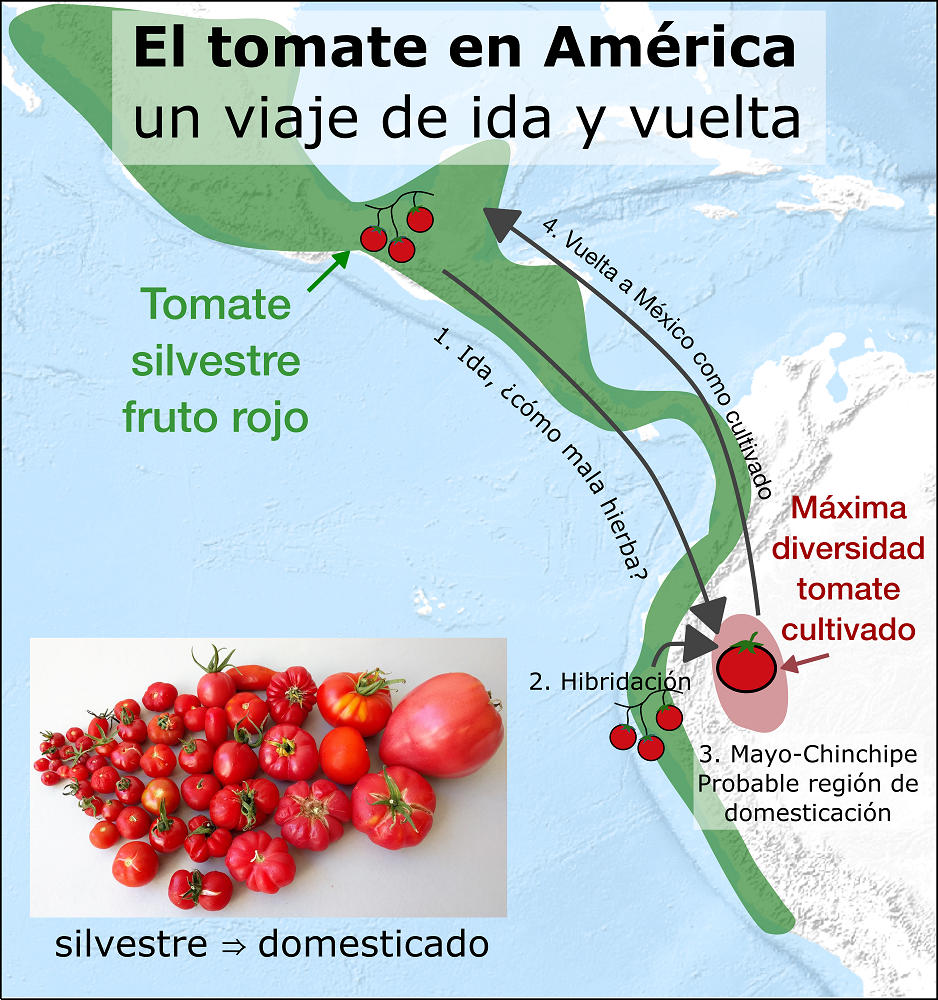

Existe apenas una docena de especies de tomate silvestre pero solo una, Solanum lycopersicum, fue domesticada y, al parecer, solo ocurrió una vez hace unos 2500 años. La especie silvestre es originaria de los Andes en Perú y Ecuador, pero no interesó a los nativos y se extendió, quizá como mala hierba, hacia el norte y fue domesticada en México donde comenzó su cultivo. En el siglo XVI lo cultivaban los mayas. Las variedades que llegaron a Europa se parecen a las cultivadas en México más que a las de la región de los Andes. También fueron los españoles los que llevaron, desde la costa occidental de México, el tomate a Filipinas desde donde se extendió el cultivo por Asia.

En el siglo XVI, Fray Bernardino de Sahagún encontró una gran variedad de tomates en el mercado de Tenochtitlán, y como Francisco Hernández, también lo dejó por escrito

El que trata en tomates suele vender los que son de muchos y diversos géneros … como son los tomates amarillos, colorados y los que están bien maduros. El que es mal tratante en esto vende los que están pudridos y machucados, y los que están azedos. Vende también los que aún no están bien maduros sino muy verdes, y cuando se comen revuelven el estómago, ni dan sabor alguno, sino que provocan las reumas.

Las variedades cultivadas más grandes, como el tomate Corazón de Buey, pueden ser hasta cien veces mayores que las bayas ancestrales. El tamaño va desde la variedad Cherry, de 1-2 centímetros de diámetro, hasta el mencionado Corazón de Buey de más de 10 centímetros. El tamaño comercial mas habitual se de 5-6 centímetros de diámetro.

La selección de variedades de tomate, según cuenta Jonathan Silvertown, con la domesticación original y el transporte de variedades entre diferentes lugares supuso el paso de, por lo menos, tres cuellos de botella genéticos y, en cada uno de ellos, solo un pequeño número de ejemplares consiguió pasar a la siguiente fase.

Los primeros tomates domesticados en México solo contenían una parte de los genes de las poblaciones silvestres. En el siglo XVI, esos tomates domesticados viajaron a Europa. Más tarde, las variedades europeas volvieron a México y solo llevaban el 5% de la dotación genéticas de los tomates silvestres. Pero tenían suficientes posibilidades de variar como permitir selección artificial que se aceleró.

La selección de nuevas variedades se aceleró a partir del siglo XIX y se favoreció por el traslado geográfico por nuestra especie, la disminución de insectos polinizadores y la promoción de variedades autofecundantes.

Las variedades más recientes, conocidas como de larga vida y desarrolladas en primer lugar en Israel a finales de los ochenta y principios de los noventa tienen una duración que permite la cosecha y su envío a mercados lejanos en buen estado de conservación. Sin embargo, en muchas de estas variedades falta el típico aroma del tomate, tan importante para el consumidor.

Los estudios para recuperar y mejorar el aroma han aumentado en el último medio siglo. La revisión de Miriam Distefano y su equipo, de la Universidad de Catania, revela que, en las bases de datos de publicaciones científicas, el número de artículos sobre los componentes volátiles del tomate, es decir, de su aroma, han pasado de 20 en la década de los setenta del siglo pasado, a casi 1000 entre 2011 y 2022. Es una muestra del aumento de interés en conocer mejor el aroma de los tomates.

Son estudios técnicamente difíciles pues en el aroma se han encontrado más de 400 compuestos volátiles. Intervienen muchos genes y el proceso se ve influido por factores externos tanto durante el crecimiento y la maduración del fruto como después de la cosecha en el transporte hasta el consumidor. La revisión de Distefano indica que lo poco que se empieza a conocer se centra, sobre todo, en los factores que actúan durante el crecimiento y después de la cosecha.

El grupo de José Blanca, de la Universidad Politécnica de Valencia, publicó en 2022 el análisis genético de 1254 muestras de variedades de tomate tanto tradicionales como modernas, y algunas de las primeras variedades domesticadas y silvestres.

Las variedades más antiguas tienen escasa variabilidad genética pero, en España e Italia, a donde llegó en primer lugar el tomate desde América, hay dos grupos con una variabilidad alta. En general, hay variedades que muestran un patrón de migraciones, movimientos geográficos debidos a nuestra especie, e hibridaciones muy complejo.

El grupo de Hamid Razifard, de la Universidad de Massachusetts en Amherst, en una publicación en 2020, menciona que la evolución del tomate se acepta muy simplificada, con dos transiciones principales: la primera es desde la especie Solanum pimpinellifolium, pequeña, silvestre y con el fruto del tamaño de un arándano, a un intermedio domesticado, S. lycopersicum var. cerasiforme, que ocurrió en Sudamérica; y la segunda transición desde esta var. cerasiforme al tomate domesticado S. lycopersicum var. lycopersicum, en América Central.

Sin embargo, el estudio por el grupo de Rafizard del genoma de 166 muestras de tomates cultivados en México y semicultivados en América Central revela un proceso más complejo. Por ejemplo, la var. cerasiforme apareció en Ecuador hace 80000 años como especie salvaje. Fue cultivada en Perú y Ecuador con frutos de tamaño mediano. Y, según los autores, se expendió hacia el norte por América Central hasta México como mala hierba acompañando a otros cultivos.

El debate continúa pues un fruto con muchas formas, colores, tamaños y sabores. El grupo de Michael Alonge, de la Universidad Johns Hopkins, analizó el genoma de 100 variedades y encontró nada menos que 238490 variaciones. Con combinaciones múltiples de estas variantes se modifica el aroma, el tamaño y la producción de frutos. Por ejemplo, encontraron un gen que da sabor ahumado al tomate y consiguieron cambiar su tamaño. En un último ensayo de diferentes combinaciones facilitaron la recolección sin disminuir la cosecha.

Hipótesis sobre la domesticación del tomateLa revisión más reciente de la domesticación del tomate la han propuesto José Blanca y sus colegas. Analizan 628 secuencias, incluyendo las publicadas en seis estudios previos. Como en el estudio de Hamid Razifard parten de las tres especies y variedades implicadas, es decir, de Solanum pimpinellifolium, Solanum lycopersicum cerasiforme y Solanum lycopersicum lycopersicum.

Mencionan tres hipótesis: la de José Blanca y colegas publicada en 2012; la ya comentada de Hamid Razifard; y la que proponen en esta revisión de 2022.

Las dos primeras proponen el movimiento de especies y variedades desde Perú y Ecuador hacia el norte, a México a través de Centroamérica. En la primera hipótesis solo llega la variedad cerasiforme a México, y en la segunda llega una cerasiforme de pequeño tamaño, y ambas, en México evolucionan a la variedad domesticada. En la hipótesis de 2022, José Blanca propone el paso hacia el norte, la vuelta a Sudamérica, con aumento de tamaño, y el regreso hacia el norte para llegar a la lycopersicum domesticada.

Fuente: Blanca & Cañizares (2022) The Conversation

Fuente: Blanca & Cañizares (2022) The ConversationPara celebrar lo que sabemos del tomate no hay nada mejor que degustarlo y, propongo, una receta de la Cocina para pobres de Alfredo Juderías. Este es el Pisto Carretillero que ilustra el refrán popular que dice que “Tomates y pimientos, siempre amigos y siempre revueltos”.

Echar en una sartén a la lumbre con aceite unos pimientos verdes partidos en dados. Cuando estén a medio freír agregar un calabacín y unos tomates algo escaldados y pelados y troceados. Cocer lentamente hasta que el agua del calabacín y del tomate se haya consumido. Espolvorear con sal, un pelín de azúcar si se quiere, algo de pimienta y que aproveche.

Y si queremos conservar los tomates podemos seguir a Juan de Altamiras y la edición de 1767 de su libro Nuevo Arte de la Cocina Española. El autor era fraile franciscano, aragonés de nacimiento, y cocinero del Convento de San Cristóbal, hoy en ruinas, junto a Tauste, en Zaragoza. La receta nos la ofrece Vicky Hayward en su libro publicado en 2017.

Una vez maduros los tomates, Fray Juan escribe que

Quando estén medio crudos, echalos en aceyte frío, y los mantendrás todo el año, como si se cogieran entonces de la mata; pero los has de coger antes de salir el Sol; y el aceyte sirve para cualquier cosa.

Así Fray Juan, como dice, tiene tomates para todo el año.

Como curiosidad y para estar al día en el gusto de los consumidores, hay que mencionar una de las variantes de salsa de tomate más conocidas y utilizadas es el kétchup que, según el Diccionario, está condimentada con vinagre, azúcar y especias. Es de origen chino y la comercializó en Estados Unidos Henry Heinz en 1878. Lleva tomate, agua, azúcar, vinagre, fécula, sal, especias, conservantes y acidulantes.

Referencias:Alonge, M. et al. 2020. Major impacts of widespread structural variation on gene expression and crop improvement in tomato. Cell 182: 145-161.

Bai, Y. & P. Lindhout. 2007. Domestication and breeding of tomatoes: What have we gained and what can we gain in the future? Annals of Botany 100: 1085-1094.

Barath, H. 2020. Las numerosas mutaciones del tomate. Investigación y Ciencia octubre: 7.

Blanca, J. et al. 2012. Variation revealed by SNP genotyping and morphology provides insight into the origin of the tomato. PLOS One 7: e48198.

Blanca, J. et al. 2022. Haplotype analyses reveal novel insights into tomato history and domestication driven by long-distance migrations and latitudinal adaptations. Horticulture Research 9: uhac030.

Blanca, J. et al. 2022. European traditional tomatoes galore: a result of farmers’ selection of a few diversity-rich loci. Journal of Experimental Botany doi: 10.1093/jxb/erac072.

Blanca, J. & J. Cañizares. 2021. El tomate no es natural, es un tesoro creado por el ingenio humano. El País 3 diciembre.

Blanca, J. & J. Cañizares. 2022. La domesticación del tomate en América: un viaje de ida y vuelta. The Conversation 28 febrero.

Distefano, M. et al. 2022. Aroma volatiles in tomato fruits: the role of genetic, preharvest and postharvest factors. Agronomy 12: 376.

Grewe, R. 1988. The arrival of the tomato in Spain and Italy: Early recipes. Journal of Gastronomy 3: 67-81.

Hayward, V. 2017. Nuevo Arte de la Cocina Española de Juan Altamiras. Círculo de Lectores. Barcelona. 493 pp.

Iglesias, P. 1988. El libro del tomate. Alianza Ed. Madrid. 143 pp.

Juderías, A. 1994. Cocina para pobres. Undécima edición. Ed. SETECO. Madrid.325 pp.

Razifard, H. et al. 2020. Genomic evidence for complex domestication history of the cultivated tomato in Latin America. Molecular Biology and Evolution 37: 1118-1132.

Sahagún, Fray Bernardino de. 1830 (1677). Historia natural de las cosas de Nueva España. Biblioteca Laurenciana. Florencia.

van Andel, T. et al. 2022. Sixteenth-century tomatoes in Europe: who saw them, what they looked like, and where they come from.PeerJ 10: e12790.

Vergani Guralazzi, R. 1997. Lycopersicum esculentum: Una breve historia del tomate. Alquibia 3: 105-111.

Wikipedia. 2022. Kétchup. 16 febrero.

Wikipedia. 2022. Solanum lycopersicum. 7 marzo.

Para saber másUn espectrómetro Raman portátil mide el punto óptimo de maduración del tomate

La contaminación por metales pesados no llega a los tomates

Así es la química de una buena pizza

Sobre el autor: Eduardo Angulo es doctor en biología, profesor de biología celular de la UPV/EHU retirado y divulgador científico. Ha publicado varios libros y es autor de La biología estupenda.

El artículo Ingredientes para la receta: El tomate se ha escrito en Cuaderno de Cultura Científica.

Tú no sabes por qué sale cara, pero la moneda sí

Javier Fernández Panadero

Foto: ZSun Fu / Unsplash

Foto: ZSun Fu / Unsplash

El uso y la costumbre nos hace olvidar que el mundo es muy diferente a lo que de primeras pudiera parecer, así cómo qué herramientas hemos elegido para (intentar) entenderlo. En la aproximación científica al conocimiento intentamos ser empíricos. Nuestro criterio para evaluar la verdad de una proposición es su acuerdo con las observaciones del mundo natural, más allá de opiniones, teorías, gurús o tradiciones. Construimos modelos que serían capaces de explicar los hechos observados, intentando que sean lo más sencillos posibles (navaja de Ockham) y expliquen cuántas más cosas, mejor. Repito, modelos.

Modelos simples, pero sin pasarseAlgunos muy exitosos, son asombrosamente “falsos” por simplificados. Te pondré un ejemplo, el gas ideal. Este modelo considera que los átomos o moléculas que forman el gas son puntuales (de tamaño cero) y que no interaccionan entre ellos. Estas obvias falsedades son tan aproximadamente ciertas para muchas situaciones que es un modelo que funciona estupendamente. Piensa que, debido a su simplicidad, las ecuaciones que se derivan son también sencillas y manejables. ¿Eso significa que existe ese gas? ¿Cómo puede ser que las moléculas ocupen un volumen cero? No, no existe. Es un modelo que aproxima la realidad con precisión suficiente para nuestras aplicaciones. Fin.

Estas ideas suelen estar bastante claras. Lo llamativo es que a veces olvidemos que con el azar pasa algo parecido. Me explicaré.

El comportamiento de una moneda no ES azaroso. La moneda es un objeto que sigue obediente las leyes de Newton del movimiento, las ecuaciones del sólido rígido, experimenta la gravedad, la reacción de la mesa, el movimiento del aire circundante… Podemos plantear las ecuaciones correspondientes e intentar derivar soluciones. El problema es que nos encontraremos con que resulta muy difícil predecir el comportamiento por la gran influencia de pequeñas variaciones en los futuros posibles.

En cambio, si analizamos los resultados de múltiples lanzamientos veremos que se PARECE mucho al que se obtendría de un sistema que, al azar, pudiera dar dos valores de salida. De hecho, haciendo un poco de estadística podríamos incluso modelizar monedas asimétricas con probabilidades distintas del 50% entre sus dos posibilidades. Por lo tanto, decir que una moneda es un sistema que devuelve al azar un valor de dos posibles es un excelente MODELO, no que estemos diciendo que sale cara porque existe un proceso necesariamente aleatorio en su comportamiento esencial. Volviendo al título. La moneda “siente” la gravedad, la reacción de la mesa, SABE muy bien quien la ha empujado en qué dirección y por qué cae como cae… eres tú el que no lo sabe y no podría saberlo.

Si piensas en una molécula que se mueve en un líquido de nuevo sabe muy bien con quién se ha chocado o con qué pared y por qué lleva la velocidad que lleva. Ella sí. Nosotros, no. Por eso hacemos mecánica estadística con estupendos resultados. Pensemos, si quieres, en la salida de una boca del metro en hora punta vista desde arriba. Se parece mucho a un líquido que se desborda y probablemente responda estupendamente a ese modelo. ¿Significa eso que cada persona que sale no sepa donde va y por qué? No, significa que nos resulta difícil hacer esa cuenta y que un modelo más simple explica suficientemente el comportamiento observado.

Y ahora, dejadme que me pare un momento sobre estas dos frases:

“El comportamiento de una moneda no ES azaroso.”

“(…) se PARECE mucho al que se obtendría de un sistema que, al azar, pudiera dar dos valores (…)”

En un esquema de pensamiento empírico, donde sabemos de las cosas por cómo se presentan a los sentidos, ¿cuál es la diferencia entre SER y PARECER?

Cuando solo tratamos con EFECTOS, ¿cómo podemos distinguir entre algo que PARECE todo el tiempo de una manera y algo que lo FUERA?

No podemos. Son indistinguibles. Desde el conocimiento empírico accedemos a la “esencia” de las cosas por sus efectos en el mundo observable.

Otra cosa sería un objeto que se comporta casi siempre de una manera, pero en situaciones especiales lo hace de otra. Ahí podría distinguirlos… pero sería de nuevo por los efectos, por esos comportamientos excepcionales.

Por lo tanto, clásicamente el comportamiento azaroso es un modelo más, aproximado, no una característica esencial de los sistemas.

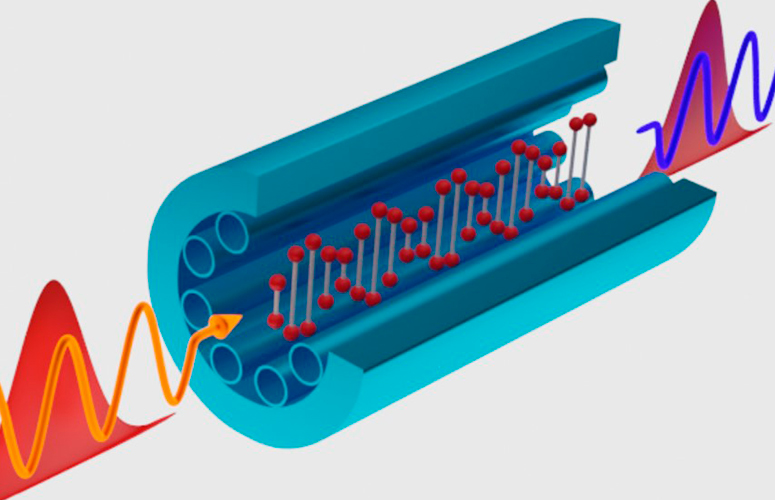

¿Es el mundo cuántico esencialmente azaroso?

Veamos…

Por un lado, la cuántica es un modelo más de la naturaleza, aproximado, y que trata de explicar los comportamientos y los efectos que percibimos. Ahí adolecería también de la renuncia a una explicación esencialista como en los modelos clásicos.

De hecho, la evolución de los sistemas cuánticos es determinista, lo que significa que dado un estado del sistema podemos saber su evolución futura. Otra cosa diferente es que el estado de un sistema no tenga “detalladas” todas sus propiedades o que no sean “accesibles”.

Estamos familiarizados con esa versión del principio de incertidumbre de Heisenberg donde el hecho de conocer con más precisión la posición nos añade incertidumbre en el momento lineal y viceversa. Así que, habrá cosas imposibles de saber (una “trayectoria”, por ejemplo. Se convierten en “nube de probabilidad”) o cosas que no podrán saberse a la vez con tanta precisión como se quiera.

También podríamos pensar en estados cuánticos que no tienen un valor definido para un observable (una “magnitud”). Por ejemplo, un electrón cuyo spin en un eje sea una combinación lineal de “arriba” y “abajo”, dos partículas entrelazadas*, etc.

¿Cómo o quién decide el valor concreto que saldrá cuando se produzca una medida?

Cuando mida el espín de ese electrón, ¿qué hará que dé ½ o -½ en la medida de cada partícula concreta?

En las partículas entrelazadas, ¿por qué al medir una me sale un valor y no el opuesto? ¿Existe un mecanismo microscópico no percibido (similar a lo que le pasaba a la moneda) o es un proceso esencialmente aleatorio?

La mejor respuesta que puedo daros es que la pregunta no tiene sentido… y que no importa, en tanto que los resultados son indistinguibles y nosotros somos empiristas.

Quizá a alguno les suene la Teoría de Variables Ocultas donde se pretendía que había variables que no estábamos midiendo y que marcaban los resultados que podíamos apreciar.

Los científicos se pusieron a idear experimentos en los que una teoría y la interpretación más habitual de la cuántica arrojaran resultados distintos. Porque esa es la única manera desde el empirismo. Los científicos siguen el mandato bíblico Por sus obras los conoceréis.

Finalmente consiguieron idearlos y llevarlos a cabo. Con ello probaron que la Teoría de Variables Ocultas, tal y como se planteaba, era incompatible con los experimentos. Así que ahora queda la disyuntiva: ¿Es la naturaleza cuántica esencialmente azarosa o muestra un comportamiento que puede modelizarse bien por el azar? Pero, como os digo, la respuesta a eso es que desde el empirismo no tiene demasiado sentido la pregunta.

Concluimos, por lo tanto, que las matemáticas son una sorprendentemente buena manera de modelizar el mundo que percibimos de forma aproximada, y que las descripciones que incluyen el azar y lo probabilístico son solo otras herramientas matemáticas a nuestra disposición. Y, aunque suponga cierta insatisfacción filosófica, recordamos que el empirismo renuncia a conocer la esencia de las cosas más que por sus comportamientos, diluyendo así la diferencia entre SER y PARECER.

Nota:

*Entrelazamiento cuántico. Curioso fenómeno, sin análogo clásico, donde dos sistemas tienen una propiedad cuyo valor en uno y otro están “ligados”. Por ejemplo, dos electrones con valor de spin en un eje igual a cero, de forma que uno tendrá un valor ½ y el otro -½, pero no está fijado cuál tiene cuál. Si preparas muchos estados así, al medir en uno te saldrá un valor y en el otro se concretará el valor contrario, y viceversa.

Para saber más:

Serie de artículos de introducción a los conceptos básicos mencionados en el texto, asumiendo conocimientos previos muy elementales: Cuantos

Serie de artículos de introducción a los problemas interpretativos de la mecánica cuántica: Incompletitud y medida en física cuántica

Sobre el autor: Javier Fernández Panadero es físico y profesor de secundaria, además de un prolífico autor de libros de divulgación científica.

El artículo Tú no sabes por qué sale cara, pero la moneda sí se ha escrito en Cuaderno de Cultura Científica.

IV Jornada Nacional de Evolución y Neurociencias: Julio Sanjuán – El mono creativo: sueños, alucinanciones y locura

¿Estamos realmente diseñados para conectar con los demás? Si es así, ¿por qué siguen existiendo los psicópatas? ¿Se pueden tratar trastornos delirantes como la paranoia desde el punto de vista de la evolución? O ¿cómo ha cambiado la atracción sexual desde la época de nuestros ‘abuelos’ homínidos hasta ahora?

A estas y otras cuestiones relativas a la evolución del comportamiento humano se trató de dar respuesta durante la IV Jornada Nacional de Evolución y Neurociencias, evento organizado por la Cátedra de Cultura Científica de la UPV/EHU y la Red de Salud Mental de Bizkaia, que tuvo lugar los días 28 y 29 de abril en el Bizkaia Aretoa – UPV/EHU de Bilbao.

Desde que en 2017 un grupo de psiquiatras de la Red de Salud Mental de Bizkaia organizara la primera edición de esta jornada, la cita se ha convertido en un punto de encuentro para profesionales de distintos ámbitos científicos como la psiquiatría, la psicología, la biología o la filosofía con un interés común: la conducta humana desde una perspectiva evolucionista y su divulgación científica en un formato accesible y ameno para todos los públicos, a la par que riguroso y actualizado.

La evolución no nos ha hecho perfectos del todo. Nuestro encéfalo a veces no compila o computa como se espera de él. Nos lo explica Julio Sanjuán, profesor de psiquiatría en la Facultad de Medicina de la Universidad de Valencia.

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus