Historia del radio terrestre

El filósofo y matemático griego Tales de Mileto creía que la Tierra era un disco flotando en un mar de agua. Para su discípulo Anaximandro la Tierra era un cilindro, con la ecúmene (el mundo habitado) en una de sus tapas planas. Sin embargo, los antiguos griegos terminaron descubriendo que la Tierra tiene forma esférica. Una vez conocida la forma del planeta el siguiente paso fue saber cuál era el tamaño de nuestro planeta y para ello los griegos realizaron algunas estimaciones, utilizando la geometría, del perímetro terrestre. La medición griega más famosa, y certera, del perímetro de la Tierra se debe al polímata griego Eratóstenes de Cirene. Pero fue el astrónomo persa Al-Biruni quien desarrolló un método más preciso aplicando ecuaciones trigonométricas al ángulo formado entre el pico de una montaña y un plano situado a sus pies. De esa manera calculó que el radio terrestre media 6339.9 km, 17 km menos de lo que en realidad tiene.

Los vídeos de Historias de la Ciencia presentan de forma breve y amena pasajes de la nuestra historia científica y tecnológica. Los vídeos, realizados para la Cátedra de Cultura Científica de la UPV/EHU, se estrenan en el programa de ciencia Órbita Laika (@orbitalaika_tve), los lunes a las 22:00 en la 2 de RTVE.

El artículo Historia del radio terrestre se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:El neutrino

Durante la toma de esta fotografía de un eclipse total de sol, los neutrinos procedentes del Sol atravesaron la Luna, la cámara, la fotógrafa y el planeta sobre el que esta estaba sin inmutarse. Foto: karen kayser / Unsplash

Durante la toma de esta fotografía de un eclipse total de sol, los neutrinos procedentes del Sol atravesaron la Luna, la cámara, la fotógrafa y el planeta sobre el que esta estaba sin inmutarse. Foto: karen kayser / UnsplashLa descripción de la desintegración beta en términos de la transformación de un neutrón en el núcleo es parte de una de las historias más fascinantes de la física moderna: la predicción y el eventual descubrimiento de las partículas llamadas neutrino y antineutrino.

Los estudios cuantitativos de las relaciones energéticas en la desintegración beta durante las décadas de 1920 y 1930 plantearon una cuestión difícil y seria. Se idearon métodos para determinar el cambio de energía en un núcleo durante la desintegración beta. Según el principio de conservación de la energía, la energía perdida por el núcleo debe ser igual a la energía transportada por la partícula beta; pero las energías cinéticas medidas de las partículas beta tenían una amplia gama de valores medidos, todos menores que la cantidad de energía perdida por el núcleo. Es decir, parte de la energía perdida por el núcleo parecía haber desaparecido.

Las mediciones realizadas en una gran cantidad de emisores beta indicaron que, en promedio, aproximadamente dos tercios de la energía perdida por los núcleos con desintegración beta parecían desaparecer. Los intentos de encontrar experimentalmente la energía que faltaba fallaron. Por ejemplo, se pensó que esta energía podría ser transportada por rayos gamma; pero estos rayos gamma no se pudieron detectar experimentalmente. El principio de conservación de la energía parecía violarse en la desintegración beta. Se encontraron discrepancias similares en las mediciones del momento del electrón emitido y el núcleo desplazado.

Como en el caso de los experimentos que llevaron al descubrimiento del neutrón, la comunidad física se esforzó mucho en encontrar una alternativa a la posibilidad de aceptar un fracaso de los principios de conservación de la energía y el momento. Estas y otras consideraciones relacionadas llevaron a Wolfgang Pauli a sugerir que otra partícula, que hasta ese momento había pasado inadvertida, se emite en la desintegración beta junto con el electrón, y que esta partícula es la que porta la energía y el momento que faltan.

Esta partícula hipotética no podía tener carga eléctrica, porque la carga positiva del protón y la carga negativa de la partícula beta juntas son iguales a la carga cero del neutrón original. El balance masa-energía en la desintegración del neutrón apuntaba a que la masa en reposo de la partícula de Pauli debería ser muy pequeña, mucho más pequeña que la masa de un electrón y posiblemente incluso cero. La combinación de carga eléctrica cero y masa cero o casi cero haría que la partícula fuera extremadamente difícil de detectar.

Enrico Fermi llamó a esta partícula hipotética neutrino [1]. Fermi construyó un modelo de la desintegración beta basado en la sugerencia de Pauli, en el que un neutrón se desintegra en un protón, un electrón y un neutrino, aquí representado por la letra griega nu (ν):

![]()

Este modelo describía adecuadamente los hechos conocidos de la desintegración beta. A partir de 1934, mientras la difícil búsqueda de su verificación experimental aún estaba en curso, el neutrino fue aceptado como una partícula «real» por dos razones, ambas teóricas [2]: salvaba el principio de conservación de la energía en la desintegración, y podía ser utilizado con éxito tanto para describir el resultado de los experimentos de desintegración beta como para predecir los resultados de nuevos experimentos.

Se hicieron muchos intentos infructuosos para detectar neutrinos durante 25 años. Finalmente, en 1956, se detectaron neutrinos en un experimento utilizando el flujo extremadamente grande de neutrinos que sale de un reactor nuclear. La detección de neutrinos es un proceso indirecto que consiste en detectar los productos de una reacción provocada por un neutrino. La reacción utilizada fue una desintegración beta inversa, la producción de un neutrón a partir de un protón. Debido a que el encuentro apropiado de un protón, un electrón y un neutrino en el mismo lugar y al mismo tiempo es un evento extremadamente improbable [3] y el neutrón resultante es difícil de detectar, «atrapar» los neutrinos requerió de una trampa muy elaborada y sensible. Una vez más, la fe en el principio de conservación de la energía se había justificado.

Notas:

[1] En castellano el diminutivo de neutro sería neutrito, en italiano de neutro, neutrino.

[2] En abierta contradicción con los que hablan de “el método científico” como algo único, lo identifican con el método hipotético-deductivo y hacen de la falsación el centro del mismo. La ciencia se basa en actitudes científicas, lo que implica el uso de los métodos que sean menester en cada caso, como este. Véase a este respecto nuestra serie La tesis de Duhem-Quine.

[3] Tanto es así que los neutrinos pueden atravesar toda la Tierra sin alterarse lo más mínimo. De hecho, ahora mismo tu cuerpo está siendo atravesado por neutrinos sin que produzcan efecto alguno.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo El neutrino se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:La vacuna de la covid-19, una proeza científica

Es 27 de diciembre de 2020 y acabo de firmar, como su responsable legal, el consentimiento para que le sea administrada a mi padre la vacuna de la covid-19. Ese acto mínimo es el requisito para que culmine, en la persona de un anciano de 86 años interno en una residencia, un proceso que comenzó hace casi un año y que, sin temor a exagerar, puede ser considerado una verdadera proeza científica, muy probablemente la mayor proeza científica de la historia.

Foto: Daniel Schludi / Unsplash

Foto: Daniel Schludi / UnsplashNo se ha alcanzado aún la meta final. Queda por delante un camino largo lleno de amenazas. Son miles de millones las personas que han de ser vacunadas, y pueden surgir dificultades aún. Hay quienes, por diferentes razones, prefieren no vacunarse o esperar. No sabemos aún cuál será el alcance de la vacunación, cuándo llegará hasta los últimos rincones del planeta. No sabemos cuánto tiempo hara falta para producir los miles de millones de dosis que serán necesarias, ni cuántos los miles de personas que morirán o enfermarán gravemente pocos días o semanas antes de poder recibir la vacuna. Desconocemos si las variantes genéticas del SARS-CoV-2 que surjan le conferirán defensas frente a las vacunas que se administren. También ignoramos si las vacunas, además de proteger a quienes la reciben, impedirán que puedan contagiar a otros. Y, por último, no sabemos si tendrán efectos secundarios de alguna consideración cuando se vacune a millones de personas. Pero ninguna de esas amenazas, por reales que sean, pueden empañar el logro que supone la vacunación, con las máximas garantías que se pueden ofrecer, de millones de personas en los primeros meses de 2021, un año después del comienzo de la peor pandemia a que se ha enfrentado la humanidad en un siglo.

Por dimensiones, que no por su carácter u objetivos, podemos citar dos antecedentes de esta empresa. El primero es el proyecto Manhattan. Permitió a los norteamericanos disponer, en pocos años, de la bomba atómica. Durante su desarrollo (1942-1947) llegó a involucrar a 130 000 personas y se le dedicó el equivalente a 70 000 millones de dólares actuales, aunque solo el 10% de esa cantidad se destinó al desarrollo y producción de armamento. El segundo, más tecnológico que científico, fue el programa Apolo, gracias al cuál en seis ocasiones seres humanos pisaron la superficie lunar. El programa se prolongó durante más de una década (1961-1972) y conllevó una inversión de 170 000 millones de dólares.

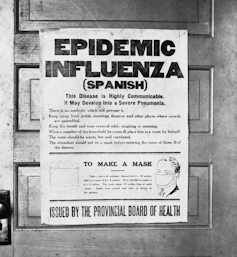

La historia, breve, de la vacuna de la covid-19 empezó el 31 de diciembre de 2019, cuando se informó de 27 casos de una neumonía desconocida en Wuhan (China). El 8 de enero siguiente se supo que el causante era un nuevo coronavirus. Dos días después ya se había hecho pública su secuencia genómica. En febrero se pusieron en marcha varios proyectos de vacunas. En China, las primeras fueron CanSino Biologics, Sinovac Biotech y la estatal Sinopharm; en los Estados Unidos, Moderna e Inovio Pharmaceuticals; en Europa, BioNTech, una empresa biotecnológica alemana desarrolló una candidata que más adelante compartiría con Pfizer; un grupo de la Universidad de Oxford creó una vacuna al que se sumó AstraZeneca; Janssen y Sanofi Pasteur también lanzaron sus propios proyectos.

A mediados de abril supimos que la vacuna de SinoVac Biotech era eficaz con monos. El 20 de ese mismo mes, cinco empresas ya testaban su vacunas en ensayos clínicos, y había más de 70 candidatas en desarrollo preclínico. A finales de julio, las vacunas de Moderna y de Pfizer-BioNTech, ambas basadas en ARN mensajero, empezaron los ensayos de eficacia. Los proyectos chinos, paradójicamente, perdieron la delantera debido al éxito con el que se contuvo la pandemia en aquel país, lo que obligó a reclutar voluntarios en otros.

Durante el mes de noviembre, se anunció que unas pocas vacunas de la covid-19 tenían una eficacia superior al 90%. Todos los plazos, desde la aparición de los casos de neumonía en diciembre de 2019 hasta las autorizaciones en diciembre de 2020, por las agencias reguladoras, de las vacunas, han sido los más cortos, con gran diferencia, que haya habido nunca.

Desde que se anunció el brote de la enfermedad miles de científicos, biomédicos y de otras áreas, de todo el mundo se pusieron a investigar en temas relativos a la covid-19, compartiendo información en un grado nunca visto. La cooperación se ha producido, en su mayor parte, haciendo uso de redes informales, sin necesidad de que mediasen acuerdos formales entre países o instituciones.

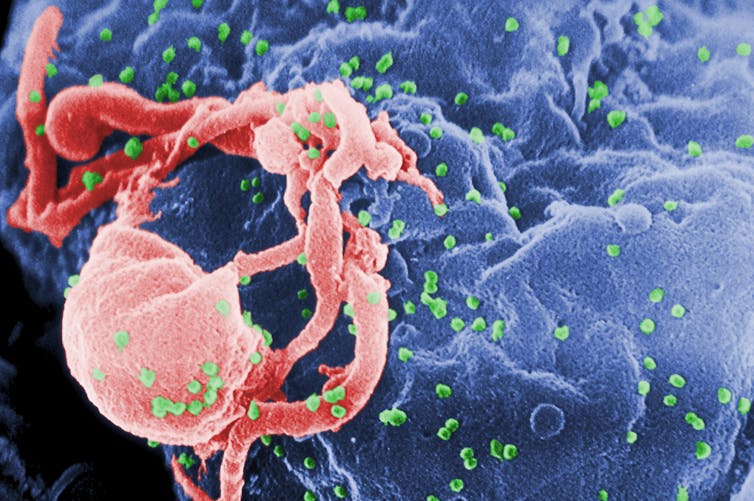

Ultraestructura de un coronavirus. Imagen: CDC / Unsplash

Ultraestructura de un coronavirus. Imagen: CDC / UnsplashLos resultados de esa actividad investigadora se han plasmado en la publicación, hasta primeros de diciembre, de 84 180 artículos científicos relacionados con la covid-19 (a razón de 260 diarios). Para dotar a esa cifra del significado que merece, hagamos una comparación: el número total de los publicados desde que existen las revistas científicas sobre el cáncer de pulmón es, aproximadamente, de 350 000; de sida-VIH, 165 000; de gripe, 135 000; y de malaria, 100 000. En tan solo once meses se ha publicado un volumen de artículos sobre covid-19 equivalente a casi el 60% de todos los publicados sobre la gripe.

El número de firmantes (autores únicos) de los artículos sobre la covid-19 asciende a 322 279, cifra que triplica en tan solo 11 meses la correspondiente al proyecto Manhattan al cabo de cinco años. Si nos limitamos a quienes han intervenido en el desarrollo de las vacunas y puesto que en este momento hay 162 candidatas (de las que 52 se encuentran en ensayos clínicos), una estimación conservadora arroja un número de 65 000 participantes (personal científico y sanitario) en todo el mundo, lo que equivale a la mitad de todo el personal involucrado en el proyecto Manhattan.

El esfuerzo económico también ha sido enorme. Solo la administración norteamericana ha destinado más de 10 000 millones de dólares a las compañías farmacéuticas para el diseño y producción de vacunas. Si a esa cantidad sumásemos los recursos invertidos por China, Japón, Rusia, Reino Unido y la Unión Europea, la cantidad total se aproximaría quizás a la inversión realizada en el proyecto Manhattan, aunque solo el 10% de aquél se destinase a diseño y producción de armamento.

Además de las inversiones económicas y la dedicación de centenares de miles de personas, la vacuna para el SARS-CoV-2 se ha beneficiado de algunas circunstancias favorables que resumo a continuación. La investigación de hace unos años para el desarrollo de las vacunas contra el SARS-CoV-1 y el MERS-CoV ha permitido omitir pasos preliminares. Los ensayos de fase I y II se iniciaron de forma casi simultánea adaptando procedimientos ya existentes. Los de fase III comenzaron después del análisis intermedio de los resultados de las anteriores, cubriendo etapas de ensayos clínicos en paralelo. Varias vacunas se empezaron a producir a gran escala, asumiendo el riesgo de que finalmente no resultasen efectivas y se perdiese la inversión. Y las agencias públicas de medicamentos, mientras tanto, han ido haciendo una evaluación continua de estas vacunas para contar con todas las garantías de eficacia y seguridad.

Una conjunción extraordinaria de factores ha permitido que esta empresa científica cursase a una velocidad asombrosa. Nunca se habían desarrollado a la vez tantas vacunas contra un mismo patógeno. Nunca tantas personas se habían involucrado en un gran proyecto científico en tan poco tiempo. Nunca se había alcanzado un grado tal de colaboración, incluso entre competidores. Nunca se habían desarrollado tantos ensayos clínicos a la vez para probar la eficacia de tantas vacunas. Y nunca antes se habían destinado tantos recursos y tanta inteligencia a combatir una enfermedad en tan corto espacio de tiempo.

Sin ese esfuerzo tan grande no se habría llegado a la situación en que nos encontramos hoy. Y sin embargo, tal esfuerzo no era, por sí solo, garantía de éxito. En 1971, el entonces presidente de los Estados Unidos, Richard Nixon, firmó la denominada National Cancer Act, una ley mediante la que se proponía acabar con el cáncer y destinó a ese objetivo el equivalente a unos 10 000 millones de dólares actuales. Han pasado 50 años desde entonces.

La razón por la que la denominada ‘guerra contra el cáncer’ de Nixon se quedó muy lejos de cumplir sus objetivos es que había aspectos fundamentales de la biología de las células cancerosas que se desconocían aún. No había ocurrido lo mismo con el ‘proyecto Manhattan’ o con el ‘programa Apolo’, porque en ambos casos se contaba con el conocimiento básico necesario para abordarlos.

Ese mismo factor, la ciencia básica, ha resultado clave en el desarrollo de la vacuna de la covid-19. Desde que en 1953 se desvelase la estructura del ADN, un volumen ingente de investigación ha permitido conocer la estructura y comportamiento de los virus, desentrañar el funcionamiento del sistema inmunitario humano, y desarrollar poderosas técnicas biotecnológicas, entre otros ingredientes esenciales de este logro. Es esta una importante lección de cara al futuro: la investigación básica puede ser requisito esencial para afrontar peligros para nuestra propia supervivencia que desconocemos hoy.

En días o semanas próximas vacunarán a mi padre y, con él, a miles de residentes más en centros sociosanitarios. Más adelante serán otros los vacunados, hasta que gran parte de la población mundial se haya inmunizado. Subsisten dudas, surgirán problemas y aflorarán nuevos obstáculos a superar, pero la humanidad en su conjunto -miles de millones de personas- se beneficiará de los frutos de una empresa colectiva sin parangón, de una empresa científica.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo La vacuna de la covid-19, una proeza científica se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Sí con mis impuestos

- La Covid-19 revoluciona el sistema de publicación científica

- Relación entre genoma y las formas graves de COVID-19

¿En qué se parecen un patógeno y un rumor?

Manuel de León Rodríguez y Antonio Gómez Corral

Foto: Ben White / Unsplash

Foto: Ben White / UnsplashCon el término “rumor” nos referimos a una información, no siempre cierta, que puede propagarse en una población de individuos que interactúan entre sí. Su transmisión puede tener un impacto importante en la formación de las opiniones públicas y, en numerosas ocasiones, influye en el progreso de la sociedad de forma positiva y negativa.

Aunque el uso del rumor –bien o mal intencionado– para influir sobre la sociedad y desacreditar a un adversario ha existido siempre, la irrupción de internet y las redes sociales han hecho que su difusión se haya vuelto cada vez más poderosa con respecto a su intensidad y rapidez. Acontecimientos de gran magnitud internacional –como las elecciones en EE. UU. y el referéndum del Brexit– pueden haberse visto influenciados por fake news puestas en circulación intencionadamente.

La propagación de fake news e insultos en Twitter ha preocupado a las administraciones públicas hasta el punto de abordar la regulación de las redes sociales y la adopción de ciertas medidas colectivas complementarias.

El contagio de patógenos y rumores

Tras las epidemias subyacen modelos matemáticos y comportamiento humano, tal y como explicamos en el libro Las matemáticas de la pandemia.

De la misma manera que la malaria se transmite entre personas por medio de un mosquito infectado del género Anopheles, los rumores a menudo se transmiten entre seres humanos por medio del contacto que comparten en una red social. En ambos casos se observa la difusión de algo (el parásito Plasmodium o las fake news) entre una persona infectada (enferma por malaria o conocedora del rumor) y otra persona susceptible (sana o ignorante del rumor).

En la década de 1960, el matemático estadounidense William Goffman sugirió que la transmisión de información entre científicos funcionaba esencialmente como una epidemia. La analogía de Goffman estaba basada en usar los términos “susceptible”, “infectado” y “eliminado” empleados en el modelo SIR de epidemias que aluden a las personas sanas, colonizadas con el patógeno –y, por tanto, capaces de transmitirlo a otras– e inmunes.

En su trabajo las usaba para referirse al autor de un artículo científico, el lector que adquiere el conocimiento científico –y potencial propagador del mismo– y la muerte del lector o la pérdida de interés en el conocimiento transmitido. En este contexto, los artículos científicos serían los vectores de transmisión. Con su analogía, Goffman estaría sugiriendo que la difusión de las leyes de la herencia de Johann Mendel y la teoría de la relatividad de Albert Einstein podría ser modelizada de forma adecuada mediante un modelo de epidemias.

Pronto surgieron voces disconformes con la analogía de Goffman: en el modelo SIR de epidemias la persona infectada se recupera después de un cierto tiempo y adquiere inmunidad frente al patógeno cuando se recupera. Los matemáticos británicos Daryl J. Daley y David G. Kendall pusieron de manifiesto que los propagadores en un modelo de rumores habitualmente no se recuperan –no cesan en el intento de transmitir el rumor– de manera natural, sino que podrían desistir cuando, por ejemplo, encuentren a alguien que ya conoce el rumor.

Quizá la crítica de Daley y Kendall no sea muy sorprendente, dado que la difusión de rumores depende de aspectos sociales que no se observan en la transmisión de un patógeno. Mientras que el patógeno persiste en su intento de colonizar a nuevos individuos, los rumores están a menudo sujetos a las reglas sociales que rigen el comportamiento de una persona dentro del grupo con el que habitualmente interactúa.

Además, hay que observar un planteamiento diferente entre el proceso de transmisión en una epidemia y la propagación de un rumor.

Ante la emergencia de un nuevo virus, como es el caso del SARS-CoV-2, las agencias sanitarias pretenden primero saber cuáles son las rutas principales de transmisión y luego conocer sobre cuáles de esas rutas deberían centrar sus esfuerzos para parar o mitigar la transmisión del patógeno.

Los comerciales en el diseño de una campaña de publicidad deben centrar su atención sobre esos mismos aspectos, pero con matices opuestos. Tienen que conocer la forma en que una persona puede verse expuesta al mensaje de publicidad para centrarse en las rutas de transmisión del mensaje adecuadas, pero con el objetivo de expandir lo más posible su campaña.

Aunque con grandes diferencias, en epidemias y rumores hablamos de dos elementos comunes: las personas y las conexiones entre pares de personas que determinan la ruta de transmisión.

Las redes sociales vistas como un grafo

Sobre una hoja en blanco, las personas que forman parte de una población podrían ser representadas mediante puntos, y una línea conectando dos puntos indicaría, en un sentido amplio, una conexión entre las personas representadas de manera abstracta con esos puntos. Veríamos entonces cómo un mosquito viaja sobre una línea trazada entre dos puntos –sobre los que hemos colocado a una persona infectada de malaria y una persona sana– de la misma manera que el rumor viaja a través de internet desde el móvil de una persona que, con buenas o malas intenciones, quiere influir sobre otra persona susceptible.

El resultado final de representar a las personas y sus conexiones podría describirse mediante un grafo o red de contactos donde los nodos son personas y las aristas son los enlaces, cuando existen entre ellas. Incluso las aristas podrían estar orientadas en ambos sentidos, como las relaciones en redes sociales como Whatsapp y Facebook, o solo en uno de ellos, como en Twitter. Esto dependerá de si el rumor puede ser transmitido entre dos personas por igual o, por el contrario, solo puede ser transmitido desde una de ellas a la otra.

Como consecuencia, las dinámicas de difusión de rumores tienen mucho en común con la teoría de grafos, el concepto de “mundo pequeño” y la teoría de “los seis grados de separación” sobre el reto de encontrar a una persona que no estuviera conectada con otra persona elegida al azar a través de una cadena de cinco conocidos.

La propiedad de mundo pequeño es de especial relevancia, tanto en la propagación de un patógeno como en la difusión de rumores. Lo que expresa es que un nodo individual –un individuo, en un sentido amplio– está conectado con otros nodos en su área local, pero también lo puede estar con nodos más lejanos en el espacio a través de nodos intermedios.

Con independencia de los orígenes de las redes de contacto y sus aplicaciones, la teoría de los seis grados se refiere a cualquier red social en el sentido general de estructura que involucra a usuarios (personas, terminales, instituciones) relacionados entre sí en función de algún vínculo (de amistad, profesional, político). Estos conceptos han dado lugar incluso a canciones como Full Circle de No Doubt y a las películas Seis grados de separación (1993) y Babel (2006), con el trasfondo de la globalización.

Ambos conceptos son objeto de investigación activa y aparecen combinados con otros aspectos novedosos. Por ejemplo, las redes de contacto dinámicas evolucionan a lo largo del tiempo en función del conocimiento que una persona tiene sobre el estado de sus contactos. En la aplicación a la propagación de SARS-CoV-2, esto puede significar la ruptura del enlace entre una persona sana con una persona diagnosticada de covid-19 y el necesario establecimiento de una nueva conexión con otra persona diferente.

Se trata de una medida preventiva de distanciamiento social –que la persona sana adopta por decisión propia desde el conocimiento de que uno de sus vecinos está infectado– con un claro beneficio individual, pero que sorprendentemente podría tener un efecto negativo sobre la evolución de la epidemia a nivel poblacional en términos del número de individuos que se verán finalmente afectados por el patógeno y la duración del episodio.![]()

Sobre los autores: Manuel de León Rodríguez es profesor de investigación del CSIC en el Instituto de Ciencias Matemáticas (ICMAT-CSIC) y Antonio Gómez Corral, es profesor del departamento de estadística e investigación operativa de la Universidad Complutense de Madrid

Este artículo fue publicado originalmente en The Conversation. Artículo original.

El artículo ¿En qué se parecen un patógeno y un rumor? se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Compartiendo un rumor

- El modelo SIR, un enfoque matemático de la propagación de infecciones

- La mielitis transversa: el embotellamiento inflamatorio de la médula espinal

Carlos Briones – Naukas Bilbao 2019: Luna

Foto: Luca Huter / Unsplash

Foto: Luca Huter / UnsplashAntonio Martínez Ron escribía refiriéndose a Carlos Briones lo siguiente:

No solo es la persona que mejor representa la unión de las sensibilidades científica y literaria; sus charlas sobre astronomía y arte han marcado una especie de estándar de la calidad de una conferencia. Además de poeta laureado y divulgador incansable, Carlos es uno de los científicos españoles más brillantes.

Si en Naukas 2018 Briones sorprendió a todo el mundo con una forma sorprendente de contar la historia del universo, en 2019 su conferencia titulada Luna entró definitivamente en la categoría de obra artística. Lo que traemos a continuación es la edición especial que eitb.eus hizo de la misma; la voz en off es la del directo de Briones. Para disfrutar con auriculares y en una habitación en penumbra.

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Carlos Briones – Naukas Bilbao 2019: Luna se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Naukas Pro 2017: Carlos Briones y el origen de la vida

- Carlos Briones – Naukas Bilbao 2018: Os voy a contar una historia (en imágenes)

- Nahúm Méndez Chazarra – Naukas Bilbao 2019: Marcianos, extraterrestres y la zona habitable

Los pasaportes de inmunidad, entre el conflicto ético y la oportunidad

Foto: Blake Guidry / Unsplash

Foto: Blake Guidry / UnsplashLos pasaportes de inmunidad son una forma de registrar que se considera que un individuo tiene inmunidad a la COVID-19 y se presume que es improbable que contraiga o propague la enfermedad. Pueden ser un certificado, una pulsera, una aplicación para móviles u otro documento. En principio su utilización genera muchas dudas desde un punto de vista científico y ético. La ciencia desconfía de ellos porque aún no está claro que haber pasado la enfermedad haga que, efectivamente, se consiga la inmunidad, ni por cuánto tiempo. De hecho, hay algunas reinfecciones, aunque parece ser un fenómeno muy poco habitual. Los problemas científicos, con todo, irán desapareciendo conforme se obtengan más datos.

Los problemas éticos, en cambio, tienen vocación de permanencia. “Si aceptamos que, como dicen sus detractores, los pasaportes son inadmisibles porque pueden provocar que las personas se contagien voluntariamente, o porque aumentarían la vigilancia del Estado, sobre todo en colectivos vulnerables, o porque crearían un mercado negro incipiente, es obvio que deberíamos renunciar a ellos”. Sin embargo, en un artículo publicado con el profesor Ikerbasque de la UPV/EHU Iñigo de Miguel Beriain como coautor, se argumenta “que esto no es tan simple, y para entender por qué, hay que adoptar la perspectiva del inmunizado”, afirma el doctor en Derecho y en Filosofía.

“Si usted no puede contagiar el virus, es sumamente difícil justificar la restricción de algunos de sus derechos, sobre todo el derecho fundamental a la libertad de movimientos. Tanto la Constitución Española como el Convenio Europeo de Derechos Humanos limitan claramente cualquier restricción de ese derecho —añade—. Es muy difícil amparar una limitación de nuestra libertad de movimientos sobre la base de la evitación de conductas temerarias por parte de terceras personas”.

En opinión del investigador del Departamento de Derecho Público, la importancia de esta cuestión se incrementará sin duda cuando se tengan vacunas disponibles y una proporción importante de la población empiece a vacunarse. Los certificados de vacunación generarán, de hecho, una especie de pasaporte de inmunidad. Según el investigador, en las próximas fases de la pandemia, estarán en juego diferentes estados de inmunidad, “porque es inevitable la necesidad de identificar quién puede propagar COVID-19. Si una persona no representa una amenaza para la salud pública porque no puede propagar la infección, entonces se debe respetar su derecho a la libertad de movimiento, independientemente de cómo haya adquirido esa inmunidad. Pero, si no hay vacunas para todos en ese momento, lo que estaremos haciendo es reconocer la vigencia y la aceptabilidad moral de los pasaportes inmunológicos, al menos cuando hablemos de derechos fundamentales”.

Referencia:

Iñigo de Miguel Beriain, Jon Rueda (2020) Immunity passports, fundamental rights and public health hazards: a reply to Brown et al. Journal of Medical Ethics doi: 10.1136/medethics-2020-106814

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Los pasaportes de inmunidad, entre el conflicto ético y la oportunidad se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Por qué los biobots no son un problema ético (de momento)

- Un nexo cannabinoide entre mitocondrias y memoria

- La dependencia entre conectividad estructural y funcional en el cerebro

Sombra aquí, sombra allá: reconocimiento facial discriminatorio

Lorena Fernández Álvarez

Foto: jurien huggins / Unsplash

Foto: jurien huggins / UnsplashCon los avances en inteligencia artificial los sistemas de reconocimiento facial han proliferado. Se han desarrollado muchos servicios para identificar a personas en las multitudes, analizar sus emociones y detectar su género, edad, raza y características faciales. Ya se utilizan con una gran variedad de propósitos: desde contratar o mejorar sistemas de marketing hasta aspectos relacionados con seguridad y vigilancia.

Sin embargo, a pesar de los amplios esfuerzos para mejorar su fiabilidad, los estudios demuestran que los algoritmos de aprendizaje automático pueden discriminar según el género y la raza. También bajan su rendimiento en personas trans y no son capaces de clasificar a personas no binarias. Además, elementos como el maquillaje tienen un alto impacto en la precisión de los sistemas.

Los algoritmos de aprendizaje automático (Machine Learning) establecen patrones tras procesar grandes cantidades de datos. Son como estudiantes en un colegio: aprenden del libro de texto (información con la que se les entrena para que generen reglas de inferencia) y del profesorado (quien decide qué temas entrarán en el examen y les dice a sus estudiantes qué parámetros son importantes). Su limitación es que se pueden cargar de sesgos en varios puntos y de varias maneras.

La primera casuística se da cuando la realidad de la que aprenden está ya llena de prejuicios. La segunda, cuando les enseñamos solo una parte que no es representativa, que hace que los algoritmos piensen que esa es la única realidad. Otro punto de perversión se puede introducir durante la etapa de preparación de datos y la selección de modelos, cuando se hacen las preguntas equivocadas o se toman en consideración los parámetros erróneos.

Indicadores de equidad: Infraestructura escalable para sistemas de machine learning justos. Catherina Xu y Tulsee Doshi, Google Research.

Indicadores de equidad: Infraestructura escalable para sistemas de machine learning justos. Catherina Xu y Tulsee Doshi, Google Research.Empecemos analizando la recopilación de datos. Entre 1940 y 1990 compañías como Kodak y Polaroid solo usaron modelos blancos para calibrar sus productos. Treinta años después, seguimos teniendo los mismos sesgos raciales con la tecnología.

El estudio Gender Shades midió la precisión de la clasificación comercial de sistemas de Microsoft, IBM y Face ++ para descubrir que las mujeres de piel más oscura eran clasificadas erróneamente con mayor frecuencia que el resto. Los sistemas funcionaban mejor en rostros de hombres que de mujeres y en pieles claras que oscuras.

Una actualización del estudio en 2019 volvió a probar los tres sistemas comerciales previamente examinados y amplió la revisión para incluir Amazon Rekognition y Kairos. IBM, Face ++ y Microsoft habían mejorado su precisión. Sin embargo, las plataformas de Amazon y Kairos tenían unas brechas de precisión del 31 % y 22,5 %, respectivamente, entre hombres de piel más clara y mujeres de piel más oscura.

Amazon, en vez de tomar nota y tratar de corregir el problema, comenzó toda una campaña de desprestigio de la investigación y, más en concreto, de la figura de una de sus responsables, Joy Buolamwini.

Informe Gendered Innovations 2.

Informe Gendered Innovations 2.Este es un ejemplo de sesgo interseccional, donde diferentes tipos de discriminación amplifican los efectos negativos para un individuo o grupo. La interseccionalidad describe formas cruzadas de opresión y desigualdad que surgen de ventajas y desventajas estructurales derivadas de la pertenencia a múltiples categorías sociales superpuestas como género, sexo, etnia, edad, nivel socioeconómico, orientación sexual, ubicación geográfica… Es decir, cada persona sufre opresión u ostenta privilegio en base a su pertenencia a múltiples categorías sociales.

El sesgo también puede introducirse durante la preparación de datos y la selección del modelo, lo que implica escoger atributos que el algoritmo debería considerar o ignorar, como los cosméticos faciales o la evolución de las caras de personas trans durante la transición.

Maquillaje y personas trans

Un estudio mostró que el maquillaje (usado principalmente por las mujeres en la mayoría de sociedades) reduce enormemente la precisión de los métodos de reconocimiento facial comerciales y académicos. La razón es que los cosméticos no se han establecido como un parámetro en las bases de datos faciales disponibles públicamente.

Una propuesta para desarrollar sistemas que sean robustos es mapear y correlacionar varias imágenes de la misma persona con y sin maquillaje. Estas soluciones también deben tener en cuenta las diferentes prácticas de maquillaje en las distintas culturas.

Otro de los desafíos emergentes son las caras de las personas trans, especialmente durante los períodos de transición. Por ejemplo, saltó a los medios el caso de una conductora trans de Uber que tenía que viajar todos los días dos horas para ir a una oficina local de la compañía dado que no funcionaba con ella la app que solicita periódicamente a conductores que envíen selfies para verificar su identidad antes de comenzar un turno.

La terapia hormonal redistribuye la grasa facial y cambia la forma y textura general del rostro. Dependiendo de la dirección de la transición (es decir, de hombre a mujer o de mujer a hombre), los cambios más significativos en la cara transformada afectan las arrugas y líneas, las estrías, el engrosamiento o adelgazamiento de la piel y las variaciones de textura. La terapia con hormonas, por ejemplo, hace que la cara sea más angular.

¿La solución es corregir los prejuicios asegurando que se incluyan muchas personas trans en los datos de entrenamiento de la IA? La idea, en un primer momento, puede sonar bien, pero recoger y almacenar datos de una comunidad que tiene motivos para sentirse incómoda con esta recopilación, no es la mejor práctica. En este caso, puede ser importante revisar los parámetros algorítmicos. Los métodos existentes indican que en estos casos, la región ocular (o periocular) se puede utilizar de forma más fiable en comparación con el uso de la región de rostro completo, ya que se ve menos afectada por el cambio que otras.

Otro estudio halló que cuatro servicios comerciales (Amazon Rekognition, Clarifai, IBM Watson Visual Recognition y Microsoft Azure) tuvieron un desempeño deficiente en personas trans y no pudieron clasificar géneros no binarios.

Usando el hashtag proporcionado por las personas en sus publicaciones de Instagram (#woman, #man, #transwoman, #transman, #agender, #genderqueer, #nonbinary), el equipo calculó la precisión de los resultados de clasificación de género en 2 450 imágenes. En promedio, los sistemas clasificaron a las mujeres cis (#women) con un 98,3 % de precisión y a los hombres cis (#man) con un 97,6 %. La precisión disminuyó para las personas trans, con un promedio de 87,3 % para #transwoman y 70,5 % para #transman. Aquellas personas que se identificaron como #agender, #genderqueer o #nonbinary fueron mal caracterizadas el 100 % de las veces.

Informe Gendered Innovations 2.

Informe Gendered Innovations 2.Hora de repensar la tecnología

Ante todas estas incógnitas éticas, compañías como IBM han cesado por completo el desarrollo de software de reconocimiento facial, mientras que Amazon y Microsoft han hecho un parón temporal en la venta de sus sistemas a la policía.

Visto lo sucedido con el despido por parte de Google de Timnit Gebru, una de sus líderes de ética (y precisamente otra de las impulsoras del estudio de Gender Shades), es peligroso dejar las llaves del gallinero al zorro.

Como bien dice Cathy O’Neil, otra activista por una IA ética: “No se puede confiar en que las empresas verifiquen su propio trabajo, especialmente cuando el resultado pueda entrar en conflicto con sus intereses financieros.”

Para no perpetuar e incluso amplificar los patrones sociales de injusticia al codificar consciente o inconscientemente los prejuicios humanos, tenemos que pasar del “modo reactivo” (poniendo parches cuando se encuentran los problemas) al “modo proactivo”, incorporando el análisis interseccional desde la misma concepción de los proyectos.

Para ello, desde la Comisión Europea se ha publicado un informe (Gendered Innovations 2) en el que hemos desarrollado quince estudios de caso y métodos para mostrar cómo ayudar a la investigación a desarrollar tecnologías más justas y responsables. Nuestro objetivo es concienciar a la ciudadanía, a las organizaciones y a la administración pública de este problema y así crear tecnologías que funcionen para toda la sociedad y no solo para las mayorías con poder.![]()

Sobre la autora: Lorena Fernández Álvarez es directora de identidad digital de la Universidad de Deusto

Este artículo fue publicado originalmente en The Conversation. Artículo original.

El artículo Sombra aquí, sombra allá: reconocimiento facial discriminatorio se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- ¿Qué hay más allá de la orilla del mar?

- #Naukas16 Aquí no se opina, aquí se mide

- Los retos de geolocalizar a la población española

La estrategia ganadora de Helena

Foto: Ronnie Overgoor / Unsplash

Foto: Ronnie Overgoor / Unsplash

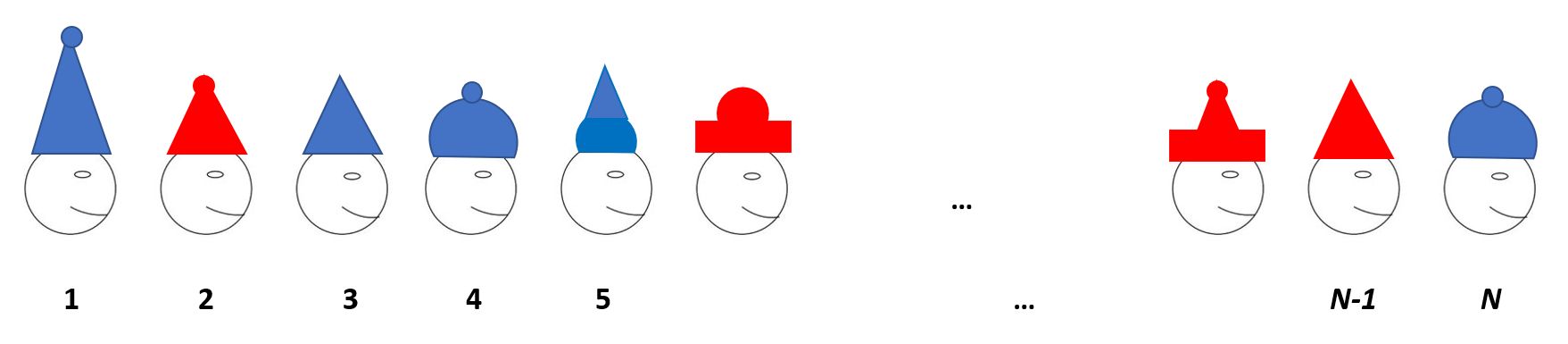

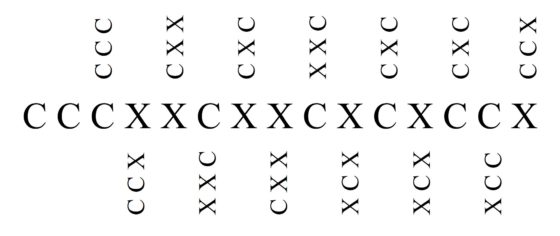

Un grupo de N estudiantes de lógica se somete a una prueba para verificar sus habilidades en esta materia. Deben situarse en fila mirando hacia la derecha. Sin que ellos puedan verlo, se coloca al azar un sombrero rojo o azul sobre cada cabeza.

El estudiante situado más a la izquierda (en la posición 1) puede ver todos los gorros menos el suyo. El compañero situado delante de él (en la posición 2) divisa todos los sombreros excepto el suyo y el del estudiante colocado detrás de él (en la posición 1). En general, la persona situada en la posición k puede ver (solo) los gorros de sus compañeros colocados en los lugares k+1, k+2, etc. hasta N.

A cada estudiante se le preguntará por el color que piensa que tiene su sombrero. Tras finalizar esta ronda de preguntas y respuestas, se entregará al grupo tantas tablets como el número de aciertos. El propio grupo se encargará después de repartir “su botín”. Es decir, a los estudiantes les interesa colaborar.

Antes de ponerse en fila, los estudiantes pueden pactar una estrategia para responder a la pregunta de manera más certera. Pero, una vez colocados en línea, los sombreros se colocan al azar y los estudiantes ya no pueden interactuar. Las preguntas y las respuestas se realizarán en voz alta. Se empezará interrogando al estudiante más a la izquierda (en la posición 1) y se continuará en orden hasta terminar con el situado más a la derecha (en la posición N).

Buscando una buena estrategia

Si los estudiantes responden al azar ganarán, en media, N/2 tablets ya que la probabilidad de acertar de ese modo es de 1/2.

Bertrand, uno de los estudiantes del grupo, propone el siguiente método de juego:

· El estudiante 1 (el situado más a la izquierda) responderá diciendo el color del gorro del estudiante 2, que de este modo conocerá de manera certera el color de su sombrero.

· El estudiante 2 repetirá lo que le ha dicho el jugador 1 y, por lo tanto, acertará.

· El estudiante 3 responderá diciendo el color del gorro del estudiante 4.

· El estudiante 4 repetirá lo que le ha dicho el estudiante 3, y por lo tanto ganará.

Y siguen respondiendo de este modo. Esta manera de proceder garantiza al menos N/2 respuestas exactas. Además, en media, los estudiantes responderán correctamente 3N/4 (= N/2 + N/4) veces, ya que las personas colocadas en lugares impares acertarán (por azar) aproximadamente una de cada dos veces.

La mayor parte de los estudiantes, convencidos, aplauden la estrategia de Bertrand. Sin embargo, Helena —una “fuera de serie” en lógica— está en desacuerdo. Y dice a sus compañeros: «Tengo otra idea mejor. Con ella ganaremos todos una tablet… salvo quizás uno de nosotros».

¿Cuál puede ser la estrategia de Helena? Piensa un poco antes de mirar la respuesta propuesta…

La estrategia de Helena

Helena (ver [2]) propone que cada persona del grupo debe transmitir información sobre la paridad (par o impar) del número de sombreros rojos colocados a partir de él (contando su sombrero). Es decir, la forma de actuar es la siguiente:

-

El estudiante 1 (el situado más a la izquierda) dice “rojo” como respuesta al color de su sombrero si el número de gorros rojos que ve es par y contesta con azul en caso contrario. Tiene una posibilidad sobre dos de acertar.

-

Si el estudiante 2 ve que a partir de él hay una cantidad de gorros rojos de la misma paridad que la indicada por el estudiante 1 (recordemos que las respuestas se dan en voz alta), sabe que él tiene un gorro de color azul. Y si la paridad no coincide, sabe que su gorro es de color rojo. Responde siguiendo la estrategia de Helena, así que su respuesta es necesariamente correcta.

-

El estudiante colocado en el lugar 3 conoce la paridad de los sombreros rojos desde el 2 hasta el N (por la información dada por su colega situado en la posición 1) y sabe si el estudiante 2 tiene un gorro rojo o azul (ya que ha oído su respuesta y todos saben que es la correcta). Así, conoce la paridad del número de sombreros rojos desde el 3 hasta el N. Como ve todos los gorros desde el 4 hasta el N, deduce el color de su sombrero sin temor a equivocarse.

El proceso continúa de este modo respondiendo cada estudiante turno por turno. Todos, excepto quizás el primero, dan la respuesta correcta. ¡Así que Helena tenía razón! Con su estrategia ganarán al menos N-1 tablets…

En el peor de los casos, quedaría por decidir quien se queda sin tablet… pero esa es otra historia.

Referencias

[1] Jean-Paul Delahaye, Rubrique des paradoxes: Les chapeaux alignés, Accromath. Volume 15.1 – hiver-printemps 2020

[2] Jean-Paul Delahaye, Solution du paradoxe précédent: Les chapeaux alignés, Accromath. Volume 15.2 – été-automne 2020

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad

El artículo La estrategia ganadora de Helena se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Coloquios escépticos: Medicinas alternativas, con Helena Matute

- Helena Matute: “Sería un error pensar que los robots van a limitarse a tareas rutinarias.»

- La mejor estrategia para un maratón

Historia de la tectónica de placas

En 1912 el físico alemán Alfred Wegerner formuló la hipótesis de la deriva continental o desplazamiento de las masas continentales. Dicha propuesta fue largamente debatida, entre otras, en universidades británicas y australianas. Sin embargo, en los años cincuenta del XX los geólogos que cartografiaban sistemáticamente el magnetismo fosilizado llegaron a la conclusión de que el polo norte parecía haber cambiado de posición continuamente en el pasado.

Se barajaron todo tipo de hipótesis para dar respuesta a este descubrimiento: que eran sus instrumentos los que creaban el efecto, que el campo magnético no había sido siempre dipolar, que los continentes se habían movido relativamente con respecto a los demás, o que los polos se habían desplazado independientemente uno del otro. Para finales de la década de los cincuenta, estos y otros datos hizo que un grupo de científicos de las universidades de Londres y Nacional Australiana, liderados por el físico Keith Runcorn, de la Universidad de Newcastle, llegaran a la conclusión de que los continentes se habían desplazado, reviviendo de esta manera la languideciente teoría de la deriva continental.

Los vídeos de Historias de la Ciencia presentan de forma breve y amena pasajes de la nuestra historia científica y tecnológica. Los vídeos, realizados para la Cátedra de Cultura Científica de la UPV/EHU, se estrenan en el programa de ciencia Órbita Laika (@orbitalaika_tve), los lunes a las 22:00 en la 2 de RTVE.

El artículo Historia de la tectónica de placas se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Ciencia Express: la tectónica de placas

- De la tectónica de placas

- La presencia de sales podría hacer que exista una tectónica de placas en Europa

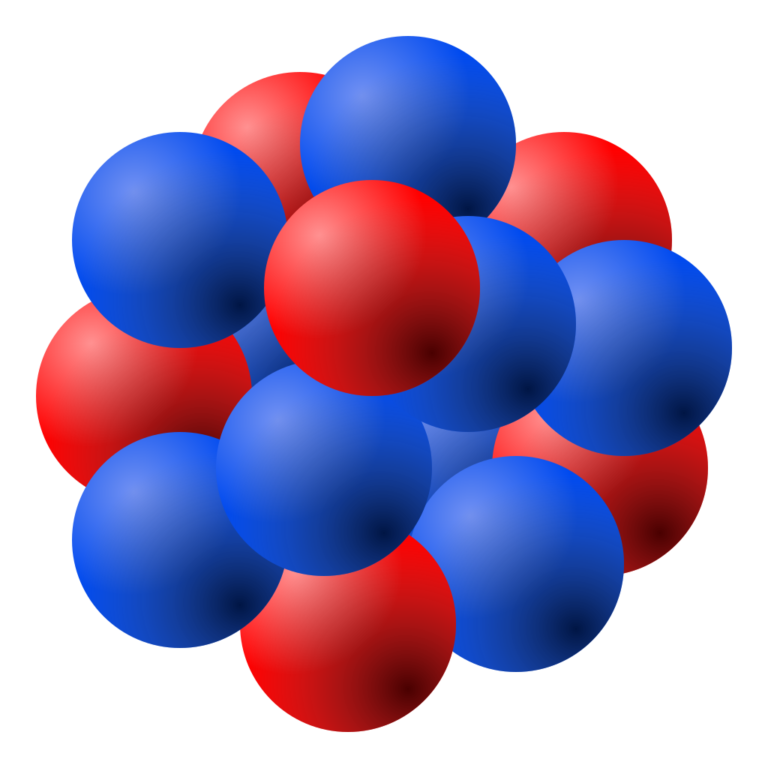

El modelo protón-neutrón

Fuente: Wikimedia Commons

Fuente: Wikimedia CommonsEl descubrimiento del neutrón, con una masa atómica cercana a una unidad y sin carga eléctrica, confirmó la sugerencia de Rutherford de que el núcleo atómico está formado por protones y neutrones. Esta hipótesis pronto fue utilizada por Heisenberg como base de una teoría detallada del núcleo, también en 1932. Su trabajo supuso otro triunfo para la mecánica cuántica.

Según el modelo protón-neutrón que surgió de la nueva teoría, el núcleo de un átomo que tiene un número atómico Z y un número másico A consta de Z protones Z y de (A-Z) neutrones.

Los núcleos de los isótopos de un elemento dado difieren solo en el número de neutrones que contienen. Por tanto, el núcleo del isótopo de hidrógeno de número de masa 1 contiene un protón; el núcleo del isótopo de hidrógeno de número de masa 2 contiene un protón y un neutrón [1]. . El núcleo del isótopo de neón 20Ne contiene 10 protones y 10 neutrones, mientras que el de 22Ne contiene 10 protones y 12 neutrones.

El número atómico Z identificado con la carga en el núcleo es el número de protones en el núcleo. El número de masa A es el número total de protones y neutrones [2]. De aquí resulta que el número de masa atómica A resulta ser simplemente el número de nucleones en el núcleo.

El número atómico Z identificado con la carga en el núcleo es el número de protones en el núcleo. El número de masa A es el número total de protones y neutrones [2]. De aquí resulta que el número de masa atómica A resulta ser simplemente el número de nucleones en el núcleo.

Según el modelo protón-neutrón, un solo protón forma el núcleo del isótopo común del hidrógeno. Un protón y un neutrón producen el llamado deuterón, y el átomo resultante se llama deuterio.[3][4]

El modelo protón-neutrón para la estructura de los núcleos es totalmente coherente con lo datos experimentales sobre la radiactividad, como la emisión de partículas alfa y beta y las reglas de desplazamiento radiactivo. Si dos protones y dos neutrones pudieran combinarse, la partícula resultante tendría Z = 2 y A= 4, exactamente las características de la partícula alfa. La emisión de dos protones y dos neutrones (en la forma combinada de una partícula alfa) sería consistente con la primera regla.[5]

El modelo neutrón-protón planteaba una nueva cuestión: si el núcleo está formado por protones y neutrones, ¿de dónde podría provenir una partícula beta en una desintegración beta? Esta pregunta es más difícil de responder que la del origen de una partícula alfa. La segunda regla de desplazamiento radiactivo proporciona una pista: cuando un núcleo emite una partícula, su carga Z aumenta en una unidad, mientras que su número de masa A permanece inalterado. Esto es lo que sucedería si un neutrón se transformara en un protón y una partícula beta.

Esta idea es diferente a la hipótesis protón-electrón. La comunidad física ya había llegado a la conclusión de que los electrones no están presentes en el núcleo, por lo que no se consideraba que la desintegración fuera una simple separación de un protón y un electrón; tendría que ser una transformación de un neutrón que creara un protón y un electrón. Sin embargo, existían datos experimentales adicionales que hacían que una idea de transformación tan simple no fuese suficiente.

Notas:

[1] Este núcleo se llama deuterón.

[2] Protones y neutrones se llaman conjuntamente nucleones.

[3] Cuando dos átomos de deuterio se combinan con oxígeno, forman «agua pesada».

[4] El átomo formado a partir del isótopodel hidrógeno formado por un protón y dos neutrones se llama tritio, una sustancia radiactiva.

[5] La partícula podría existir como tal en el núcleo, o podría formarse en el instante de la emisión; esta última posibilidad se considera ahora más probable.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo El modelo protón-neutrón se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El descubrimiento del neutrón (2): la hipótesis de Chadwick

- La hipótesis protón-electrón de la composición nuclear

- El descubrimiento del neutrón (1): el gran dilema

Por qué los girasoles se marchitan

Daniel Torregrosa, lector

No concibo una mejor introducción para recomendar este libro que las palabras del matemático y divulgador científico Jacob Bronowski, recogidas en su ensayo El sentido común de la ciencia (1951):

«Uno de los prejuicios contemporáneos más nefastos ha sido el de que el arte y la ciencia son cosas diferentes y en cierto modo incompatibles. Hemos caído en el hábito de contraponer el temperamento artístico al científico; incluso los identificamos con una actividad creadora y otra crítica. En una sociedad como la nuestra, que practica la división del trabajo, existen naturalmente actividades especializadas como algo indispensable. Es desde esta perspectiva, y sólo desde ella, que la actividad científica es diferente de la artística. En el mismo sentido, la actividad del pensamiento difiere de la actividad de los sentidos y la complementa. Pero el género humano no se divide en seres que piensan y seres que sienten; de ser así no podría sobrevivir mucho tiempo».

Por qué los girasoles se marchitan es la ópera prima de Oskar González Mendia, profesor de Química de la universidad del País Vasco en las facultades de Ciencia y Tecnología y en la de Bellas Artes. Esta dualidad docente ha hecho de este autor el referente intratable de la unión perfecta, o una amalgama- como diríamos los químicos-, entre ciencia y arte. Y así lo demuestran sus años de publicaciones en la sección KimikArte del Cuaderno de Cultura Científica. Esta obra es el resultado esperado de las reacciones, no ya químicas en este caso, sino las de la legión de seguidores que reclamábamos el producto final en forma de libro. Y por fin ha llegado.

En Por qué los girasoles se marchitan nos embarcaremos en un trayecto por la Historia del Arte de la mano de una serie de elementos químicos presentes, ya sea en estado fundamental o como compuestos, en la pintura, la escultura o la arquitectura. Todo es química, como se suele decir, y el Arte está repleto de ella. A través de sus páginas nos asombraremos con historias sobre el color verde y sus propiedades asesinas, descubriremos cómo coloreaban el vidrio los egipcios, conoceremos al artista que pintaba con oro, aprenderemos la química tras las falsificaciones más sonadas de la Historia… Y mucho más.

El resultado final es un libro brillante, que nos regala un original y ameno paseo entre las orillas de la ciencia y del arte, ese pensamiento y sentimiento del que hablaba Bronowski. No se lo pierdan, les aseguro que la próxima vez que admiren un cuadro o escultura en cualquier museo, lo harán con la emoción que nos proporciona la contemplación artística y con los ojos de la química. Los girasoles de Van Gogh podrán marchitarse pero el poder de la fascinación, la magia de la química, los puentes entre humanidades y ciencia, están muy bien regados con obras como esta que les acabo de presentar.

Ficha:

Título: Por qué los girasoles se marchitan. Los elementos químicos en el arte

Autor: Oskar González Mendía

Editorial: Cálamo

Colección: Arca de Darwin

Año: 2020

ISBN: 978-84-16742-20-2

Sobre el autor: Daniel Torregrosa es químico y divulgador científico. Autor de Del mito al laboratorio. La inspiración de la mitología en la ciencia (Cálamo, 2018), 101 Obras esenciales de divulgación científica (BRMU/Ediciones Tres Fronteras, 2019) y del blog Ese punto azul pálido.

En Editoralia personas lectoras, autoras o editoras presentan libros que por su atractivo, novedad o impacto (personal o general) pueden ser de interés o utilidad para los lectores del Cuaderno de Cultura Científica.

El artículo Por qué los girasoles se marchitan se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Ciencia, arte y cultura callejera: materiales y obra artística

- Libros para enamorarse

- Arte & Ciencia: Química y Arte, reacciones creativas

Evite, si puede, la silla y el sofá

Foto: Jordan Koons / Unsplash

Foto: Jordan Koons / UnsplashLa inactividad física ejerce efectos negativos sobre la salud porque eleva el riesgo de sufrir ciertas enfermedades no contagiosas. La probabilidad de sufrir enfermedades cardiovasculares, diabetes tipo 2 y cánceres de varios tipos es mayor en las personas inactivas. La inactividad es, por ello, responsable de una parte de la mortalidad prematura; si se redujese de forma significativa, aumentaría la esperanza de vida ocho meses, en promedio, para el conjunto de la Humanidad.

Lo dicho en el párrafo anterior es de sobra sabido a estas alturas. Lo que probablemente no sea tan conocido es que los efectos negativos de la inactividad también se producen aunque quien los sufre frecuente el gimnasio o dedique un tiempo de cada día a correr. Y no, no hay contradicción entre esas dos afirmaciones. El ejercicio físico tiene efectos salutíferos, por supuesto. Pero si quien lo practica pasa la mayor parte de su tiempo tumbado en el sofá o sentado frente a la pantalla del ordenador, sus buenos efectos se ven contrarrestados.

Ahora bien, la actividad física sigue siendo saludable y muy recomendable incluso si uno lleva vida sedentaria. Valga la metáfora del sorteo: la probabilidad de que toque es mayor cuantos más son los boletos que se compran. Pasando poco tiempo sentado se compran boletos para una condición saludable; practicando algún deporte o desarrollando alguna actividad física con frecuencia, también. Son boletos diferentes. Cuantos más se compren, mayor es la probabilidad de que toque una buena salud, y viceversa.

En el sorteo juega un papel clave la enzima lipoproteinlipasa. Se encuentra en el interior –en la luz- de los capilares sanguíneos, adherida al endotelio, que es la capa de células que tapiza los vasos. Actúa sobre los triglicéridos de las lipoproteínas de bajísima y de muy baja densidad que viajan en la sangre, y los convierte en moléculas que, a su vez, introduce en las células musculares, para su metabolismo, y de las adiposas, para su almacenamiento.

La condición sedente perjudica la salud porque la inactividad muscular provoca una reducción de los niveles de lipoproteinlipasa, de manera que las moléculas que debían ser introducidas en las células musculares permanecen en la sangre, donde los triglicéridos pueden alcanzar altas concentraciones y ser fuente de problemas.

Recordemos, para acabar, que no todo el mundo pasa media vida delante de una pantalla. Es más, hay quienes carecen de sillas. Herman Pontzer, de la Universidad Duke (EEUU), ha estudiado el metabolismo de los Hadza, un grupo de cazadores y recolectores africanos. No tienen sillas ni nada semejante pero, al margen del sueño, también descansan; reposan durante unas diez horas diarias, tantas como podemos estar sentados en los países occidentales. Y sin embargo, los Hadza no tienen niveles altos de triglicéridos en la sangre. La clave radica, según Pontzer, en su forma de descansar, en cuclillas o de rodillas sobre los talones, en posturas que exigen una cierta actividad muscular para mantener el equilibrio. Esa “pequeña” diferencia parece suficiente para evitar problemas. Pero si ha pensado en imitarlos, mejor no lo intente: si no lo hace desde su más tierna infancia, no es fácil, y puede usted acabar con una lesión.

Así pues, evite, si puede, la silla y el sofá, pero si, debido al trabajo que desempeña o a cualquier otra causa, ha de sentarse durante largos periodos, conviene que se levante cada veinte minutos, aproximadamente, y se mueva durante un par de minutos antes de volver a sentarse. Y si a eso le añade una horita diaria de actividad física moderada, comprará unos cuantos boletos para una vida saludable.

Fuentes:

I-Min Lee et al (2012): Effect of physical inactivity on major non-communicable diseases worldwide: an analysis of burden of disease and life expectancy. The Lancet 380 (9838): 219-229.

Pontzer y D. Raichlen (2020): How changing the way you sit could add years to your life. New Scientist nº 3291.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Evite, si puede, la silla y el sofá se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Una infección vírica puede activar la aparición de diabetes tipo I

- ¿Qué nos puede decir un elefante del cáncer en humanos?

- No habrá solución sin más conocimiento

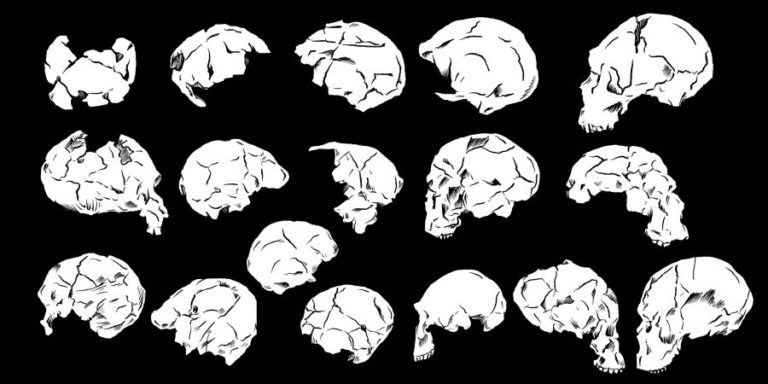

Catástrofe Ultravioleta #33 TANATOS 2

En este episodio seguimos indagando en el concepto de la muerte. Aquí vamos a dejar atrás el resto de especies que tratamos en el anterior capítulo y vamos a centrarnos en nuestros antepasados, ¿cómo se enfrentaron ellos a la muerte? No tenemos una máquina del tiempo, pero sí algo que siempre nos dice la verdad: los huesos.

https://www.ivoox.com/t03e09-tanatos-2_md_62361097_wp_1.mp3Puedes escucharnos en:

– Podium Podcast

– iVoox

– Spotify

– Apple Podcasts

Agradecimientos: Susana Escudero, Roberto Sáez, Nacho Martínez Mendizábal y Lucía Perlado.

** Catástrofe Ultravioleta es un proyecto realizado por Javier Peláez (@Irreductible) y Antonio Martínez Ron (@aberron) con el patrocinio parcial de la Cátedra de Cultura Científica de la Universidad del País Vasco y la Fundación Euskampus. La edición, música y ambientación son obra de Javi Álvarez y han sido compuestas expresamente para cada capítulo.

El artículo Catástrofe Ultravioleta #33 TANATOS 2 se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Catástrofe Ultravioleta #32 TANATOS 1

- Catástrofe Ultravioleta #31 SIBERIA

- Catástrofe Ultravioleta #21 PHARMA

¿Puede un muerto regresar a la vida?

Sendoa Ballesteros Peña

Foto: Cristian Newman / Unsplash

Foto: Cristian Newman / UnsplashQue el disfraz de muerto viviente sea uno de los más recurrentes de la noche de Halloween, víspera del Día de Todos los Santos, no es casual. La posibilidad de que los muertos retornen a la vida ha quitado el sueño a los humanos desde la época medieval hasta principios del siglo XIX. Las leyendas de los “no muertos” surgieron en la Europa del siglo XI, aunque el mito, probablemente, es mucho anterior.

La arqueología ha dejado a la luz testimonios de rituales funerarios grotescos, como enterramientos boca abajo u hoces sobre la garganta del difunto para evitar que el muerto se levantase de su tumba.

Pero a partir del siglo XIX se generalizó un nuevo miedo alentado por la literatura propia del romanticismo oscuro de la época: el de ser enterrado vivo. Poco después del año 1800, se comercializó el primer ataúd de seguridad. Este dispositivo permitía activar una campanilla situada en el exterior desde la propia sepultura, en el caso de que el supuesto difunto hubiese “despertado”. Hasta mediados del siglo XX se computaron al menos 22 patentes de este artilugio en Estados Unidos, si bien no existe registro ni testimonio de que alguna vez haya sido utilizado por una persona erróneamente declarada muerta.

¿Es posible declarar muerta a una persona viva?

A lo largo de la historia la forma de diagnosticar la muerte de una persona ha sufrido variaciones. Durante siglos se aceptó que la ausencia de respiraciones, de pulso, de latidos y de reacción a estímulos eran signos inequívocos de fallecimiento. Sin embargo, esos criterios no siempre eran determinados por un médico cualificado y podía existir cierta desconfianza en el diagnóstico.

Bajo esas circunstancias, y en aras de evitar el error de dar sepultura a alguien dado por muerto por error, nace la tradición del velatorio, cuya duración varía, según las culturas, entre uno y tres días. De hecho, en España, hasta el año 2011 era necesario esperar 24 horas antes de proceder al enterramiento de un cuerpo. Actualmente, la ciencia y la tecnología están suficientemente avanzadas como para no cometer errores de esa naturaleza. Aunque a veces, la prensa de hace eco de sucesos casi inverosímiles de “resucitaciones”.

¿Es posible que una persona declarada muerta “resucite”?

Cabría pensar que tal afirmación corresponde al mundo de la leyenda o del cine. Pero cuando durante la última década se ha realizado esta pregunta a una muestra de profesionales sanitarios, el 45% de los médicos de emergencias de Francia, el 37% de los intensivistas canadienses y el 37% de los holandeses respondieron que, durante su carrera, al menos habían sido testigos de un caso de autorresucitación de un paciente en ausencia de maniobras de reanimación cardiopulmonar.

De forma paralela, la literatura científica alberga casos documentados de pacientes que recuperaron las constantes vitales una vez cesadas las maniobras de reanimación cardiopulmonar o en ausencia de ellas. Un extraño suceso denominado “fenómeno de Lázaro”, en alusión al conocido pasaje bíblico.

Desde 1984, se tiene constancia de que el fenómeno de Lázaro ha afectado, al menos, a 63 pacientes clínicamente muertos, tanto en edad adulta como pediátrica. El tiempo desde el cese de las maniobras de reanimación hasta la recuperación espontánea de los signos vitales ha variado en un rango de pocos segundos hasta tres horas y media. El 35% de “los resucitados” sobrevivió hasta el alta del hospital y, en la mayor parte de las ocasiones, sin secuelas neurológicas.

No obstante, y a la vista de la elevada proporción de clínicos que, en privado, afirman haber presenciado una resucitación y la modesta descripción de casos en revistas especializadas, parece existir cierta infradocumentación de “fenómenos de Lázaro”. Esta escasez de información puede ser debida a temores de los clínicos frente a consecuencias médico-legales, de descrédito profesional o incluso por la incredulidad del personal asistencial ante sus observaciones. A diferencia de la literatura biomédica, los textos periodísticos se hacen regularmente eco de noticias que relatan hechos compatibles con el fenómeno de Lázaro.

¿Por qué se produce el fenómeno de Lázaro?

Aunque ya no se duda de la existencia de procesos de autorresucitación, en la actualidad se desconocen por qué mecanismos fisiopatológicos se producen los fenómenos de Lázaro.

Se han barajado varias hipótesis plausibles al fenómeno, aunque por sí solas no han logrado explicar la totalidad de los casos documentados.

Una de ellas tiene que ver con un posible efecto retardado de los fármacos utilizados durante la reanimación, como la adrenalina o el bicarbonato. Otras posibles explicaciones al fenómeno se han relacionado con la presencia de marcapasos funcionantes o la autorreperfusión miocardiaca tras el desprendimiento de placas de ateroma en las arterias coronarias.

Pero la hipótesis más razonable apuntaría a la existencia de un aumento de las presiones intratorácicas producida por la ventilación artificial. Este proceso podría desencadenar una disminución de la perfusión coronaria y el cese de la actividad del corazón. Al dar por finalizadas las maniobras de reanimación se provocaría la disminución la presión intratorácica y, tras ello, la recuperación espontánea del movimiento mecánico del corazón.

Sea como fuere, el fenómeno de Lázaro desafía al entendimiento humano. Una leyenda convertida en observación clínica a falta de explicación científica.![]()

Sobre el autor: Sendoa Ballesteros Peña es enfermero en Osakidetza- Servicio Vasco de Salud y profesor asociado a la Facultad de Medicina y Enfermería, Universidad del País Vasco / Euskal Herriko Unibertsitatea

Este artículo fue publicado originalmente en The Conversation. Artículo original.

El artículo ¿Puede un muerto regresar a la vida? se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Una infección vírica puede activar la aparición de diabetes tipo I

- Andar puede salvarte la vida

- El análisis del supercúmulo «El Gordo» limita qué puede ser la materia oscura

Beethoven y el metrónomo: los titubeos de un genio

Hace 8 años empecé a estudiar física en la UNED gracias, en parte, a la curiosidad inspirada por Naukas, una comunidad de divulgación científica a la que le estaré siempre agradecida. Hoy, 17 de diciembre y coincidiendo con el 250 aniversario del nacimiento de Ludwig van Beethoven, se ha publicado mi primer artículo científico en la revista PLOS ONE, firmado junto a Iñaki Úcar. Este trabajo fue inspirado inicialmente por un post de Francis Villatoro publicado en 2013. Su artículo de divulgación consiguió encender una chispa de curiosidad que culminó con mi TFG (dirigido por Álvaro Perea Covarrubias) y con el estudio que hoy os presento. Lo que sigue es un breve resumen de nuestro trabajo, traducido al castellano.

Las elecciones de tempo de los directores arrojan luz sobre el misterio del metrónomo de Beethoven

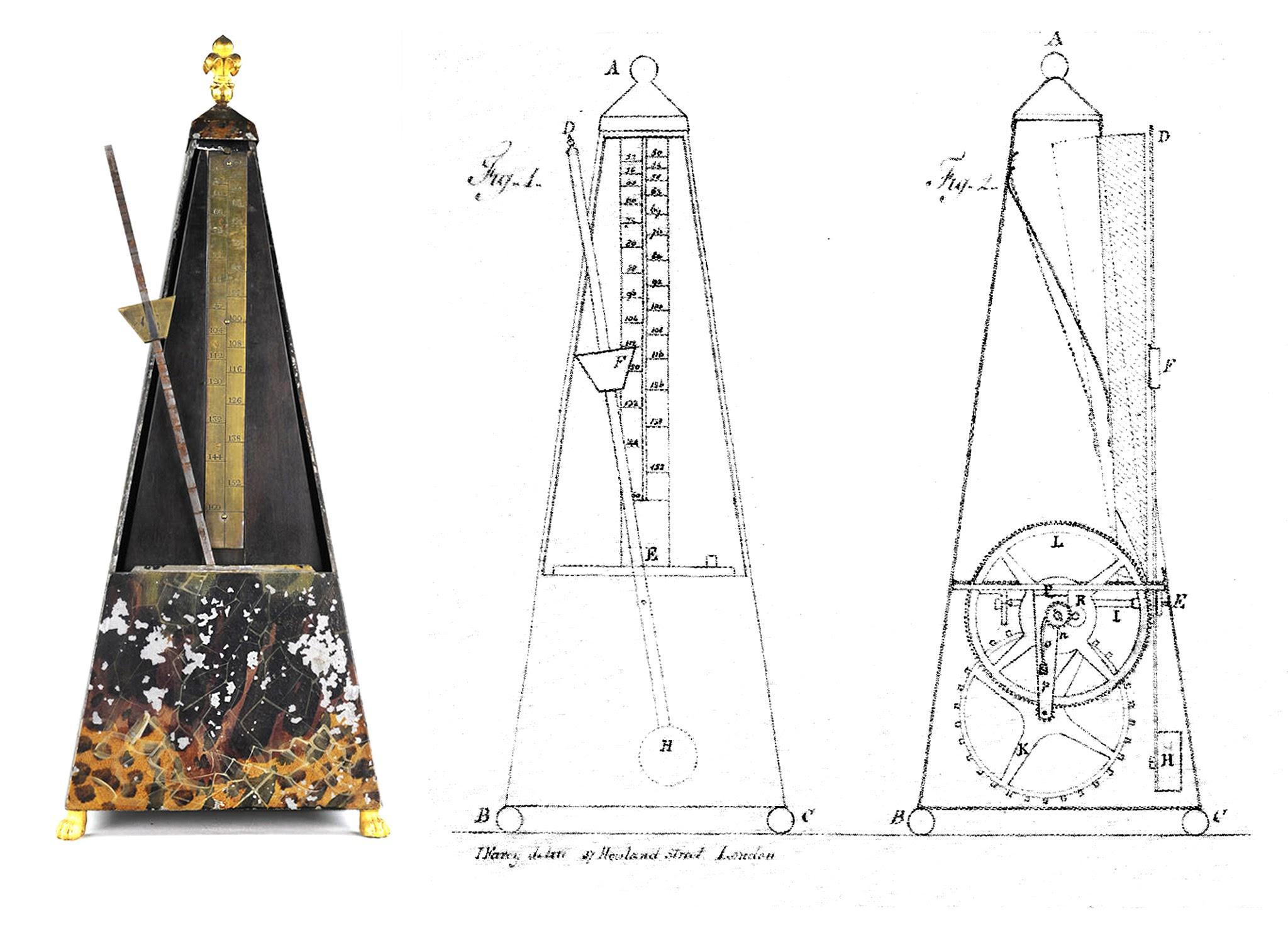

Durante la mayor parte de la historia de la música clásica occidental, el tempo, la velocidad a la que debe sonar la música, no era especificado en las partituras. En general, se consideraba obvio por el contexto musical. El metrónomo, un dispositivo que permite medir y cuantificar de manera precisa este tempo musical, no fue patentado hasta 1815. Beethoven acogió el invento con entusiasmo, hasta el punto de medir y añadir nuevas marcas a sus ocho sinfonías ya publicadas hasta esa fecha.

La gran paradoja de esta historia es que, a pesar de la implicación de Beethoven, estas marcas no han ayudado a clarificar el tempo de su música. Por el contrario, desde su publicación, han sido ampliamente disputadas: muchos intérpretes las consideran antimusicales o incluso demasiado rápidas para ser tocadas. Probablemente, el caso más paradigmático es el de la Sonata para piano Op. 106, también conocida como Hammerklavier, que comienza con una indicación completamente inviable de 138 ppm (pulsos por minuto). Esta y otras incongruencias han llevado a muchos artistas a ignorar estas cifras y usar otras pistas para determinar el tempo correcto de la música. Pero también hay quienes, buscando interpretaciones históricamente precisas, reivindican las marcas de Beethoven como su supuesta voluntad escrita. Desde la década de 1980, el movimiento HIP (por sus siglas en inglés, historically informed performances), definido por su intención de interpretar la música tal y como sonaba en la época en que fue concebida, ha culpado al romanticismo y a la escuela de dirección de Wagner por ralentizar las interpretaciones musicales de Beethoven.

El hecho de que no todas las marcas compartan la misma mala reputación ha desconcertado especialmente a los musicólogos. La explicación más controvertida e intrigante es la que se centra en el funcionamiento del propio metrónomo. Después de todo, Beethoven poseía una de las primeras unidades de un dispositivo recién inventado. Existen evidencias documentales de que al menos en dos ocasiones el compositor tuvo que llevarlo al relojero debido a su comportamiento inestable. ¿Pudo ralentizarse debido a algún daño mecánico, obligando a Beethoven a elegir marcas más rápidas de las que realmente pretendía?

Sobre la base de todo este debate, la cuestión clave es si la música implica cierto tempo que los intérpretes pueden estimar o si, en cambio, es una elección arbitraria que solo el compositor puede revelar. De hecho, hasta el siglo XIX, los compositores no tenían una forma de cuantificar la velocidad de la música. Solo podían usar indicaciones cualitativas (como Allegro, Andante, Grave) para caracterizar sus piezas. Pero incluso después de 1815, compositores como Brahms o Mendelssohn descartaron usar el metrónomo por considerarlo inútil, argumentando que cualquier músico debería poder inferir el «tempo correcto» para cualquier pieza. Hay estudios que sugieren que la información del tempo está codificada no solo en la melodía y el ritmo, sino también en otros atributos musicales como el tono, el timbre y la densidad de eventos. Como resultado, la combinación característica de melodía, armonía, ritmo, orquestación y notación dentro de una pieza pueden influir en la percepción de un tempo óptimo dentro de unos límites razonables.

En busca de ese tempo perceptivo, en este trabajo, hemos medido de manera automatizada los tempi de 36 integrales sinfónicas de Beethoven interpretadas por 36 directores diferentes. La idea es que, si el metrónomo es el culpable de las marcas exageradamente rápidas, una gran colección de tempi interpretados por diferentes directores debería revelar, en promedio, una desviación sistemática respecto a las marcas originales de Beethoven. Esta desviación podría explicarse por medio de algún fallo mecánico del metrónomo de Maelzel. Nos basamos, en última instancia, en la llamada «sabiduría de las masas». Los resultados muestran que todos los grupos de directores tocan más lento que lo indicado por Beethoven en aproximadamente 6, 8 y 13 ppm, respectivamente, en promedio.

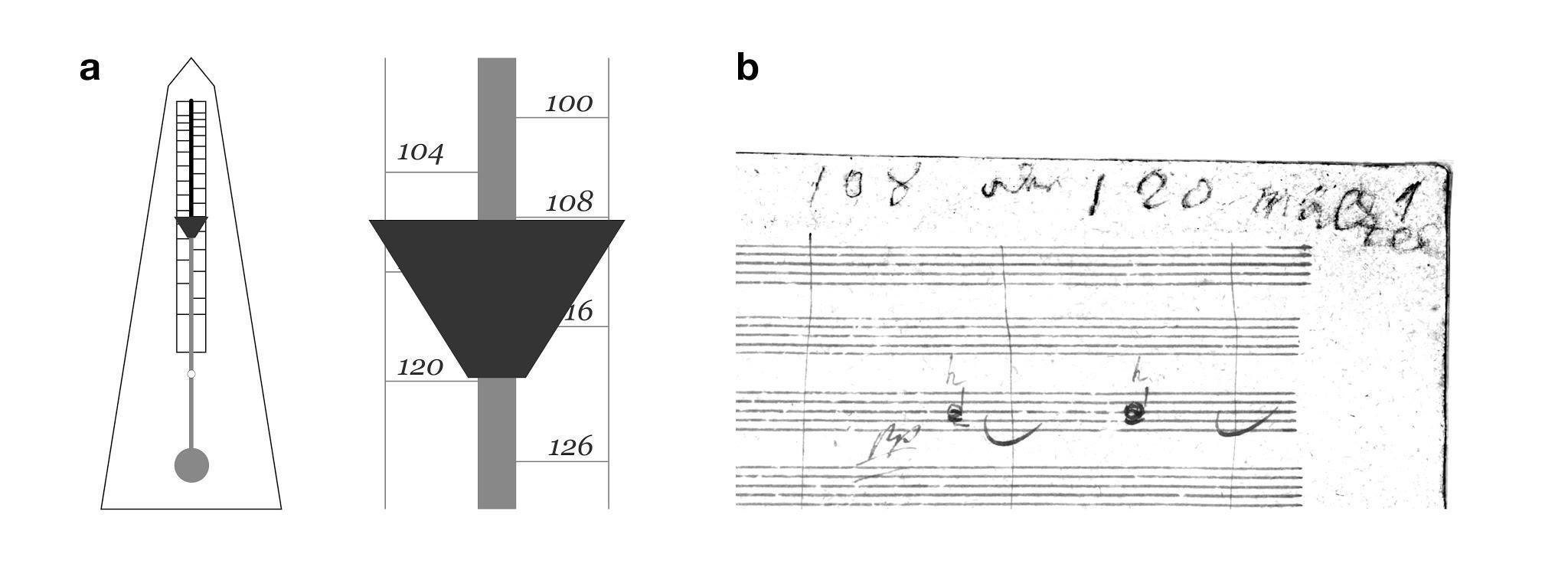

A continuación, desarrollamos un modelo matemático del metrónomo basado en un péndulo doble y validado experimentalmente con un metrónomo contemporáneo. También desarrollamos una metodología para estimar los parámetros originales del metrónomo de Beethoven a partir de fotografías de otros metrónomos de la época y el esquema de la patente original. Finalmente, usamos este modelo para evaluar posibles distorsiones: incluyendo la alteración de la masa inferior o un aumento de la fricción entre otras. La única perturbación que provoca una deceleración homogénea del metrónomo es un desplazamiento de la escala con respecto al eje de aproximadamente centímetro y medio.

Esto podría suceder si, por alguna razón, su mecanismo se hubiera caído dentro de la caja o la escala hubiese estado mal colocada. Sin embargo, hay otra explicación más simple. Por convención, la masilla del metrónomo debe colocarse bajo la marca que se quiere reproducir. En los primeros metrónomos, esta masilla medía, precisamente, centímetro y medio de alto y una forma trapezoidal apuntando hacia abajo (ver figura). Esto podría haber llevado a sus usuarios a leer la marca del metrónomo por debajo del peso en movimiento, en lugar de por encima. Al anotar las cifras debajo de esta aparente flecha, las marcas de Beethoven habrían resultado más rápidas de lo que el compositor realmente pretendía, precisamente, por 12 bpm. Este número, por supuesto, no es accidental: como hemos mostrado, es aproximadamente la diferencia promedio entre las elecciones de tempo de los directores románticos y las anotaciones de Beethoven.

¿Pudo Beethoven realmente cometer semejante error? En la primera página del manuscrito de la Novena Sinfonía, hay una inscripción reveladora de su propio puño y letra: “108 o 120 Maelzel”. Algunos académicos han interpretado este texto como prueba del pobre estado mental de Beethoven, su indecisión o, quizás, como un rango de tempi preliminar aún pendiente de refinar. Pero la gran diferencia entre estas dos cifras hace que semejante vacilación sea improbable para un compositor que tan a menudo insistió en la importancia del tempo como parte esencial de su música. Además, si Beethoven hubiese querido delimitar un posible rango de tempi, habría escrito “108-120”, no “o” (palabra que en alemán es inconfundible: oder). Como hemos aclarado en este trabajo, la distancia entre 108 y 120 en la escala, 1.5 cm, coincide exactamente con el tamaño del peso en movimiento del metrónomo. Esta inocente anotación constituye una prueba escrita de que, después de tanto tiempo usando el dispositivo, hubo un momento al menos, en el que Beethoven no estuvo seguro sobre cómo leerlo.

Nuestro trabajo descarta la hipótesis de la ruptura de Beethoven y arroja luz sobre una controversia de 200 años entre críticos, intérpretes y académicos. La hipótesis más probable es que Beethoven o su asistente malinterpretaran el dispositivo, lo que no debe tomarse como un error tonto, sino como un síntoma de un diseño que aún no se había perfeccionado y que aún carecía del contexto cultural para apoyar a sus nuevos usuarios. Quizás, con ayuda de los datos y la física, los intérpretes encuentren una nueva forma de interpretar y escuchar a Beethoven.

Referencia:

Martín-Castro A., Ucar I. (2020). Conductors’ tempo choices shed light over Beethoven’s metronome. PLOS ONE: e0243616. doi: 10.1371/journal.pone.0243616

Sobre la autora: Almudena M. Castro es pianista, licenciada en bellas artes, graduada en física y divulgadora científica

El artículo Beethoven y el metrónomo: los titubeos de un genio se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El genio cegado por su propia teoría

- Un genio desconocido del Renacimiento

- Cuando Galileo medía el tiempo en corcheas

Cuando la probabilidad te avisa de que no juegues

Uno de los libros de divulgación de las matemáticas que más me influyó en mi juventud fue El hombre anumérico, El analfabetismo matemático y sus consecuencias (Tusquets, 1990), del matemático y divulgador estadounidense John Allen Paulos.

Portada de la edición en castellano de 1990, de la editorial Tusquets, del libro El hombre anumérico de John Allen Paulos, junto con una fotografía del matemático sacada de la propia página web

Portada de la edición en castellano de 1990, de la editorial Tusquets, del libro El hombre anumérico de John Allen Paulos, junto con una fotografía del matemático sacada de la propia página web

El libro está lleno de interesantes ejemplos sobre la importancia de entender la probabilidad y cómo en ocasiones esta nos demuestra que nuestra intuición se equivoca. Muchos de estos ejemplos los he rescatado para mis artículos, conferencias, talleres y libros, como la conocida paradoja del cumpleaños, aunque seguramente mi primera lectura de la misma fue de la mano del gran maestro de la divulgación matemática, el estadounidense Martin Gardner (1914-2010), en su libro ¡Ajá! Paradojas. Paradojas que hacen pensar (Labor, 1983); el bonito ejemplo de la probabilidad de que llueva el fin de semana, que utilicé para el video de la sección Una de mates del programa de La 2 de televisión española Órbita Laika que podéis ver en la entrada Una de mates: la probabilidad de que llueva el fin de semana; el ejemplo de los falsos positivos en las pruebas médicas para detectar una enfermedad, con el que inicié la entrada Falsos positivos o la importancia de comprender la información; o el juicio en California “a la mujer rubia peinada con una cola de caballo y al hombre negro con barba y bigote”, ejemplo del mal uso de la probabilidad en los juicios (otros ejemplos de este estilo aparecen en la entrada La probabilidad en el banquillo de los acusados).

Una probabilidad continua (2011), del artista estadounidense Reed Danziger. Imagen de la página web del artista

Una probabilidad continua (2011), del artista estadounidense Reed Danziger. Imagen de la página web del artistaEn el capítulo Probabilidad y coincidencia de El hombre anumérico también se incluían ejemplos sobre el lanzamiento de una moneda al aire. La probabilidad de que salga cara, o cruz, cuando lanzamos una moneda al aire –que en cualquiera de los dos casos es del 50%–, es el primer ejemplo que siempre se utiliza para explicar el concepto matemático de probabilidad, del que además derivan situaciones más complejas e incluso anti-intuitivas.