Corazones

La semana pasada me ocupé de los sistemas circulatorios, y especialmente de la circulación general humana. Pero la bomba de impulsión, aunque citada, no recibió atención ninguna. Vamos, pues, con los corazones y otros sistemas de bombeo.

Algunos animales han recurrido a los flagelos como mecanismo de impulsión de líquidos; es el caso de las esponjas, que los utilizan para impulsar el agua que pasa a través de sus poros, o de los erizos de mar, que consiguen de esa forma hacer circular el líquido de su cavidad celómica.

Saltamontes (Imagen: Wikipedia)

Otros han desarrollado dispositivos que provocan el movimiento de fluidos mediante el concurso de músculos o de elementos esqueléticos. Lo normal es que esa forma de impulsión se produzca solo cuando el animal se mueve. Cuando una estrella de mar utiliza su musculatura para mover sus brazos también provoca el movimiento de su líquido celómico. En muchos artrópodos, los movimientos de la musculatura del exoesqueleto y de la pared corporal ayudan a impulsar la hemolinfa; en los saltamontes, por ejemplo, el corazón principal solo late cuando están inactivos, porque cuando se mueven el movimiento de la musculatura extrínseca es suficiente para desarrollar la actividad de impulsión necesaria para alimentarla. En vertebrados también hay dispositivos basados en musculatura esquelética que impulsan la sangre. Un ejemplo es el corazón caudal de los peces bruja (mixinos), al que me referiré más adelante. Y similar a ese dispositivo es el de las venas de las extremidades inferiores humanas, que ayudan a que la sangre venosa ascienda hasta el corazón.

Persitaltismo (Fuente: Auawise, Wikipedia)

Otra modalidad de impulsión se basa en el peristaltismo. La impulsión peristáltica se produce cuando una musculatura propia del conducto (vaso sanguíneo u otro tubo) se contrae y esa contracción se desplaza en una dirección determinada. El desplazamiento de la contracción empuja el contenido del tubo en esa dirección y lo desplaza. Cuando ese dispositivo se encuentra en secciones especializadas de los vasos, se les denomina corazones peristálticos. Es la forma de bombeo de muchos anélidos, como los gusanos de tierra, y de bastantes artrópodos.

Y por último tenemos los corazones musculares camerales, que son los más conocidos. Consisten en cámaras provistas de una musculatura específica que al contraerse desplaza el líquido contenido en su interior. Son, normalmente, las bombas de impulsión principales en todos los vertebrados y muchos artrópodos y moluscos. Las cámaras necesitan de sendas válvulas en los dos extremos para garantizar el flujo de la sangre en una dirección. El corazón de los artrópodos es monocameral (consta de una sola cámara), pero en la mayoría de los moluscos y todos los vertebrados tiene, al menos, dos cámaras, una aurícula, que recibe el líquido que retorna al corazón, y un ventrículo que es el que genera la fuerza primaria para impulsar la sangre que se dirige al resto del organismo.

Vista interna de un corazón humano (Imagen: Jana Oficial, vía Wikipedia)

Los corazones de los vertebrados fueron originariamente bicamerales, pero ese esquema se modificó con la aparición de los primeros peces capaces de respirar en aire. A partir de ese momento empezó a desarrollarse un segundo circuito, el de la circulación pulmonar, que conecta el corazón con los pulmones. Las dos cámaras originales se empezaron a subdividir mediante paredes internas. De esa forma, un lado de la aurícula recoge la sangre procedente del cuerpo y el otro lado la procedente de los pulmones; y a la vez, un lado del ventrículo envía la sangre al conjunto del organismo y el otro lo hace a los pulmones. Ese proceso de separación se completa en aves y mamíferos, que tienen corazones cuatricamerales, aunque en realidad podría hablarse de dos bombas diferentes, aunque funcionando de manera acompasada, cada una con su aurícula y su ventrículo.

Función de las válvulas

En aves y mamíferos la arteria aorta es la vía de salida del ventrículo izquierdo hacia la circulación sistémica y las venas cava, las de retorno al corazón -a su aurícula derecha-; esa sangre es a continuación impulsada por el ventrículo izquierdo, a través de las arterias pulmonares, a los pulmones, y retorna del órgano respiratorio a la aurícula izquierda a través de las venas pulmonares. Un completo sistema de válvulas en puntos clave es el que garantiza la correcta dirección del flujo sanguíneo.

Como ya se ha indicado, además del corazón principal, en muchos animales hay bombas auxiliares de impulsión. Los gusanos de tierra, por ejemplo, tienen numerosos vasos peristálticos además de los vasos dorsales especializados como corazones peristálticos principales. También los insectos disponen de corazones auxiliares en la base de patas, alas y antenas.

Los cefalópodos, que son los únicos moluscos con un sistema circulatorio cerrado, tienen dos corazones branquiales auxiliares además del corazón principal; esos dos corazones impulsan la sangre a través de las branquias. Es posible que gracias a ellos consigan pulpos y calamares impulsar a través de sus órganos respiratorios una sangre de gran viscosidad debido a su elevada concentración de hemocianina, necesaria, a su vez, para satisfacer la demanda metabólica tan alta que generada su muy activo modo de vida.

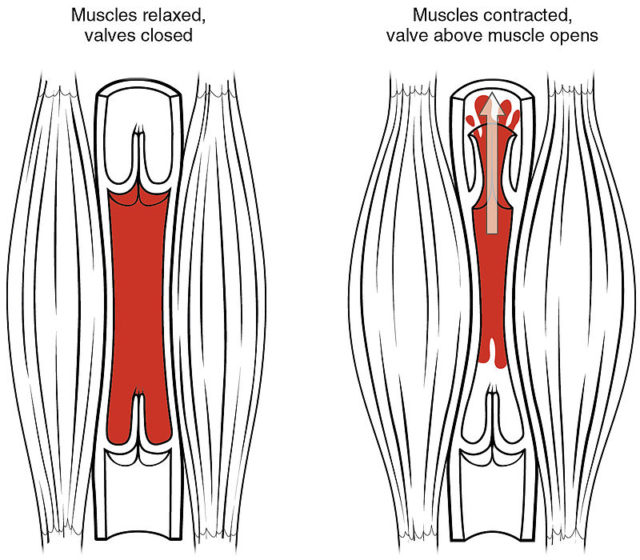

Bomba venosa muscular (Imagen: OpenStax College, vía Wikipedia)

Los mixinos tienen varios corazones auxiliares. El más importante es el corazón caudal, que está formado por dos cámaras alargadas entre las cuales hay una estructura cartilaginosa flexible que se comba alternativamente a derecha e izquierda siguiendo el movimiento de la cola. Al combarse comprime una de las dos cámaras y distiende la otra, succionando y expulsando, respectivamente, la sangre contenida en su interior. Sendas válvulas colocadas en los extremos anterior y posterior de cada cámara determinan que el flujo sea unidireccional. Por otro lado, los dispositivos con que cuentan las venas de nuestras piernas cumplen una función similar (ver imagen superior). Ayudan a impulsar la sangre venosa de vuelta al corazón al ser presionadas y comprimidas por los músculos que las rodean; el retorno de la sangre al corazón se produce gracias a la presencia de válvulas en esas venas, que evitan el flujo sanguíneo hacia abajo y desplazan la sangre hacia arriba. Por eso no es aconsejable estar de pie durante mucho tiempo sin mover las piernas.

Para concluir, disfruten de este notable pasaje de una de las mejores películas españolas, Amanece que no es poco.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Corazones se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Un viaje a través del sistema circulatorio humano

- Corazones cámbricos

- La distribución del agua animal y el curioso caso del potasio

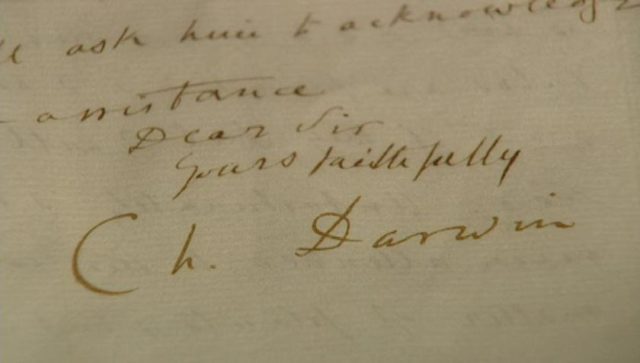

Las transmutaciones de van Helmont (2)

La teoría química de van Helmont es una mezcla muy curiosa de lo más avanzado con lo más arcaico. Muchos en el siglo XVII aceptaban como transmutación el hecho de que los metales se disolviesen en ácido; obviamente, el concepto de moderno de disolución no estaba establecido. También se aceptaba como transmutación el hecho de que una herradura de hierro dejada en un arroyo cercano a minas de cobre (y, por tanto, rico en sales de cobre disueltas) terminase recubierto por una capa de cobre. Sin embargo, para van Helmont estos dos fenómenos claramente no eran transmutaciones, pero eso no impedía que siguiese creyendo en la posibilidad.

De hecho, dejó escrito una anotación en la que relataba lo que el creía sinceramente que había sido una transmutación de 8 onzas de mercurio en oro conseguida mediante la adición de un cuarto de grano (el grano era una medida de peso equivalente al peso medio de un grano de trigo, equivalente a 0,0648 g) de un polvo amarillo suministrado por un extraño (véase el paralelismo con la presunta transmutación de Helvetius).

Es difícil saber con los datos proporcionados qué presenció van Helmont en realidad. El mercurio es conocido por su capacidad para combinarse formando amalgamas y compuestos, por lo que podría haber incorporado algún tipo de material de color amarillo metálico y volverse sólido al hacerlo. Con todo, no es fácil encontrar algún producto que tenga ese efecto en unas cantidades tan pequeñas para 8 onzas de mercurio. Pero recordemos que en esta época los alquimistas estafadores se habían vuelto realmente sofisticados y, por ejemplo, nada impide que el extraño no solo diese el polvo amarillo sino que lo entregase en un recipiente en el que debía realizarse la mezcla para que no se perdiese parte en el trasvase, y que fuese este recipiente el que aportase realmente la parte que efectivamente hacía que la reacción ocurriese.

Y así van Helmont osciló entre revolucionario y reaccionario toda su vida. Rechazó los cuatro elementos aristotélicos (jugándose, literalmente, el cuello) y los tres principios de Paracelso, pero los reemplazó por aire y agua, señalando la creación de los cielos y el agua en el segundo día del Génesis como fundamento. El aire era solamente un medio físico, por lo que , en última instancia, todo se reducía a agua. Pero, por otro lado, hizo un uso intensivo de la balanza y como consecuencia de él llegó al convencimiento de que nada se crea o se destruye en una reacción química (la ley de conservación de la materia es anterior a Lomonósov o Lavoisier), aunque no lo expresó explícitamente.

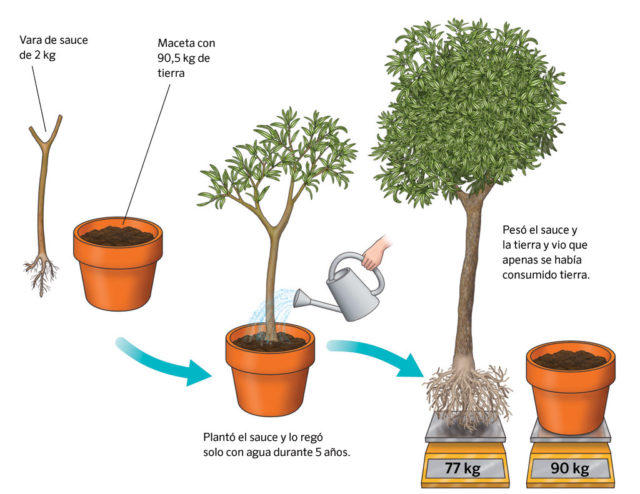

Su famoso experimento del sauce ilustra perfectamente sus planteamientos y, significativamente, el tipo de experimentación que llevaría en última instancia al surgimiento de la química como ciencia. En este experimento pesó una plántula de sauce y la sembró en una cuba con exactamente 200 libras de tierra previamente desecada; cubrió la cuba para impedir que el polvo o cualquier otra cosa se añadiese a la tierra. Después de regarla con agua destilada y verla crecer durante 5 años, sacó el pequeño sauce de la tierra con gran cuidado y lo volvió a pesar. Encontró que el árbol había incrementado su peso sustancialmente pero que la tierra pesaba muy poco menos de 200 libras. Hasta aquí el experimento y los datos. Su interpretación es otra cosa. De ellos van Helmont extrajo la conclusión de que el agua aportada se había convertido en madera de sauce.

Obviamente el experimento carece de otros controles mínimos, como llevar un registro del peso de agua aportada, de las pérdidas por evaporación o filtrado fuera de la cuba o posibles derrames. Ni que decir tiene que van Helmont no tenía idea del papel que juega el dióxido de carbono del aire en la biología de la planta, ni de que ésta emitía oxígeno. Pero la idea básica está ahí: la cantidad de materia hay que controlarla con la balanza. Lo que fuese que se introdujese en una reacción tenía que aparecer en los resultados de una forma u otra.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Las transmutaciones de van Helmont (2) se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Jan van Helmont, filósofo por el fuego (1)

- El siglo de la esquizofrenia química

- Libavius y el primer libro de texto químico

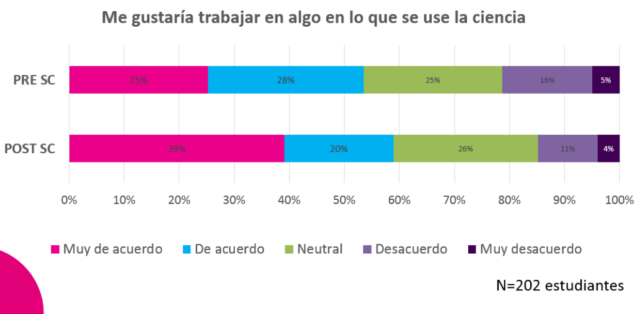

Científicos y estudiantes se encuentran a través de Internet

Ángela Monasor

“¿Qué haces cuándo te confundes?, ¿Crees que en el futuro viviremos en ciudades submarinas?, Cuando descubrís algo nuevo, ¿a quién se lo contáis?, Dedicándose a la ciencia, ¿se liga igual? ” Estas son algunas de las preguntas que estudiantes de 11 a 18 años de todo el territorio español envían a los investigadores participantes de Somos Científicos, ¡sácanos de aquí!.

En Somos Científicos, los estudiantes desafían a científicas y científicos a través de CHATS de texto, les PREGUNTAN todo lo que se les ocurra, y VOTAN para que el científico o científica que quieran gane 500 € destinados a divulgar su trabajo. Todo esto ocurre a través de Internet en somoscientificos.es

Diferentes informes apuntan a que para mejorar la comprensión pública de la ciencia es más importante facilitar la comprensión del proceso científico – cómo funciona la revisión por pares, cómo se ponen a prueba las hipótesis, cómo surge el consenso científico… – que explicar hechos concretos. De esta manera, y en las palabras de uno de los científicos participantes, Daniel Gómez Domínguez, «Somos Científicos acerca la forma de pensar en ciencia, a través del científico.»

Los estudiantes comprueban que quienes se dedican a la investigación científica son personas normales, ven cómo lo que aprenden en clase se aplica en la vida real, y sus aspiraciones científicas aumentan.

Somos Científicos llega a donde otras actividades no pueden. Al tratarse de un proyecto online, alcanza centros educativos que los científicos no suelen visitar; como el CP Amescoas, en Zudaire (localidad de 200 habitantes a 60 minutos en coche de la ciudad más próxima), o el IES Miguel Fernández, en Melilla. Investigadores como José Miguel Rodríguez Espinosa astrofísico en la pequeña isla de la Palma o Daniel Pastor Galán, estudiando terremotos en Japón, se comunican con estudiantes en una experiencia imposible de manera presencial.

Pero los límites van más allá de la geografía. El hecho de que la participación sea anónima y que cada estudiante decida sobre qué quiere hablar, dentro de un entorno seguro, iguala el terreno de juego de cada clase; beneficiando a quienes no siempre tienen la confianza para hablar en público.

Tan importante es favorecer la diversidad de estudiantes, como del personal investigador. Para ello implantamos cuotas de género en nuestra selección de participantes, un modelo de rol para cada estudiante. En este sentido, Somos Científicos parece tener mayor impacto positivo en cómo ven la ciencia las chicas. Pensamos que esto puede estar relacionado con la naturaleza social de la actividad; las chicas hacen más preguntas y suelen decantarse por cuestiones personales; como las motivaciones para dedicarse a la ciencia, los retos de futuro o las dificultades del día día.

No sólo pensamos en las clases. Cada vez hay más evidencias de que el personal investigador se beneficia de comunicarse con la sociedad. Ben Still, uno de los primeros participantes de la versión británica de Somos Científicos lo describió como «el mejor curso intensivo de comunicación de ciencia». Ceri Brenner, otra participante, presume de haber acuñado la definición de su investigación que hoy utiliza como presentación en cenas con amigos, comités científicos, o solicitudes de becas, durante la actividad.

Somos Científicos sirve como plataforma de lanzamiento de divulgadores: anima a los investigadores a divulgar y les ayuda a mejorar sus habilidades comunicativas, obtener una nueva visión de su trabajo y descubrir lo que los jóvenes piensan acerca de la ciencia y de quienes se dedican a ella.

Es por esto que seleccionamos nuevos participantes para cada actividad. Desde abril de 2016, hemos puesto en contacto a 35 científicos con 3500 estudiantes. Nuestra siguiente actividad será del 8 al 19 de mayo, y tras ella esperamos aumentar las cifras hasta 55 científicos y 5000 estudiantes.

Aquí puedes ver quiénes protagonizarán “Somos Científicos” en mayo, y puedes seguir todas nuestras actualizaciones en el Twitter de @S_Científicos y en la etiqueta #SCientíficos.

Si te ha picado el gusanillo y quieres participar en siguientes ediciones, apúntate ya:

- Si eres docente: somoscientificos.es/profesores/

- Si investigas: somoscientificos.es/inscripcion-de-cientificos/

Si necesitamos convencerte un poco más, echa un vistazo a nuestro vídeo:

Estos son los participantes del País Vasco que estarán en “Somos Científicos” mayo 2017:

Como investigadores, participarán Eder Amayuelas López, estudiante de doctorado de la Facultad de Ciencia y Tecnología de la Universidad del País Vasco, e Isabel García Barón, estudiante de doctorado de la Fundación AZTI.

Entre los centros educativos participantes están el IES Saturnino De La Peña, de Sestao; el Colegio La Salle, de Bilbao y el Colegio Summa Aldapeta de San Sebastián.

Sobre la autora: Ángela Monasor es farmacéutica y se doctoró con una tesis sobre señalización molecular en el Centro Nacional de Investigaciones Oncológicas. Dirige Somos Científicos, ¡sácanos de aquí! a través de Kialo Comunicación y Divulgación Innovadora.

El artículo Científicos y estudiantes se encuentran a través de Internet se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Científicos a examen

- Ciencia para todos a través del cine y la literatura de ciencia ficción

- Por qué los estudiantes de más éxito no tienen pasión por el colegio

El test de Allen a examen

Un Trabajo Fin de Grado de la UPV/EHU duda sobre la fiabilidad y validez del test de Allen practicado en servicios de urgencias médicas y unidades de cuidados intensivos (UCI). La maniobra busca relacionar la calidad de la circulación sanguínea de la mano con el riesgo de isquemia (falta de riego sanguíneo) y se efectúa siempre antes de una punción arterial o colocación de un catéter sobre la arteria radial de la mano. Este trabajo, realizado por el graduado en Enfermería Oscar Romeu Bordas, ha sido dirigido por Sendoa Ballesteros Peña, profesor de la Facultad de Medicina y Enfermería.

Antes de realizar una punción arterial en la mano o colocar un catéter radial, el personal sanitario debe comprobar la calidad de la circulación sanguínea. De esta manera, se intenta predecir la falta de riego sanguíneo (isquemia) que podría desembocar en una complicación grave como la muerte de los tejidos de la mano (necrosis). De forma rutinaria, se utiliza la maniobra de Allen. El procedimiento es el siguiente: con la palma boca arriba, se cierra la mano en un puño. Se presiona con los dedos y al mismo tiempo las arterias radial y cubital a ambos lados de la muñeca para comprobar que la palma adquiere un color pálido. Se libera la presión sobre la arteria cubital, pero se mantiene sobre la radial. Con esta técnica se simula el efecto que tendrá una punción o la colocación de un catéter y valora la capacidad de la arteria cubital para asumir la totalidad del riego sanguíneo de la mano. Cuando pasan 10-15 segundos y no se ha restablecido la coloración normal de la palma de la mano se considera que constituye una contraindicación para la punción de la arteria radical por el elevado riesgo de isquemia debido a un déficit en la circulación colateral de la mano.

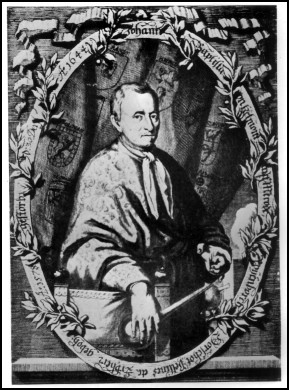

La técnica del test de Allen, descrita inicialmente en 1929 por el médico Edgar Allen, se realiza, por tanto, desde hace casi 90 años; y, aunque es habitual sobre todo en los servicios de Urgencias y UCIs, ni el propio creador pudo verificar la validez del test.

Oscar Romeu Bordas, en su investigación, ha revisado y analizado todos los ensayos realizados hasta la actualidad en inglés y español sobre la validez del test de Allen. En concreto, acudió a seis bases de datos (Medline, Scopus, Web of Science, EMBASE, Cochrane plus y CINAHL) donde se localizaron 14 estudios pertinentes. Estos artículos comparan los resultados de la técnica de Allen y la ecografía Doppler para evaluar la circulación colateral palmar y evalúan las complicaciones isquémicas tras punciones de la arterial radial.

Tras el análisis, el graduado en Enfermería concluye que la prueba no permite asegurar al 100% cuál es la calidad de la circulación sanguínea de la mano, ni prevenir la aparición de una isquemia tras la punción arterial. Además, el Trabajo Fin de Grado sugiere que esta técnica se puede eliminar de los protocolos y manuales asistenciales, porque, además, podría limitar de manera innecesaria técnicas terapéuticas de primera elección, como un cateterismo radial.

Referencia:

Romeu-Bordas O, Ballesteros-Peña S. Validez y fiabilidad del test modificado de Allen: una revisión sistemática y metanálisis. Emergencias. 2017;29:126-35.

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo El test de Allen a examen se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Test de personalidad matemático

- Máquinas inteligentes (I): Del molino de viento al test de Turing

- Científicos a examen

Domesticados

Los seres humanos nos hemos relacionado intensa y cordialmente con los perros a lo largo de gran parte de nuestra historia. Convivimos desde hace miles de años. La prueba más sólida de asociación entre ambas especies –restos caninos enterrados junto a restos humanos- data de hace 15.000 años, pero es muy probable que nuestra relación “amistosa” comenzase bastante antes. Seguramente los perros se empezaron a asociar con nuestros antepasados cuando estos todavía eran cazadores-recolectores. Y sin embargo, es mucho lo que desconocemos de los canes.

Como cuentan Raymond Coppinger y Lorna Coppinger (2016) en What is a dog? (¿Qué es un perro?), en Norteamérica, Europa y otros países desarrollados viven alrededor de ciento cincuenta millones de perros. Son sobre todo mascotas, animales de compañía. De ellos depende un importante sector de actividad económica, que incluye cría, venta y entrenamiento, así como cuidados sanitarios, alimentación, libros y revistas; son, indudablemente, un claro producto del mundo desarrollado. Casi todas las mascotas son perros de raza: dogo, pastor alemán, galgo, pointer, chihuahua, pequinés o cualquier otra; sus rasgos han sido seleccionados de forma artificial por el sencillo y eficaz procedimiento de controlar su reproducción. Sin embargo, en el mundo hay muchísimos más perros: son del orden de mil millones. En otras palabras, los de raza sólo representan un 15% de todos los canes. Quienes esto lean se preguntarán, perplejos, por el 85% que falta. Pues bien, los que faltan, la gran mayoría, son esos a los que llamamos chuchos, perros callejeros o, como se denominan en algunos países por sus hábitos alimenticios, perros de basurero.

La mayoría de la gente piensa que los chuchos son la variedad de perro que surge cuando los de raza se cruzan entre sí, cuando, por las razones que fuere, se reproducen al margen del control de sus dueños. Pero eso no es así. En los países occidentales no es habitual encontrarse con un chucho por la calle. Es fácil adivinar el porqué. Pero abundan en los barrios y basureros de las grandes ciudades de muchos países. No pertenecen a nadie. Se encuentran cerca de la gente porque es así como se alimentan. Y no han surgido de ningún cruce entre perros de raza. Se parecen mucho unos a otros, tanto como una persona se parece a otra, aunque vivan en las antípodas. Pero si no son el resultado de cruces de perros de raza, ¿de dónde han salido? ¿cómo han surgido? Y la respuesta es muy sencilla: los perros callejeros proceden de los cánidos que empezaron a asociarse con los seres humanos hace decenas de miles de años. Durante milenios la selección natural ha propiciado la aparición de rasgos que les permiten vivir como lo hacen, alimentándose de los recursos que desechamos y que, de forma directa –dándoselos- o indirecta – en vertederos- ponemos a su disposición. Son los herederos de los cánidos que acompañaban a los seres humanos que empezaron a desechar alimento, probablemente a partir del desarrollo de la agricultura y la ganadería, en el Neolítico.

Los chuchos se han adaptado perfectamente al medio en el que viven. Y en esa adaptación hay un elemento especialmente significativo. Aunque lobos, coyotes, chacales y dingos también frecuentan basureros en busca de comida, sólo lo hacen cuando no hay gente cerca. Ese es quizás el rasgo más valioso de los perros: su capacidad para convivir con nosotros, para vivir en nuestro mismo entorno y, lo que es más importante, para ser de nuestro agrado. Gran parte de su éxito obedece a que los perros nos caen bien. Y es que, en cierto modo, somos nosotros los domesticados.

—————————-

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

————————

Una versión anterior de este artículo fue publicada en el diario Deia el 20 de noviembre de 2016.

El artículo Domesticados se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:#Naukas16 Te vamos a salvar la vida

Ignacio López Goñi nos habla de patógenos en esta charla digamos que virulenta y, ¿por qué no?, poliexplosiva, que hizo las delicias del público asistente.

Ignacio López Goñi: ''Te vamos a salvar la vida''Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo #Naukas16 Te vamos a salvar la vida se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- #Naukas13 Una entre billones, la variable que sustenta la vida

- #Naukas16 ¿Cómo saber si tu funeraria te estafa?

- #Naukas16 La ciencia de la pasión

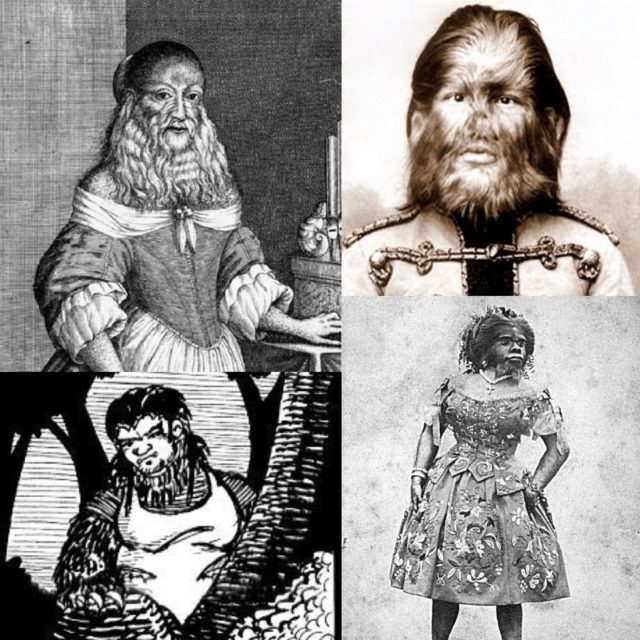

La hipertricosis del guanche que inspiró a la Bestia

No hace mucho que se estrenó la nueva versión del clásico de Disney, La Bella y la Bestia, en la que los dibujos animados dejan paso a los actores y actrices de carne y hueso y a las imágenes generadas por ordenador, y como ha ocurrido en anteriores ocasiones, está siendo todo un éxito en pantalla.

La historia que cuenta Disney en la Bella y la Bestia se basa en el cuento homónimo de la escritora francesa Jeanne-Marie Leprince de Beaumont (La Belle et la Bête), que a su vez se basó en el relato que escribió Gabrielle-Suzanne Barbot de Villeneuve, también francesa. ¿Pero en que se inspiró esta última para idear el cuento? Pues parece estamos ante una narración basada en hechos reales.

Las dos versiones originales del texto en que se basa La Bella y la Bestia

El protagonista real de la historia se llamaba Pedro González, supuestamente el hijo del jefe de una tribu guanche, natural de Tenerife, donde vino al mundo en el año 1537. Si no fuera por el detalle de que nació con una característica que no pasaba precisamente desapercibida, y que hizo que fuera abandonado en un orfanato en la isla, hubiera llevado una vida bastante normal, pero su cuerpo estaba recubierto completamente de pelo.

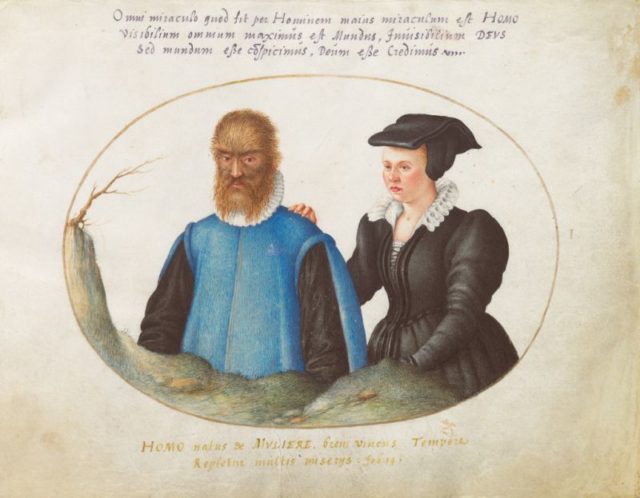

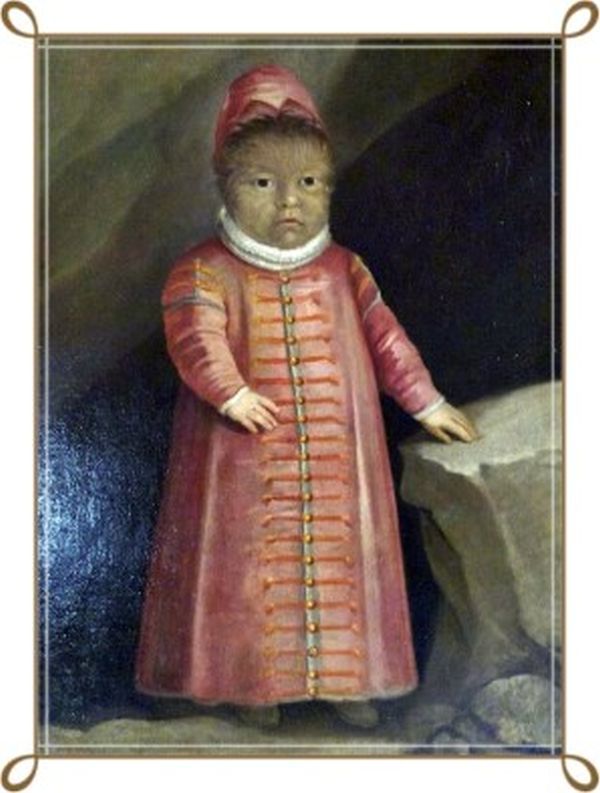

A esta condición se le llama hipertricosis, aunque en ocasiones se usa un nombre más llamativo, como es síndrome del hombre lobo o síndrome de Ambras. Este último nombre se debe a varias pinturas de Pedro González que se encuentran en el Castillo Ambras, en Innsbruck, Austria, donde están representados tanto él, como su esposa y también dos de sus hijos.

Retrato de Pedro González

La hipertricosis es una condición muy poco frecuente, que destaca por provocar un aumento considerable de la cantidad de pelo en el cuerpo, pudiendo ser localizada en zonas específicas, como ocurre con la hipertricosis auricular, o en todo el cuerpo, como ocurre en la hipertricosis general. En este último caso, las personas que la padecen suelen estar cubiertas completamente de vello, a excepción de las palmas de las manos y de los pies. Los casos de este tipo son tan extraños y llamativos, y dependen de tantos mecanismos diferentes, que es difícil generalizar sobre ella, pero en concreto del tipo de hipertricosis que vamos a hablar a continuación, y que se supone que tenía Pedro González, sólo se han documentado unos cincuenta casos desde la Edad Media hasta la actualidad.

Pedro González nació ya con esta condición, que también puede aparecer a lo largo de la vida, cuando no es congénita. Pero entre las formas congénitas nos encontramos una extensa clasificación, partiendo principalmente de las localizadas y las generalizadas.

– Las localizadas son las siguientes: Nevus congénito, nevus de Becquer, hamartoma de músculo liso, hipetricosis nevoide, neurofibromas, hipertricosis cubital, hemihipertrofia, malformaciones pilosas en palmas y en plantas, hipertricosis auricular, disrafismo espinal e hipertricosis anterior cervical.

– Las generalizadas son las siguientes: hipertricosis lanuginosa congénita o síndrome de Ambras, hipertricosis congénita generalizada o ligada al X, fibromatosis gingival asociada a hipertricosis, osteocondrodisplasia asociada a hipertricosis, síndrome de Landrach-de Lande, síndromes por teratógenos, lipoatrofia, mucopolisacaridosis, síndrome de piel tiesa, síndrome de Winchester, síndrome de Rubinstein-Taybi, síndrome de Schinzel-Giedion, síndrome de Barber-Say, síndrome de Coffin-Siris, displasia hemimaxilofacial, disostosis craneofacial, hipomelanosis de Ito y síndrome MELAS.

Jesús “Chuy” Aceves, un mexicano con hipertricosis

Probablemente Pedro González tenía una hipertricosis lanuginosa, en la que el cuerpo del bebe nace cubierto completamente de lanugo. Este término alude al vello corporal muy fino, que crece sobre la piel en ausencia de grasa, para que pueda servir como aislante térmico. Está presente en los fetos durante el desarrollo embrionario normal y se suele perder aproximadamente a las 40 semanas de edad gestacional. En el caso de Pedro, el lanugo permaneció más tiempo, siendo sustituido poco a poco por vello corporal y terminal, que permanecieron cubriendo su cuerpo durante toda su vida.

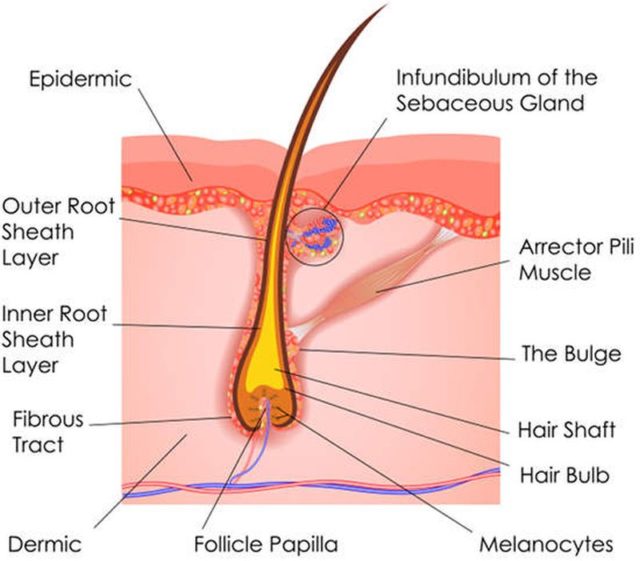

Por dejar claro la diferencia entre lanugo, vello y pelo terminal, podemos decir que el lanugo es el mas fino y delgado, y no presenta color ni médula en su interior; los pelos vellosos, vellos o intermedios son cortos, poco pigmentados y producidos por folículos se encuentran en la dermis papilar, con presencia variable de médula; mientras que los pelos terminales son producidos por folículos que se encuentran en la dermis reticular, siendo estos últimos grandes, pigmentados y siempre con médula.

Estructura de un folículo piloso

A los 10 años de edad, siendo un niño tan llamativo, Pedro González fue enviado como regalo desde Canarias hasta Bruselas, donde la intención es que fuera recibido por el emperador Carlos V y su tía, que era la gobernadora de los Países Bajos, pero durante el viaje en barco, un grupo de corsarios franceses asaltó el navío y capturó al pequeño niño peludo, el cual obsequiaron al rey de Francia, Enrique II de Valois.

A pesar de que hay variantes de esta historia, Pedro González acabo en la corte francesa, donde incluso empezó a usar el nombre latinizado de Petrus Gonsalvus. Un diplomático italiano en palacio, Giulo Alvarotto, fue una de las primeras personas en dar cuenta de la gran curiosidad que levantó el niño cuando llegó a París, y lo describió de la siguiente manera:

“Su cara y su cuerpo está recubierta por una fina capa de pelo, de unos cinco dedos de largo (unos 9 cm), de color rubio oscuro, más fina que la de una marta cibelina, (Martes zibellina, un mustélido muy apreciado en peletería) y de buen olor, si bien la cubierta de pelo no es muy espesa, pudiéndose apreciar bien los rasgos de su cara”.

Esta descripción coincide bastante bien con la hipertricosis lanuginosa y aunque esta rara condición fue la causante de que Pedro saliera de su Canarias natal, probablemente también lo salvó de una muerte segura o un castigo peor a cargo de los piratas que lo capturaron.

A pesar de su aspecto salvaje, Pedro González había recibido una buena educación, y el propio Enrique II se encargó de que aún mejorara más su formación para “civilizarlo” todo lo posible, puesto que por aquellas fechas el mito de los hombres salvajes hacía pensar que Pedro fuera medio persona, medio animal. Así le proporcionó formación en latín y otras lenguas y le inculcó las refinadas costumbres sociales del momento. Poco a poco en la corte parisina, comenzó a ser conocido como “el salvaje de Canarias”, pero tuvo en todo momento la protección del rey, y pasó a formar parte de su servidumbre, al ir creciendo. Sus primeros trabajos fueron como ayuda de cámara, y era parte de los criados que llevaban la comida al rey, con la diferencia de que él tenía que mostrarse al monarca y a sus invitados cuando éste se lo pidiera. También parece que hizo de catador de la comida del rey. A pesar de ser parte de la servidumbre, era llamado Don Pedro González, se supone que por ser descendiente de un jefe guanche.

Interpretación moderna de Pedro González y su familia

De esta manera, nuestro protagonista se convirtió en el primero de los escasos casos de hipertricosis lanuginosa congénita registrados hasta el momento, aunque si hay al menos otros cien casos de hipertricosis congénita generalizada en la literatura científica y en medios de comunicación. Relacionado con estas afecciones, se encuentra también el hirsutismo, que es mucho más común. Este último se da aproximadamente en el 10 % de las mujeres comprendidas entre las edades de 18 y 45 años, y consiste en un crecimiento anómalo y desmesurado del vello corporal en las mujeres, siguiendo un patrón de distribución masculino producido por un aumento de los niveles o respuestas de las hormonas androgénicas.

El lanugo característico que recubría toda la piel de Pedro González fue sustituyéndose poco a poco por vello y pelo definitivo, coincidiendo el comienzo del cambio, probablemente la adolescencia, ya que se relaciona con el momento en que los folículos pilosos de axilas e ingles se convierten en folículos pilosos definitivos. En los casos de hipertricosis ocurre lo mismo en zonas donde normalmente no crece vello o no se produce este tipo de pelo definitivo. En la literatura científica se sugieren básicamente tres mecanismos que producen la hipertricosis:

- La conversión de vello en pelo terminal. La producción de andrógenos en la adolescencia provoca que los folículos de axilas, ingles, pecho y espalda, crezcan tanto en longitud como en profundidad, convirtiéndose en folículos terminales. La hipertricosis muchas veces incluye el mismo proceso de conversión de vellos a pelos terminales en regiones del cuerpo que normalmente no tienen estos últimos. De todas maneras, se desconoce todavía mucho sobre el funcionamiento de este mecanismo.

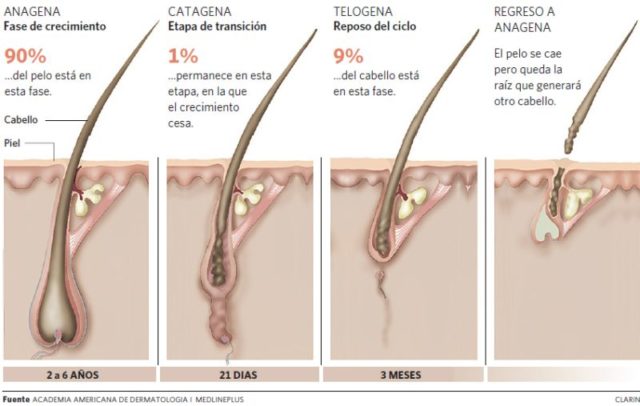

- Cambios en el ciclo del crecimiento del pelo. El ciclo del pelo incluye tres fases: Fase anágena, que es la fase de crecimiento activo; fase catágena, en la que se detiene el crecimiento y presenta apoptosis, es decir, muerte celular programada de las células del folículo; y fase telógena en la que ocurre la caída.

Fases del ciclo del pelo

El pelo largo se forma cuando permanece mayor tiempo en la fase anágena, mientras que el pelo de mayor densidad se debe a una disminución en la caída de cabello como resultado de un menor porcentaje de folículos en fase telógena. Las áreas del cuerpo con pelo más largo y de mayor densidad, como el cuero cabelludo, tienen un mayor porcentaje de pelos en fase anágena.

De nuevo estamos ante un mecanismo bastante desconocido, y el control de la alteración del ciclo del pelo apenas está empezando a entenderse. Cada folículo presenta su propio patrón de crecimiento, que puede ser alterado por influencias hormonales diversas, como andrógenos, hormonas tiroideas y hormona del crecimiento. Si los folículos permanecen mas tiempo en su fase anágena puede aparecer la hipertricosis.

- Incremento en la densidad de los folículos pilosos. La densidad de los pelos es muy variable en la piel normal, donde nos encontramos desde folículos pequeños hasta otros mucho más grandes, como en el cabello. Algunos casos de hipertricosis presentan un número total de folículos mayor de lo normal para el lugar anatómico donde se encuentran dichos pelos.

Pedro pasó su adolescencia, comenzó a sufrir este cambio, y se hizo adulto viviendo en la corte parisina, hasta el fallecimiento de Enrique II, momento en que su mujer, la reina Catalina de Médici, decidió concertar un matrimonio para “el salvaje de Canarias”. Para ello eligió a Catherine, una joven noble de su corte de gran belleza. El mito de la Bella y la Bestia comenzaba a gestarse aquí. Supongo que para la reina fue una situación divertida y no dejó que la joven viera a Pedro hasta el momento de la boda, por lo que parece que ésta quedó horrorizada al descubrir a su pretendiente. Por el contrario, es de suponer que él estaba encantado. Catherine accedió a casarse por obediencia a su reina, y en contra de lo que la mayoría de la gente esperaba, congeniaron bastante bien y no hubo problemas en el matrimonio.

Pedro González y su esposa Catherine

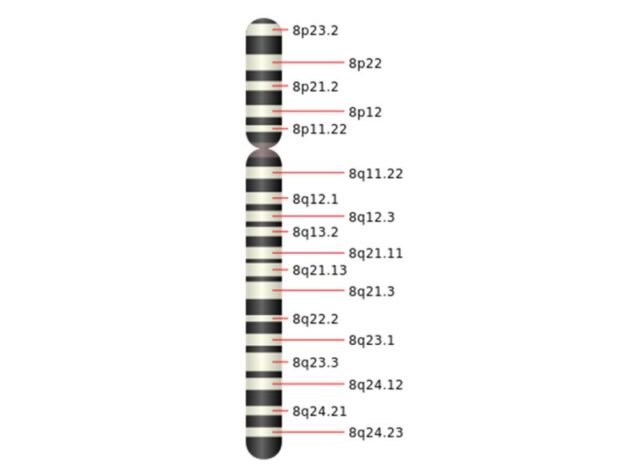

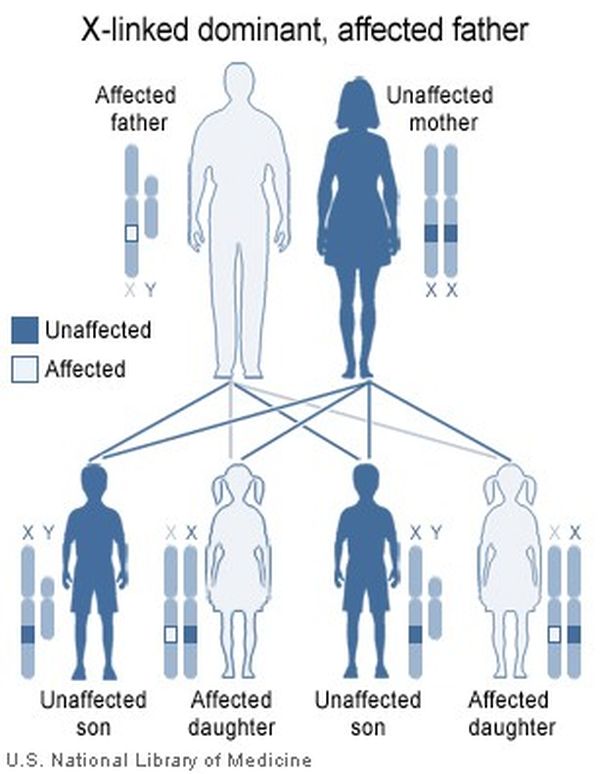

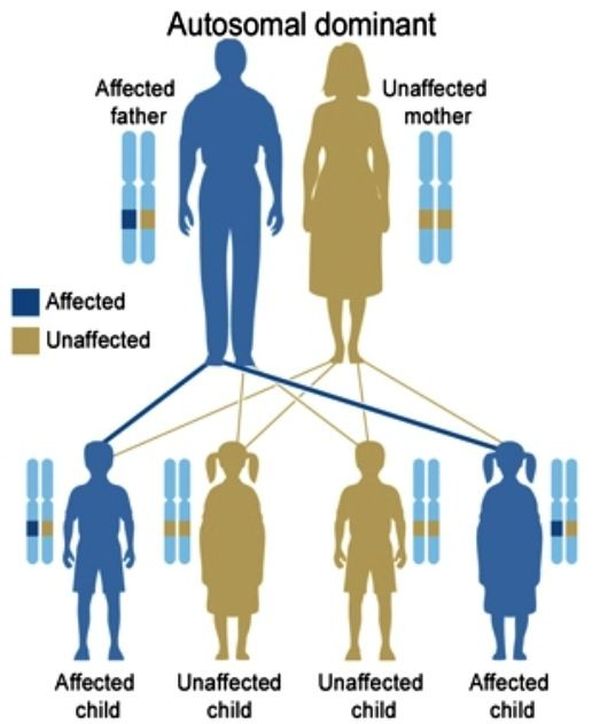

Genéticamente hablando, la hipertricosis lanuginosa congénita puede ser causada por una mutación de las bandas 8q12;q22.1 y 8p11.2;q22.2 del cromosoma 8, concretamente una inversión paracéntrica, es decir los genes que cambian su orden no afectan al centrómero del cromosoma. Una mutación espontánea podría producir esta afectación, y por lo tanto no sería necesario que ningún antepasado hubiera tenido hipertricosis para que Pedro González la padeciera. En cualquier caso, la condición, una vez que aparece, es autosómica dominante, y la probabilidad de que los hijos la hereden es alta, como podemos comprobar con sus hijos.

Cromátida del cromosoma 8 humano

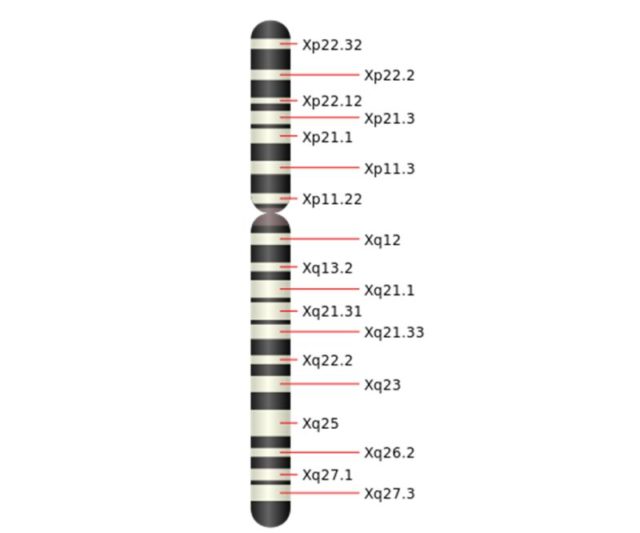

La hipertricosis congénita generalizada, sin embargo tiene un patrón de herencia dominante ligada al sexo y se ha relacionado con las regiones Xq24 y Xq27 del cromosoma X. De esta manera, siendo la Catherine de genotipo no afectado y padeciendo Pedro hipertricosis, si esta hubiera sido de tipo congénita generalizada, la probabilidad de que sus hijos la tuvieran sería del 50 %, pero variaría en cuestión de sexos, estando el 100 % de sus hijas afectadas por la hipertricosis, y no estando ninguno de sus hijos varones, datos que no cuadran con la descendencia de nuestro protagonista.

Estructura del cromosoma X humano

Del matrimonio entre Pedro y Catherine nacieron seis hijos, tres niños y tres niñas: Madeleine, Enrique, Françoise, Antonietta, Horacio y Ercole, cuatro de los cuales heredaron la hipertricosis de su padre. Tanto los niños Enrique y Horacio, como las niñas Madeleine y Antonietta, tenían el cuerpo y la cara cubiertos de pelo como su padre. Este hecho coincide y sobrepasa las probabilidades de heredar esta condición, si es autosómica dominante, como la hipertricosis congénita lanuginosa, y no está en los cromosomas sexuales.

La familia González. De arriba a abajo y de izquierda a derecha: Pedro, Catherine, Madeleine y Enrique

En ese caso la probabilidad esperada sería del 50 % de los hijos con hipertricosis y el otro 50 % no afectados. Pedro tuvo 4/6 hijos con la afectación, es decir 2/3 o 66,66 %. También hay datos de que algunos de los nietos de Pedro González heredaron esta condición, pero los datos y las pistas sobre los González se diluyen a partir de la tercera generación.

Herencia autosómica dominante de la hipertricosis lanuginosa congénita en el caso del padre afectado

Herencia ligada al cromosoma X de la hipertricosis congénita generalizada

Con Pedro González muy mayor, pero aun con vida, un médico llamado Marcus Antonius Ulmus, publicó en 1602, Physiologia barba humanae, un libro de trescientas páginas que recopilaba las opiniones e investigaciones de los “médicos y filósofos ilustres” de muchos siglos atrás sobre el pelo y las barbas. Al igual que otros autores médicos de su época, Ulmus asociaba el crecimiento del vello facial con la potencia sexual, por lo que no se habría sorprendido de que Pedro fuera padre de al menos seis niños.

Otro médico, Felix Platter, de Basilea, escribió sobre la familia de González en su obra, Observationes, hablando sobre la inexistencia de salvajes cubiertos de pelo en islas o países remotos, y nombrando a nuestros protagonistas como un ejemplo de personas normales que simplemente tenían un problema de crecimiento de pelo no deseado en muchas zonas de su cuerpo.

Podemos imaginar que el aspecto que presentaba toda la familia, fue durante mucho tiempo la comidilla de los círculos nobles y muchos acudían para verlos como si fueran animales. De hecho existen varias representaciones artísticas tanto de Pedro como de toda la familia, debido a que algunos reyes, príncipes o nobles que no podían verlos, mandaban a hacer un retrato, que después contemplaban y exhibían en sus palacios. Lo mismo ocurría con los médicos que los examinaban, que solían dejar registro pictórico de tan extraordinarias personas.

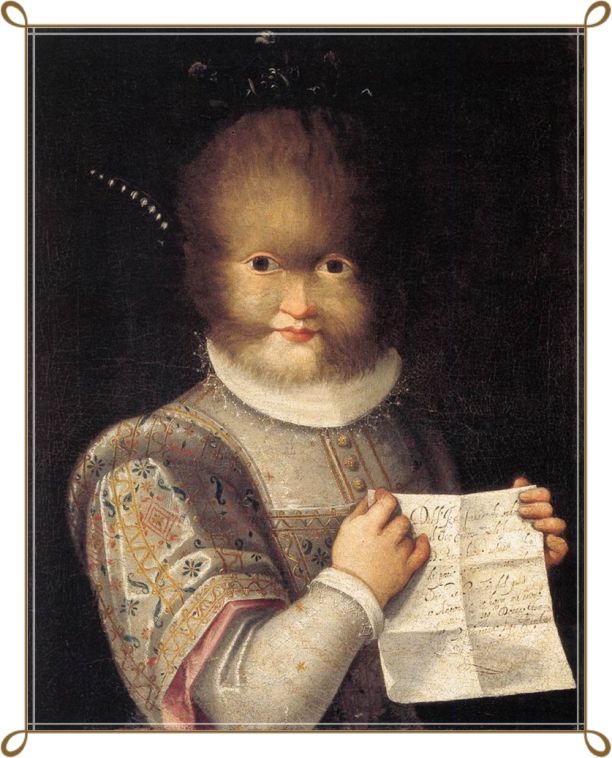

Enrique González. Uno de los hijos de Pedro que tenía también hipertricosis

Cuando Catalina de Médici falleció, la peculiar familia al completo fue entregada como un presente a Margarita de Austria, gobernadora de Flandes y duquesa de Parma, y de sus manos, posteriormente pasaron por herencia al hijo de ésta, Alejandro Farnesio. Como se puede deducir, la vida de los González no estuvo exenta de lujos, pero fueron pasando de un lugar a otro, donde fueron exhibidos como animales salvajes, a pesar de su fina educación y preparación.

Los propios hijos de Pedro fueron separados y dados como regalos a diferentes nobles, una vez que se establecieron en Italia. De esta manera, por ejemplo, era descrita Antonietta en algunos documentos de la época:

“La cara de la chica era totalmente velluda en su parte frontal, a excepción de las ventanillas de la nariz y de los labios. Los pelos de su frente eran más largos y más ásperos en comparación con los que cubría sus mejillas, aunque éstos eran más suaves al tacto que los del resto de su cuerpo. El pelo de su espalda era amarillento y más erizado que en otras zonas, y llega hasta las ingles.”

Antonietta González, otra de las hijas de Pedro que también tenía hipertricosis

Pedro González falleció en 1618 en Capodimonte, en la región de Lacio, en Italia, y a pesar de haber llevado una vida tan inusual, murió cuando tenía 80 años, algo también bastante extraño para su época. Este hombre nunca pasó desapercibido, y no son pocos los historiadores e investigadores que piensan que su historia fue la que inspiró el cuento de la Bella y la Bestia, como adelantábamos al principio.

Ilustración de la Bella y la Bestia, de Brent Hollowell

En la Bella y la Bestia nos encontramos a un joven príncipe mimado y caprichoso que es convertido en una bestia por una maldición. El aspecto de la Bestia, una vez transformado, recuerda mucho al que tenía Pedro González, con el cuerpo y la cara cubierto de pelo.

Evidentemente hay otras características de Bestia que no cuadran con el noble canario, o con otras personas con hipertricosis, pero hay algunas que sí. Por ejemplo, la Bestia tiene grandes y amenazadores dientes, lo que puede relacionarse con la hiperplasia gingival, o crecimiento desmedido de las encías y los dientes. A veces, esta condición aparece junto a la hipertricosis terminal, lo que probablemente también ayudó a dar origen al mito del Hombre Lobo, puesto que al aspecto ya de por sí extraño de una persona cubierta de pelo, se le suma una dentadura y una encía grandes con unos dientes alargados. En algunos casos de hipertricosis lanuginosa congénita también puede haber dismorfia o deformaciones faciales y dentales.

Hiperplasia gingival

La Bestia rugiendo

La cornamenta de Bestia no tiene nada que ver ni con la hipertricosis ni con la hiperplasia gingival, pero también se da el caso en algunas personas reales de la aparición de pequeños cuernos, que en raras ocasiones alcanzan un tamaño tan grande como los de Bestia, debido a una tumoración en algunas zonas de la piel. Los cuernos cutáneos, pueden formarse a partir de tumores de las células epidérmicas que se queratinizan. Esta acumulación de queratina hace que el tumor adquiera una forma cónica típica de un cuerno que sobresale de la piel.

Los cuernos de la Bestia

Los tumores que dan lugar a los cuernos cutáneos pueden ser benignos, pero en un 20 % de los casos son malignos, o se malignizan. Un tumor de células escamosas puede ser la causa más común de aparición de estos cuernos, debido sobre todo a la exposición excesiva a la luz solar (de hecho hay datos de que 70% de éstos se ha localizado en áreas fotoexpuestas), pero también a partir de cicatrices de quemaduras o por virus tipo Herpes.

Algunos cuernos cutáneos

En cuanto a la estatura de la Bestia, no es inalcanzable para un ser humano, ya que basándonos en la comparación de alturas de los dos personajes principales del cuento cuando están juntos, podemos deducir cuanto mide la Bestia. En el cuento original no hay datos de las estaturas, y en la película de animación podríamos hacer una estimación, pero con la película en imagen real lo tenemos más fácil, puesto que sabemos que Emma Watson, la actriz que interpreta a Bella, mide 1,67 m, de lo que podemos estimar que la Bestia mide un poco más de 2 metros, altura que una persona puede alcanzar sin tener que recurrir a ninguna condición o enfermedad.

La altura de Bella y Bestia

Pasemos ahora a la forma de las patas y la presencia de cola, que parece que están basadas en las extremidades y cola de un lobo, según fuentes de la propia compañía Disney. Para las patas nos tenemos que fijar en las extremidades posteriores de los cánidos, que tienen el metatarso alargado, apoyando solo los dedos en el suelo para desplazarse, al contrario que los humanos que apoyamos todo el pie. Según el alargamiento del metatarso, en ciertos personajes ficticios, como faunos o demonios, o la propia Bestia, puede dar la sensación de que la articulación de la rodilla está al revés, pero se trata del tobillo que se sitúa más alejado del suelo.

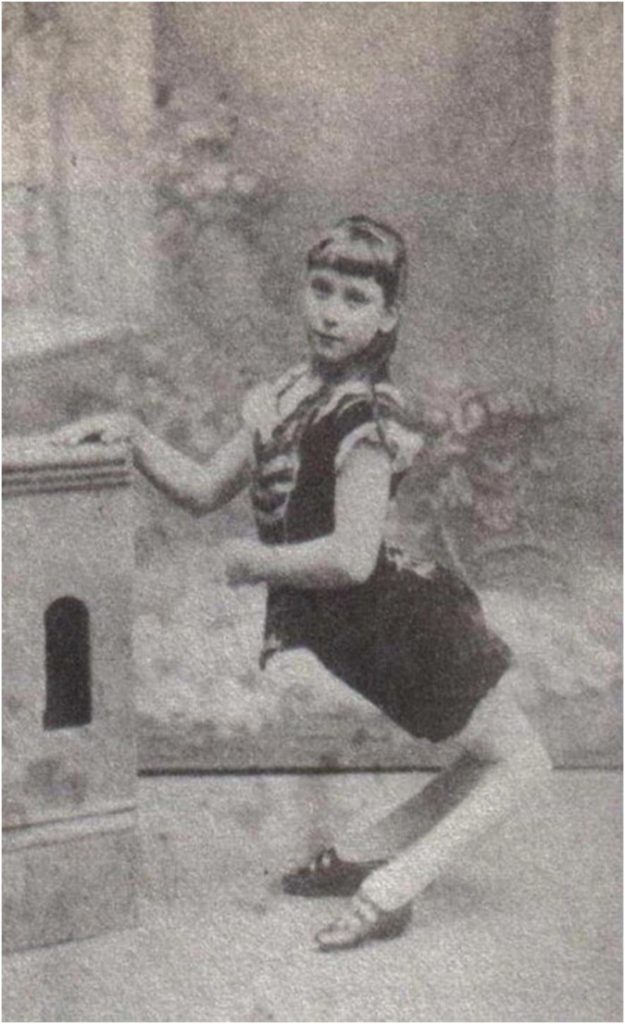

Es raro encontrar algo así en humanos, pero hubo un caso muy llamativo, de una muchacha que nació en 1870, y cuyo nombre era Ella Harper. Esta chica era conocida como “la chica camello”, debido a una patología ortopédica que hacía que sus piernas estuvieran curvadas hacia atrás, por lo que tenía que ayudarse de las manos para caminar. Como mucha gente con deformidades extrañas y llamativas, Ella trabajó como fenómeno de circo hasta los 16 años, pero tras después decidió dejarlo, estudiar y llevar una vida lo más normal posible, lo que consiguió hasta que falleció a causa de un cáncer de colón pasados los 40 años.

La cola y las patas de lobo de la Bestia

Ella Harper

Para explicar la cola de Bestia, tenemos que recurrir a lo que se suele llamar cola humana verdadera o cola vestigial. Los casos de cola vestigial también son escasos y se conocen menos de 100 en todo el mundo para lo que se puede catalogar como una rareza fenotípica, y que está producida por la activación de genes que en nuestros antepasados producían la cola. Estos genes, hacen que la cola crezca en la zona final del sacro, a continuación del cóccix, estando normalmente compuesta por tejido conectivo, músculos, vasos sanguíneos, nervios y piel, en la mayoría de ocasiones. A veces también tiene vértebras y cartílago.

A la poca frecuencia de nacimientos con esta condición, hay que añadir que cuando un niño nace con cola, se le suele extirpar a los pocos días, puesto que no tiene ninguna funcionalidad y estéticamente puede resultar un problema para esa persona en el futuro. En el caso de la Bestia, la cola vestigial además estaría cubierta de pelo debido a la hipertricosis referida anteriormente.

Cola vestigial humana

En la versión clásica en dibujos animados de La Bella y la Bestia, este personaje tiene además de las características descritas, una poblada melena parecida a la de un león, que también se ve en la versión en imagen real de 2017, aunque quizás esté un poco menos poblada. Es curioso como en documentos en los que se habla de Pedro González y su familia son descritos a veces como “el hombre-león”, o “las chicas con cara de perro”, y curiosamente, por su condición de cortesanos del Renacimiento, visten gorgueras, encajes, ropajes nobles y vestidos caros, de forma muy parecida a como los lleva la Bestia. Las coincidencias entre la realidad y la ficción son muchas.

Madeleine González. Otra de las hijas de Pedro con hipertricosis

El pelo de Pedro y el de sus hijos a menudo fue comparado con el de algunos animales. Por ejemplo, recordemos que una de las primeras descripciones del joven Pedro en París, que mencionamos al principio, hablaba de su pelo de color rubio claro, muy fino y delicado, y en algunas transcripciones directamente decían como el pelaje de un sable. El término sable, proviene del francés sable, y éste del germánico sabel, que se usaba para nombrar a la marta, Martes zibellina. El manto de la marta cibelina suele ser pardo, pero las pieles de marta más apreciadas, y por tanto más caras, eran las de color negro. De ahí viene el llamar color sable al negro en heráldica. También de una de las hijas de Pedro, Antonietta, se llegó a decir que es “Una mujer peluda de veinte años, cuya cabeza recuerda a la de un mono, pero que no es peluda en el resto de su cuerpo.”

Martes zibellina

Este aspecto medio humano y medio animal, que también posee Bestia, hace que en la película de La Bella y la Bestia, Gastón tenga argumentos para convencer a la gente del pueblo para que marchen contra el castillo donde se oculta, para acabar con tan demoniaco ser, a pesar de haberse convertido en un hombre bondadoso tras haber sufrido la penitencia de vivir convertido en monstruo. Cabe suponer que Pedro González sufriría muchos episodios parecidos a lo largo de su vida, y a pesar de ser un gentilhombre, muchos coetáneos probablemente lo tildaran de bestia.

De hecho por aquella época también hubo otros casos dignos de mención que tienen mucho que ver con la escena del linchamiento de la Bestia, como por ejemplo el de Gilles Garnier, “el hombre lobo de Dole”, que fue acusado de licantropía y de haber perpetrado terribles crímenes, como mutilaciones, canibalismo y asesinatos de niños. Según los jueces y cronistas de la época, había cometido esos crímenes en su forma de lobo. En la actualidad nadie dudaría de la psicopatía y del sadismo de semejante criminal, pero para los tribunales de entonces, todas las acusaciones eran demasiado horribles para ser consideradas realizadas por humanos, por lo que no se dudó de la teoría de licantropía. Garnier fue condenado a ser quemado en la hoguera, donde murió en el año 1583. Es de suponer que cuando esa noticia llegó a las gentes que habían visto alguna vez a Pedro González, se imaginaran a Garnier con un aspecto parecido, a pesar de que no hay constancia de que “el hombre lobo de Dole” tuviera hipertricosis o ninguna condición parecida.

Representación de Gilles Garnier, el hombre lobo de Dole

Hay muchos otros casos de gente con hipertricosis que ha pasado a la historia, como Barbara Urselin, nacida en 1629 en Kempten, Alemania, y que fue exhibida desde muy pequeña por sus padres y posteriormente por su marido a cambio de dinero, como “La Mujer Cubierta de Pelo” (The Hairy-Faced Woman). También está Adrian Jeftichejev, conocido como “El Hombre Salvaje de los Bosques de Kostroma” que era exhibido como el fruto de las relaciones entre un oso y una campesina. Adrian tuvo un hijo llamado Fedor, que sería posteriormente conocido como Theodore Petroff o “Jo-Jo, el Niño con Cara de Perro“. Este último trabajó en el circo, y tras su fallecimiento en 1904, buscaron un sustituto, que fue Stephan Bibrowski, que era conocido como “Lionel, el Hombre León“.

Julia Pastrana, una mujer mexicana que nació en 1834, era bajita y tenía una gran hipertrofia gingival, además de una frente muy peluda y bigotes y barba muy llamativos. Normalmente era llamada “La Mujer Oso” y de nuevo se culpó de su nacimiento a las relaciones entre un humano y una osa. Vivía de exhibirse en espectáculos y su mánager se aprovechó de ello, explotándola incluso después de fallecer. Su muerte ocurrió tras el parto en el que dio luz a un niño con hipertricosis, que falleció a los pocos días. Krao era una niña nacida en Bangkok, con un pelo corporal negro, lacio y brillante, además de prognatismo facial, nariz chata y orejas grandes, ágil de movimientos y muy flexible, que también fue exhibida por Europa y Estados Unidos.

Al igual que otras personas de características similares fue exhibida desde 1883 por Europa y EEUU como “La Mujer Simio” contando una historia falsa que la colocaba como un “eslabón perdido”. Y terminamos con la mujer cántabra, Joaquina López, conocida como “La Osa de Ándara“, de la que se decía que tenía pelo crespo, de frente aplastada y estrecha, nariz chata, pómulos prominentes y labios con forma de hocico.

De arriba a abajo y de izquierda a derecha: Bárbara Urselin, Theodore Petroff, Joaquina López y Julia Pastrana

Como conclusión volvemos a los protagonistas y podemos terminar diciendo que tanto Pedro González, como Bestia, son dos buenos ejemplos de hipertricosis en humanos, una congénita lanuginosa, y la otra producida por un hechizo, cuya característica principal es la presencia de pelo por todo el cuerpo. Sabemos clasificar las hipertricosis, basándonos en si son congénitas o adquiridas; generalizada o localizadas, pero aún estamos lejos de conocer todos los mecanismos que están implicados en ellas.

Sabemos también que lejos de ser una cuestión meramente estética o presentarse como un signo de diversas enfermedades, también pueden acarrear otros problemas, afectando por completo a la forma de vivir o de comportarse de los que la padecen; sino que le pregunten a Pedro González, o a Bestia. Al igual que el guanche ha servido para esclarecer el patrón de herencia de esta enfermedad, quizás hubiera sido interesante que el cuento de la Bella y la Bestia hubiera tenido un final diferente, y Bella se hubiese quedado con su príncipe en forma de Bestia, como hizo Catherine. Sus hijos probablemente hubieran servido para inspirar otra buena historia.

La Bella y la Bestia

Este post ha sido realizado por Carlos Lobato (@Biogeocarlos) y es una colaboración de Naukas con la Cátedra de Cultura Científica de la UPV/EHU.

Referencias y más información:

– Sigall, D. A., Alanís, J. C. S., Beirana, A., & Arenas, R. Hipertricosis: sus causas, formas clínicas y manejo.

– https://es.wikipedia.org/wiki/Petrus_Gonsalvus

– http://orff.uc3m.es/bitstream/handle/10016/8658/sindrome_pedraza_LITERATURA_2008.pdf?sequence=1

– http://www.laprovincia.es/cultura/2017/03/17/bestia-bella-guanche/919077.html

– https://apparences.revues.org/1283

– http://medtempus.com/archives/extravagancias-fenotipicas-ii-el-sindrome-del-hombre-lobo/

– https://supercurioso.com/la-historia-de-ella-harper-la-nina-camello/

– http://idd0073h.eresmas.net/public/artic11/artic11_04.html

– https://en.wikipedia.org/wiki/Gingival_enlargement

– https://es.wikipedia.org/wiki/Lanugo

– https://en.wikipedia.org/wiki/Hypertrichosis

El artículo La hipertricosis del guanche que inspiró a la Bestia se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El libro que inspiró al más grande

- 666, el número de la Bestia (1)

- 666, el número de la Bestia (y 2)

El camino al gran descubrimiento

La palabra en la mente de un científico cuando inicia el camino hacia un descubrimiento no es ‘Eureka’, como la leyenda de Arquímedes pudiera hacer pensar: es más bien ‘Pero ¿qué rayos?’, o incluso algo más contundente. Porque el camino al descubrimiento científico empieza con algo que no funciona como debería: algo que no responde como se esperaba o no está donde o cuando se pensaba. El camino al descubrimiento empieza con una pregunta, y las preguntas más interesantes, valiosas y potentes surgen de una anomalía. O, en el mejor de los casos, del fracaso de una teoría en explicar un fragmento de la realidad observada. El tipo de observación que hace exclamar: ‘Pero ¿qué diablos?’.

En la ciencia de llenar los huecos, la que Thomas Kuhn llamaba ‘ciencia normal’, se trabaja dentro de un marco y los experimentos que se realizan tienen una respuesta esperada. El paradigma indica en qué dirección hay que mirar y el resultado está más o menos cantado. Se trata de ir llenando las casillas de un formulario preimpreso; un trabajo importante y necesario, pero que no hace saltar consensos por los aires ni impulsa carreras meteóricas. El juego va de afinar las medidas un orden de magnitud, o de completar la serie estratigráfica, o de ensamblar los elementos faltantes de la cadena genética o metabólica. En este tipo de ciencia se trabaja mucho la metodología, el diseño de experimentos y el instrumental; es la ciencia de andar por casa, la de todos los días. La que hacen la mayoría de los científicos.

Y lo es porque los paradigmas, cuando solidifican, son estructuras intelectuales muy sólidas que cubren un amplio espacio. No sólo ayudan a explicar lo que antes no se entendía, sino que permiten entender mejor lo que ya se comprendía antes. Su poder es tal que pronto aparecen en todos los rincones de sus disciplinas, e incluso desbordan a las cercanas; a menudo resultan ser capaces de fertilización cruzada con paradigmas vecinos, creando nuevas y potentes combinaciones explicatorias. Muchas carreras científicas pueden hacerse, y de hecho se hacen, dentro de un paradigma, haciendo ciencia normal. Hay mucho trabajo que hacer dentro de un paradigma, explorando sus rincones y utilizando sus capacidades hasta el máximo.

Lo que no quita que el momento excitante se produzca con el ‘Pero ¿qué diablos?’; con el resultado inesperado y contradictorio, el feo e insignificante dato que contradice la hermosa y redonda teoría, la anomalía que se sale de lo esperado. Lo excitante empieza en el punto en el que el paradigma cede porque hay una realidad que no puede encajarse dentro.

Ése es el momento por el que vive un científico: el momento ‘Pero ¿qué leñe?’ cuando comprende que lo que acaba de presencia no tiene encaje en el paradigma, que su descubrimiento se sale de la ciencia normal y entra en el escurridizo, excitante, creativo y peligroso mundo del reemplazo de paradigmas.

Porque los paradigmas no son sólo estructuras intelectuales; también son redes reales que vinculan personas, carreras e instituciones. El acceso a becas y plazas, los premios y puestos en sociedades científicas, las decisiones editoriales en revistas, libros de texto e incluso que los edificios de los campus lleven uno u otro nombre a largo plazo dependen de esas redes. Los cambios de paradigma no son un tranquilo tránsito intelectual, un cerebral y frío relevo de una idea caduca por otra más moderna y mejor; son verdaderas carnicerías con enemistades personales, bloqueos, trampas y navajazos en los que no son desconocidos los golpes por debajo de la cintura ni las rupturas de amistades de décadas. En teoría la ciencia debe despojar la razón de la pasión; en la practica los científicos son humanos y confunden como el que más las ideas con las personas que las defienden. El resultado no es bonito; un viejo refrán dice que los viejos paradigmas jamás son rechazados, simplemente el ultimo de sus defensores se jubila o muere.

De modo que la carrera de un debelador de paradigmas no es un jardín de rosas. Implica enfrentarse a la resistencia, al principio completa y de toda la especialidad, más tarde esporádica; implica sacrificios (de amistades, de apoyos, de respaldo) y en general implica una vida profesional mucho menos cómoda que dentro de la ciencia normal. En algún momento del camino todo científico que ha tenido ese momento ‘Pero ¿qué porras?’ lo ha debido maldecir; ha debido desear nunca haber tropezado con ese inconveniente hecho, ese dato insignificante y anodino que lo puso todo en marcha.

Pero la recompensa es dulce cuando se obtiene el éxito. Porque matar un paradigma implica hacer nacer otro que llevará para siempre el nombre y la descendencia intelectual de su creador. A la larga significará honor, reconocimiento, premios; más respaldo a la investigación del que jamás se soñó, un espacio permanente en los libros de texto a partir de esa generación, reconocimiento social. El cambio, además, suele ser tan brusco como para provocar vértigo; según el chascarrillo las tres fases de aceptación de una nueva teoría en ciencia son

1.- Eso es imposible

2.- Eso es teóricamente posible pero extremadamente improbable

3.- Ya lo sabía yo

Ese ‘Ya lo sabía yo’ por parte de amigos, enemigos y mediopensionistas es el mayor honor al que puede aspirar un científico: significa que las aportaciones realizadas tienen solidez, que su trabajo y los trabajos que ha tenido que pasar en su carrera tienen sentido, que sus ideas y conceptos no serán olvidados. Y el camino hacia el ‘Ya lo sabía yo’ no arranca en un ‘Eureka’, sino en un ‘Pero ¿esto qué &/%%/&% es?

Sobre el autor: José Cervera (@Retiario) es periodista especializado en ciencia y tecnología y da clases de periodismo digital.

El artículo El camino al gran descubrimiento se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La ciencia y la duda

- Rutherford: la radiactividad y el descubrimiento del núcleo atómico, por El zombi de Schrödinger

- Consolider-Gran Telescopio Canarias: Cómo comunicar Astrofísica

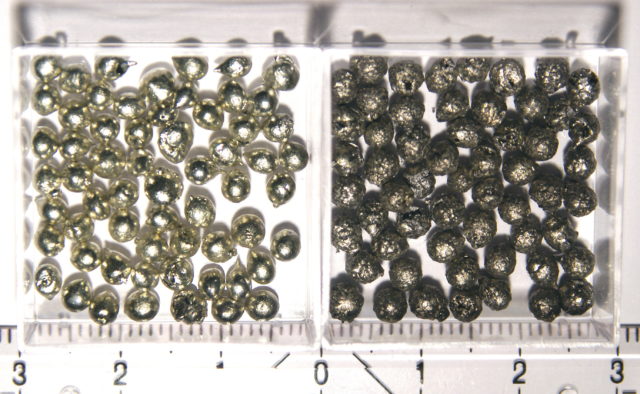

El estaño beta es como el grafeno pero en 3D

Estaño alfa (izquierda) y estaño beta (derecha)

El estaño es un metal que se conoce al menos desde hace 5.000 años, desde la Edad del Bronce. Con ese tiempo transcurrido debería haber pocas cosas ya que nos sorprendieran, pero las hay y son muy interesantes.

Cuando decimos que el estaño es un metal, realmente lo que estamos es refiriéndonos a una de las dos formas en las que el estaño organiza sus átomos, la que llamamos estaño-beta. El estaño-beta o estaño blanco es estable a temperaturas medias y altas, y presenta las características de un metal: entre otras cosas es maleable y conduce la electricidad. Podemos acuñar monedas con él, por ejemplo.

Pero si la temperatura baja demasiado (por debajo de 13 ºC) el estaño cambia su estructura cristalina por la del diamante, volviéndose quebradizo y deja de ser conductor. Este llamado estaño-alfa o estaño gris ha dejado de tener las características de un metal. De hecho este cambio de características es lo que se conoce como peste o lepra del estaño. Lo entenderemos mejor si vemos este vídeo en el que un trozo de estaño alfa si se mantiene a -40 ºC durante 20 horas, convirtiéndose en estaño beta; no ocurre ninguna reacción química (el vídeo dura 30 segundos):

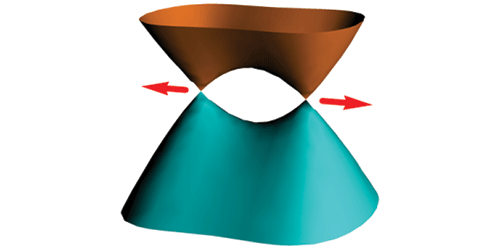

Damos un salto a la vanguardia de la ingeniería de materiales. Los llamados semimetales topológicos de Dirac presentan las propiedades electrónicas del grafeno pero, mientras que en éste están confinadas a 2 dimensiones, en los semimetales topológicos de Dirac aparecen en 3D. Hasta ahora los dos únicos semimetales topológicos de Dirac conocidos eran muestras de al menos dos elementos. Ahora un grupo de investigadores encabezado por Cai-Zhi Xu, de la Universidad de Illinois en Urbana-Champaign (EE.UU.), ha descubierto el comportamiento de un semimetal topológico de Dirac precisamente en el estaño alfa con solo aplicarle un poquito de tensión.

En el grafeno, y materiales 2D relacionados, la estructura de bandas electrónica alberga una regiones que tienen forma de cono, en las que los estados electrónicos se comportan como si careciesen de masa. Estos estados, excitaciones de baja energía llamadas fermiones de Dirac, están confinados de forma característica a dos dimensiones, como la dada por una lámina de grafeno o por la superficie de un aislante topológico. Pero en los semimetales topológicos de Dirac los fermiones pueden moverse en tres dimensiones. Esta libertad de movimientos abre todo un abanico de propiedades interesantes, como una gigantesca magnetorresistencia lineal y un patrán característico en las oscilaciones cuánticas de la resistencia. Hasta ahora solo se conocían dos semimetales topológicos de Dirac: Na3Bi y Cd3As2.

Estructura electrónica del estaño beta bajo tensión en la que se aprecian los conos de Dirac.

Existían estudios recientes que indicaban que el estaño alfa podría presentar fermiones de Dirac si se sometía a una tensión mecánica. Xu y sus colegas muy ingeniosamente hicieron crecer capas de estaño alfa en una superficie de antimoniuro de indio, que tiene casi la misma estructura de diamante que el estaño alfa. La pequeña diferencia entre las dos estructuras produce una tensión negativa (una compresión) en el estaño. Usando espectroscopía de fotoemisión el equipo pudo comprobar que, efectivamente, existían regiones con forma de cono indicando que estaban ante un semimetal topológico de Dirac. Los cálculos teóricos indican que un cambio de la tensión de negativa a positiva convertiría el estaño en un aislante topológico.

Una primera prueba de principio, en un producto barato y fácil de obtener, con unas características con un gran potencial que puede que veamos concretarse en aplicaciones dentro de unos años.

Referencia:

Cai-Zhi Xu et al (2017) Elemental Topological Dirac Semimetal: α-Sn on InSb(111) Phys. Rev. Lett. doi: 10.1103/PhysRevLett.118.146402

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

Este texto es una colaboración del Cuaderno de Cultura Científica con Next

El artículo El estaño beta es como el grafeno pero en 3D se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Fermiones de Weyl experimentales: como el grafeno, pero en 3D

- El óxido de grafeno que se mueve como una oruga y coge cosas como una mano

- Buscando conos de Dirac (que no estén en el grafeno)

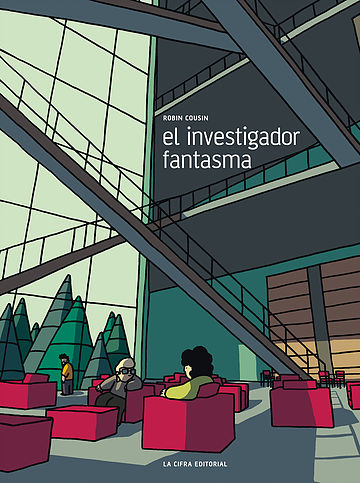

El investigador fantasma: ¿P=NP?

Le chercheur fantôme –El investigador fantasma– de Robin Cousin es un tebeo publicado a principios de mayo de 2013 por Éditions Flblb. En 2015 recibió el premio en la categoría de ficción científica otorgado por la asociación S[Cube] y, en 2016, la editorial mexicana La Cifra publicó su traducción al castellano.

Los comentarios que siguen se refieren a la publicación original en francés; las traducciones de los textos que aparecen debajo son de la autora de esta breve reseña.

En la contraportada se puede leer la siguiente presentación del libro:

La Fundación para el estudio de los sistemas complejos y dinámicos acoge a veinticuatro investigadores en residencia y les proporciona medios ilimitados para llevar a cabo su trabajo. Una noche, tres investigadores, Louise, Stéphane y Vilhem, descubren que en su edificio hay un cuarto residente que nadie ha visto nunca. Trabajaba en el problema “P = NP“.

– ¿Qué es exactamente P = NP?

– Es un problema de la teoría de complejidad computacional. La mayoría de los matemáticos piensan que P es diferente de NP. Plantea un límite teórico a la capacidad de los ordenadores…

– ¿Y si se prueba que P y NP son iguales?

– Revolucionaría las matemáticas modernas, transformaría la investigación científica.

– Ah.

El libro comienza con la llegada del nuevo director de la Fundación, Martin Sorokin. En su nuevo despacho, visiona un mensaje grabado por su predecesor, Alan Bateson: Bateson, el tercer director de la Fundación, se despide tras permanecer siete años en este puesto. Martin Sorokin es, de este modo, el cuarto responsable de la Fundación, y el primer residente en el momento de su llegada.

El mensaje que le ha dejado Bateson es el siguiente –cada salto de línea corresponde a un cambio de viñeta–:

Buenos días. Soy Alan Bateson, investigador en sociología sistémica y director Fundación no. 3. Si está mirando este video, es que como yo hace siete años, ha sido seleccionado por el programa. Es Vd. el primer residente y por lo tanto el director de la Fundación no. 4.

A la hora en la que le hablo la Fundación no. 3 está terminando…[…]

No se impresione por lo que está viendo. Es el desarrollo normal de un final de ciclo.

Como todo sistema dinámico, la Fundación tiende hacia la entropía, hacia un comportamiento caótico.

Es por ello que cada tres meses, el programa seleccionará un nuevo residente para ‘reequilibrar’ el sistema.

Como Vd., los nuevos residentes serán investigadores en una de las áreas de aplicación la teoría sistémica.

Sistemas biológicos, informáticos, financieros, neuronales…

Al cabo de seis años, los veinticuatro laboratorios estarán ocupados y el sistema estará entonces en el momento de su apogeo.

A lo largo del séptimo y último año, las investigaciones de los residentes deberían empezar a dar resultados. Este periodo verá también como se disgrega el sistema.

Su papel será entonces el de retrasar la llegada del caos.[…]

Su papel es el de guiar a los residentes, pero también el de mejorar el programa.

El conjunto de mis resultados está aquí…

Tras terminar de escuchar el mensaje de su predecesor, Sorokin lee el inquietante final del informe de Bateson:

Día 2.555 (último día)

– investigaciones terminadas (en total: 7 sobre 24)

– muertes: 1

– 2 incendios suplementarios.

– llegada del equipo de cierre.

Algunos de los personajes del tebeo.

Tras esta introducción para entender los propósitos de la Fundación, la historia prosigue seis años más tarde. Martin Sorokin comprueba que –comparando su situación al principio del séptimo año con la vivida por la Fundación no. 3– el caos está apareciendo demasiado pronto. Tiene la esperanza de que la llegada del último residente –el número veinticuatro, Stéphane Douasy (ver [1])– consiga equilibrar el sistema. Douasy es físico y su investigación en la Fundación se centrará en el estudio de las formas de los vegetales, en particular en cómo la formación de las yemas influye en la geometría de las hojas (ver [2]).

Fragmento de la página 15 del tebeo.

Tras visitar al director, Stéphane se dirige al edificio en el que debe trabajar y vivir, el edificio F. Nada más llegar conoce a Louise Franç, lingüista que había trabajado en un software capaz de aprender nuestra lengua. Su programa detectaba las formas recurrentes en la estructura de las frases para poder reproducirlas después. Había comenzado a obtener resultados prometedores, pero llegó Google y al poner en funcionamiento el programa Cleverbot –que, según Louise, repite lo que miles de internautas dicen, pero en realidad no habla– ella no pudo competir con él. Desde entonces se encuentra bloqueada, sin nuevas ideas para proseguir con sus investigaciones (ver [3]).

La otra persona que convive con ellos es el informático Vilhem (ver [4]): trabaja en un programa informático que debería predecir sus acciones y gestos en un futuro cercano. Aunque –debido a su conocimiento de la teoría del caos– sabe que cualquier evento es la consecuencia de una infinidad de causas imposibles de observar por completo, Vilhem ‘busca los guiones’ que tienen más probabilidades de suceder. Sólo observa los parámetros más significativos: los personales –recuerdos de su infancia, sus características físicas, el acontecer de su día a día,…– y los de su entorno –la Fundación, los residentes y sus investigaciones,…–. No consigue que sus predicciones tengan sentido.

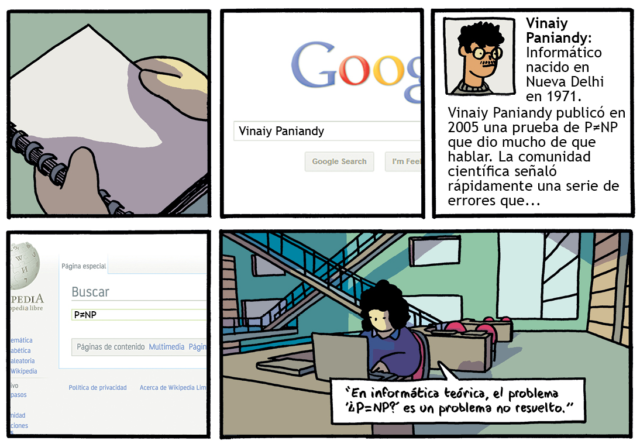

En realidad, existe otro investigador en el edificio F al que sus compañeros apodan el investigador fantasma, ya que nunca lo han visto. Es el informático Vianiy Paniandy con el que no se debe interactuar ‘por órdenes superiores’. Paniandy trabaja en la resolución del problema de informática teórica P vs NP, uno de los Problemas del Milenio. Paniandy había publicado en 2005 una prueba de que P≠NP, pero la comunidad matemática descubrió una serie de errores en su prueba, y le volvió la espalda (ver [5]).

Paniandy trabaja precisamente en el problema del viajante, que es NP-completo. Se basa en el plano de la Fundación (ver [6]): o bien debe probar que no existe ningún algoritmo que lo resuelva –en cuyo caso P≠NP, como él pensaba– o bien debe encontrar el algoritmo que permita llegar de manera óptima, sin tanteos, de un lugar a otro de la Fundación –en cuyo caso P=NP, con lo que ese algoritmo permitiría resolver cualquier problema ‘decidible’–.

Fragmento de la página 44 del tebeo.

Paniandy se horroriza al encontrar ese famoso algoritmo: empiezan a producirse accidentes y muertes entre los demás residentes. El caos empieza a reinar cuando Paniandy introduce su algoritmo en las investigaciones de algunos de sus colegas. El final será inesperado y terrible…

Fragmento de la página 47 del tebeo.

El investigador fantasma es un ‘thriller’ y al mismo tiempo una metáfora de la investigación básica, que pasa desapercibida para la mayor parte de la población, a pesar de su gran importancia para el avance científico.

Además de la trama y el suspense, Cousin introduce numerosos conceptos científicos: además de los ya citados, se habla, por ejemplo, del aún no resuelto problema del sofá o la sorprendente influencia de la geometría (ver [7]) de las yemas de los vegetales en la forma final de las hojas…

Notas:

[1] Su nombre es prácticamente el del físico Stéphame Douady (CNRS, París), con el que Robin Cousin mantuvo varias entrevistas para preparar el cómic. Douady trabaja –entre otros temas– en filotaxis. De allí el paralelismo con el último residente, investigador en morfogénesis, centrado durante su estancia en la Fundación en el estudio de sistemas vegetales.

[2] Douasy representa la pasión por el conocimiento.

[3] A través de Louise se denuncian las presiones de la sociedad de consumo sobre el mundo académico.

[4] Vilhem simboliza la obsesión provocada en algunas ocasiones por la actividad investigadora.

[5] La situación de Paniandy representa el poder de la comunidad científica sobre los investigadores, que deben recibir su aprobación para dar por válidas sus teorías.

[6] La Fundación está situada en un paraje con bosques y edificios, y está organizada siguiendo la sucesión de Fibonacci.

[7] Douasy –en el tebeo– utiliza la papiroflexia en su investigación. El equipo del físico Stéphane Douady –el científico que inspira el personaje del tebeo– usa el origami y kirigami para entender la geometría de las hojas según los pliegues de las yemas.

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad.

El artículo El investigador fantasma: ¿P=NP? se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- “Miguel Odriozola: un investigador adelantado a su tiempo” por José María Odriozola

- Un convite matemático ‘de altura’

- Incendios, los grafos de visibilidad y la conjetura de Collatz

Un viaje a través del sistema circulatorio humano

En reposo, un corazón humano típico bombea 70 ml en cada latido y late alrededor de 70 veces por minuto. Por lo tanto, el corazón bombea, aproximadamente, 5 litros de sangre por minuto. Hoy vamos a examinar algunas características del sistema de vasos que recorre esa sangre tras ser impulsada por el corazón.

Muchos animales tienen sistemas circulatorios. Son dispositivos que permiten comunicar las diferentes partes del organismo para transportar entre ellas nutrientes, deshechos, gases respiratorios, calor e información. Un sistema cardiovascular -como también se le llama- consta de una o varias bombas de impulsión –o corazones- y de un conjunto de conductos, a los que llamamos vasos sanguíneos, que llevan la sangre desde el corazón hasta los tejidos y, de vuelta, desde los tejidos al corazón. Hay dos tipos de sistemas circulatorios, abiertos y cerrados. En los sistemas abiertos los vasos que proceden del corazón se van ramificando hasta que se abren a los espacios y cavidades internas del organismo, vertiendo en ellos la sangre que portan. Posteriormente, esa sangre es recogida por las venas, que la conducen hasta el corazón. Los moluscos bivalvos, por ejemplo, tienen un sistema abierto. Su configuración no permite un control muy estricto sobre los flujos que bañan de sangre unos y otros tejidos. Además, son sistemas de baja presión, lo que tiene diversas consecuencias, de las que nos ocuparemos en otro momento.

Los sistemas cerrados conducen la sangre a través de los tejidos por un sistema de capilares y de esa misma forma retorna al sistema venoso y de ahí al corazón. No obstante, a su paso por los tejidos, parte del plasma sanguíneo se filtra al espacio intersticial llevando consigo sustancias disueltas con destino a las células, y del mismo modo retorna a los capilares, con sustancias de deshecho procedentes de aquellas. Estos son sistemas de alta presión hidrostática.

En los metazoos hay una variedad enorme de sistemas circulatorios. Pueden tener uno o varios corazones, aunque en este segundo caso lo más habitual es que uno de ellos sea el principal y los otros sean auxiliares. Y la arquitectura del conjunto del sistema así como la configuración de los vasos puede ser también muy diferente.

El sistema cardiovascular humano está constituido por dos circuitos, el de la circulación pulmonar por un lado y el de la general o sistémica por el otro. Su corazón tiene cuatro cámaras. Con cada contracción, la sangre es impulsada, desde el ventrículo derecho hacia los pulmones (circulación pulmonar) y desde el ventrículo izquierdo hacia el resto de órganos y tejidos (circulación sistémica), y retorna de los pulmones y del resto del organismo hasta la aurícula izquierda y la aurícula derecha, respectivamente. En lo sucesivo me referiré a la circulación sistémica.

Solemos considerar siete tipos de vasos sanguíneos en el sistema circulatorio general: arteria aorta, arterias, arteriolas, capilares, vénulas, venas, y venas cava. Pero en realidad hay ciertas dosis de arbitrariedad en esta clasificación, pues la ramificación de los vasos hasta llegar a los capilares y su posterior reagrupamiento hasta confluir en las venas cava es gradual y las fronteras son imprecisas entre unos y otros.